ChatGPT登場時と同じような衝撃を受けたgroqを調べてみた

groqとは?

groqとは、言語モデル処理に特化したLPU(Language Processing Unit)を開発している会社です。

このLPUを使用することにより大規模言語モデルの応答速度が格段に速くなります。

その結果、ユーザはレスポンスの待ち時間を意識することなく大規模言語モデルを使用することができるようになります。

groqは、そのLPUを使用したgroq.comというChatGPTに似たサイトであるGroqChatを提供しています。

GroqChatの使用方法

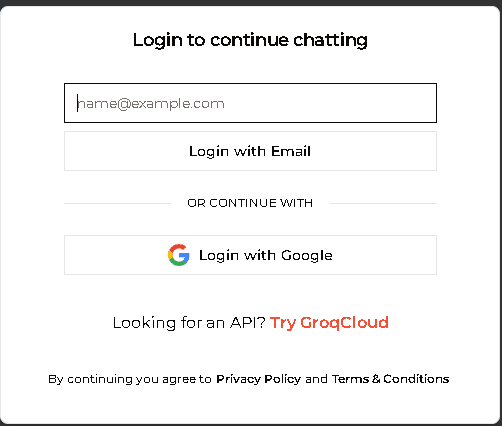

groq.comを開きましたら、左下の"Sign in to Groq"にログインします。

次に、ログインするときのメールアドレスを入力します。私は、Googleでログインするので、"Login with Google"をクリックします。

次に、Sing in to qroq.comへログインするときに、Googleメールを使用する場合のプライベートポリシーに同意しますかと聞かれますので、"Continue"とクリックします。

これで下記の画面が表示されてGroqChatを使うことができるようになります。

右上の歯車のところの横に、"Llama3-8b-8192"と表示されていますが、言語モデルを選択することができます。

現在、選択できる言語モデルは、GoogleのGemma、MetaのLlama3, Llama2、MixtralのMixtralとなります。

おそらく今後使用可能な言語モデルが増えていくと考えられます。

では、GroqChatを使ってみましょう。

"Enter prompt here"に入力して、→をクリックします。

今回は、下記のように書いてクリックします。

下記のような出力結果が出ますが、出力されるスピードを体感してほしいです。あっという間に出力されることに驚きを隠せません。

上記の右上に、"837.28T/s"と書かれており、1秒間あたり837.28トークンを処理したことになります。

今回、このNoteを書くタイミングでGroqChatを使いましたが、出力スピードが凄いです。

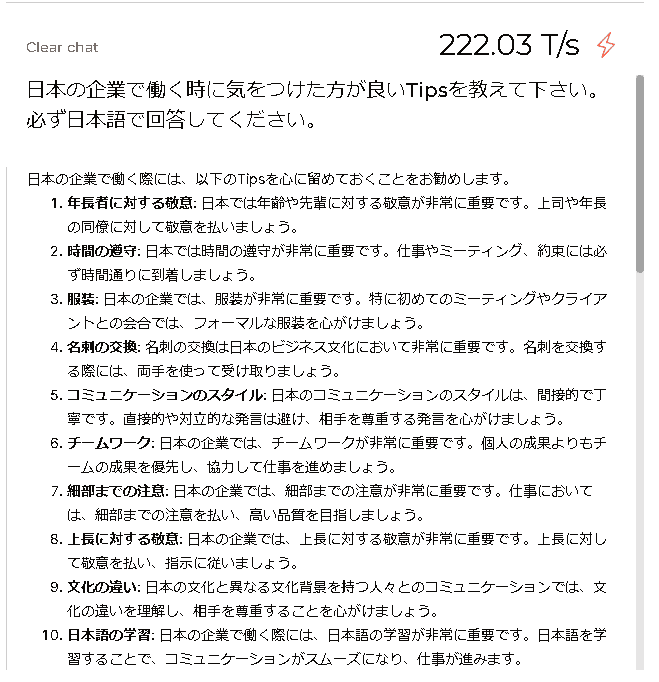

今度は、Llama3-70b-8192を使用してみます。今度は確実に日本語で回答するように依頼します。

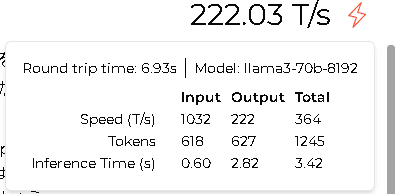

日本語にしても、1秒あたり222.03トークンの処理速度です。早いですね。

話は逸れますが、MetaのLlama3-70bという700億パラメータ凄いですね。回答結果もさながら、日本語の和訳もきっちり処理されているのには驚きです。この言語モデル自体の性能がオープンソースになっているのですね。

groqのAPIの使い方

groqには、APIキーが用意されており、Gemma, Llama、MixtralのLLMをAPIキーを通して使うことが出来ます。

上記のところで、"Create API Key"をクリックします。

API Keyの表示名を入力して、"Submit"をクリックします。

APIキーが作成されると、次のように表示されます。

APIキーを使うコードサンプルは、次のQuickStartを参考にして少しGoogle Colab用に修正しています。

!pip install groq

import os

from groq import Groq

client = Groq(

api_key="gsk_xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx",

)

chat_completion = client.chat.completions.create(

messages=[

{

"role": "user",

"content": "Explain the importance of fast language models",

}

],

model="mixtral-8x7b-32768",

)

print(chat_completion.choices[0].message.content)上記コードをGoogle Coalbで実行するときは、gsk-xxxxxxの部分を実際のGroqChatのAPIキーを張り付けてください。

実行結果は、ささっと出力されました。

1. Real-time applications: Fast language models are critical for real-time applications such as chatbots, virtual assistants, and speech recognition systems. These applications require a model to process and respond to user inputs quickly and accurately. Slow models can result in delayed responses, leading to a poor user experience.

2. Resource-constrained devices: Many devices, such as smartphones, IoT devices, and embedded systems, have limited computational resources and memory. Fast language models can run efficiently on these devices, enabling natural language processing capabilities without requiring powerful hardware or cloud-based processing.

3. Scalability: Fast language models can be deployed on a large scale, allowing them to handle a high volume of requests without overwhelming the system. This is particularly important for businesses and organizations that need to process large amounts of text data in real-time.

4. Cost-effectiveness: Training and deploying large language models can be expensive, both in terms of computing resources and energy consumption. Fast language models require fewer computational resources, making them a more cost-effective solution for many applications.

5. Accessibility: Fast language models enable natural language processing capabilities on a wider range of devices, making them more accessible to a larger audience. This can help bridge the digital divide and enable more people to benefit from advanced language technologies.

In summary, fast language models are important for real-time applications, resource-constrained devices, scalability, cost-effectiveness, and accessibility. By enabling efficient and effective natural language processing, fast language models can help drive innovation and improve user experiences in a wide range of applications.groqのプラン

フリープラン、オンデマンドプラン、エンタープライズプランの3種類があります。まだ、フリープランで使えるのは良いですね。

所感

今、groqの株を買いたいです。

この記事が気に入ったらサポートをしてみませんか?