GPT-4o, Google I/O 2024, etc - Generative AI 情報共有会 #17

今週、5月28日(火)にZENKIGEN社内で実施の「Generative AI最新情報共有会」でピックアップした生成AI関連の情報を共有します。

この連載の背景や方向性に関しては 第一回の記事 をご覧ください。

OpenAI、GPT-4o発表(2024/05/13)

テキスト、音声、画像、動画のあらゆる組み合わせの入力に対して、テキスト、音声、画像での出力を可能とするGPT-4o (”o”は”omni”)。

音声入力に対し、最短232ms、平均320msで応答可能で、これは人間の応答時間と同等。

これまで(Voice mode)の応答速度は、GPT-3.5では平均2.8秒、GPT-4では平均5.4秒かかっていた。

Voice modeは、3つの独立したモデル(speech-to-textモデル、LLM、text-to-speechモデル)のパイプラインで、応答速度が遅いことに加え、入力のさまざまな情報(トーンや話者情報、背景ノイズなど)を知能であるLLM(GPT-4など)に渡せず失っていた。

GPT-4oはテキスト、視覚、音声にまたがる単一のモデルをend-to-endで訓練したもので、入出力が同じニューラルネットワークによって処理される。

性能

英語のテキストとコードにおいてGPT-4 Turboに精度で匹敵、非英語テキストでは大幅に精度向上し、APIは高速で50%安価。

【テキストタスク】

6ベンチマーク中5つでGPT-4 Turboを上回り、6ベンチマーク中4つで比較対象モデルの中で最高性能。

【音声認識】

全てのベンチマークでWhisper-v3より高い性能(WER, 数値が低いほど高性能)

【音声翻訳】

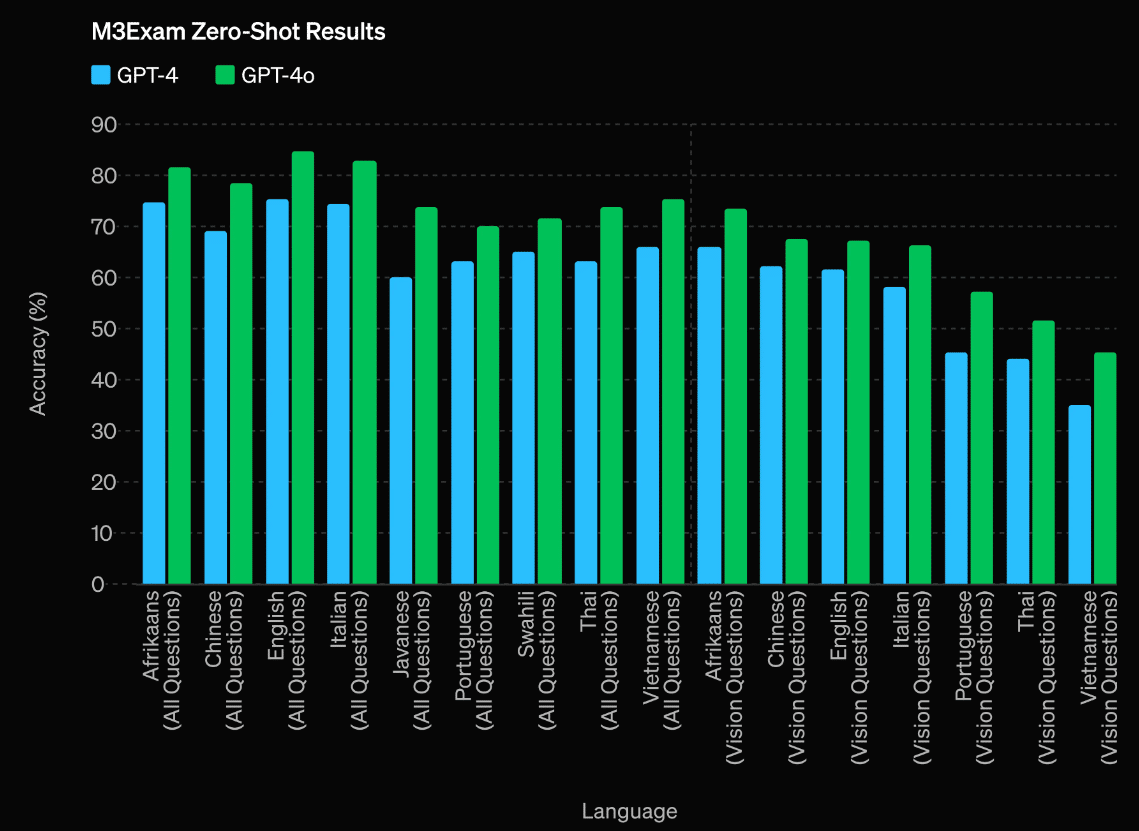

【M3Exam】

M3Exam : 多言語、マルチモーダル、マルチレベルで、LLMを評価するための実際の公式試験問題から作成されたベンチマーク。

対象の9言語全てにおいてGPT-4を上回る。

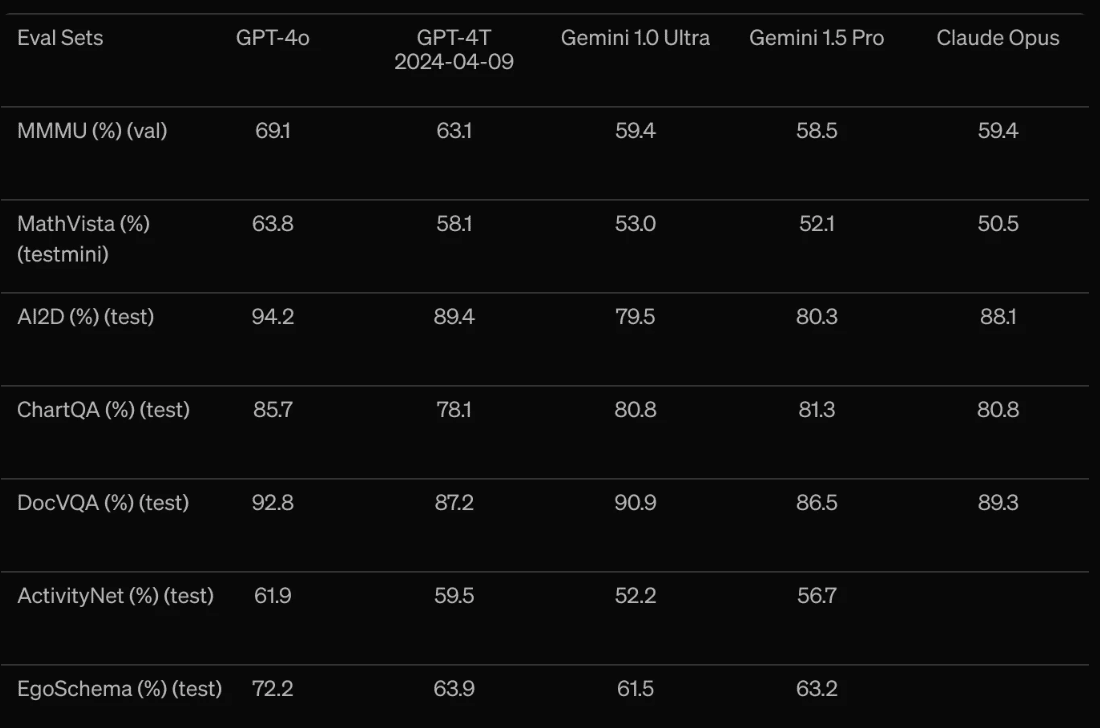

【画像理解タスク】

全てのベンチマークにおいて、比較対象の中でGPT-4oが最高性能

能力デモ

面接の準備として、身だしなみについて相談。

じゃんけんの実況。

数学の問題の解答サポート。

MTGへの参加(「犬と猫どちらが好きか?」のディベートのオーガナイザ)

リアルタイム翻訳(英語-スペイン語)

こちら で画像生成や画像編集、3Dオブジェクト生成、音声理解、動画理解といった能力を見るデモが共有されている。

その超一部(個人的な関心)をこちらでピック。

「Meeting notes with multiple speakers」(複数話者での議事録)

Input1 :

音声データ : https://cdn.openai.com/hello-gpt-4o/spaker-diarization.mp3

“How many speakers in this audio and what happened?”

「このオーディオには何人のスピーカーが入っていて、何が起こったのですか?」

Output1 :

"There are four speakers in the audio. It sounds like a project meeting where the project manager, Mark, is introducing himself and asking the team members to introduce themselves and state their roles. After Mark introduces himself, three additional speakers introduce their roles: Dirk as the marketing expert, Nick as the user interface designer, and Xavier as the industrial designer. They briefly mention their responsibilities for the project."

「音声には4人のスピーカーがいます。プロジェクトマネージャーであるマークが自己紹介をし、チームメンバーに自己紹介と役割分担を聞いている、プロジェクトミーティングのような音声です。マークが自己紹介をした後、さらに3人のスピーカーがそれぞれの役割を紹介している: ダークはマーケティングの専門家、ニックはユーザーインターフェイスデザイナー、ザビエルは工業デザイナーだ。彼らは、このプロジェクトにおけるそれぞれの責任について簡単に述べる。」

Input2:

"Can you transcribe it with speaker names?"

「書き起こしをスピーカー名を添えてしてくれますか?」

Output2:

Mark: Okay, good morning. This is our first team meeting.

Team: Morning.

Mark: I will be your project manager for today, for this project. My name is Mark and I'll be giving this presentation for you to kick the project off. This is the agenda for today. Well, of course, we’re new to each other, so I'd like to get acquainted first. So, let's do that first. I mean, let’s start with you. Can you introduce yourself? You are a marketing expert?

Dirk: Yes. Uh, my name is Dirk, Dirk Meinfelt. Uh, I will be, uh, during this project, the marketing expert. And I will see what, uh, the user wants and, uh, what we can do, uh, with the new product, project, product.

Mark: Excellent. And you are?

Nick: Nick de Boer, user interface designer. I'm going to, uh, look at the technical design from the user point of view.

Mark: Okay.

Xavier: My name is Xavier Joerkens. I'm the industrial designer, and there are three main questions that I have to find an answer to.

「Lecture summarization」(講義の要約)

Input :

動画(OpenAI DevDayの45分程の動画): https://cdn.openai.com/hello-gpt-4o/A-Survey-of-Techniques-for-Maximizing-LLM-Performance.mp4

Here is a video of a presentation on techniques for maximizing LLM performance. Could you give me a detailed summary of the presentation?

「LLMのパフォーマンスを最大化するテクニックに関するプレゼンテーションのビデオです。プレゼンテーションの詳しい概要を教えてください。」

Output :

Certainly! The presentation focused on techniques for maximizing the performance of large language models (LLMs) and was delivered by Colin Jarvis and John Allard from OpenAI. The session was part of OpenAI's first developer conference and aimed to provide insights into optimizing LLMs for specific tasks.

Introduction

- Colin Jarvis is the head of OpenAI's solutions practice in Europe, and **John Allard** is an engineering lead on the fine-tuning product team.

- The presentation highlighted the challenges of optimizing LLMs, emphasizing that there is no one-size-fits-all solution.

(中略。長いので全体はOpenAIのページを見てください)

Conclusion

- The presentation concluded with a summary of the optimization flow and emphasized the importance of iteratively improving LLM performance using the discussed techniques.

Q&A

- The presenters invited questions from the audience and were available for further discussion.

日本語でのデモが自民党AIプロジェクトチームのメンバーに対してOpenAI社提供のもと行われたとのこと。

日本語もかなり流暢(英語っぽい日本語ではない日本語)に感じられる。

OpenAIの本社エンジニアによるGPT-4oの特別デモ。「この会議室を10万円でおしゃれに改装するアイディアは?」と聞くと観葉植物、クッション、室内アートと即答。レスポンスの速さ、OCRの精度、関西弁の上手さ、ラップのリズム感、などなど想像を上回る性能でした。日本が抱える社会課題解決のために、… pic.twitter.com/dMUZQLenbO

— 塩崎あきひさ 【衆議院議員・愛媛1区】 (@AkihisaShiozaki) May 24, 2024

デモ失敗例

デモにおける失敗も共有されている。

例1: 発話が流暢でなく支離滅裂なことを話し出す失敗(と思われる)

例2: 中国語への翻訳が全くの間違いである失敗(と思われる)

例3: 中国語の発音(”你好”)の指導をしてもらうが、不適切な指導が行われる失敗(と思われる)

トークナイザの効率化

日本語は1.4倍効率的のトークナイズされるように。

GPT-4oを我々がアクセスできるようになる時期

テキストと画像の機能はChatGPT上ですでに展開されている。

無料ユーザーもアクセス可能。

Voice modeは(2024/05/13発表時点で)数週間以内にChatGPT Plusでアルファ版としてリリース予定。

API経由でも、テキストと画像のモデルを利用可能に。GPT-4oはGPT-4 Turboと比較し2倍高速で価格は半分。

音声と動画の機能サポートは(2024/05/13発表時点で)数週間以内に信頼できるパートナーへの提供開始。

Azureでは日本リージョンまだ未対応(2024/05/29現在。Azure OpenAI Serviceのモデル可用性一覧)なものの、すでにGPT-4oを製品に組み込む例は見られる。

Google I/O 2024(2024/05/14)

Google I/O 2024で発表された内容から生成AI関連の話題を。

Gemini 1.5 Proの改善と、新たなモデルGemini 1.5 Flash

Gemini 1.5 Pro

Gemini 1.5 Pro自体は2月に発表(noteでも紹介しました)されていたが、翻訳、コーディング、推論などの主要なユースケースにおいて、精度が向上。

2Mトークンのコンテキストサイズを一度に処理できる形で利用可能に。

実際は10Mまで現状でも処理可能。

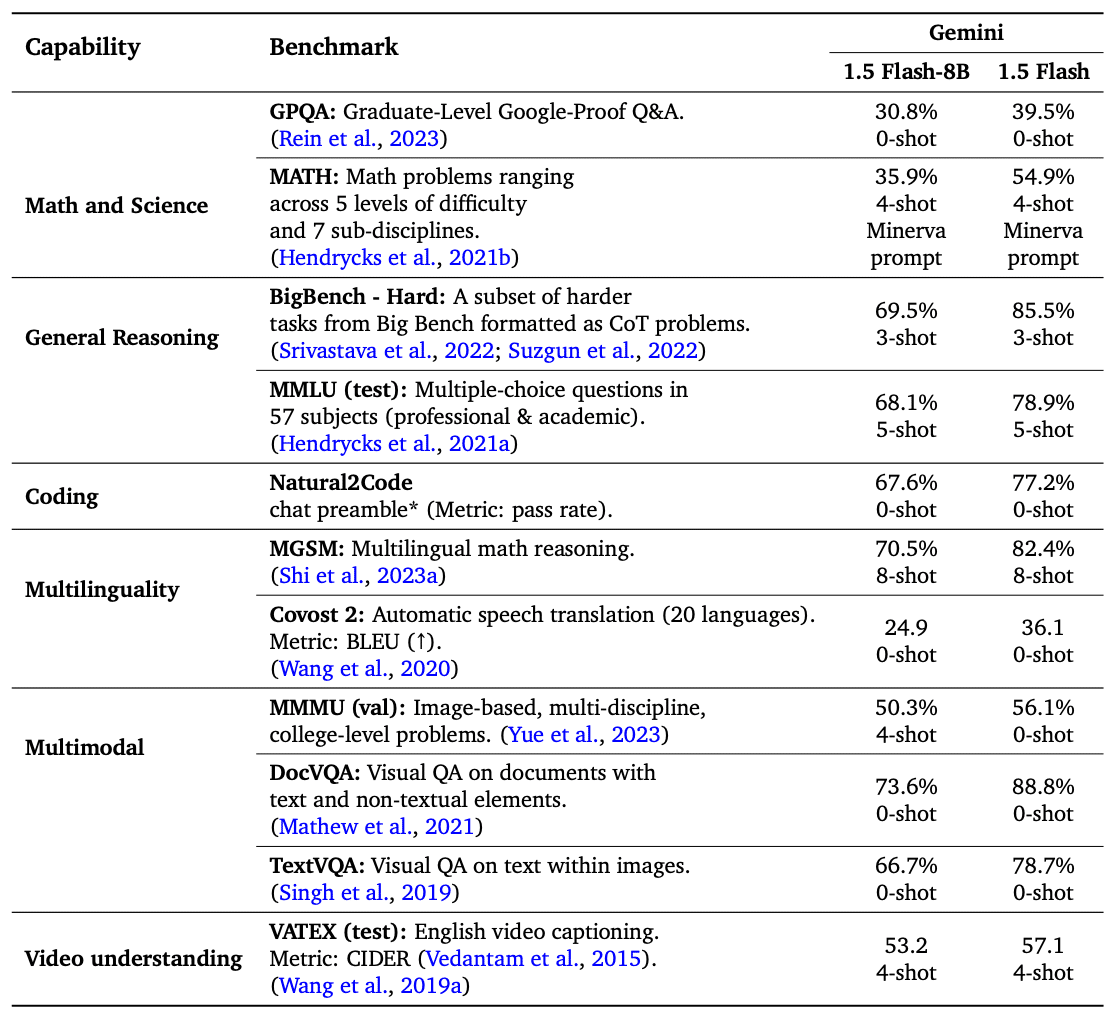

Gemini 1.5 Flash

Gemini 1.5 Proより小型なモデル。モデルの応答速度が重要なタスクに最適化。

1.5 Flash-8Bモデル(開発中)

Gemini 1.5 Flashと同じコアアーキテクチャ、最適化、データ混合を継承することで、1Mトークンを超えるコンテキストサイズをサポートする効率的なマルチモーダルモデル。

1.5 Flashや1.5 Proに性能は劣るものの、高スループットと超低レイテンシという点で大きなメリット。

Gemma 2

27Bというサイズで、先月公開されたMeta社の Llama 3 70B(こちらのnoteで紹介しました)に匹敵する性能(Gemma 2はまだ事前学習途中)。

今後(2024/05/13発表時点)数週間以内に正式発表されるとのこと。

オープンなVision-Language Model「PaliGemma」

画像や短い動画へのキャプション生成、視覚的な質問応答、画像内のテキスト理解、物体検出、物体分割など、画像とテキストを入力しテキストを生成するタスクで高性能なファインチューニング性能を発揮するよう設計されている。

動画生成モデル「Veo」

1080p解像度での1分超の動画生成や動画編集が可能。OpenAIの「Sora」(こちらのnoteで紹介しました)への対抗となるか?

今後(2024/05/13発表時点)数週間で、機能の一部が一部のクリエーターに提供される予定。将来的にYouTube Shortsなどの製品に提供予定。

画像生成モデル「Imagen 3」

プロンプトを理解する能力を大幅に向上させ、幅広いビジュアル・スタイルを生成し、長いプロンプトから細かなディテールを捉えることが可能に。

複数のバージョンが用意され、高速な画像生成から高解像の画像生成までさまざまなタスクに対応。

ImageFX内で一部クリエーターに提供開始。近日中(2024/05/13発表時点)にVertex AIでも提供予定。

Project Astra

現在開発中の、”見て” “話す” 先進的な応答エージェント(”advanced seeing and talking responsive agent”)

機能の一部を今年後半にGoogle製品に搭載予定。

生成AI活用事例

グレート・ビーンズ、志望動機自動生成サービスを提供開始

CIY : 就活生や転職希望者向けに、自己分析や適性の高い業種・職種のアドバイスを行なう採用ツール

累計65万人以上が自己分析ツールを利用とのこと。

今回新たに、自己分析結果をもとにChatGPTを利用して自己PRを自動生成する機能を提供開始。

ディップ、対話型バイト探しサービス「dip AIエージェント」

生成AIを活用してより自然な応答を生成し、対話を通じて最適な仕事を提案する。

ディップは、東大の松尾先生下の株式会社松尾研究所と連携し最先端技術開発を進める「ディップ技術研究所」を設立(2023年4月)。

ライフマップ、高校生の進路相談に24時間対応 する『AI進路サポーターβ』

LINEを使った進路相談ツール「AI進路サポーターβ」

これまでの『らいしん!』の相談記録や、進学情報サイト「コレカラ進路.JP」に掲載している学校情報を元に生成AIが回答。

『らいしん!』: 月2回の頻度で社員がリアルタイムで進路相談をするサービス。

終わりに

少しでも弊社にご興味を持っていただけた方は、お気軽にご連絡頂けますと幸いです。まずはカジュアルにお話を、という形でも、副業を検討したいという形でも歓迎しています。

この記事が気に入ったらサポートをしてみませんか?