MicrosoftがPhi-3を発表。On-Device AIの実現へ

米Microsoftは23日(現地時間)、小規模言語モデル(SLM, Small Language Model)「Phi-3」を発表した。23日時点ではPhi-3ファミリーとして複数あるモデルのうち最も小規模な「Phi-3-mini」がHugging Face、Ollama、NVIDIA NIMで利用可能になった。

・Phi-3-miniは人々の日常的なコミュニケーション方法をベースとし、さまざまな指示に従うよう訓練されたオープンモデルである。

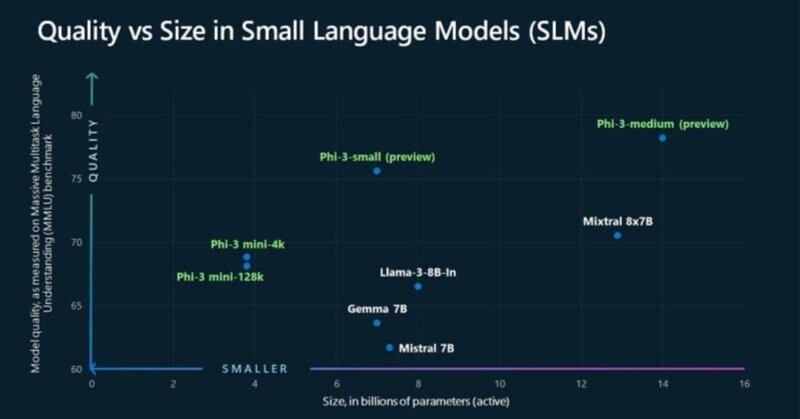

・3.3兆個のトークンで訓練された38億パラメータの小規模言語モデル(SLM)にもかかわらず、Mixtral 8x7BやGPT-3.5のようなモデルに匹敵する性能をもつ。

・phi-2に使用されたものをスケールアップしたもので、フィルタリングんいより厳選されたWebデータと合成データにより訓練され、頑健性、安全性、チャット形式のためにさらに調整されている。

・phi-3-smallとphi-3-mediumと呼ばれる4.8Tトークンのために訓練された7Bと14Bのモデルで、いくつかの初期パラメータ-スケーリングの結果を提供し、どちらもphi-3-miniより高性能である。

・コンテキスト長は4Kトークンと128Kトークンを用意。言語、推論、コーディング、数学のベンチマークで、同サイズのLLM(大規模言語モデル)よりも高い性能を発揮する。

などの特徴を持っており、On-Device AIの実現に向けての大きな前進と言える。

Phi-3-miniは、モデルの量子化手法を死傷して、モバイルデバイスに最適化している。量子化技術は、モデル内の数値データの精度を下げることにより、モデルのサイズと計算要求を減少させるが、その性能には大きな影響を与えないというものである。これにより、処理能力やメモリが限られたデバイスでも効率的に動作することが可能となり、モバイルプラットフォームで先進的なAI機能をよりアクセスしやすくする。

※画像:Massive Multitask Language Understanding (MMLU)を用いて他社モデルと性能を比較した図(出典:Microsoft)

この記事が気に入ったらサポートをしてみませんか?