ライブ・ビューイングの臨場感向上大作戦!~Yamaha Distance Viewing

2020年から続いたパンデミックも落ち着き、ようやく街中に人が戻ってきました。それに伴い、Live Extremeを家庭向け配信ではなく、ライブ・ビューイングに利用したいというお問い合わせも増えてきました。

大音量で聴くライブ・ビューイングは家庭向け配信以上に音質がシビアです。その音源がAAC圧縮されたステレオでは、本来のライブ体験とはかけ離れたものになってしまうでしょう。

今回はLive Extremeをライブ・ビューイング用の配信システムとして利用した最近の事例をご紹介するとともに、最新の「Live Extreme Encoder v1.13」で強化されたライブ・ビューイング向け機能についてご紹介いたします。

Yamaha Distance Viewingでの利用

ヤマハ株式会社が開発を進める「Distance Viewing」は、ライブ時の迫力あふれる音を完全再現しながら、大型スクリーンを用いた等身大映像と、ライブさながらの照明演出などで、そのパフォーマンスをステージ上によみがえらせる次世代ライブ・ビューイング・システムです。

2020年10月の発表以降、事前収録したライブの音響・照明・映像を、後日、ディスタンス・ビューイング会場で再現するという形で実施されてきましたが、2024年2月2日に初めてリアルタイムで遠隔配信することに成功しました。そして、その配信システムとして利用されたのがLive Extremeでした。

Yamaha Presents WONK Live × Distance Viewing

「Yamaha Presents WONK Live × Distance Viewing」と名付けられたこのイベントでは、エクスペリメンタル・ソウルバンド「WONK」がヤマハ銀座スタジオで行ったライブを、グレースバリ銀座店にリアルタイムに配信し、ライブ体験を完全再現することを試みました。ライブ会場には、チケットを購入した180人の一般客が入場できましたが、ライブ・ビューイングの方はプレスや関係者のみに限定公開されました。

以下に本配信と家庭向け配信の主な違いについてご紹介します。

高ビットレート4K映像の伝送

家庭向けの配信では、マルチカメラによるスイッチング映像を配信することが一般的ですが、Distance Viewingではライブ会場にいるかのような臨場感を実現することを目指しているため、ステージ全体を俯瞰できる映像を撮影し、巨大スクリーンに等身大で投影します。このため、解像度もビットレートも家庭向け配信以上のものが求められます。

Live Extremeを使った通常の配信は、一般家庭のインターネット環境でも快適に見られるよう、4K映像であってもビットレートは18Mbps程度に抑えていますが、今回の配信では、Live Extreme Encoderの上限である4K 65Mbps (映像コーデックはH.264) という高ビットレートで伝送されました。

ヤマハ新開発の「GPAP」により照明データを同時伝送

Distance Viewingの非常にユニークな特長として、音声・映像データ以外に照明制御用のデータも記録することにあります。これにより、ディスタンス・ビューイング会場に設置された照明装置を音声や映像と同期して制御することが可能となります。この演出をディスタンス・ビューイング会場で見ていると、ライブ映像が巨大スクリーンを飛び出してくるような不思議な感覚があり、非常に高い臨場感と没入感が得られます。

通常、音声と照明データを同期して記録・伝送していくには、タイムコードを軸とした煩雑なシステムを組む必要がありますが、ヤマハは今回のイベントに合わせ、照明制御データ (DMX) を含む各種信号を音声信号 (WAV) として記録可能な「GPAP (General Purpose Audio Purpose)」という規格を開発していました。

GPAPでは各種信号を変調して音声信号に収録可能なため、データ記録としては48kHz/24bitをビットパーフェクトで記録可能なDAW (Cubaseなど) をそのまま利用できます。リアルタイム伝送する場合も、48kHz/24bitをビットパーフェクトで送受信可能なシステムであれば対応可能ですが、ここはまさにLive Extremeが得意とする領域です。

今回のイベントでは、Live Extremeの音声チャンネルの1つをGPAP用として利用し、照明データを伝送しました。(原理的には映像もGPAPに収録できそうですが、今回は映像については通常のLive Extremeの仕組みを利用して伝送しました。)

マルチチャンネル・ロスレス音声による伝送

ライブ・ビューイング・イベントの場合、ライブ会場とビューイング会場の音響特性が異なることから、ライブ会場のPAミックス(ステレオ)を伝送するのではなく、楽器ごとのステム信号を伝送し、視聴会場でミックスし直した方が良い結果が得られます。

Live Extremeは従来より、FLACコーデックの上限である8chのロスレス・オーディオ信号を配信することができました。本イベントではこの機能をフル活用し、7chのステム信号にGPAPを加えた合計8chの48kHz/24bit音声をリアルタイム伝送しました。ステム信号を視聴会場側のPAミキサーでミキシングすることで、視聴会場の音響特性に対応した臨場感の高い音質によるライブ・ビューイングを実現することができました。

ローカル・ディスクへのHLSライブ配信

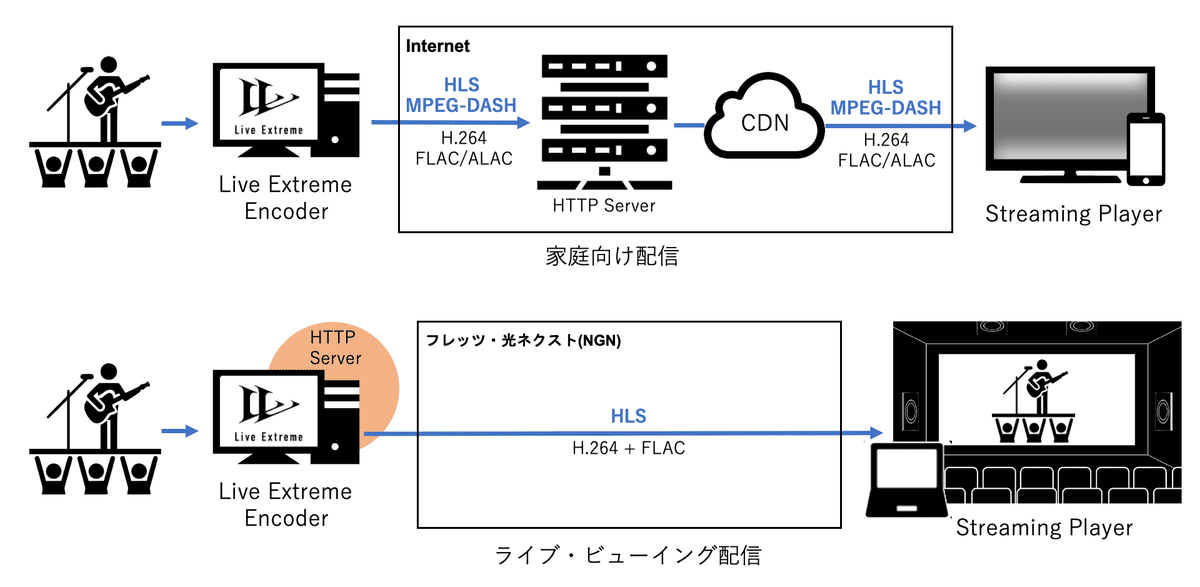

Live Extremeで家庭向け配信を行う場合は、Live Extreme EncoderからAmazon S3など外部配信サーバーに対して、HLS / MPEG-DASHストリームをリアルタイムにアップロードさせています。ライブ・ビューイングでも同じ仕組みを利用することができますが、配信先が少数の特定拠点である場合は別のアプローチも考えられます。

Live Extreme Encoderにはローカル・ディスクに対しても、HLS / MPEG-DASH形式でリアルタイム記録する機能が備えられています。ここで、Live Extreme Encoder PC内に「IIS (Internet Information Services)」などでHTTPサーバーを立てれば、Live Extreme Encoder PCを配信サーバーとして利用することが可能となります。

今回の配信では、ライブ・ビューイング会場にあるMacから、ライブ会場にあるLive Extreme Encoder PCのHLSデータを直接読み込んで再生しました。

フレッツ網内IPv6折り返し通信(相当の通信方式)

NTT 東日本・西日本の提供する「フレッツ 光ネクスト」は、「IPv6 オプション」を有効にするだけで「フレッツ網(NGN)内IPv6折り返し通信」を利用することができます。この通信方式を利用すると、フレッツ網に接続されたIPv6端末間でP2P的なダイレクト通信を行うことができるようになり、以下のようなメリットがあります。

拠点間の通信で遅延が少ない

安定して数百Mbps以上のスループットを期待できる

ISP の契約が不要

通常、Live Extremeで拠点間伝送を行う場合、上記網内折り返し通信を推奨していますが、今回のイベントでは視聴会場側の設備の都合で、これを利用することができませんでした。

そこで今回は、我々のパートナー企業の一つである輝日株式会社の「Infal Bridge」サービスを利用しました。これは異なる回線同士をブリッジ接続するもので、今回はライブ会場の「NTT東日本 フレッツ光」と、ビューイング会場に元々引かれていた他社光回線とをレイヤ2接続しています(下図点線赤枠部分)。

これによりフレッツ網の枠組みを超えつつも、 NGN網内折り返し相当の品質が担保されたレイヤ2のネットワークを構築できました。

Live Extreme Encoder v1.13の新機能

2024年5月にリリースされた「Live Extreme Encoder v1.13」には、ライブ・ビューイング用システムとして利用されることを想定して、以下の機能が追加されています。あいにく2月の「WONK Live × Distance Viewing」ではタイミングが合いませんでしたが、今後は配信仕様に応じて利用可能です。

同時入力チャンネル数を16chに拡張

Live Extreme EncoderはSDI/HDMIのエンベデッド・オーディオ、または外部ASIOデバイスから音声を取り込むことが可能です。従来は同時入力チャンネル数が最大12chに制限されていましたが、Live Extreme Encoder v1.13より最大16chに拡張されています。

今後も入力チャンネル数の更なる拡張が予定されていますが、現時点でも既にSDIのエンベデッド・オーディオを全チャンネル同時に入力することができるようになっています。

非圧縮PCM (最大16ch) の配信に対応

Live Extremeの標準音声コーデックであるFLACは、フォーマットの制限により最大8chまでの音声しか収録できません。これは家庭向け配信としては十分なチャンネル数と言えますが、ステム音声用としては、必ずしも十分とは言えません。

Live Extreme Encoder v1.13では、最大16chの非圧縮のPCM音声(最大192kHz/24bit)を映像とともにHLSでライブ配信できるようになりました。

これを再生できる環境は限られている (*) ため、不特定多数への配信には不向きですが、再生環境を完全にコントロールできるライブ・ビューイングにおいては、ステム音声用としても立体音響用としても有効に利用できます。

(*) HLSの非圧縮PCM音声の再生が可能なのは、

・macOS 12 Monterey または macOS 13 Ventura : 最大16ch

・macOS 14 Sonoma : 最大12ch

で動作する、SafariブラウザまたはQuickTime Playerのみとなっています。

まとめ

2024年以降、ライブ・ビューイング市場はますます伸張していくとともに、品質に対する要求も高まっていくのではないかと予想されます。Live Extremeでは今後もこの市場に向けた技術開発を継続していく予定ですが、映像では既に4K解像度、音声ではLPCM 192kHz/24bit x 16chを実現しており、16chステム・ミックス伝送から9.1.6ch立体音響伝送まで、現行のv1.13でも殆ど全てのニーズに対応できるのではないかと考えています。

この記事が気に入ったらサポートをしてみませんか?