【#Vtuber】AI Vtuberを作りたい 第1回(概要)

はじめに

本記事は、

・大学院での研究をきっかけにUnityに興味を持っている

・Vtuber黎明期からVtuberを追っている

筆者がVtuberのようなものを

「自分の手で作れるところまで作ってみたい!挑戦したい!」

と思って作っている過程を記すものになります。

次回の記事はこちらです。

追記:2023/02/21

「AI Vtuberを作りたい」シリーズのマガジンになります。

やりたいこと

目標

目標の1つとしては、AI Vtuberの「紡ネン」さんのように所謂中の人がいないようなVtuberを作ることを目指していこうと思います。

また、これに加えて全自動で自分の意志で動作する人工知能(AI)にしていきたいと考えております。(人間らしさを持ったAIにする。)

実装したい機能

これらを踏まえて現時点で実装したい機能は以下になります。他に思い付いたら都度別の記事で追記していこうと思います。

声帯:そのままの人間の声ではなく合成音声ソフト(VOICEVOX、VOICEROID)で話す機能

顔の動作(リップシンク):話している音声に合わせて口が動く機能

顔の動作(表情):任意のキーボード入力または話す内容の感情分析による結果で顔の表情が変わる機能

体の動作:任意のキーボード入力または自分の意志で体の動きが変わる機能

話す内容:自然言語処理や感情分析、対話型AIなどで話す内容を生成する機能

開発環境

Unity

Unity 2021.3.16f1

導入したもの

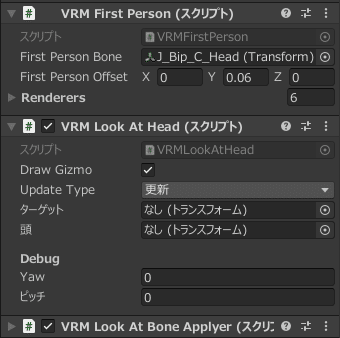

UniVRM(モデル制御)

UniVRM v0.108.0

私はunitypackageを用いて導入しました。

導入後、自分で用意したモデルの.prefabファイルをシーンに入れるとモデルが表示されます。

スクリプトはデフォルトでセットされるみたいです。

uLipSync(リップシンク)

uLipSync v2.6.1

こちらもunitypackageを用いて導入しました。

unitypackageをプロジェクトに展開し、Package Mananager から Mathematics および Burst をインストールすると使用できます。

uLipSyncを使えるようにするために参考にしたサイトは以下です。

「マイクの利用」や他の音声向けに調整したデータを作成するための「キャリブレーション」などの詳細については下記サイトの1つ目にあります。

声帯はVOICEVOXの使用を考えているので、Unityで使用できるように準備したらキャリブレーションしてちゃんと口パクできるようにしたいと思います。

Output Sound Gainを0にすると自分の声が聞こえなくなります。(デフォルトだと1で最大限に聞こえる設定)

Blinker(目の瞬き)

目の瞬きを追加するには、「Add Component」で「Blinker」をモデルに追加します。

BlinkerはVRM導入時に一緒に同梱されているので上記までのことができていたら適用できると思います。

Breath Controller(呼吸動作)

BreathController Beta

以下のサイトからOneDriveのダウンロードリンクまで飛んでzipをダウンロード→展開してAsset配下にフォルダを置き、中に入っているファイルをHumanモデル(シーンにあるモデル)にアタッチして使用してください。(HumanモデルにはAnimatorControllerがアタッチされている必要がある。)

その他設定備忘録

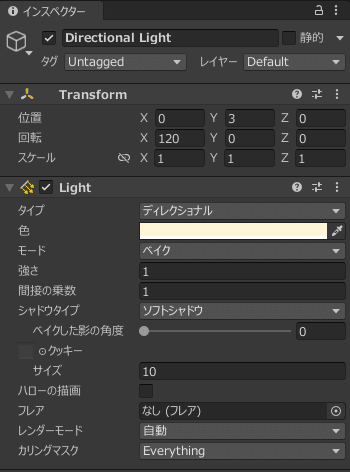

Light

強さの値を変えると明るさが変わります。(大きいほど明るい)

この記事が気に入ったらサポートをしてみませんか?