【#Vtuber】AI Vtuberを作りたい 第3回(VOICEVOXの声でリップシンク)

はじめに

前回の記事はこちらです。

「AI Vtuberを作りたい」シリーズのマガジンになります。

今回は第1回の記事で実装したい機能として述べた

顔の動作(リップシンク):話している音声に合わせて口が動く機能

について書いていこうと思います。

導入したもの

uLipSync(リップシンク)

uLipSync v2.6.1

こちらもunitypackageを用いて導入しました。

unitypackageをプロジェクトに展開し、Package Mananager から Mathematics および Burst をインストールすると使用できます。

VOICEVOXの声でリップシンクをするための手順

基本的な「uLipSync」についての説明については下記サイトにあります。

今回はVOICEVOXの声でリップシンクをするために下記サイトの「マイクの利用」や他の音声向けに調整したデータを作成するための「キャリブレーション」を参考にして手順を書いていこうと思います。

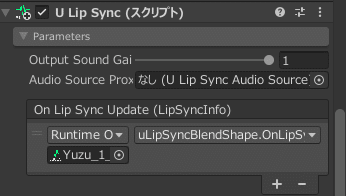

1. マイクの設定

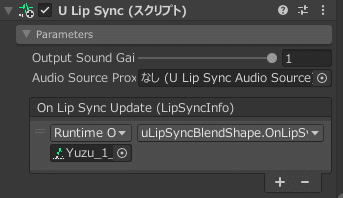

「U Lip Sync」の「Output Sound Gain」を「1」

「U Lip Sync Microphone」の「Device」を「VoiceMeeter Output」

に設定する。(第2回参考)

2. プロファイルの作成

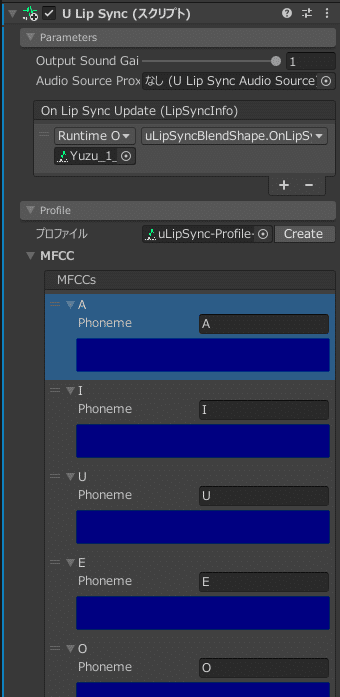

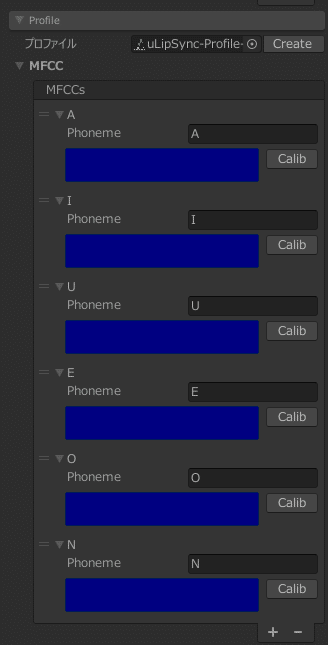

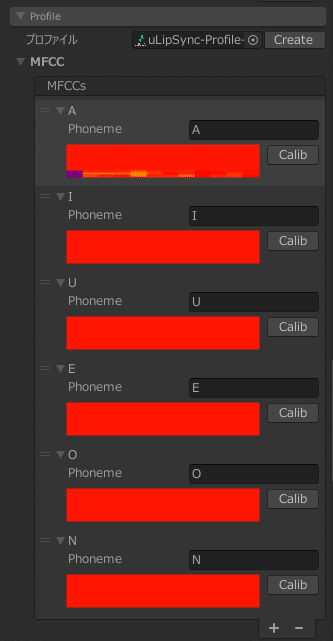

「U Lip Sync」の「Profile」の「Create」でプロファイルを作成する。

次に「Profile」→「MFCC」→「MFCCs」→「+」で認識させたい音素(A,I,U,E,Oなど)を登録する。

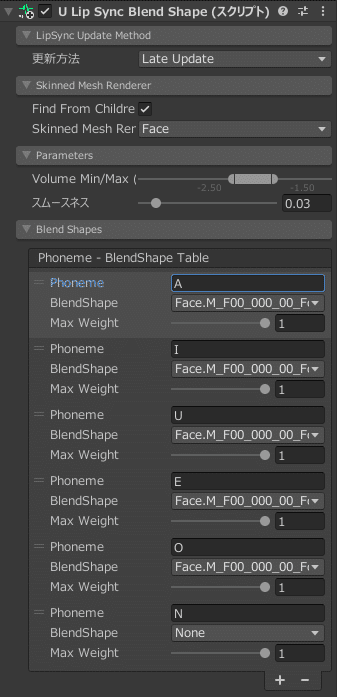

上記で設定した音素の文字(A,I,U,E,Oなど)が「U Lip Sync Blend Shape」→「Blend Shapes」→「Phoneme」の文字と一致するようにしてあれば問題ありません。(アルファベットでもひらがなでもカタカナでもいいらしい。)

3. 音素のキャリブレーション

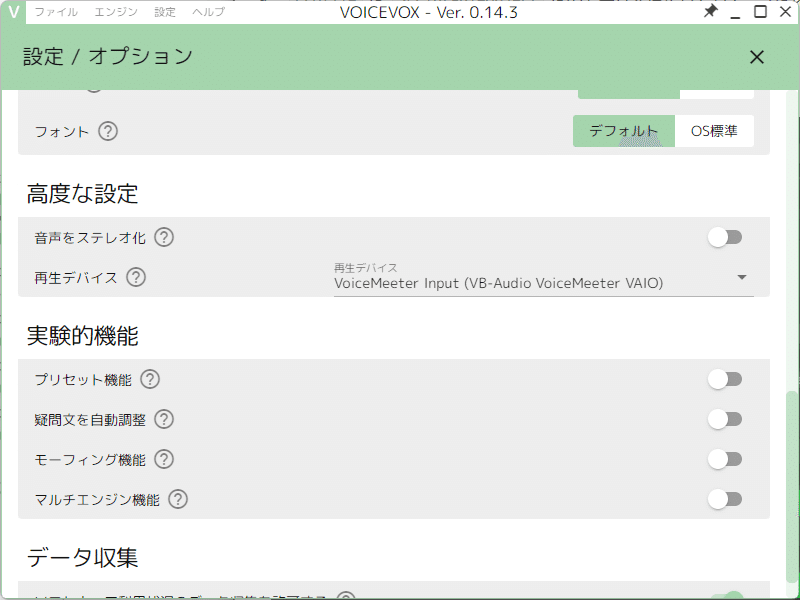

「VOICEVOX」を起動し、「再生デバイス」を「VoiceMeeter Input」に設定する。

「Unity」に戻り、「▶ボタン」を押す。

「U Lip Sync」→「Profile」→「MFCC」→「MFCCs」で各音素の「Calib」が押せるので、キャリブレーションしたい音素の「Calib」を押す。

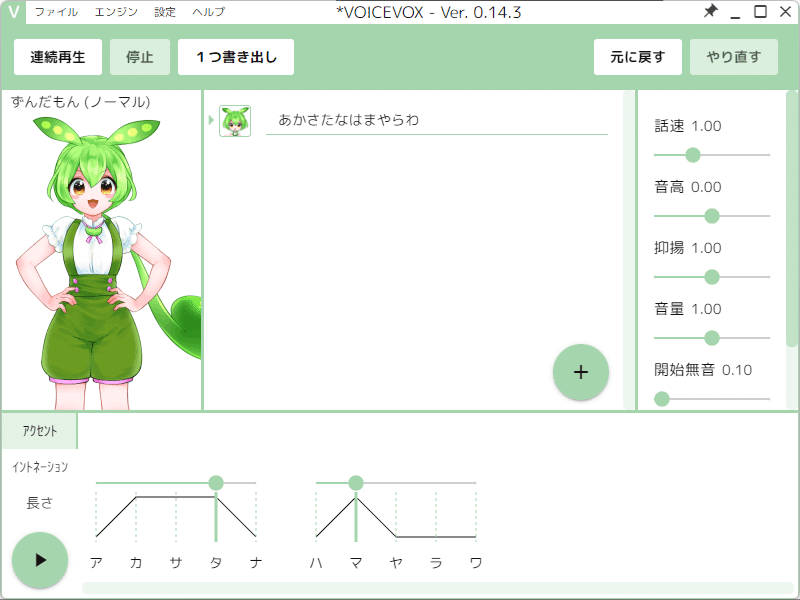

「VOICEVOX」に戻り、指定した音素用のテキストを入力し、左下の「▶ボタン」を押す。(「A」の場合は「あかさたなはまやらわ」に筆者はしている。)

「A」でやってみた結果が以下になります。合成音声ソフトだからなのか人の声よりも変化が分かりにくいかもしれないです。

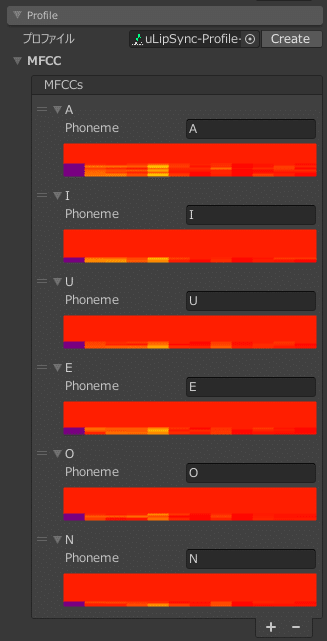

「I」を「いきしちに~」、「U」を「うくすつぬ~」とか同様に行い、全てキャリブレーションした結果が以下になります。

補足

Output Sound Gainを0にすると自分の声が聞こえなくなります。(デフォルトだと1で最大限に聞こえる設定)

この記事が気に入ったらサポートをしてみませんか?