OpenAI社が公開した音声認識AI「Whisper」の全モデルを試してみた

GPT-3やDALL•E 2を公開しているOpenAI社より9月21日に音声認識Whisperが公開されました。

この記事では、Whisperの特徴など詳細は割愛しますが、実際に使ってみてどのくらいすごかったのか、どのくらい日本語を書き起こすことができたのかをご紹介します。

詳細が知りたい方はこちらの神サイトクラスメソッドさんのサイトをご覧ください。

前提

Google Colaboratory GPU環境でWhisper公式ドキュメントに従って実行

音声データはGoogleが公開しているサンプルアナウンス音声(WAV)48秒4.6MBを使用

モデルが5つ用意されていて、それぞれパラメータ数が異なり、実行時間も異なっている。今回はこの5つ全てのモデルを同一音声ファイルに対して実行してみた

結果

tiny 5s

朝の友です。今日の東京株式市場で、ニッケーヘー金株川コハバゾクシントなっています。終わりには機能に比べ、22年712センダかの1万1,818円50発線でした。同生一部のネアガリメーガラスは1646、対してネサガリは368、川ラスは148、100円メーガラとなっています。ここでプレゼントのお知らせです。この番組では、毎月発行の万すりレポートをしがつごを中線で10メーサマにプレゼントいたします。おもしこみはお出まで、東京レーさん、レイチレーナナ、837さん、レイスさん、レイチレーナナ、837まで。以上、番組からのお知らせでした。

base 6s

朝のともみです。今日の東京株式市場で、日計平均株価は、小幅属心となっています。終わり根は機能に比べ22円72000だかの1万1888円58000でした。当初1部の寝上がり名がら数は1446、対して寝下がりは368、変わらずは144名がらとなっています。ここでプレゼントのお知らせです。この番組では、毎月発行のマンスリーレポート4月5日を中戦で10名様にプレゼントいたします。おもしこみはお電話で、東京冷産冷一冷7、8373、冷産冷一冷7、8373まで以上番組からのお知らせでした。

small 19s

朝のともみです今日の東京株式史上で日系平均株価は小幅属進となっています終わり根は昨日に比べ22円72千高の1万1088円58千でした当初一部の値上がり明がら数は1146対して値下がりは368変わらずは104明がらとなっていますここでプレゼントのお知らせですこの番組では毎月発行のマンスリーレポート4月号を中線で10名様にプレゼントいたしますお申し込みはお電話で東京030107-8373-030107-8373まで以上番組からのお知らせでした

medium 49s

朝野ともみです。今日の東京株式市場で日経平均株価は小幅俗進となっています。終り値は昨日に比べ22円72千高の11,088円58銭でした。当初一部の値上がり名柄数は1,146、対して値下がりは368、変わらずは104名柄となっています。ここでプレゼントのお知らせです。この番組では毎月発行のマンスリーレポート4月号を抽選で10名様にプレゼントいたします。お申し込みはお電話で東京030107-8373、030107-8373まで。以上番組からのお知らせでした。

large 68s

朝野 智実です 今日の東京株式市場で日経平均株価は小幅続進となっています終わり値は昨日に比べ22円72,000だかの11,088円58,000でした 当初一部の値上がり銘柄数は1,146対して値下がりは368 変わらずは104銘柄となっていますここでプレゼントのお知らせです この番組では毎月発行のマンスリーレポート4月号を抽選で10名様にプレゼントいたしますお申し込みはお電話で東京03-0107-8373-0301-078373まで以上番組からのお知らせでした

考察

電話番号を正しく書き起こせたのはsmall以上

「小幅続伸」を正しく書き起こせたのはlargeだけ

22円72銭はlargeでさえ、22円72,000となってしまったのは仕方ない。ニュースを読む場合頻出だと思うので、このあたりはファインチューングが必要そう

tinyを使うのは現実的じゃなさそう

mediumがギリギリリアルタイム翻訳に使えそう

largeが一番精度が高いが実行時間が音声ファイルの1.5倍程度かかってしまっているので、後から集計したりバックグラウンドで並列実行させるなどの工夫が必要そう(GPUの性能を上げることで改善できるとは思うが)

精度という観点では、Google のSpeech-to-Textによる文字起こしと、あまり大きな差は感じられなかったというのが正直なところかもしれないんですが、やっぱり今回はオープンソースとして公開されたということが圧倒的な

すごさですよね。

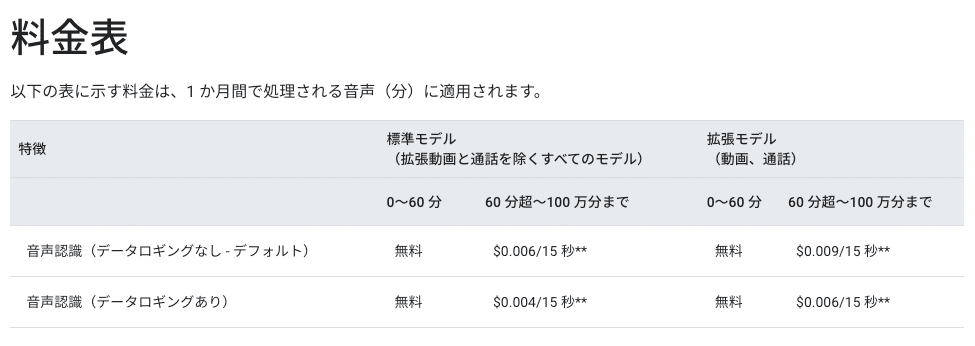

参考にまで、GoogleのSpeech-to-Textの料金表です。

https://cloud.google.com/speech-to-text/pricing

この記事が気に入ったらサポートをしてみませんか?