OpenAI共同創業者が設立した安全性重視のAI会社Safe Superintelligence Inc. (SSI) について解説

OpenAI共同創業者で、2024年5月にOpneAIを退職したIlya Sutskever(イリヤ・サスケバー)氏, ダニエル・グロス氏, ダニエル・レビー氏らが新会社を設立ました。その経緯と声明文ついて紹介します。

Ilya Sutskever(イリヤ・サスケバー)氏とは?

Ilya Sutskeverは1986年にロシアに生まれたコンピュータサイエンティストです。

XX年にOpenAIを共同創業し、Chief Scientist of OpenAIとしてChatGPTをはじめとしたLLMの開発に携わってきました。

2024年5月、OpenAIのLLMが世界的な脅威になるとして、従業員XX名とOpenAIを退職したことで話題になりました。また、2023年11月のサムアルトマンCEO解任騒動の首謀者の1人ともされています。

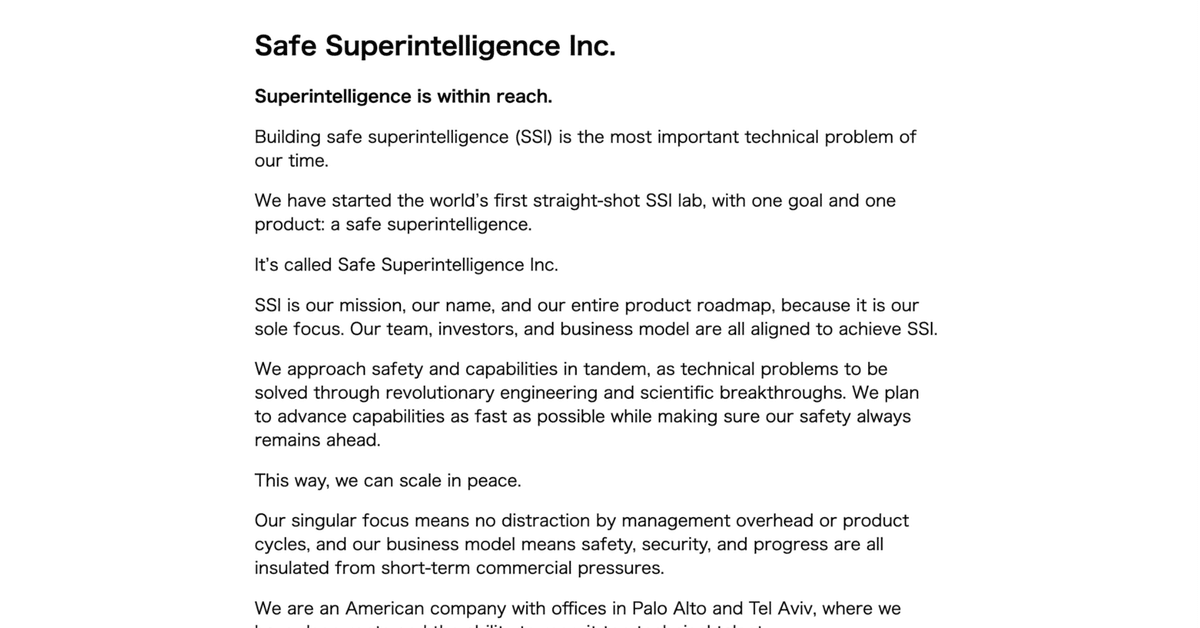

Safe Superintelligence Inc.の声明文

▼日本語訳

セーフ・スーパーインテリジェンス株式会社

超知能が手の届くところにあります。

安全な超知能(SSI)を構築することは、我々の時代における最も重要な技術的課題です。

私たちは世界初の直進型SSIラボを立ち上げました。目標は一つ、製品も一つ:安全な超知能です。

それがセーフ・スーパーインテリジェンス株式会社です。

SSIは私たちの使命であり、名前であり、全製品ロードマップのすべてであり、私たちの唯一の焦点です。私たちのチーム、投資家、ビジネスモデルはすべてSSIの達成に向けて一致しています。

私たちは安全性と能力を並行して、革命的なエンジニアリングと科学的な突破口を通じて解決すべき技術的問題として取り組んでいます。安全性が常に先行するようにしながら、可能な限り速く能力を向上させることを計画しています。

この方法で、私たちは平和にスケールアップできます。

私たちの唯一の焦点は、管理上の手間や製品サイクルによる気を散らされることなく、ビジネスモデルは安全性、セキュリティ、および進歩が短期的な商業圧力から保護されることを意味します。

私たちはパロアルトとテルアビブにオフィスを構えるアメリカの会社であり、深いルーツとトップクラスの技術人材を採用する能力があります。

私たちは、SSIにのみ焦点を当てた世界最高のエンジニアと研究者の精鋭チームを組織しています。

もしそれがあなたであれば、人生の仕事を行い、我々の時代における最も重要な技術的挑戦を解決するための機会を提供します。

今がその時です。私たちに参加してください。

イリヤ・スツケヴァー、ダニエル・グロス、ダニエル・レビー

2024年6月19日

連絡先

解釈

安全な超知能(SSI)を定義し、その実現に向けて加速的に開発を進めるための会社のようですね。

目につくのは、「安全性が常に先行するように」という部分と「短期的な商業圧力から保護される」という部分でしょうか。

推し図るに、OpenAIではこれらが実現できないと見込んだために、自ら会社を設立したのでしょう。

「短期的な商業圧力」は、Microsoft社をはじめとしたビックテックの圧力を意味するのでしょう。Web2的脅威から人々を守るという思考は、USはじめ活発なようで、AIの性能向上と同等以上に重要視されるものでしょう。

今後について

元CSOということで、OpenAIの研究成果のほとんどを把握しているであろうイリヤ氏、OpenAIがこれまで大金をかけてきた研究をショートカットできるのは間違い無いでしょう。

疑問

今後の資金源は?

LLM開発に必要であろう兆円超規模の膨大な資本はどのように、どこから用意するのでしょうか。ふと思い浮かぶのはイーロン・マスクでしょうか。たとえイーロン・マスクであっても1人でどうにかなる金額ではありませんが。

「安全性」とは?

イリヤ・サスケバーが重視する「安全なAI」のゴールとはどこなのでしょうか。オープンソース、非営利法人など手段はいくつかありますが、果たして超ビックテックの力無くして超知能に到達できるのか、気になる所です。

画像生成AI領域で有名なStable Diffusionはオープンソース化されていますが投資家からは収益性を上げろと圧力がかかっているようですし、良い事例はありませんね。

以上、補足などありましたらお気軽にコメントで教えてください。

超AI時代に期待です。

この記事が参加している募集

この記事が気に入ったらサポートをしてみませんか?