AMDはなぜ売られたのか?

アドバンスト・マイクロ・デバイセズ(AMD)は6月13日、「データセンター&AIテクノロジー・プレミア」を開催したが、投資家は感心しないようで、株価は3.61%下落した。AMDの株価は2023年に激しく上昇し、これまで94%以上上昇している。昨日の下落は株を追加するチャンスなのだろうか?そして、Nvidia (NASDAQ:NVDA)とAMD、今買うべき最高の株はどちらなのか?

一つの材料として、SemiAnalysisが発表したテクニカル分析レポートであった。参考までに、当該レポートの翻訳をしてみた。内容が濃すぎるため、一般の投資家には理解しがたい内容となっている。

お勉強が好きな投資家は読んでみてもいいだろう。

AMD MI300 誇大広告を手なずける

AIパフォーマンス、ボリュームランプ、顧客、コスト、IO、ネットワーキング、ソフトウェア

驚異のエンジニアリング、しかし市場投入までの道のりは?

レポートのリンクは以下の通り。

https://www.semianalysis.com/p/amd-mi300-taming-the-hype-ai-performance?utm_source=substack&utm_medium=email

SemiAnalysis

DYLAN PATEL, GEORGE COZMA, AND GERALD WONG

2023/06/13

GPUが大量に不足し、Nvidiaが製造コストに対して5倍以上の値上げをしているため、業界では誰もが代替案を求めてやまない。Googleは、TPUやOCSなどの成熟したハードウェアとソフトウェアにより、AIワークロードにおいて、他の大手テック企業に対して、社内では構造的な性能/TCOの優位性を持っているが、社外ではリーダーにはなれないと思われる構造問題がある。

1. Google TPUは、1つのクラウドで1つの会社からしか利用できないだろう。

2. Googleは、チップを配備された後、かなり時間が経過するまで公表しない。一方、大規模なバイヤーは、発売前に文書化し、早期アクセスシステムを発売前に入手する必要がある。

3. Googleは、メモリ/コンピューティング関連やネットワーク/デプロイメントの柔軟性など、複数の主要なハードウェア機能を何年も一貫してユーザーから隠してきた。

4. Googleは、パフォーマンスを最大化するためのカスタムカーネルを書きたいウィザードのために、ハードウェアを低レベルで外部に文書化することを拒んでいる。

AIインフラにおけるGoogleの最大の技術的進歩の門番は、Googleがそのやり方を変えない限り、構造的に、Nvidiaベースのクラウドオファリングに対して後手に回り続けるだろう。アマゾンやマイクロソフトなど他のクラウドのインハウスチップは、まだ非常に非常に遅れている。

マーチャントシリコンの世界では、GPT-3での確かなパフォーマンスと印象的なオープンソースモデルを持つセレブラス(Cerebras)が現在最も近い競争相手だが、ハードウェアへのアクセスは非常に限られており、個々のサーバーは数百万ドルもする。クラウドでCerebrasにアクセスする唯一の方法は、同社が提供するものを利用することである。アクセスの欠如は、開発の柔軟性を損なう。Nvidiaのエコシステムの生命線は、数百ドルのゲーム用GPUから、最終的には数万個のGPUを搭載したシステムに拡張できるような、さまざまなシステムで開発する人々、あるいはサードパーティのクラウドサービスプロバイダーである。Tenstorrentのような他の新興企業も有望だが、ハードウェア/ソフトウェアが本格的に普及するのはまだ少し先だと考えている。

NervanaとHabanaという2つの異なるデータセンターAIハードウェア企業を買収したにもかかわらず、世界最大のマーチャントシリコンプロバイダーであるインテルの姿はどこにも見当たらない。Nervanaは数年前に殺され、Habanaも今同じようなことが起こっているようだ。Intelは現在、第2世代のHabana Gaudi 2に取り組んでいるが、AWSで利用できる一部のインスタンス以外、ほとんど採用されていない。さらに、Intelは、この製品が2025年のFalcon Shores GPUにロールインされることで、ロードマップが死んだと既に伝えている。IntelのGPUであるPonte Vecchioは、これ以上良い状況にはない。かなり遅れており、長らく延期されていたスーパーコンピュータ「Aurora」への納入が最近完了したばかりで、さらに2年間は後継機がない。その性能は、NvidiaのH100 GPUと比較すると、一般的に競争力がない。

余談だが、6月27日にサンノゼで、Raja Koduri、TenstorrentのJim Keller、CerebrasのAndrew Feldman、MetaのHorace Heが参加するオープンソースAI、AIハードウェア、RISC-Vに関するディスカッションを開催する予定である。

AMD MI300 誇大広告を説明する

誇大広告を手なずけるには、まず、なぜその誇大広告がそもそも存在するのかを知る必要がある。誰もが代替品を求めている。AMDは、ハイパフォーマンス・コンピューティングのためのシリコンを成功裏に提供した実績がある唯一の企業である。これは、主にCPU側がよく動く実行マシンであることに当てはまるが、さらにその先もある。AMDは、2021年に世界初のExaFLopスーパーコンピュータ「Frontier」のためにHPC GPUシリコンを提供した。Frontierを駆動するMI250Xは、その主要な仕事を十分に果たしたが、クラウドやハイパースケーラの大金持ちの間では、何の影響も受けることができなかった。

現在、AMDのMI300は、今年後半にEl Capitanに搭載され、2回目のExascaleスーパーコンピュータの勝利に貢献する予定であるため、誰もが期待している。そのため、AMDの次期GPU「MI300」は、Nvidiaの地を離れれば、最も議論されるチップの1つである。SemiAnalysisは、昨年の前半からMI300チップの開発について議論してきた。MetaのPyTorch 2.0やOpenAIのTritonなど、MI300チップのソフトウェア事情に密着してきた。データセンター向けチップでこれほど話題になったのは、NvidiaのGPU「Volta」とAMDのCPU「Rome」以来である。

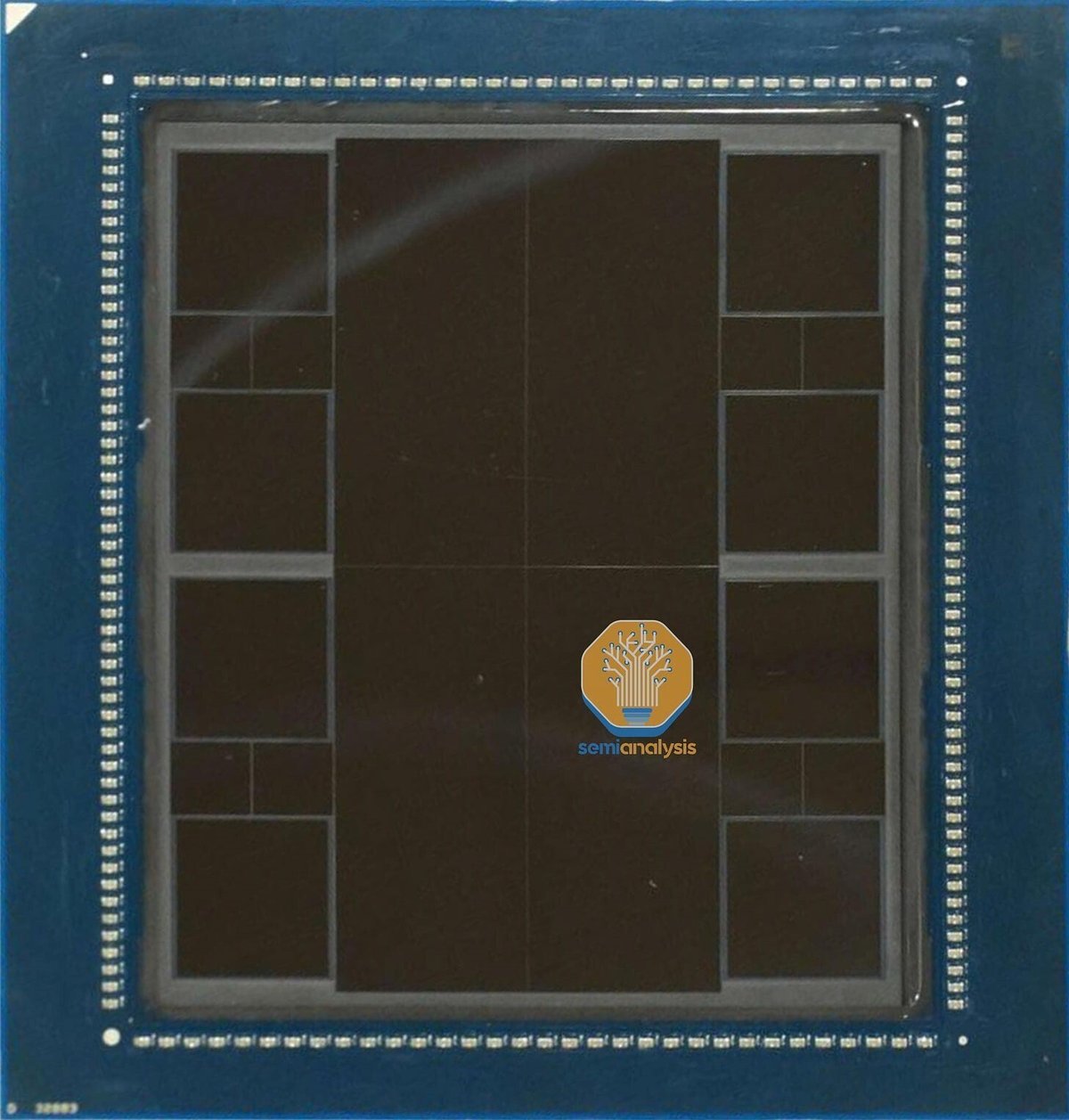

MI300、コードネームAqua Vanjaramは、いくつかの複雑なシリコンの層で構成されており、率直に言ってエンジニアリングの驚異である。CEOのリサ・スーは、今年のCESでMI300のパッケージを手に取り、MI300がどのような構造になっているかを見せてくれた。シリコンの4つの象限が、HBMの8つのスタックに囲まれているのがわかる。これはHBM3の最高速度である5.6GT/sのビンで、16GBまたは24GBのスタック8個で128GBまたは192GBのユニファイドメモリを形成し、なんと5.6TB/sもの帯域幅を実現している。

Nvidia H100 SXM 80GBの3.3TB/sと比較すると、72%の帯域幅で60%から140%の容量アップとなる。

AMDがAIコンピューティングのドルをいくらでも獲得できるチャンスは、結局のところ、Nvidiaに対してハイパースケーラーが信頼できる第2ソースとなることに尽きる。潮の満ち引きはすべてのボートを持ち上げるという前提がある。確かに、AIデータセンター・インフラに期待される大規模な支出は、何らかの形でAMDに利益をもたらすだろう?

いや、AMDのハードウェアは、AIへの出費がかさむ中で、ほとんど脚光を浴びていない。実際、現在AMDは、データセンターGPUでの成功の欠如、HGX H100システムでのCPU勝利の欠如、およびCPU支出からの一般的なシフトにより、生成的AIインフラ構築において相対的に敗者である。そのため、MI300の成功は非常に重要である。

本レポートでは、AMDのMI300のベールを脱ぐことにする。チップレットデザイン、アーキテクチャ、IOスピード、システムエンジニアリング、FLOPS、パフォーマンス、製造コスト、デザインコスト、リリースタイミング、ボリュームランプ、ソフトウェア、顧客などを取り上げる。様々なバージョンが異なる市場をターゲットにしているが、特にAIをターゲットにしたバリエーションに焦点を当てる予定である。

なお、本レポートは、当社が数ヶ月前からクライアントに提供しているレポート+解説の拡張版である。まず、ハードウェアの構成要素から始め、よりビジネス的な側面へと進んでいこう。

基本構成要素 - Elk Range(エルク レンジ)Active Interpose Dier(アクティブ・インポーザー・ダイ)

MI300のすべてのバリエーションは、AID(アクティブ・インターポーザー・ダイ)と呼ばれる同じ基本構成要素から始まる。これはエルクレンジと呼ばれるチップレットで、TSMCのN6プロセス技術で製造された約370mm2の大きさである。このチップには、2つのHBMメモリコントローラ、64MBのMALL(Memory Attached Last Level) Infinity Cache、3つの最新世代のビデオデコードエンジン、36レーンのxGMI/PCIe/CXL、さらにAMDのNOC(Network on Chip)が搭載されている。4タイル構成では、H100の50MBに対して256MBのMALL Cacheとなる。

AIDの最も重要な部分は、CPUとGPUのコンピュートに関してモジュール化されていることだ。AMDとTSMCは、AIDを他のチップレットに接続するために、ハイブリッドボンディングを採用している。銅製のTSVを介したこの接続により、AMDはCPUとGPUの最適な比率を混在させることができる。4つのAIDは、AMDのNavi31ゲーミングGPUのチップレットインターコネクトに見られるようなUltra Short Reach(USR)物理層で実現された4.3TB/sを超える二分割帯域幅で互いに通信する。ただし、今回は水平および垂直リンクと対称な読み取り/書き込み帯域幅を持つ。また、正方形のトポロジーは、対角線上の接続に2ホップが必要なのに対し、隣接するAIDは1ホップであることを意味する。

2つまたは4つのAIDは、MI300の種類によって異なるコンピュートを持っており、CoWoSシリコンインターポーザーの上にグループ化されている。AIDには2種類のテープアウトがあり、IntelのSapphire Rapidsと同様にミラーリングされている。

コンピュートタイル - Banff XCDとDG300 Durango CCD

AIDの上にあるモジュール式のコンピュートタイルは、CPUとGPUのどちらかを選択できる。

GPU側のコンピュートチップレットはXCDと呼ばれるもので、コードネームは「Banff」である。Banffは、TSMCのN5プロセス技術で、約115mm2の重さになる。合計40個のCompute Unitを搭載しているが、有効なのは38CUだけである。AMDのMI250Xから発展したアーキテクチャで、GitHubではAMDはgfx940と呼んでいるが、公にはCDNA3と呼んでいる。 計算に最適化されており、「GPU」でありながらグラフィックスを行うことはできない。NvidiaのH100も同様で、GPCのほとんどがグラフィックができないようになっている。

各AIDは合計で2つのBanffダイを持つことができ、合計76個のCUを持つことができる。MI300の最大XCD/GPU構成では、304CUを提供することになる。これは、AMDのMI250Xの220CUと比較している。

MI300のもう1つのモジュラーコンピュートの側面は、CPU側だ。AMDは、Zen 4のCCDチップレットを部分的に再利用しているが、いくつかの変更が加えられている。AIDへのSoIC用ボンドパッドを作るために、メタルレイヤーマスクの一部を変更し、メタルマスクの一部を再設計して新たにテープアウトする必要がある。この改造されたZen 4 CCD、GD300 Durangoは、GMI3 PHYを無効にしている。AIDへの帯域幅は、GMI3よりかなり高い。このCCDは、TSMCの5nmプロセス技術を採用し、デスクトップやサーバーに搭載されているZen 4 CCDと同じ約70.4mm2のダイサイズを維持している。

各AIDは、3つのZen 4チップレットを搭載し、合計24個のコアを搭載することができる。MI300の最大CCD/CPU構成では、最大96コアを提供することができる。

先進のパッケージング - 未来を味わう

AMDのMI300は、世界で最も信じられないような先進的なパッケージングを実現している。TSMCのCoWoS-S技術を用いた記録的な3.5倍レチクルシリコンインターポーザーの上に、100個以上のシリコンが貼り合わされているのである。このシリコンは、HBMメモリ層からアクティブインターポーザー、コンピュート、構造支持用のブランクシリコンまで、多岐にわたる。この巨大なインターポーザは、NVIDIAのH100に搭載されているものの2倍に近い大きさだ。MI300のパッケージングプロセスフローは非常に複雑で、各ステップで利用される正確なプロセスフローと装置について話すには、また別の機会に潜入する必要がある。

複雑なパッケージのため、MI300を期限内に完成させるために、AMDは大きな柔軟性と修正を必要とした。当初の設計では、TSMCのCoWoS-R技術で有機再分配層(RDL)インターポーザーを使用する予定だった。実際、TSMCは昨年、MI300の構造に酷似したCoWoS-Rテストパッケージを発表している。おそらく、これだけ大きなサイズの有機インターポーザーでは、反りや熱安定性に不安があるため、インターポーザーの材料を変更したのだろう。

AIDはXCDとCCDにSoIC gen 1を9umピッチでハイブリッドボンディングしている。AMDは、6umピッチのTSMCのSoIC gen 2に移行する計画を、未熟であったために撤回せざるを得なかった。そして、それらはCoWパッシブインターポーザーの上にパッケージされる。この工程では、十数個のサポートシリコンを使用する。最終的なMI300は、従来のフリップチップ一括リフロー、TCBに加え、チップオンウェハ、ウェハオンウェハ、再構成ウェハオンウェハのハイブリッドボンディングを含む。

MI300のコンフィギュレーション

AMD MI300には4種類のコンフィギュレーションがあるが、実際に4種類すべてがリリースされるかどうかはわからない。

MI300Aは、ヘテロジニアスCPU+GPUコンピュートで注目を集めるもので、El Capitan Exascaleスーパーコンピュータに採用されているバージョンである。MI300Aは、72×75.4mmの基板にヒートスプレッダを組み込んだパッケージで、ソケットSH5のLGAメインボードに収められ、1ボードに4プロセッサを搭載する。事実上、開発費の元は取れた。すでに出荷されているが、第3四半期には本当にランプがつく。標準的なサーバー/ノードは、MI300Aを4枚搭載することになる。ホストCPUは内蔵されているので必要ない。これは市場で圧倒的に優れたHPCチップであり、しばらくはこのままであろう。

MI300Xは、AIハイパースケーラのバリエーションで、成功すれば、本当のボリュームムーバーになるだろう。AIで最大のパフォーマンスを発揮するために、すべてGPUで構成されている。AMDがここで推しているサーバーレベルの構成は、8つのMI300Xと2つのGenoa CPUだ。

MI300Cなら逆方向で、96コアのZen4+HBMでCPUのみとなり、IntelのSapphire Rapids HBMへの回答となる。しかし、AMDがこのバリエーションを製品化するには、この市場は小さすぎ、製品も高価すぎるかもしれない。

MI300Pは、MI300Xの半分の大きさのようなものだ。PCIeカードでより低い電力で入ってくることができるものである。これもホストCPUが必要だ。これは、2024年のリリースになると思われるが、開発を始めるには最も入手しやすいものだろう。

本レポートでは、IOスピード、ネットワーク、システムエンジニアリング、FLOPS、パフォーマンス、製造コスト、設計コスト、リリースタイミング、ボリュームランプ、ソフトウェア、カスタマーエンゲージメント、競争力などを取り上げていく予定である。様々なバージョンが様々な市場をターゲットにしているが、特に最大の市場であるAIをターゲットにしたバリエーションにフォーカスしていく予定だ。

以上

市場の声

AMDは、AIプレゼンテーションの後、イベント前の宣伝文句と必ずしも一致しなかったため、下落した。このチップ企業は、市場に投入される新しいAIチップに関する一般的な詳細を提供したが、経営陣は、より多くの投資家を惹きつけて株価を上昇させるための財務面での後押しはしなかった。

重要なのは、AMDがAI需要の急増で活躍するデータセンター向けチップを用意していることだ。同社は、データセンターの総アドレス可能市場(TAM)が、現在の300億ドルから2027年には1500億ドルに達し、今後5年間は年率50%の巨大成長を遂げると予測している。

AMDは以前、今後5年間のTAMの総額は3000億ドルで、データセンターに割り当てられるのは1250億ドルに過ぎないと発表していた。AIイベントでは、このTAMが2027年には1,500億ドルに跳ね上がることを示唆し、収益を大きく押し上げることに成功した。

投資家が最も懸念しているのは、AIチップの実装に伴うCPU需要の振れ幅に関するこの分析だ。この製品は、GPUへの支出に大きくシフトする必要があるが(Nvidiaの数字で強調)、その過程で必ずしも追加のCPUを使用する必要はない。

SemiAnalysisが強調するように、高性能コンピューティングのためのチップを提供した実績があるのは、AMDだけである。Intel Corporation (INTC)は、AIハードウェアの買収に失敗し、Nvidia GPUに対抗するGPUを市場に投入していないため、この議論に参加することはない。このニュースにより、AMDのMI300が、同社が製造コストの5倍を請求すると推定されるGPUチップにおいて、Nvidiaに対抗する唯一の競争相手となった。

AIイベントでは、CEOのLisa Su氏が新チップ「MI300」について盛んに語っていた。MI300A(CPU+GPU)は現在顧客向けにサンプリング中で、MI300X(GPUのみ)は第3四半期にサンプリングする。両チップとも、第4四半期には以下の構成で生産が開始される予定。

・MI300A - 6 XCD(最大228 CU)、3 CCD(最大24 Zen 4 Cores)、8 HBM3 Stacks(128 GB)

・MI300X - 8 XCD(最大304 CU)、0 CCD(0 Zen 4 Coresまで)、8 HBM3 Stacks(192 GB)

市場は、AMDがNvidiaから市場シェアを奪うことができるかどうかを示すために、第4四半期の生産開始について、AMDからはるかに多くの詳細を説明してくれることを望んでいた。GPU企業(MVDAのこと)は、第2四半期の売上高がアナリスト予想を40億ドル上回り、記録的な売上高になるとの見通しを発表したばかりである。

AMDは再び、MI300が現行のInstinct MI250に比べてAI性能を8倍、ワットあたりAI性能を5倍向上させることを引き合いに出した。このチップはHPC層にはあまり支持されていないため、最終的に重要なのは、現在のAIチップの売上をすべて獲得しているNvidiaのH100との比較である。

SemiAnalysisが強調しているように、MI300は、H100よりも72%大きいバンド幅と60%大きい容量を提供する驚異的なエンジニアリングである。

MI300Xは、AIでパフォーマンスを最大化するために、すべてのGPUを搭載した本当のボリュームムーバーになることが期待される。Nvidiaのチップの過剰なコストを考慮すると、AMDはCPU市場でIntelに対してシェアを獲得し始めたのと同様に、Nvidiaに対するTCOの優位性を提供するはずである。

株価が下がっているのは、短期的に期待値を高める材料がないためだ。AMDは新しいAIチップを発表したわけでもなく、マイクロソフト(MSFT)とのAIチップに関する提携の可能性から売上につながるような詳細な情報を提供したわけでもない。

要するに、AMDは潜在的なモンスターAIラインアップを持っているが、チップはまだ発売されておらず、インテルCPUを活用しながらNvidiaが成功していることが、今のところAMDをその市場からブロックしている。同社は、今後5年以上のデータセンターの成長の大部分を牽引しうるセグメントに参加しないという究極のリスクに直面している。

AMDは今後数年で5ドル以上のEPSを獲得する可能性がある。AI分野でヒット製品が生まれれば、Nvidiaの収益が大幅に増加することを考慮すれば、この予想に大幅な上乗せをもたらすだろう。

投資家にとって重要なことは、アドバンスト・マイクロ・デバイセズ社がAIチップの販売に関してより実質的な情報を提供するまで、今後数週間から数ヶ月間、一時停止する可能性があるということである。そのきっかけは、7月下旬の第2四半期決算報告後の下期ガイダンスかもしれないし、MI300の発売のための別のイベントであるかもしれない。重要なのは、投資家はAIハイプがいつ株価に戻るかわからないということだが、AMDはMI300のAIチップラインナップの大きな可能性から、今後1年間で大きく上昇する可能性が高い。

※当資料は、投資環境に関する参考情報の提供を目的として翻訳、作成した資料です。投資勧誘を目的としたものではありません。翻訳の正確性、完全性を保証するものではありません。投資に関する決定は、ご自身で判断なさるようお願いいたします。

#AMD #AIチップ #最先端半導体 #AI競争 #AI勝ち組

#データセンター #ハイパースケーラー #NVDA #MSFT #GOOGL #AMZN #AWS #AVGO

この記事が気に入ったらサポートをしてみませんか?