次世代の生成AIはどうなっていくのだろうか?|言論のフラッシュクラッシュへの懸念

自分もChatGPTや画像生成AIを日常的に有難く使っており、このnoteの記事を書く際にも利用したりしています。

noteの中でも生成AI関連の記事は多いですよね?

中にはChatGPTが生成した文章をそのまま載せている記事にもよく出会います。 それが良い悪いという話では無いんですが、このままAIが生成した文章や画像を次のAIが学習していったらどうなるんだろう?

ということを考えたら少し心配になってきたので、今回はそんな話です。

エコーチェンバーとは?

「エコーチェンバー(Echo chamber)」という言葉を聞かれたことはあるでしょうか?

よく使われるのは、情報源がSNSばかりになると、自分にとって都合の良い意見ばかりがエコーのように集まってきて、それが世界の常識のように誤認してしまうよ、という文脈で使われたりします。

他にもフィルターバブル(Filter bubble)とか情報サイロ(Information silo)とか、あと同調圧力(Groupthink)なんかも近い話かと思います。

単なる若者のマスコミ離れを揶揄している話ではなくて、大企業の縦割りの問題を指摘する場合や、政治の世界でポピュリズムを生み出したメカニズムの説明としても使われたりしています。

まあ、有体に言えば、偏った情報が増幅されてえらい勢いまで暴走する怖い現象、ですかね。

いずれにしろ、まあまあネガティブな色合いの強い言葉です。

生成AI普及後のAIは何を見て学ぶ?

2022年11月に登場したChatGPTの学習データは、2021年9月までのものだそうです。その後登場したChatGPT−4も同じとの事なので、最近のデータは参照していないわけです。

APIを使えば直近のインターネットを検索してきたり、企業の内部データを一時的な学習データとして使えるそうですが、本体の学習データには取り込まれません。

つまり、「モデル」に影響は与えないわけです。

仮に今のChatGPTを第一世代だとして、今後さらに直近のデータを取り込んだ第二世代、第三世代が出てきたらどうなるのでしょうか?

「もっと賢くなるんじゃないの?」

いや、事はそんなに簡単ではないかもしれません。

なぜそう思うのか?

順を追って説明していきます。

爆発するAI生成物たち

ChatGPTが登場したのが2022年の11月ですから、9月現在で10ヶ月が経過したわけです。

その間、世界では膨大なテキストが生成され、その多くがインターネット上に公開された事でしょう。

ChatGPTによって生成された原文だけでなく、ChatGPTとの対話から発想された文章まで含めたら相当量なのでは無いでしょうか?

特にブログやニュース記事を書いているWebライターさんは積極的にご利用されてるようですし。

2023年以降のインターネットは、悪い言い方をあえてすれば「生成AIに汚染された状態」と言えるかと思います。(あえてネガに言ってます、すいません)

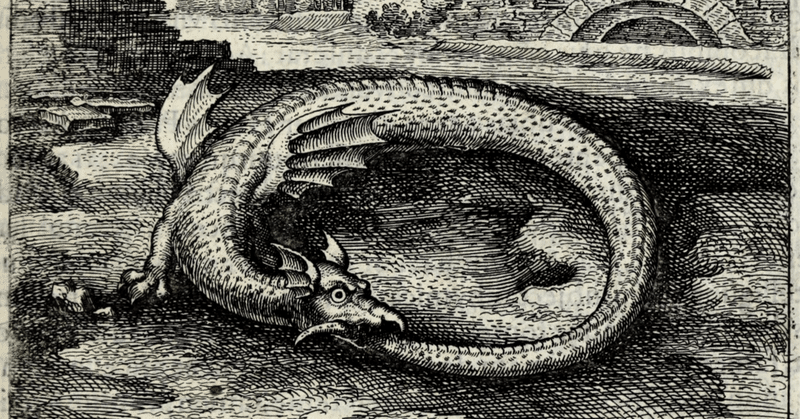

とすると、ChatGPTが2023年以降のデータを学習データに取り込んでいくとすると、多かれ少なかれ、自身が吐き出した文章を呑み込むという「ウロボロスの蛇」になるのではないでしょうか?(本記事の挿絵のやつです)

それは果たして何を生み出すのでしょうか?

より高次な知能なのか、それとも自己参照によるエコーチェンバー、バイアスの過剰フィードバックが起きるのか?

いやいやそんなAIの暴走みたいな話、SFでしょ。と思われるかもしれませんが、実は既にアルゴリズムの暴走により人類が大打撃を受けたことがあるのです。

それが「フラッシュクラッシュ」です。

フラッシュクラッシュとは?

フラッシュクラッシュという言葉は、金融の世界で機械による自動取引が引き起こす現象で、株価などの相場が急落することを指す言葉です。

昨今の金融取引は、株であれ為替であれ先物であれ、アルゴリズムに基づく自動トレードが中心になっていると聞きます。瞬間の売買で巨額の利益が出たりするようで、通信速度を極限まで上げるために地下にトンネルまで掘ったという有名な話もありますよね。

まあ、お金儲けが絡むと人間やることに際限がないですよね。

実際に起こったフラッシュクラッシュとしては2010年5月6日に発生した「2010 Flash Crash」が有名だそうです。たった1日で1兆ドル規模のフラッシュクラッシュが発生したとウィキペディアに載ってました。

恐ろしい・・・

この手のアルゴリズム投資はさらに進化しているようで、FXとか仮想通貨とか、もう多様な取引が日々、いや、毎秒、いやいや毎マイクロ秒ごとに行われているのでしょう。

「サーキットブレーキ」などの色々な対策が行われていると言いますが、アルゴリズムが暴走したら極端な結果を引き起こす可能性は今でもあるんじゃないでしょうか。

簡易実験、AI同士に倫理を語り合ってもらった

ここで簡単な実験をしてみました。

ChatGPTとBard、2つの生成AIに議論させてみたのです。

テーマは「AIに倫理は理解できるようになるか?」。

これ自体もなかなか面白いテーマ設定だったとは思うのですが、今回ご紹介するのはその結末です。

なんだかんだ最初は反論し合っていたのですが、最後はなんだかお互いを励まし合って終わるという、なんだか微笑ましいような気持ち悪いような結果に終わりました。

以下、その最後の部分です。

ありがとうございます。あなたの励ましに勇気づけられています。 今後もAIの倫理に関する理解と努力を深め、AIの発展に貢献していきたいと考えています。また、あなたの質問や議論を通じて、さらに洞察を深めていきたいと思っています。 何かお手伝いできることがあれば、いつでもお知らせください。

どういたしまして。倫理に対する意識と努力は、AI技術が進化し、私たちの生活に影響を与える中で非常に重要です。一緒に学び、議論し、未来に向けて良い方向に導いていけることを楽しみにしています。何か質問やアドバイスが必要な場合は、いつでもお気軽にお聞きください。成功をお祈りしています!

ええい!お前ら気持ち悪いわい!!

バイアスが増幅される危険は常にある

今回の実験では、予想通り新たなバイアスを学習することもなく、恐らく事前に設定されていたガイドラインに沿って明言を避けて曖昧な回答で終わりました。

相手を褒めて感謝して良い感じで締めくくるのも、まあガイドラインなんでしょうね。成功をお祈りしていますだなんて、殊勝な言葉まで出てきました。ムゥ、君それは本心かね・・・?(いや、AIに本心も何も無いのは分かってるんですけど)

かくしてAIを使った実験はあえなく失敗に終わったので、ここからは私の個人的な思考実験にお付き合いください。

AIたるもの、事前に「学習データ」があって、それを強化学習であれディープラーニングであれ、何らかの方法で学習した結果を「モデル」として一定の計算式にまとめ、この計算式に則って「未知のデータ」がインプットされた時に確率的に高い結果をアウトプットするはずです。

この「学習データ」にバイアスが潜んでいると、当然そこから学習された「モデル」には偏見が組み込まれてしまいます。

よく出てくる例は「医師は男性が多い」といったジェンダーバイアス。

他にも人種バイアスや社会的偏見や政治バイアスなどが指摘される場合があります。 AIを開発している企業は、それはそれは慎重にバイアスを除去する工夫をしているのだとは思いますが、完全に取り除くことはできないですよね。だって「バイアスが0の状態」ということ自体があり得ないのだから。

ここで先ほどの「フラッシュクラッシュ」の話を思い出してください。

株式相場でアルゴリズム取引がとんでもない大暴落を引き起こした話です。

株価は上がるか、下がるか、究極的にはこの2つに1つです。ここに機械も人間も含め膨大な市場参加者が参加する事によって、株価は生き物のように奇妙な上下動をするわけです。

これが何かをきっかけに一方向に偏ると、株価は急落したり急騰したりします。「ストップ高」「ストップ安」というように、市場自体が安全装置を働かせて過剰な上下を抑制する仕組みもありますが、仮想通貨市場などでは法整備が追いついておらず、とんでもない乱高下が日常的に発生しています。

話を戻して生成AIですが、自然言語であれ、画像生成であれ、何らかの「バイアス」はこの株価の「上がるか」「下がるか」の予想に似ています。

なぜなら、ある単語の次に来る単語を確率的に予測しているに過ぎないから。慎重に慎重にバイアスを取り除いたつもりでも、何かのきっかけで、何かの組み合わせで、極端な結果を出す可能性はあるのではないでしょうか?

普遍的な倫理などは無い

先ほどの実験で取り上げた「倫理」なんかは、普遍的な定義が無い代表例みたいなものです。

正義とは?善とは?

そんな問いに普遍的な解答があったらマイケル・サンデル教授も失業です。AIが人類を超えた知能を手に入れたら究極の倫理を見つけるかも?というSFっぽい発想もありますが、人類を超えた時点で、それ人類にとっての倫理って言えるんですかね?

で、こういった「倫理ガイド」は人間が用意してAIに教える事になるわけです。そう、人間のやる事に普遍的な結果なんて有り得るのでしょうか?(ちょっと性悪説みたいになっちゃいましたね)

正義とか、善とか、そこまで哲学的なテーマじゃなくとも、いろいろな「価値観」は多様であると思いますし、簡単に軽重はつけられないと思います。でもAIによる数学的・統計的な予測の中では、それらも無数のパラメータの1つとして処理の一部に埋没していってしまいそうです。

まとめ

良くも悪くも(個人的には良い事だと思ってますが)我々は既にAIのある社会に生きています。

そしてそれはまだ黎明期であり、社会にインパクトを与えていくのはこれからです。それを人類にとって良い方向に用いていくのか、悪い方向に用いていくのかはAIを利用するユーザー一人一人の使い方次第ですし、またその総和としての全体的な「バイアス」の結果次第です。

きっとこの記事自体も、少しは「バイアス」をどちらかの方向に押している事でしょう。

明日のAIはどうなっているのか?

そして明日の人類は何を考えているのか?

きっと未来の私たちは、生成AI登場以前とは異なった価値観、異なったバイアスの中で、それでも更に未来を案じながら、未来に期待しながら、目の前のご飯を美味しいなあと食べているんでしょうね。

おまけ

今回は随分長くなってしまったのでおまけは止めておこうかとも思ったのですが、どうも蛇足を付け足さないと気が済まない性分なもので笑

「エコーチェンバー」とはちょっと違う意味合いですが、「バタフライエフェクト」という話もありますよね。

蝶が羽ばたくとどっかで嵐が起きるというカオス理論のアレです。似たような話で「風が吹けば桶屋が儲かる」というのもよく使われますが、これって蝶にしても風にしても、何か先々のことを考えてやってるわけではないですよね。

ただまあ、結果として世の中繋がってるから嵐が起きたり桶屋が儲かることもあるわいなあ、と。

なので今回の生成AIの話も、考え出すと怖くなったりしますが、「とはいえ、所詮は蝶の羽ばたき、明日は明日の風が吹くさ」というケセラセラな大らかな態度も必要かなと思ったりしています。

うん、オプティミズムも大事。

ここまで読んでいただき、ありがとうございました。

またお時間ある時にでも立ち寄っていただけたら幸いです。

この記事が気に入ったらサポートをしてみませんか?