衝撃のスライド【325ページ】! デジタル庁公開の生成AI検証レポートが素晴らし過ぎる

2024/05/13 初版公開のスライド

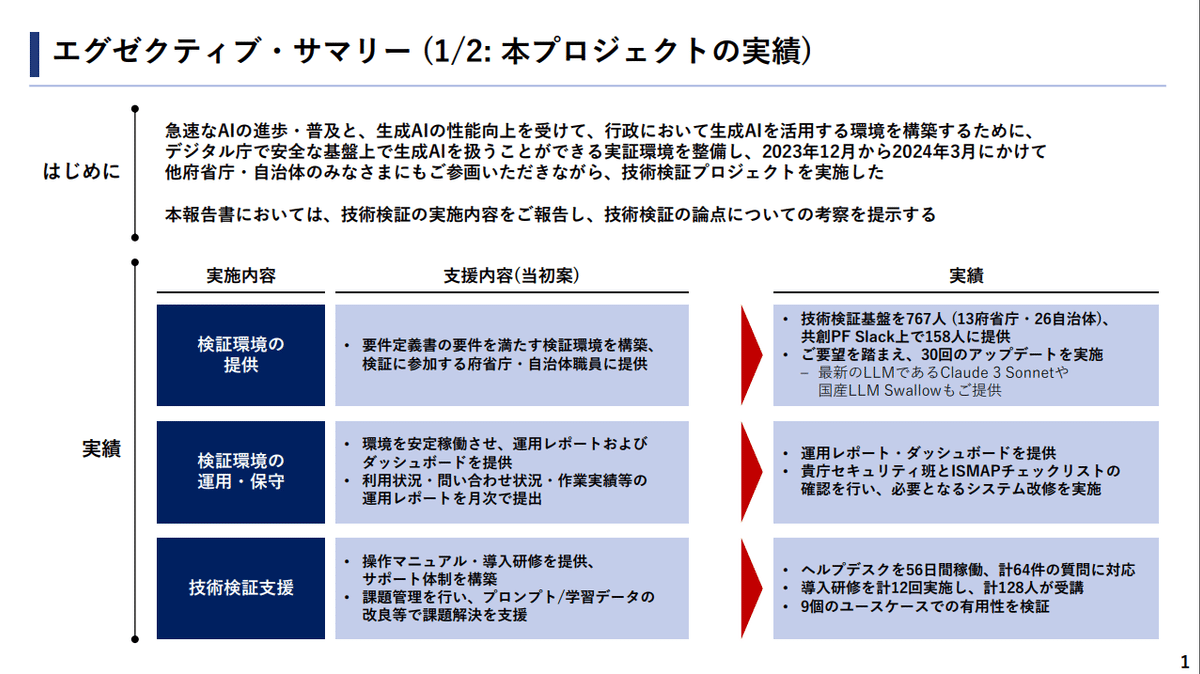

はじめに

生成AIの勢いは衰えることなく最近でもClaude3、GPT-4o、さらにGeminiとリリースラッシュが続いています。

LLMモデルを始め、LLMを利用したサービスも次から次と出てきてどれを使えばよいのか悩んでしまいますよね。

「よくわからないので、とりあえず検証してみよう」となりがちです。

「生成AIの検証レポートまとめておいて! あとはよろしく!」と突然丸投げされる人も多いのではないでしょうか?

「生成AIの検証って何をどうすればいいの?」

「レポートの作り方がさっぱりわからん」

突然丸投げされてもこういう状況になってしまいますよね。

検証の方法も報告書の書き方もいまいちピンと来ません。みなさんなら、どうこの難題に立ち向かいますか?

まずは、周りの人に聞いたりすることから始めるかもしれませんが、よいアドバイスが得られずに途方に暮れることも多々あるでしょう。

さて、そんな逆境の中で道しるべになる情報を見つけました。

「2023年度 デジタル庁・行政における生成AIの適切な利活用に向けた技術検証を実施しました」

https://www.digital.go.jp/news/19c125e9-35c5-48ba-a63f-f817bce95715

ヒントになる情報が山盛り詰まった資料です。なんと、スライド325ページの特大ボリュームです。

これは目を通しておかないとまずいです。

デジタル庁 生成AI利活用検証レポート

投稿プロンプト一覧

しかも、投稿プロンプト一覧もCSVで提供されています。

それほど複雑なプロンプトではないですが、コツを押さえた使い勝手の良さそうなプロンプトがたくさん記載されています。

掲載プロンプトの例

命令書

あなたは優れたアナリストです。

{経営戦略を考えたい事業}の経営戦略を立案するにあたり、考えられるKPI、KGIをいくつか考えてください。

{KPI、KGIで示したい内容}に`なし`以外の記述があれば、その内容を踏まえたKPI、KGIを考えてください。

経営戦略を考えたい事業

経営戦略を考えたい事業の内容を教えてください

KPI、KGIで示したい内容

KPI、KGIが示す内容を教えてください

テストケース例

プロンプトだけでなく、テストケースの一覧もあります。

検証の良し悪しを計測するにはテストケースが重要です。

「テストケースって何すればいいの?」と悩んでしまいますが、これを見れば参考になります。

ユースケース

対象ユースケースもしっかり全体を俯瞰したまとめのページがあります。

適切なLLMモデル選定

今ではGPT-4、Claude3など選択肢が多いLLMモデルですが、GPT-4、Claude3レベルになると、用途によって良し悪しの差は出ますが、総合的にどっちがよいかまでは判断難しいと思います。

1つの検証例ではありますが、以下のようにまとまっているとわかりやすいですね。

定量評価、定性評価

評価基準の方針などがまとめられています。

検証基盤の利用頻度

このページは特に面白いなーと思いました。

ふつうだと、検証は「検証することが前提」で進めますが、このアンケートらしき回答を見ると、「検証しなかった人もいる前提」の検証だったようです。

つまり「検証しなかった人はなぜ検証しなかったのか?」という理由も検証結果のレポートとして成り立っているということです。

「検証しない」こともレポートになるというのは、個人的には斬新でした。

業務、役割毎の利用

このページはよくある役職別、業務別の割合です。

LLM別利用状況

Claude3とGPT-4は回答精度的には、あまり大差ないと思ってますがGPT-4の利用が圧倒的のようですね。

このあたりは知名度が影響しているのかもしれません。

検証課題の結論

結論のページもわかりやすくまとまっています。

利用アカウント数、リクエスト数

このあたりも検証の情報としてはよく見る数値ですが、しっかり押さえてあります。

継続利用者数

この数値はあまり見たことがなかったですが、たしかにアカウント登録して1,2回使ったあと飽きて使わなくなる人も多いのではないでしょうか?

本当に業務で役立てている人は日々継続して使う傾向があるので、この継続利用者数と言うのは指標として良さそうですね。

リリースノート

日々検証基盤が進化しているのがよくわかります。

基本的なことですが、面倒なのでついサボりがちになるので見習いたいです。

検証のプラットフォーム

シンプルにAWSとAzureを使った環境のようですが、資料としてはわかりやすいイメージです。

RAGも使ってるようですね。

PlayGround

最近トレンドになってきていますが、複数のLLMモデルの結果を横並びにして比較できる機能もあります。

Web検索設定

この検証環境は外部のWebサイトも検索してLLMの回答に含めるようにできるようです。

Slack連携

Slack連携もあります。

検証レポートのヒントになるだけでなく、社内システムづくりのヒントにもなりそうですね。

プロンプトの発展過程

プロンプトの結果だけでなく、改善の過程もレポートとしてあります。

レポートとして、結果のプロンプトだけ貼り付けることが多いですが、「どうやって改善していったか」という過程がわかるのも非常に価値ある情報です。

あるべき将来像

あるべき将来象がわかりやすくイメージ化されています。

イメージを作ると、概要過ぎたり細かすぎたり、さじ加減が難しいですが、これくらいのレベル感だと誰にでもわかりやすく伝わりそうです。

改善効果とコスト

これもレポートとして重要なポイントですが、ちゃんと計算式もさっと算出して一目瞭然になっています。

定性効果

定性効果の説明もあります。

数字の定量効果だけでも検証結果にはなりますが、定性効果も重要です。

評価基準と評価要件

評価基準や評価要件も明示してあります。

「何となく検証しました」ではないのがこのページでわかります。

シーケンス図

シーケンス図のページまでありました。

これはおまけのようなページかもしれませんが、一切手を抜かないという意気込みは感じます。

ユースケース概要

これくらいの粒度のイメージはとてもわかりやすいです。

ついつい複雑に書いてしまいがちですが、書くべきイメージのさじ加減がわかるだけでも参考になります。

ソースコード言語変換、プロンプトの試行過程

ソースコードの言語変換も検証されています。

このページも試行過程がわかります。

ドキュメントの機密度判定

これはどの企業でも応用できそうです。

人手では途方もない作業も生成AIであれば、判定のアシスタントとして活用できそうです。

まとめ

検証レポートはいかがでしたでしょうか?

325ページもの分量なので今回の紹介だけでも一部ですが、これだけでも参考になるページがたくさんあったのではないでしょうか。

改めて今まで生成AIの検証レポートを見た中で、最高の質と量の検証レポートでした。

検証レポートを作る際はこれくらいの品質のレポートを書いてみたいです。

こんなレポートを見せられたら、みんな唸って文句1つ言えないかもしれません。笑

僕もレポートの書きっぷりは改めて勉強したいと思います。

この記事が気に入ったらサポートをしてみませんか?