急速に拡がる「ChatGPT」の波!果たしてコミュニティでも使えるのか?

活用が進む「生成系AI」

こんにちは。イーライフのアドバイザー水野です。

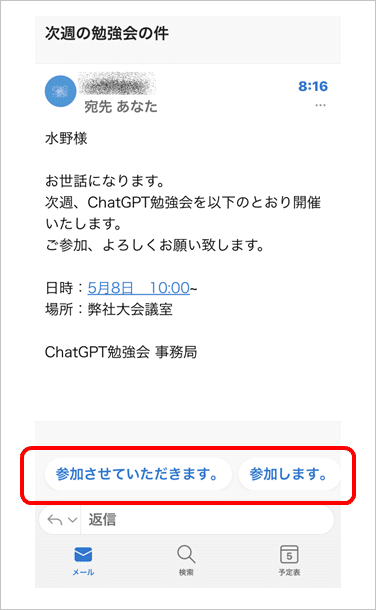

最近、ニュースなどでよく名前を耳にする「ChatGPT」。生成系AIと呼ばれるこれらのコンピュータテクノロジーは、私たちの生活のさまざまなシーンで活用が進んでいます。とりわけ、自然言語処理(NLP)の分野ではコンピュータの文章解析精度が上がっており、例えば次の図のように受信したメールの文章を解析し、適切な返答を提案してくれます。

急速な進化を見せているこの生成系AI、もとをたどると、2017年にGoogleの研究者が発表した「Transformer(トランスフォーマー)」という深層学習モデルからスタートしているようです。自然言語処理に強いこの学習モデルは、Googleが開発するBERT(注1)やLaMDA(注2)など、各社が凌ぎを削るAI開発競争につながっています。そして現在、大規模汎用モデルとして脚光を浴びているChatGPTもそのひとつです。

参考:

注1)スピーカーデッキ「自然言語生成系AIの系譜」https://speakerdeck.com/11royamasaki/zi-ran-yan-yu-sheng-cheng-xi-ainoxi-pu?slide=28

注2)ZDNET Japan「グーグル、自然な会話を実現する言語モデル「LaMDA」発表--高度な検索目指す「MUM」技術も」https://japan.zdnet.com/article/35170935/

ChatGPTは、チャット形式の自然対話による処理命令(プロンプト)入力を基本として、文章の要約や翻訳、校正・チェック、テンプレートの作成などが行えます。外部と接続するための出入口ともいえるAPIを利用して、世界の名だたる企業がこのAIを「エンジン」として活用し始めています。

ChatGPTはコミュニティでも使える!?

人間と同等の能力を持ち、24時間休むことなく働けるChatGPTは、コミュニティ運営での活用も期待できますね。

コミュニティ内で日々投稿される会員からのコメントを抽出して、前述のメールの返答のように自動で返信コメントをつけることもできるでしょう。また、大量の投稿を集めた分析も然り。人手による分析作業は膨大な労力がかかりますが、自動処理によって大幅な負担軽減が期待できます。もちろん、会員向けに行うアンケートの分析にも効果を発揮するでしょう。

ChatGPTを活用した有償のVoC解析サービスも次々と登場しています。サービスによって特色はさまざまですが、ひとつの例として「TopicScan™️」を取り上げてみますね。このサービスは、『企業コミュニティのちょっといい話 Vol.5』でも紹介したEmotion Tech(エモーションテック)社が提供しているもので、アンケートのフリーコメント・レビュー・口コミなどの分析を行うスポットサービスです。

簡単に言うと、「どんな話題が語られているか?」や「ポジティブな論調か?ネガティブな論調か?」などを自動判定して、ダッシュボードに表示してくれます。同サービスにはMicrosoft社の「Azure OpenAI Service」が採用されていますが、企業はOpenAIやMicrosoftと年間契約などを結ぶ必要がなく、使った分だけ支払えばいいようです。

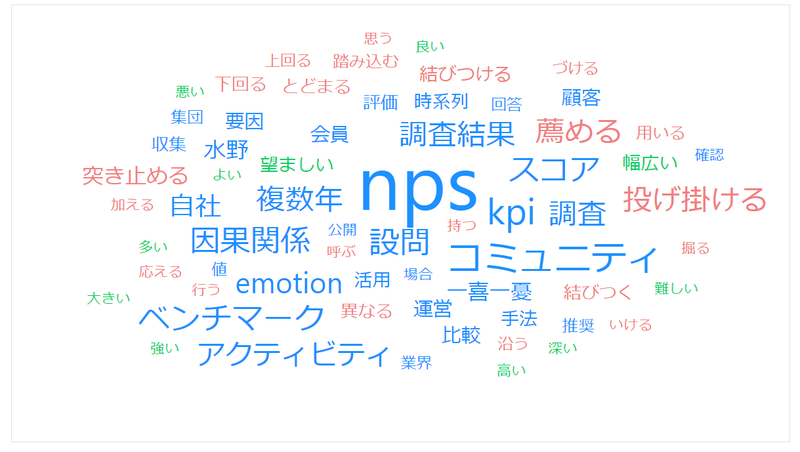

テキストマイニングのサービスは、これまでさまざまな企業から提供されてきました。しかし、ワードクラウドのビジュアル解析結果で図示される出現頻度の高い単語は「そりゃそうだ」と思うものが多く、俯瞰した整理にはなっても、新たな気づきや仮説形成には使えないこともあったのではないでしょうか。

ChatGPTをはじめとする生成系AIの活用によってこれらの精度も向上し、今後はより深いVoC解析サービスがたくさん登場すると思います。

ChatGPT利用で注意したい4つのリスク

一躍脚光を浴びたChatGPTですが、その活用にブレーキをかける動きもあります。イタリアではデータ収集方法が問題視され、一時使用禁止に踏み切りました。また、国内企業のなかにも利用を禁止する動きが見られます。ChatGPTをはじめとする生成系AIは発展途上とあって、利用にはいくつかのリスクが存在します。一般的に考えられるリスクは、次の4つです。

出力結果の信頼性

情報漏洩の可能性

少数意見の消失

意図せぬ権利侵害の可能性

ChatGPTの無償プランは、プロンプトで入力される文章をOpenAI側が利用可能であることを規約に明示しています。したがって、ここに入力される情報自体を機械が学習し、同種のプロンプトに対し学習結果として他者に提示する恐れがあるのです。

例えば、自社の商品開発にChatGPTを活用すると想定してみましょう。こんなやりと取りを行うのではないでしょうか。

あなた:「若い女性をターゲットにした、新しいアルコール飲料のアイディアを出して」

ChatGPT「以下は、若い女性をターゲットにした新しいアルコール飲料のいくつかのアイディアです。・・・」

あなた:「フレーバーにミントを使うなら、どんなアイディアが考えられる?」

ChatGPT「ミントは、リフレッシュ感のある香りと風味を持っています。そこで・・・」

このように、アイディアは得られるものの、若い女性に向けた新しいミントフレーバーのアルコール飲料のアイディアは、ChatGPTの学習教材となって蓄積されていくわけです。この流れに連動して、自社(△社としましょう)の社名や商品名も入力してしまったとします。その学習結果に対し、第三者がこんな問いかけをすると、どうなるでしょうか?

第三者:「若い女性向けの、新しいアルコール飲料の開発事例を教えて」

ChatGPT:「△社では、ミントのフレーバーを用いた若い女性向けのアルコール飲料を開発しています」

このように、機密にしておきたい情報も堂々と事例として紹介することもあり得るのです。また、「出力結果の信頼性」の問題もあります。機械学習は、データを用いて精度を上げていくため、多様な意見があるなかで、データ量の多い論調の学習精度が必然的に上がります。逆に少数の意見は学習に反映されないという結果になり、少数意見が(たとえ正しくても)消失してしまうリスクもあります。

それゆえ、信憑性を欠く出力結果になる可能性があることを理解したうえで利用しなければなりません。出力結果のなかには、他者の著作権に触れるもの(当然クレジットなどの表記無しで)も存在します。活用する際は、二重三重の確認を行うことが重要です。

「ちょっといい話」第14回まとめ

対話型でいろいろなことを教えてくれるChatGPTは、ビジネスを進めるうえで心強いパートナーとなるでしょう。コミュニティ運営においても、会員からのコメントやアンケートの解析などで威力を発揮すると思います。しかし、まだまだ発展途上のツールであることも忘れてはいけません。自社の機密情報のインプットは避けるとともに、出力される結果についても十分な確認が必要です。