Auduinoマイコン活用講習会(UNIT-VでAIカメラ)

こんにちは。高校で情報の先生をしていますTakitoです。

ご高覧いただきありがとうございます。

今回は日本工学院専門学校 東京工科大学さんで「Aruduinoマイコン活用講習会」を受講してきました。教えていただいた内容を書き記しておきます。

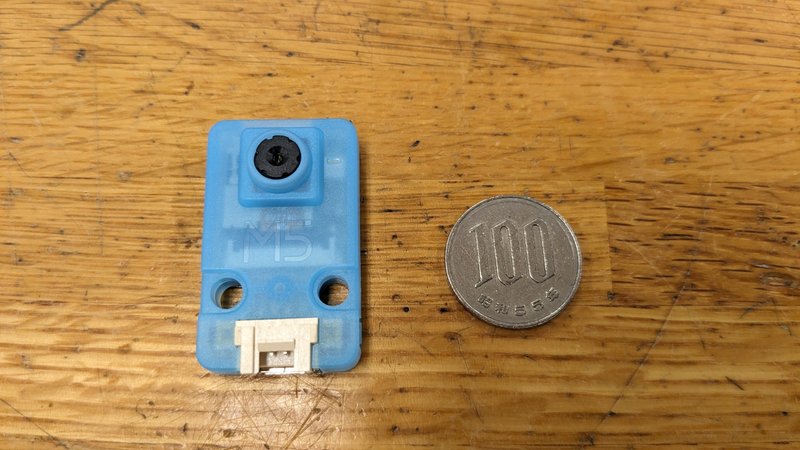

受講で使った機器(UNIT-V)

UNIT-Vはカメラ機能が搭載されたマイコンユニット。M5stackというIoTに利用できる包括なマイコン製品群の中のひとつ。カメラの他、LEDランプ1つ、ボタンを2つ搭載している。カメラ機能を持った製品の中では性能は低めだが、安価でお手頃(といっても6,000円程度)、サイズも小さい(下画像参照)。

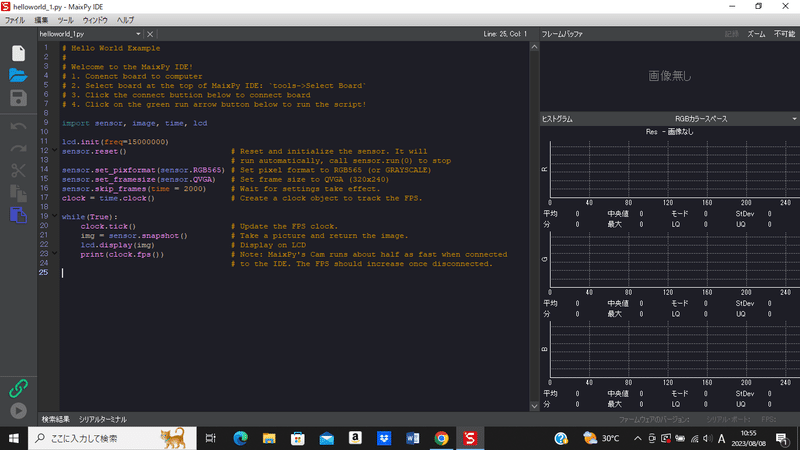

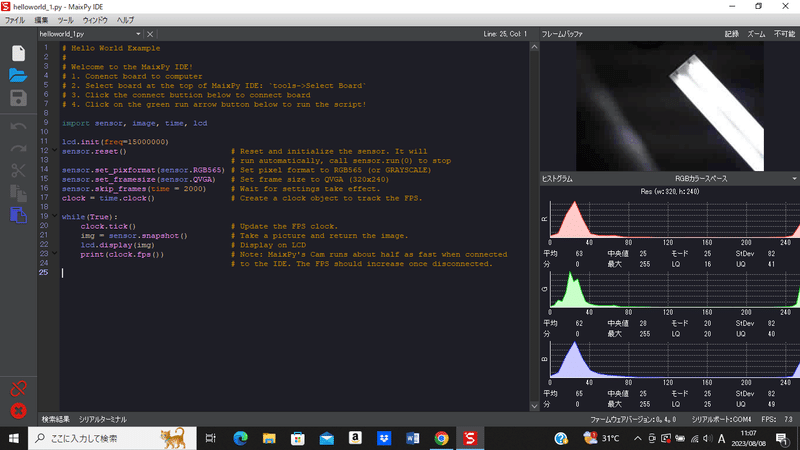

開発言語はマイコン制御ができるMicroPythonを利用、開発環境はMaixPy IDEを利用。今回の講習会では環境整備済みのPCを利用させていただいた。

自分でイチから環境を構築するのは大変そうな感じ。

UNIT-Vを使ってカメラから映像転送

PCとUNIT-Vを接続した状態で、映像を転送するプログラムを動かすと映像がPCに転送される。

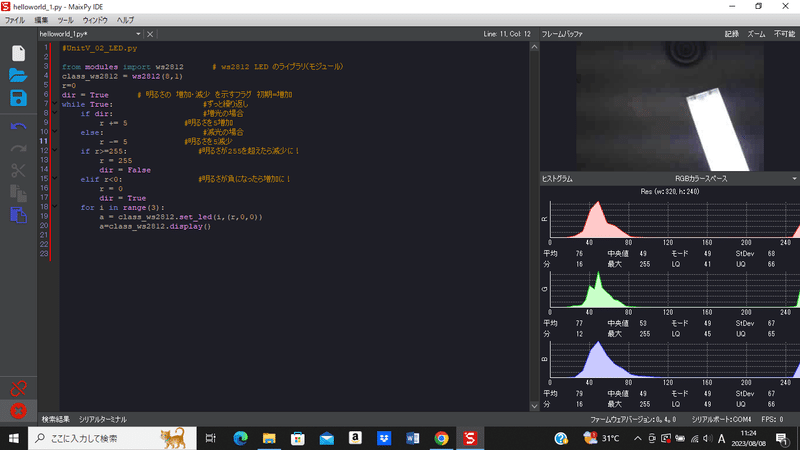

UNIT-Vを使ってLED点灯

UNIT-VにはフルカラーLEDが搭載されている。プログラムを組むことで色、明るさ、点灯時間、ボタン動作による点灯・消灯など様々な点灯動作が可能。

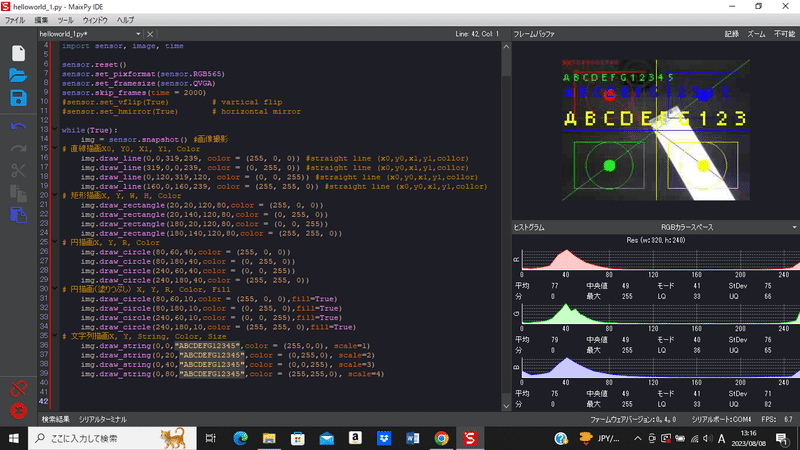

UNIT-Vからの映像に描画

UNIT-Vで撮影したカメラ映像の上にプログラミングで図形や文字を描画。

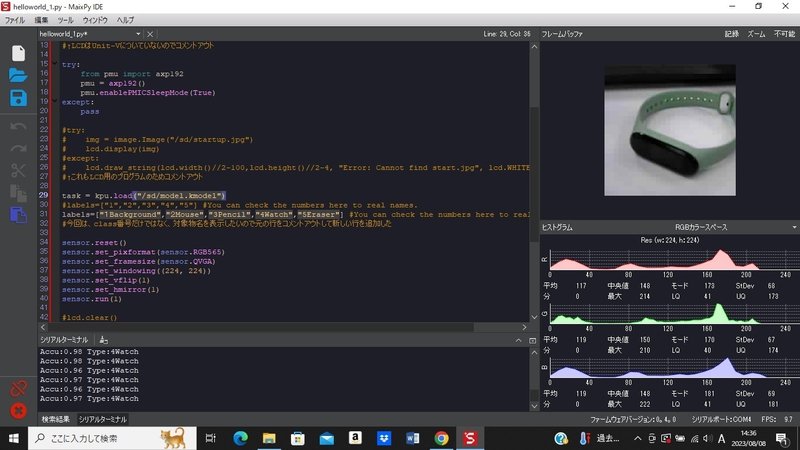

UNIT-Vと学習済みモデルを使って物体認識

機械学習された物体認識学習モデルを利用することで、UNIT-Vのカメラに映った物体が何か認識することができる。物体認識学習モデルにはGoogleが提供するVisionAIなど有名なものがあるが、おおよそのものはUNIT-Vの性能では扱うことができない。

そのため、V-TrainingというUnit-Vの開発企業が提供するサービスを利用して物体認識モデルを作る。

V-Trainingは撮影専用プログラムを使い、認識させたい物体の写真を35枚程度撮影して、指定されたサイトでデータを送付するだけで物体認識学習モデルを作成してくれるが、作成完了までに非常に時間がかかる(早くて半日、遅いと1週間)

今回は用意していただいた学習済の物体認識学習モデルを使った。

このモデルは「1.白紙、2.マウス、3.ペン、4.腕時計、5.消しゴム」の5つ物体を認識することできる。右上の画像から物体を認識し、左下のシステムターミナルに結果が表示される。

Accu: 認識精度 最大1.00(100%) Type:認識した物体

終わりに

文科省の情報科教員研修教材にmicro:bitが登場しているように、専門教科だけでなく、普通教科でもIoTに関わるプログラミングが一般的になっています。そんな中でマイコンを体験できたのは非常に大きな収穫でした。

とはいえ、今回のUNIT-Vも電子機器としては安価でお手頃でも、教材としてはまだ高価。授業のために生徒全員分を購入というのは難しそうです。ただし、課題研究のように興味ある生徒がチャレンジする題材としては良い教材になりそうです。ということで、また課外活動のひとつネタが増えました。

今回も非常に有意義な体験をさせていただきました。

関係各所の皆様、誠にありがとうございました。

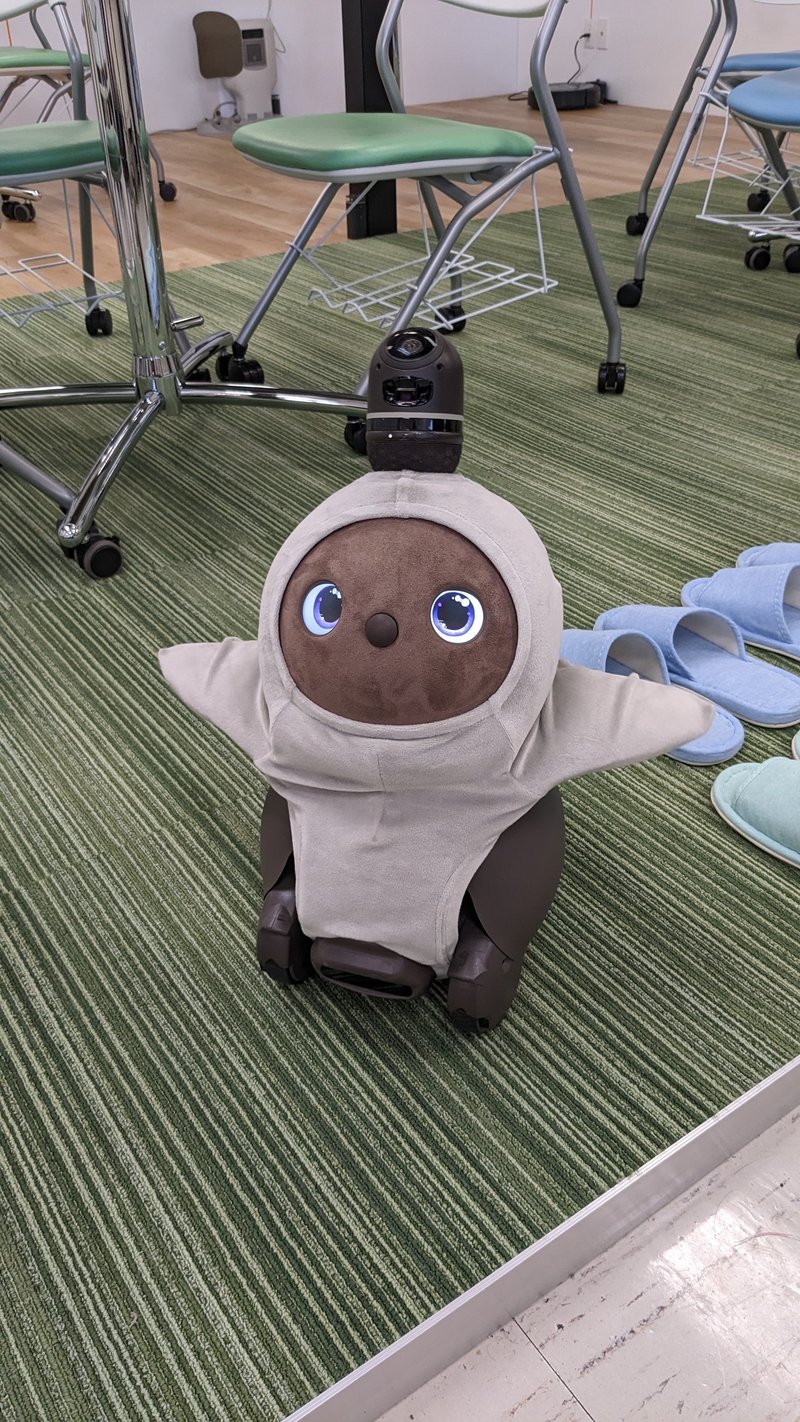

人気のロボットペットLOVOTくんにも会えました。めちゃ可愛い。

この記事が気に入ったらサポートをしてみませんか?