企業のアクセシビリティへの取組 その2(Microsoft,Lego,IBM)

1,Microsoft

Microsoftのセッションでは、小さな支援技術のパーツがたくさん紹介されているのに参加した。MSそのものというより、メインに話してくれたのは、OTさんである。なかなか楽しいセッションだった。私は初めて知ったのだが、こういったパーツに対し、3Dプリンターで個々人に合わせたアタッチメントをオンラインでオーダーしたり、身近にプリンターがあれば自分で作ったりできることだ。

OTやリハエンジニア、学校の教師など、例えば障害のある子どもに合わせた補助具を、かなり自由に、柔軟に作ることができるのだ。青い部分が、3Dプリンターで作成したものだ。発表してくれたのはOTさんだったが、地域の中にこういうことに詳しい人が居て、使えそうなATを探してくれたらいいな、アタッチメントの設計データを一緒に作ってくれたらいいな、フィッティングも一緒にやってくれたらうれしいな、などと思ってしまった。これと同じ画面は日本マイクロソフトにもあった。。日本でも自分に近い地域で、このサポートが受けられるのだろうか。OS自体をUDにするのと同時に、このような、入力装置のカスタマイズも、障害に合わせてきめ細かく可能になると嬉しいと思う。

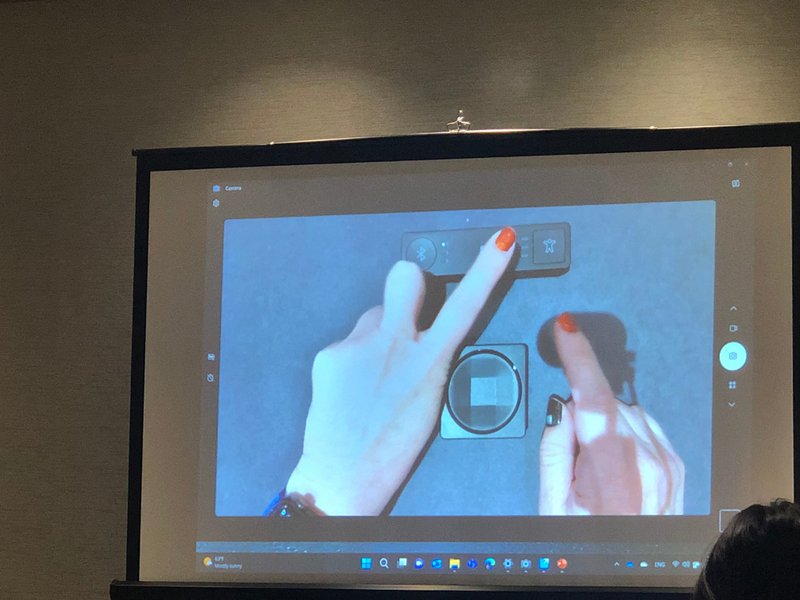

さまざまな入力オプションをコントロールできるHubと、ボタンの組み合わせになっている。会場ではこれを回覧してくれて、大きさやクリック感などの確認をさせてくれた。軽くてかわいい。

会場では、カメラを使ってどういうふうに使うのかをデモしてくれた。遠かったのであまりよく見えなかったが、少なくともかなり柔軟に、その人の状態に合わせてカスタマイズできそうだということは理解できた。一度、肢体不自由の方と一緒に使ってみたいものだ。

2,LEGO

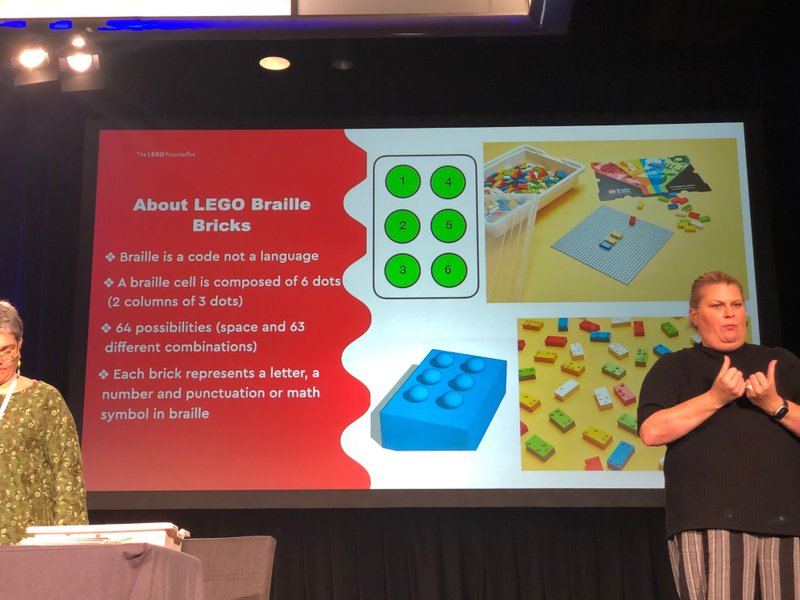

LEGOのセッションは楽しかった。もともとLEGOは、4歳から99歳までという言い方をするが、今は1歳半から使えるのもあるそうだ。100歳以上だって問題なく遊べるものもありそうなので、できたら1歳から105歳まで、と、延長して欲しい気がする。さて、今回は、LEGO® Braille Bricksを紹介していた。LEGOのブロックの上に点字と文字がついている。最初は視覚障害の子どもが、みんなと一緒に遊べるような晴盲両用玩具だと思ったのだけど、見える子どもも大人も、楽しく点字を学べるLEGOでもあった。4歳以上がお勧めという。

セッションでは、この点字LEGOを使って、いろんな遊び方を紹介してくれた。点字として遊ぶ以前に、まずは触覚で並べてみる!というシンプルなものに始まり、次第に難度が上がっていく。また、LEGOの上の点字を触って、遊びながら点字を覚える方法も。またその状態でのゲームやアクティビティもたくさん紹介された。動物を探して逃がしてみよう!なんてのもあった。なんだか無限大だなあ。LEGO本体がそういうものだけど、今回は触覚も総動員するからもっと面白い。想像力を駆使して、新しい遊び方をどんどん開発していける気がする。

で、会場ではペアになって、二人で一緒に遊ぶ、という方式になっていたのだが、私はまごまごしているうちにペアの相手を見つけられず、ちょっと取り残された気になった。そのとき、「一緒にやろうよ!」と合図してくれたのが、最前列に座っていた聴覚障害の女性だった。手話通訳を前にしていたので、彼女もペアを組むのが遅れたのだ。で、二人でペアを組んで、講師の指示に従ってゲームをするのだけど、これが難しい!だって目をつぶってLEGOブロックを触りながら進めるのだ。私は英語がよくわからないし、彼女は眼をつぶったら手話が読めず、盲ろう状態になる。しかし、とにかく彼女は明るい。なんとかなるわよと、どんどんトライする。二人できゃっきゃと笑いながら、手探りで目指すブロックを見つけ、並べるとか、タワーを作るとか、いろいろ挑戦した。おかしくて仕方がない!で、遊びながら、自然に点字の仕組みや規則性を覚えていく。触覚を使った新しい遊び方だ。これ、日本点字にも対応してほしいなあ。近いものはあるようなのだが。

最後に彼女に所属を聞いてみた。大学の障害学生支援センターでリアルタイムキャプションを行っている人らしい。こーんな明るい人に支援してもらったら、学生も嬉しいだろうなあ。ひたすら楽しい時間だった。

3,IBM

今回、IBM本体としては、Phill Jenkinsのセッションなどいろいろあったのだけど、時間が合わなくてVRやAI系のものにはあまり行けなかった。だが、浅川智恵子さんが出たセッションにはいくつか参加した。また、彼女が進めている、AIスーツケースのデモルームには、二回訪問して、使わせてもらった。これはなかなか面白いと思う。触覚を使うからだ。

GoogleMapで移動する場合、私たちはどうしても視覚に頼る。だが、暗い所や高齢になると、あの地図を見ながら移動するのは結構大変だ。外国などではもっと厳しくなる。だが、手に伝わるなんらかの触覚で、行先を教えてもらえれば、これはとても楽なのだ。Uberで行先を指定すればそこへ車が連れて行ってくれるように、行先を指定すれば、AIスーツケースがそこへ人間を誘導してくれる。人間Uberでもある。Whillも人を連れて行ってくれるけど、自分で歩きたいときは、こっちの方が自由である。また、スーツケースが先に進んでくれるので、白杖の代わりにもなる。フラットなのか、障害物はないのか、全てではないが教えてくれるからだ。私は以前は、重いし、階段上がれないし、とか思っていたが、実際に使ってみると、すごく楽だと思った。たぶん高齢者や外国からの旅行者にうけると思う。空港やショッピングモールで、普通に貸し出してくれると嬉しい。ま、私としては、ときどき休めるように、椅子の機能もつけてほしいけど。。。

Mile Pacielloが司会をして、AmazonのJosh、IBMの浅川智恵子、それにGregg Vanderheidenが語るという豪華なセッションもあった。全盲二人なのでなかなか楽しかった。(浅川さんの到着が遅れ、私は心配して会場外の廊下まで迎えに行ってしまった。AIスーツケースが千客万来で抜けにくかったそうだ。)このパネルは、この30年以上のATとUDの歴史を振り返るものではあったが、これからやりたいことをたくさん語っていたし、Joshのような若いメンバーも参加していたので、これからのUDについて明るい未来を予感させるものでもあった。浅川さんが、AIスーツケースは盲導犬の替わりか、と質問されて、替りではない、と明言していたのが印象的だった。盲導犬は、間違うことがある。それが重要なのだと。コミュニケーションを経て、共に成長していくから盲導犬はいいのだ。間違わないAIスーツケースは、別の世界のものだという。機能が誘導だけではなく、触覚によるフィードバックであることを考えると、別次元のものかもしれないと思う。今後が楽しみである。

この記事が気に入ったらサポートをしてみませんか?