マップナビゲーションは花盛り

①GoodMaps

昨年から多くの企業が、マップのアクセシビリティや歩行ナビゲーションについてセッションや展示を行っていたが、今年もこの分野は花盛りだった。

(上の写真は、Glide と白杖と盲導犬とベビーカーが写っている。なんてUDなんだ!)

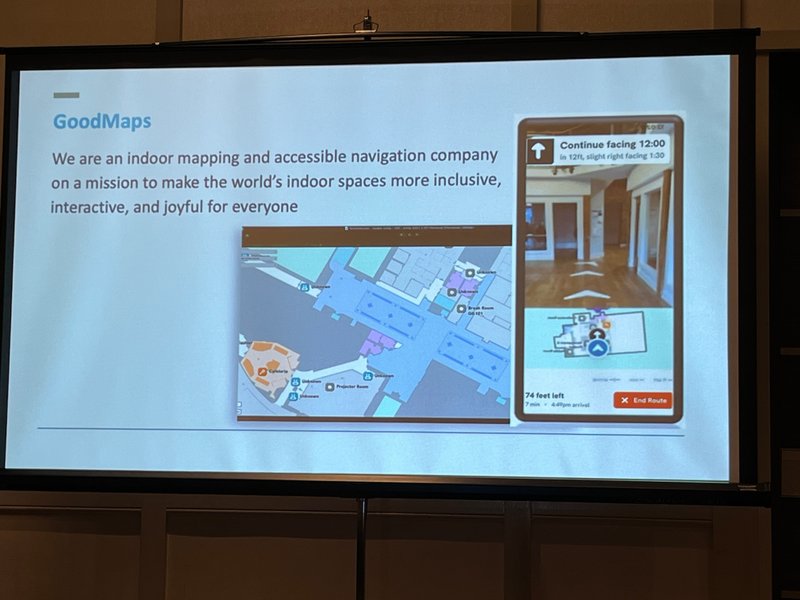

最初に行ったのは、GoodMapsの「The Future of Inclusive Digital Indoor Maps and Navigation」である。最初はAPH(American Printing House for the Blind)という視覚障害者の団体が2019年にインドアナビゲーションの会社として立ち上げたものだが、このニーズが視覚障害だけに特化したものではないと気づき、今では車いすユーザーやシニア層などより多様な利用者に機能を広げ、ユニバーサルなソリューションを提案している。

実際、屋内で目的の場所を探すのは、誰にとってもなかなか困難な場合が多い。外でだったらGoogleマップで何とかたどりつけるのに、屋内に入った瞬間から迷うことがある。空港や駅で目的のゲートやコンコースを見つけること、ホテルで自分の部屋やレストランにたどり着くこと、ショッピングモール内で目的の店やカフェを見つけること、新学期の大学内で講義室を見つけること、訪問先の会社で会議室を見つけること、病院で指定された検査室を見つけること、展示会会場で目指すブースを見つけること、などなど、考えただけでもたくさんある。

不慣れな場所で予定の時間に間に合うか、はらはらした経験は誰にでもあるだろう。 (私の場合、日本では渋谷駅や梅田駅、それから夜の温泉旅館で迷うことが多い!) 視覚障害者や言葉がわからない外国人旅行者は、なおさらだ。高齢者は案内図が見えにくく、コミュニケーションに不安のある人は知らない誰かに道を聞くことそのものが難しい。

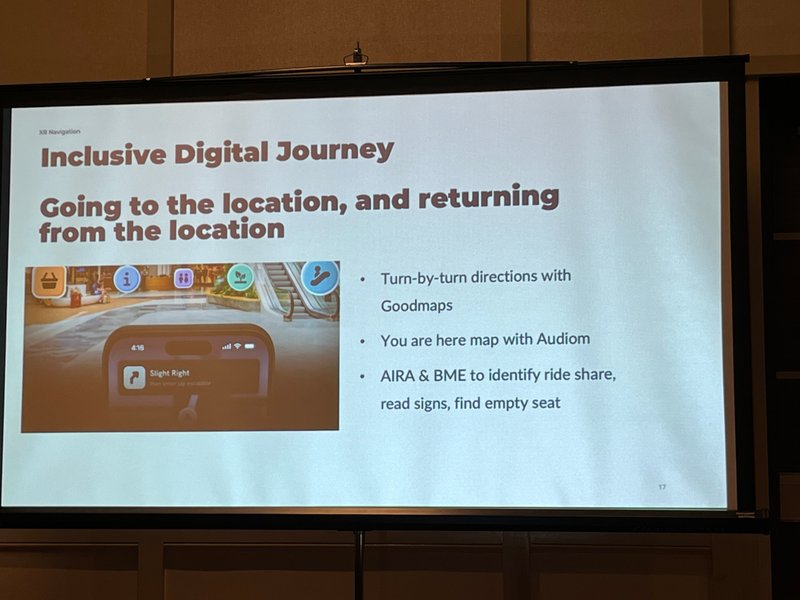

Goodmapは、そのような屋内(インドア)に特化したナビゲーションを提示している。今回は、XR Navigationという会社との共同発表だった。XRというだけあって、なかなか面白い。この会社、元は3Dプリンターで視覚障害者にタクタイルのマップや構造物を説明していたが、今はインドアナビゲーションが中心のようだ。最初に建物の構内の主なルートを3Dカメラで撮影し、データをキャプチャーする。そのデータを地図データと照合し、2D、次に3Dの空間地図を作るのである。ユーザーは歩きながら、現在地と現実の映像と照らし合わせて、今いる場所から何フィート進めばスタバがあって、そこから右に何フィートでスーパーの入り口といった情報を、音声などで得ながら進むことができる。Uberのように、目的地を設定して進むことももちろん可能だ。AIで画像認識が増えれば、もっと正確になるだろう。XRの実用例としては悪くない提案だ。将来的にはライドシェアを確認したり、サインを読んだり、空いている座席を教えてくれるかもしれないと語っていた。

私は昔から建造物を作るときの情報であるBIM(Building Information Modeling)のデータを、ユニバーサルな建物を作る際のシミュレーションに使えないかと、ずっと思っていた。3Dのモデルデータがあれば、それで車いすユーザーの移動経路や、弱視者の見え方の確認をバーチャルで行うことも可能になるはずだ。筐体がもともと持っているデータと、キャプチャーしたデータを組み合わせれば、ナビゲーションはより正確になるだろう。これまでにも視覚障害者へのインドアナビは、ビーコンを使ったもの、ナビレンズなど、たくさんの挑戦がなされてきた。今後はAIやXRを駆使したソリューションがもっと出てくる可能性が高い。とても楽しみな分野である。AIを使ったナビゲーションとしては、OKOというアプリも紹介されていた。これは屋外が中心であるが、街の中のサインなどをAIで読み取ってその情報を視覚障害者に提示するものだ。

②AccessMap

Map to Accessible Trip というセッションでは、ワシントン大学の全盲のクナルと、ノースカロライナ大の車いすユーザーのクリスティナが町中の歩道のデータを収集してGPSと連動させ、その人にあったアクセシブルルートを提示するアプリの可能性を紹介していた。ここも、先ほどのXR Navigationと連携しているという。数年前はVRとアクセシビリティが多かったが、次第にAR,MR,XRと、進化してきたということだろうか?キャプチャーされたデータが蓄積されていき、インドアおよびアウトドアで、ニーズに応じた道案内が出来ることを期待している。

③Glind

デモコーナーでも、このジャンルの製品が目立った。一番人気は、Glindという掃除機のような形をしたものだ。昨年人気だった浅川さんのAIスーツケースを小型にしたようなイメージだが、この小型掃除機?を持って動くと、手に振動が伝わり、障害物や方向を教えてくれるのだ。

これを開発したGlindanceという会社は、イギリスの盲導犬協会の会長で、Microsoftのリサーチャーだった全盲のAmos Millerである。視覚障害者が歩行する際に必要なデータをセンサーとカメラで感知し、AIで階段や障害物を教える。最初はよくできた白杖のようなものだと思ったが、いつも通るルートを指定できる。今はまだ目的地へのナビゲーションを謳ってはいないが、可能性はある。軽いのでAIスーツケースでは上がれなかった段差も超えられるかもしれない。盲導犬ロボットともいえるだろう。私自身は盲導犬のほうがずっと好きではあるが、年齢によっては使えない人も出るかもしれない。今年はまだプロトタイプだが、予約を受け付けていた。会場では、スティービー・ワンダーやハーベン・ギルマがこれにトライしたようで、CSUN後の勧誘予約メールで写真が紹介されていた。AIやIOTが、支援技術をどんどん進化させていく事例を今回はたくさん見たような気がする。AIによる技術進化や、今後の製品化が待たれる。

この記事が気に入ったらサポートをしてみませんか?