本日の日記/現在の動画生成AI(第3世代)は短命に終わる?/Runway Gen-3 Alpha Turboの特性 - Diary 2024/08/20

Ce journal est une sorte de mémo sur les activités quotidiennes du projet Generative AI.

8月19日(水)深夜2時

Runway Gen-3 Alpha のその後の検証。

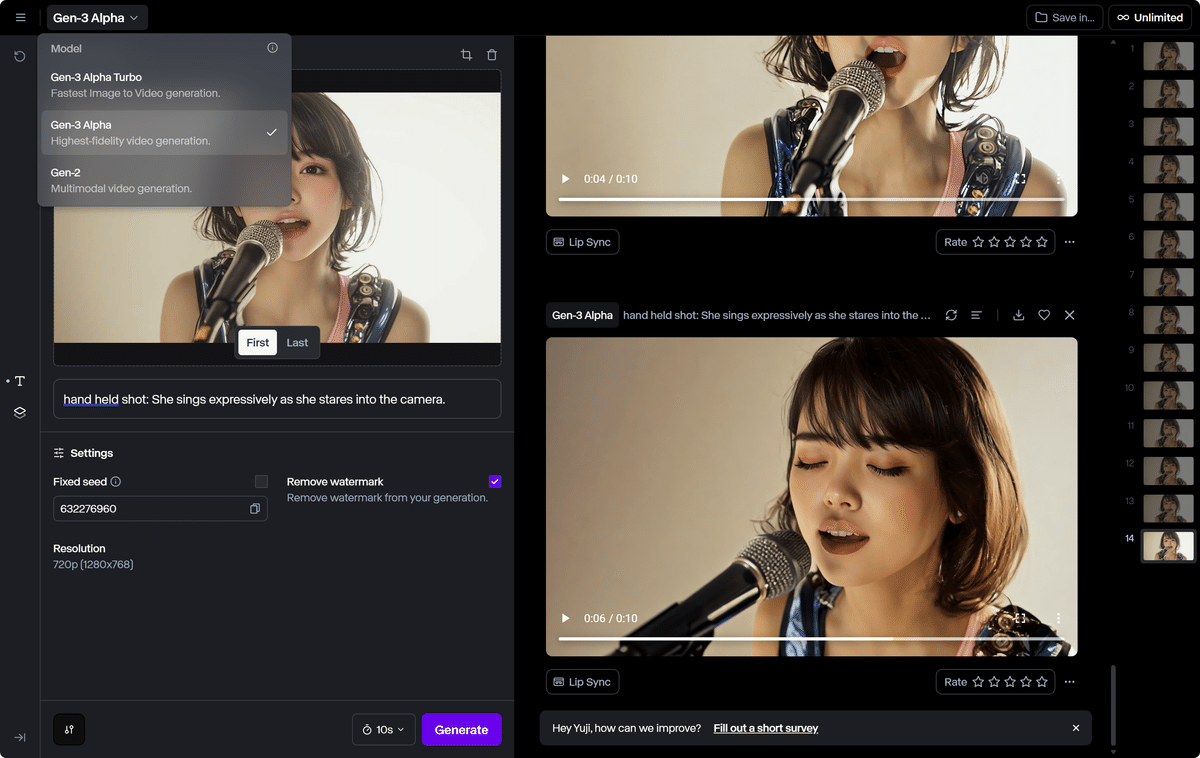

「Gen-3 Alpha」と「Gen-3 Alpha Turbo」の生成結果の違い。各々、同じプロンプトで画像ごとに10回程度生成しています。

まだ最終確認していませんが、「Gen-3 Alpha Turbo」はLuma Dream MachineのEnhanced PromptをOFFにしたときの生成結果に近いです。

Gen-3 Alpha

プロンプトに忠実でダイナミックに動くが、別人の顔に変化しやすい(デフォルトの「First」で生成)。右下の生成結果をご覧ください、顔が別人になっています。

Gen-3 Alpha Turbo

動きの変化は小さいが(スローモーションになる)、人物の一貫性は保たれている。8~10秒で参照画像に戻っていますので、この画像の場合は「First」と「Last」どちらも効いているという仮説。

Gen-3 Alpha

プロンプトに忠実でダイナミックに動く(デフォルトの「First」で生成)。ハルシネーションが目立ちますが、映像としては迫力があります。

Gen-3 Alpha Turbo

一貫性は保たれていますが動きの変化は小さく、スローモーションになる。メインの人物の走りは不自然ですが、背景の人物は忠実に動いています。映像の素材として使用するのは厳しい。

Gen-3 Alphaは、プロンプトに忠実で動きに迫力があります。ただ、ハルシネーションがひどいので慎重にチェックする必要があります。

Gen-3 Alpha Turboは(この画像だと)ほとんど静止画。Luma Dream MachineのEnhanced PromptをOFFにしたときの生成結果と同じで、プロンプトをしっかり書かないと動いてくれない。

今のところ、「Gen-3 Alpha」と「Gen-3 Alpha Turbo」どちらも必要で、必要に応じて切り替えることになりそう。

8月20日(火)早朝5時

少々お待ちください、撮影ルームに移動中。

移動中に確認。「Gen-3 Alpha Turbo」で10回以上生成しても動かなかった画像、「Gen-3 Alpha」だとプロンプトどおりに動きました(しかも成功率高い)。

高速なったのでGen-3 Alpha Turboをメインで使っていましたが、Gen-3 Alphaと切り替えながら試さないとダメですね…

「Gen-3 Alpha Turbo」で作ったMV、「Gen-3 Alpha」で作り直して比較してみた方がよさそう。

20日(火)午前

MVの画像だと、「Gen-3 Alpha」はぜんぜんダメでした。顔が別人に変わってしまうので使えない。10回生成して確認。

「Gen-3 Alpha Turbo」は一貫性を保っていて良好。ただ、プロンプトの書き方でかなり結果が変わります。

動画生成AIを使用したコンテンツ制作は第4世代まで待つ方がいい?

動画生成AIは6月12日のLuma Dream Machineリリース以降、第3世代となりましたが、技術的にはまだ過渡期で評価が難しい。

個人的には、第4世代まで待った方がよいと思っています。タイミングとしては、アメリカの大統領選挙が終わる11月、もしくは来年の3月あたり。

CMや映画などのプロフェッショナル領域では、動画生成AIのエンタープライズ版カスタムモデルが使用される。大規模な組織向けで高額だがプロ仕様。

現在、私たちが使っているのはコンシューマー領域の最上位プランですが、CMや映画などに使用できるレベルではないので、個人的な娯楽目的や商業作品のプロトタイプ制作などで使用されています。

ただ、自主映画制作やアートアニメーションなどの実験映像として許容できるジャンルは現在の動画生成AIでも可能ではないかと。

むしろ、今までなかった新規性の高い映像表現に挑戦できるので、映像クリエーターの方にとってはチャンスだと思っています。

公共性の高いテレビなどで流れるCMや一般対象の映画ではなく、実験映像の領域で誰も見たことがないような映像表現を開発する。今の動画生成AIを使うなら、ハルシネーションをプラスに働かせる方がいい。

20日(火)午後

意見交換会のメモ

V6.1 のテスト

生成画像に独自性を持たせるには、Personalizationを適用した状態でパラメータの値、組み合わせを決めていく必要がある。

--style raw --p --s 50 --q 2 --v 6.1

人物の顔だけなら、検知サービスを使っても写真と区別できなくなる可能性が高いとのこと(現在は判別できる)。

YouTubeもVimeoも実写と区別できない表現には、AIラベルを付加するため投稿時にAI生成物であることを明示しないといけませんが、まだオプションになっている(この設定があることを気づいていない人の方が多いはず)。

第2世代および現在の第3世代の動画生成AIで作られた映像は容易に判別できますが、今後出てくる第4世代あたりから難しくなってくるかもしれない。

多分(動画生成に関しては)現時点で最強の組み合わせ。

Midjourney V6.1 + Runway Gen-3 Alpha

再生時間:30秒

20日(火)深夜

深夜ラジオ配信中

実験的な配信です。深夜ラジオの今後について。

次回(第36回)からメンバーシップに。

深夜ラジオ 第35回(臨時配信)

配信時間:8分47秒

限界集落に戻る。

肌寒い。風邪をひかないように注意。

8月23日(金)の日記へ

更新日:2024年8月20日(火)/公開日:2024年8月20日(火)

この記事が気に入ったらサポートをしてみませんか?