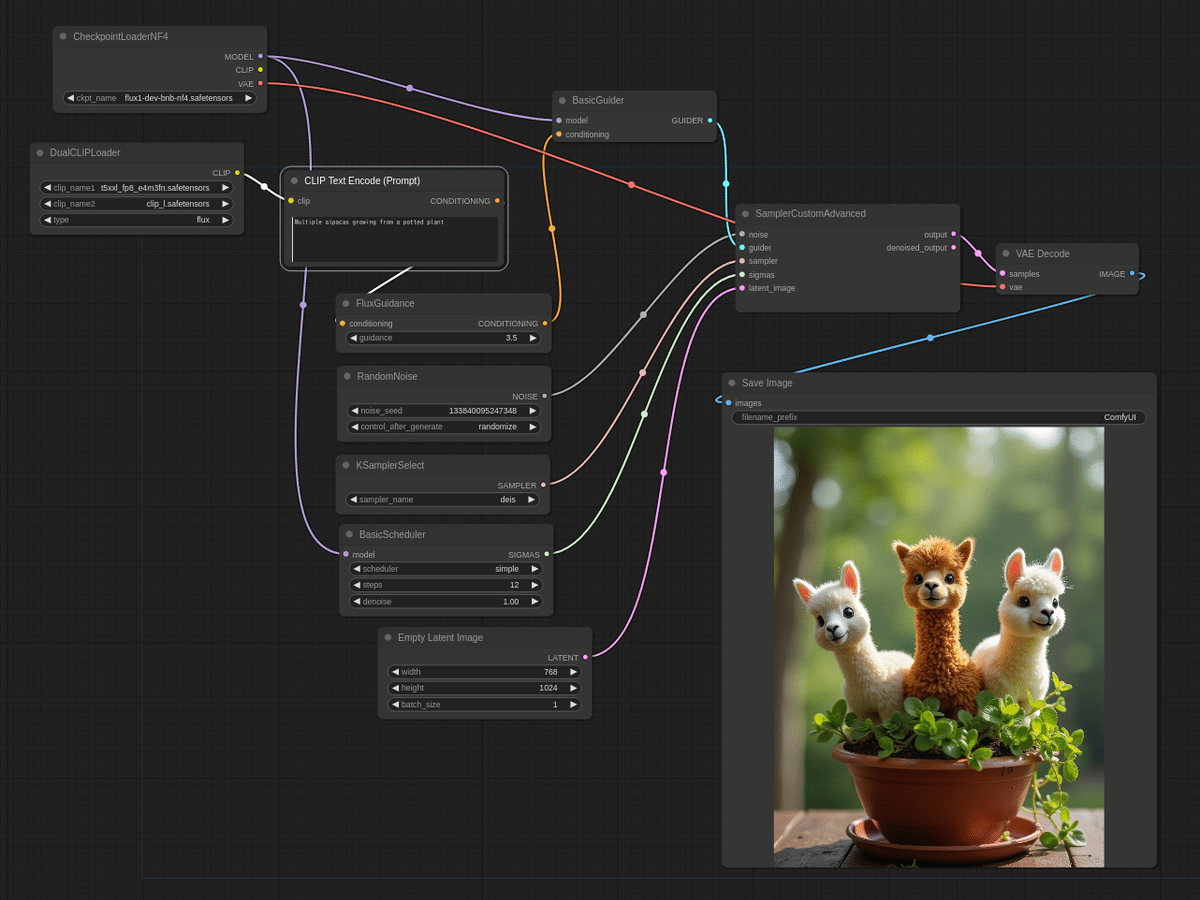

【NF4】Flux.1をローカルで動かした話③【かなり軽くなった】

割引あり

はじめに

Flux.1-devモデルを軽量化したモデルが利用できるので試してみました。

準備

「flux1-dev-bnb-nf4.safetensors」モデルをダウンロードして、ComfyUIの「Unet」フォルダではなく「Checkpoints」フォルダへ保存します。

たぶんNF4は「Non-Float 4-bit Quantization」の略なんでしょう。つまりぶつ切り量子化したモデルです。

ComfyUIで利用するには、カスタムノードの導入が必要です。

C:

cd C:\ComfyUI.d\custom_nodes

conda activate comfy-ui

git clone https://github.com/comfyanonymous/ComfyUI_bitsandbytes_NF4.git

cd ComfyUI_bitsandbytes_NF4

pip install -r requirements.txt※ ComfyUIがAnacondaでセットアップされている場合です。

その他に必要なファイルを入手します。

ComfyUIのCLIPフォルダに保存すべきもの

t5xxl_fp8_e4m3fn.safetensors

clip_l.safetensors

実行

(最適手法かどうかはわかりませんが)

jsonファイルは有料欄でダウンロードできます。ご支援よろしくお願いします。

まとめ

ミドルクラススペックのパソコンではFLUX.1のローカル利用は実用的ではないかなと考えていた矢先に軽量モデルが出てきました。このモデルであれば、十分実用的と言えます。※ それでもGPUメモリが足りず、RTX 3060 12Gで一枚あたり1分程度必要ですが

NF4モデルは、Stable Diffusion webUI forgeでも利用されているモデルです。

この記事が気に入ったらサポートをしてみませんか?