RWKV をシュッと理解する

さて、Twitter で AI 界隈の情報を眺めているとなにやら RWKV(Receptance Weighted Key Value) の論文がでてると話題になっていました。

あー、RWKV(ルワクフ)ね。

うん。知ってる知ってる。

名前だけはね、、、

Transformer までは知ってたけど RWKV はわからん!( ゚Д゚)

ということで論文を DeepL でシュッと見つつ ChatGPT4 大先生に聞きながら自分なりに解釈したので書いておく。

※私はまだまだデータサイエンス初学者なので解釈を違えている可能性があります

というエクスキューズをいれたのでシュッと書いていく。

他のモデルと何がちゃいますのん?

RWKV を調べる中でよく比較対象として Transformer と RNN(Recurrent Neural Networks)が登場します。

特に Transformer は GPT にも使われていたりと大人気モデルです。

それに対して何が違うのか?

教えて! ChatGPT 先生!

RNN(Recurrent Neural Networks)は、時間を通じて情報を覚える能力を持つスーパーヒーローと考えてみてください。彼は、過去の出来事を覚えていて、それを現在の状況に適用することができます。しかし、彼の弱点は、一度に一つの出来事しか処理できないことです。それは、彼が一度に一つの犯罪しか解決できないスーパーヒーローのようなものです

Transformerは、すべての情報を一度に処理する能力を持つスーパーヒーローと考えてみてください。彼は、一度に多くの出来事を見て、それらをすぐに処理することができます。しかし、彼の弱点は、時間が経つと情報が混ざってしまうことです。それは、彼が一度に多くの犯罪を解決しようとすると、どの犯罪が最も重要であるかを見失うスーパーヒーローのようなものです。

RWKV(Receptance Weighted Key Value)は、これらのスーパーヒーローの能力を組み合わせた新しいスーパーヒーローと考えてみてください。彼は、RNNのように時間を通じて情報を覚え、Transformerのように情報を一度に処理することができます。これにより、彼は大量の情報を効率的に処理し、重要な情報を保持することができます。それは、彼が一度に多くの犯罪を解決しながら、どの犯罪が最も重要であるかを見失わないスーパーヒーローのようなものです。

このように、RWKVは、RNNとTransformerの両方の強みを活用し、それぞれの弱点を補う新しいスーパーヒーローのようなモデルです。これにより、RWKVは、大量の情報を効率的に処理し、重要な情報を保持することができます。

流石先生、、、!!

わかりやすい、、、!!

駄菓子菓子、どうやってその力を得たのでしょう?

スーパーヒーローの力には代償が伴う、、、

RWKV(Receptance Weighted Key Value)は、以下の4つの主要な要素を使用して、時間の経過とともに情報を混ぜ合わせ、チャネル間で情報を混ぜ合わせる能力を得ています。

R(Receptance): 過去の情報を受け入れる役割を果たすReceptanceベクトルです。

W(Weight): 位置の重み減衰ベクトルで、訓練可能なモデルパラメータです。

K(Key): 伝統的な注意力メカニズムにおけるKeyに相当するベクトルです。

V(Value): 伝統的な注意力メカニズムにおけるValueに相当するベクトルです。

これらの要素間の相互作用は、各タイムステップで乗算的に行われます。

RWKVアーキテクチャは、時間の経過とともに混ぜ合わせるブロックと、チャネル間で混ぜ合わせるブロックを形成する一連のスタックされた残差ブロックから構成されています。これらのブロックは再帰的な構造を持っています。

再帰性は、現在の入力と前のタイムステップでの入力との間で線形補間として定式化されています。これは、時間シフト混合またはトークンシフトと呼ばれる技術です。これは、入力の線形投影ごとに独立して調整することができます。

また、WKV(Weighted Key Value)の更新は、時間依存的なもので、これはAFT(Attention Free Transformer)と似た計算になっています。ただし、Wはチャネルごとのベクトルで、相対位置によって乗算されます。

これらの要素とメカニズムにより、RWKVは時間を通じて情報を覚え、情報を一度に処理することができ、大量の情報を効率的に処理し、重要な情報を保持することができます。

ふむふむ。なるほどね。(なんもわからん)( ゚д゚)

助けてスーパーヒーロー!!

R(Receptance): これは、スーパーヒーローが過去の出来事を覚えている能力です。例えば、スーパーヒーローが以前に戦った悪役の弱点を覚えていて、次にその悪役と戦うときにその知識を活用することができます。

W(Weight): これは、スーパーヒーローが時間の経過とともに情報の重要性を調整する能力です。例えば、スーパーヒーローが昨日の出来事よりも今日の出来事を重視するように、情報の重要性を時間の経過とともに調整することができます。

K(Key): これは、スーパーヒーローが特定の情報を見つけ出すための鍵のようなものです。例えば、スーパーヒーローが必要な情報を見つけ出すために、この鍵を使って情報の海を探索することができます。

V(Value): これは、スーパーヒーローが見つけた情報の価値を評価する能力です。例えば、スーパーヒーローが見つけた情報がどれほど役立つか、どれほど重要かを評価することができます。

これらの特殊能力を組み合わせることで、RWKVスーパーヒーローは時間を通じて情報を覚え、情報を一度に処理し、大量の情報を効率的に処理し、重要な情報を保持することができます。それは、彼が一度に多くの犯罪を解決しながら、どの犯罪が最も重要であるかを見失わないスーパーヒーローのようなものです。

ふむ。要するに時系列とアテンションをいい感じで使いこなしているわけね。

アテンションといえば Transformer

ということで RWKV との比較を改めて教えてもらいましょう。

RWKVとTransformerの違いは、主に計算の効率性と情報の処理方法にあります。

計算の効率性: Transformerは全ての単語間の関係を計算するため、計算量が単語数の二乗に比例します。一方、RWKVは各単語が直前の単語との関係だけを計算するため、計算量は単語数に比例します。これにより、RWKVは長い文章を効率的に処理することが可能です。

情報の処理方法: Transformerは全ての単語間の関係を平等に考慮します。これに対して、RWKVは直前の単語との関係を重視し、さらに時間的な衰退を導入して古い情報の影響を減らします。これにより、RWKVは時間的な構造を持つデータを自然に扱うことができます。

並列処理の可能性: Transformerは全ての単語を同時に処理することができるため、並列処理に適しています。一方、RWKVは各単語を順番に処理するため、並列処理は難しいです。しかし、RWKVは時間的な構造を利用して一部の計算を並列化することができます。

デコーディングの方法: Transformerは全ての単語を一度にデコードしますが、RWKVは各単語を順番にデコードします。これにより、RWKVはRNNのように動作し、長いシーケンスを効率的に処理することができます。

以上のように、RWKVとTransformerはそれぞれ異なる特性を持ち、それぞれのタスクやデータによって適したモデルが変わる可能性があります。

うん?RWKV は Tranformer と比べてアテンション機能が弱い、、、ということかしら?

RWKVは、全ての単語を同時に考慮するTransformerとは異なり、直前の単語のみを考慮するという特性があります。これは、一見すると精度が低下する要因に思えるかもしれません。しかし、RWKVはその特性を補うために、時間的な混合成分を利用して情報を伝播させるという独自のアプローチを採用しています。

具体的には、RWKVは時間的な混合成分を用いて、過去の情報を現在の状態に統合します。これにより、過去の情報を「忘れる」ことなく、新しい情報を効率的に処理することが可能になります。また、このアプローチは、情報の伝播を効率化し、計算コストを大幅に削減します。

さらに、RWKVは「レセプタンス」という概念を導入しています。これは、新しい情報が過去の情報にどれだけ影響を与えるかを制御するゲートのようなものです。このレセプタンスにより、RWKVは過去の情報を適切に保持しつつ、新しい情報を効率的に統合することができます。

したがって、RWKVはTransformerとは異なるアプローチを採用していますが、これにより、情報の伝播と処理を効率化し、高い精度を達成しています。ただし、このアプローチは、特定のタスクや状況によっては、Transformerよりも性能が低下する可能性があることを理解しておくことが重要です。

なるほどですねぇ。アテンションではなくレセプタンスが RWKV のキーワードなわけですね。

Transformer に比べて計算効率がいい?

まさかそんなうまい話があるはずが、、、

RWKV(Receptance Weighted Key Value)モデルは、時間ステップごとに情報を処理し、その過程で前の時間ステップからの情報を引き継ぎます。これにより、モデルは時間的な構造を持つデータを自然に扱うことができます。

さらに、RWKVモデルは、異なるチャンネル(情報の種類)の情報を混ぜ合わせることができます。これにより、モデルは異なる種類の情報を統合し、より複雑なパターンや依存関係を捉えることができます。

また、RWKVモデルは、各時間ステップでの処理を一部並列化することができます。これにより、モデルは大量のデータを効率的に処理することができます。

したがって、RWKVモデルは、時間的な構造を持つデータを効率的に処理し、異なる種類の情報を統合し、大量のデータを並列に処理する能力を持っています。これにより、モデルは高いパフォーマンスを達成し、複雑な問題を解決することが可能になります。

ここちょっとわかりにくいですね。

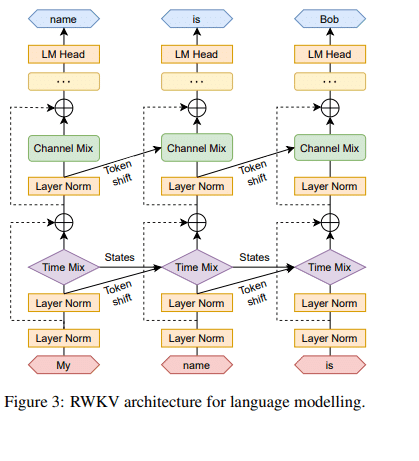

でも論文に乗っている図を見るとわかりやすいです。

https://arxiv.org/pdf/2305.13048.pdf

要するに時間軸をちょっとずつずらして並列処理できるわけですね!

かつ、Transformer とは違い直前の情報しか受け取らないので処理が速い!

しかし、図の Time Mix と Channel Mix ってなんじゃろ?

Time Mixは、時間を通じてどの情報を優先するかを決定します。つまり、過去の情報と現在の情報の間でどの程度の情報を混ぜるかを制御します。これにより、モデルは時間的な構造を持つデータを自然に扱うことができます。

一方、Channel Mixは、異なるチャネル(情報の種類)の間でどの情報を優先するかを決定します。つまり、異なる種類の情報をどの程度混ぜるかを制御します。これにより、モデルは異なる種類の情報を統合し、より複雑なパターンや依存関係を捉えることができます。

したがって、Time MixとChannel Mixは、それぞれ時間的な情報とコンテキスト情報の優先度を制御する指標と捉えることができます。これらの機能により、RWKVモデルは高いパフォーマンスを達成し、複雑な問題を解決することが可能になります。

にゃるほど!!

ということで後半雑になりましたが自分としてはある程度理解、アウトプットができたので良しとします。

シュッとするのが目的だからね。

では、おしまい。

この記事が気に入ったらサポートをしてみませんか?