PyTorch (2) - AUTOGRAD Tutorial

autograd tutorial の補足。 vector-Jacobian productの中身がよくわからないので、書き出してみる。

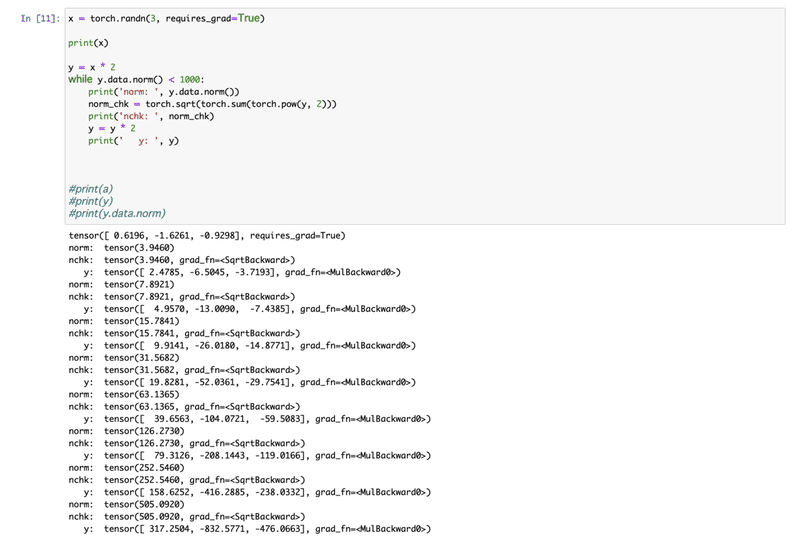

[11] この y.data.norm() は単純にtensor y のユークリッドノルムなので、二乗和のsqrtをとる(Ref.)。

[16] normを確認。

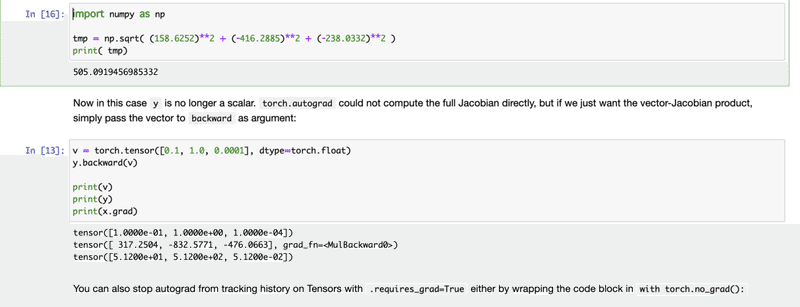

[13] while loopは y=2x, y=4x, ... と続き、最後はy=512xなので、y=[512*0.6196, 512*-1.6261, 512*-0.9298]=[317.2352, -832.5632, -476.0576]となる。

gradient(勾配)は、でd(y)/dx=d(512x)/dx at vで以下となる。

この記事が気に入ったらサポートをしてみませんか?