3Dスキャンについてわかりやすく整理してみる(2/3回)

みなさん、明けましておめでとうございます。

今年一発目のnoteは、ANDPAD ZEROの藤田が担当します。

ANDPAD ZERO noteのVol.3にて、私からよくある3Dスキャナーの種類やそれらのスキャン方法などについて簡単に説明させていただきました。

読んでいただいた方は、「3Dスキャンには、3Dスキャナーが必要なんだ」と思われたかもしれません。

しかし、実は、3Dスキャンは、3Dスキャナーを利用しなくても可能なんです。

ということで、今回は、3Dスキャナーを利用しない3Dスキャンの方法について、「フォトグラメトリ(Photogrammetry)」「NeRF(Neural Radiance Fields、通称:ナーフ)」を例に挙げて、紹介していこうと思います。

フォトグラメトリ

まずはフォトグラメトリについての紹介です。

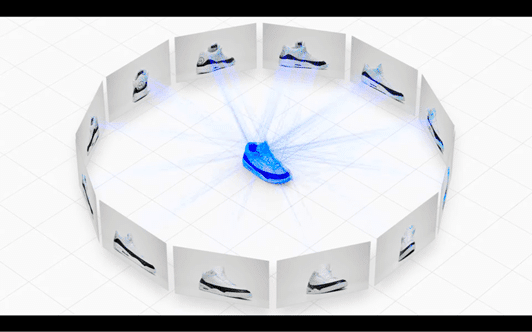

フォトグラメトリとは、簡単に言うと、「写真から3Dモデルを作る技術」です。

オブジェクトを様々な角度から撮影し、それらの写真を解析・統合することで、3Dモデルを生成します。

写真測量法とも呼ばれており、古くは19世紀から、測量や地図作成の分野で使われてきました。

現在では建築に限らず製造業やゲーム等、様々な分野で活用されています。

フォトグラメトリの始め方

フォトグラメトリはこの3つがあれば始めることができます。

● カメラ

フォトグラメトリは写真から3Dモデルを生成するため、写真の質が非常に大事になります。

スマートフォンなどのカメラでも大丈夫ですが、一眼レフのようなハイスペックのカメラの方が、より綺麗なモデルを作成できます。

● 専用ソフト

数多くのソフトウェアが出ていますが、その中でも「3DF Zephyr」というソフトがメジャーのようです。このソフトは、フリートライアル版も出ているので、まず試してみるのにはおすすめだと思います。

● パソコン

選択したソフトウェアの推奨スペック以上のものを用意してください。

おそらく現在市販されているものであれば問題ないと思います。処理する写真の枚数が多い場合はメモリを多めに積んでおくといいようです。

また、靴や花瓶のような小さいものをスキャンする場合は「ターンテーブル」、建物等の大きなものをスキャンする場合は「ドローン」があれば便利です。

写真の撮影方法

先ほどお伝えしたとおり、フォトグラメトリでは、写真から3Dモデルを生成します。そのため、利用する写真の質が良ければ良いほど綺麗なモデルが生成できます。

また、撮影する際にも下記に示すようないくつかの注意点があります。

・撮り漏れがないよう様々な角度の写真を撮影する。

(枚数は多ければ多い方がいい。)

・隣り合う写真は60%以上オーバーラップするようにする。

・オブジェクトに対してなるべく正面から撮影するようにする。

・対象物を中心にし、移動しながら撮影する。

ターンテーブルを使う場合は背景をホワイトバックにしたり、トリミングする。

・屋外で撮影する場合は曇りの日が望ましい。

(ガラス等の反射が抑えられ、綺麗にモデル作成できます。)

フォトグラメトリって実際どうなの?

フォトグラメトリは、利用するカメラや写真の撮り方等によって、3Dモデルの出来栄えが大きく左右されます。言い換えれば、常に一定のクオリティのモデルを作成できるわけではないのです。

3Dスキャナーの場合は、スキャナーのセンサーの精度によってある程度品質が担保されるのに対して、フォトグラメトリの場合は、品質の担保が非常に難しいのです。しかし、3Dスキャナーに比べて高価な専用デバイスが不要で、比較的気軽に始めることができるのはとても大きなメリットです。

また、3Dスキャナーの場合は、スキャンに光を利用するため、光を透過するもの(ガラスなど)や光を吸収するもの(黒色の素材など)、光沢のあるものの検出は難しいです。フォトグラメトリの場合も、光を透過するものや光沢のあるものを不得意としていますが、3Dスキャナーと比較するとより綺麗にモデルが生成できます。

もちろん、本当に綺麗な3Dモデルが欲しい場合はフォトグラメトリ単体での完結は難しく、生成された3Dモデルの手動補正がやはり必要になってきますし、建物や街といった大きなオブジェクトの場合、数多くの写真を使ってモデルを生成しますので、処理時間もどうしても長くなってしまいます。

それでもこちらの記事のように、一定程度綺麗に3Dモデルが作成できるのは非常に魅力的ですよね!

川越の街並み「小江戸」をVR化してみた。

— 龍 lilea / Ryo Fujiwara (@lileaLab) November 13, 2021

時の鐘や蔵造りの建物をデジタルアーカイブ。

バーチャル観光にいかが?

食べ歩きも出来ちゃいます。

VRの起動は続きからどうぞー#小江戸VR pic.twitter.com/NjiGafq3gJ

NeRF(Neural Radiance Fields)

3Dスキャナーを必要としないもう一つの方法は、「NeRF」です。

これは2020年に発表された新しい技術です。

厳密には、3Dスキャンかと問われると少し異なるのですが、類似技術としてご紹介します。

NeRFとは、様々な角度から撮影した写真を機械学習させることで、任意の視点の画像を生成する技術です。撮影写真を機械学習させる過程で3Dモデルを生成し、それにより実際には撮影していない視点の画像を作ることができます。イメージが難しいと思いますので、まずは下記Twitterに掲載されている動画をご覧ください。

3D capture of cherry blossoms at night in Tokyo and it's giving off major chill vibes 🌸🌃 Transports you back down the lanes of Tokyo with this immersive animation! #NeuralRendering #NeRF #LumaAI #VFX pic.twitter.com/1WaFsUa07Q

— Bilawal "Billyfx" Sidhu (@bilawalsidhu) December 18, 2022

非常に綺麗で滑らかに描画されていますよね。

フォトグラメトリや3Dスキャナーは、光を透過したり反射するものの検出は苦手としていますが、NeRFはそういったものでも問題なく検出できるようです。

将来的にはVR分野への応用が期待されている、今話題の技術になります。

とはいえ、NeRFはあくまでも「任意の視点の画像を生成する技術」です。

機械学習の過程で3Dモデルを生成するのですが、一般的なポリゴンとしてではなく、あくまで学習データとしてのモデルです。さきほど紹介した動画についても、NeRFにより生成した画像を使ってアニメーションとして作成したもので、厳密には3Dモデルではありません。

では、現在のNeRF Viewerがどうやって描画しているかというと、NeRFの3Dモデル(学習データ)から、さらに描画用にポリゴンに変換したりしているようです。

ポリゴンに加工する過程で情報の欠損等が発生し、上で紹介した記事のような滑らかさや綺麗さは失われてしまいます。

まだまだ発展途上の技術なため、これからの発展が非常に楽しみです。

終わりに

今回は3Dスキャナーを利用しない3Dスキャンとその類似技術について紹介させていただきました。

フォトグラメトリは実績も多いため既に知っていた方も多くいらっしゃったかもしれませんが、NeRFという新しい技術については、新鮮に、面白く読んでいただけたのではないでしょうか。

最近はVRやMRが盛り上がりを見せていますが、それらと連動するように3Dスキャンも非常に盛り上がっていると感じています。これからの動向を楽しみに追っていこうと思います。

次回は、iPhoneを活用した3Dスキャンについてお話させていただきたいと思いますので、ぜひお楽しみに!

ここまで読んでいただきありがとうございました。藤田でした!

この記事が気に入ったらサポートをしてみませんか?