OpenAI:デブ・デーでリアルタイム音声とビジョンAPIが追加・コスト98%削減!

5月に行われたOpenAIスプリング・アップデートと違い、本日のOpenAIデブ・デーはライブ配信がありませんでした。下記に、CEOのサム・アルトマンがポストで本日のアップデートを解説しています。

shipping a few new tools for developers today!

— Sam Altman (@sama) October 1, 2024

from last devday to this one:

*98% decrease in cost per token from GPT-4 to 4o mini

*50x increase in token volume across our systems

*excellent model intelligence progress

*(and a little bit of drama along the way)

本日、開発者向けの新しいツールをいくつかリリースしました。前回の devday から今回の devday まで: *GPT-4 から 4o mini へのトークンあたりのコストが 98% 削減 *システム全体でトークン量が 50 倍に増加 *モデル インテリジェンスの優れた進歩 *(途中でちょっとしたドラマもありました)

excited to make even more progress from this devday to the next one.

— Sam Altman (@sama) October 1, 2024

the path to agi has never felt more clear.

サム・アルトマンは、「この DevDay から次の DevDay まで、さらに進歩できることに興奮しています。AGI への道がこれほど明確に感じられることはかつてありませんでした。」と語り、次のポストで詳細へのリンクを紹介しています。

realtime api (speech-to-speech): https://t.co/cfUkb9hTsq

— Sam Altman (@sama) October 1, 2024

vision in the fine-tuning api: https://t.co/fDFazE7xvZ

prompt caching (50% discounts and faster processing for recently-seen input tokens):https://t.co/97mz86YVKR

model distillation (!!):https://t.co/4wH1bmP7rb

リアルタイム API (音声合成): https:// openai.com/index/introduc ing-the-realtime-api/ …

ファインチューニング API のビジョン: https:// openai.com/index/introduc ing-vision-to-the-fine-tuning-api/ …

プロンプト キャッシュ (最近表示された入力トークンの 50% 割引と高速処理): https:// openai.com/index/api-prom pt-caching/ …

モデル蒸留 (!!): https:// openai.com/index/api-mode l-distillation/

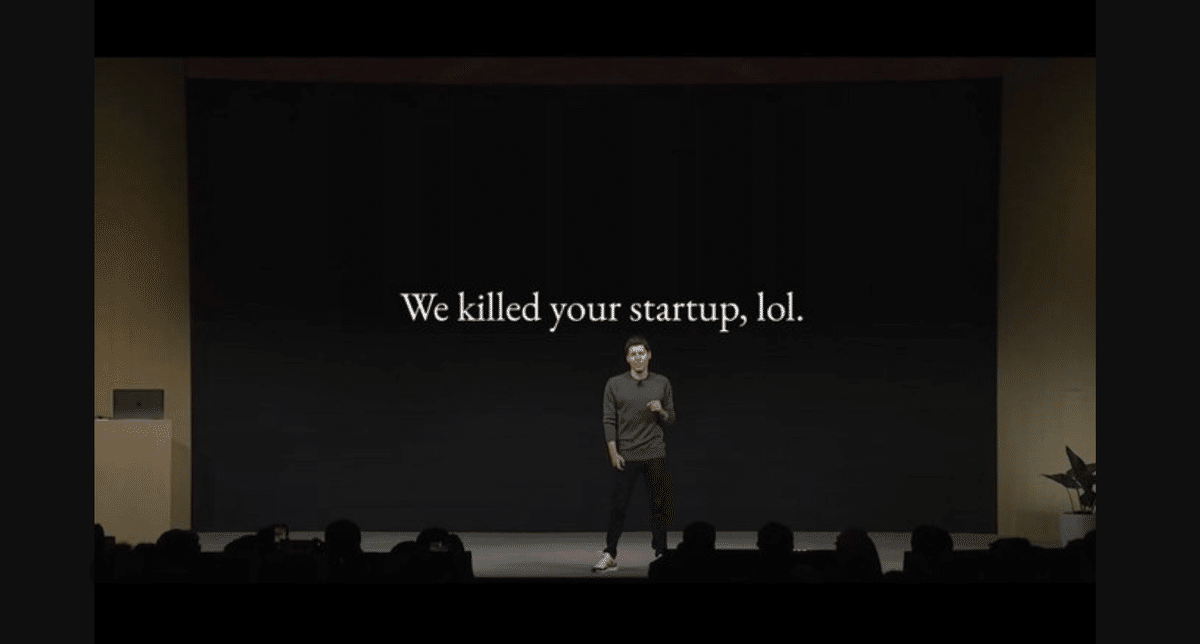

デブ・デイーにはサム・アルトマン自身も登壇し、彼の背景には、「OpenAIがスタートアップを殺す?草」と書かれています。つまり、このデブ・デーで本日発表されるChatGPTの優れたAPIでスタートアップが魅力的なツールやアプリを作る助けになると言う事を言っているのですね。それにしてもいつもこのカーキ色の無地のロンT来てますね。

それでは上記、本日のアップデートのラインナップを一つ一つ解説していきます。

リアルタイム API (音声合成)

これまで、同様の音声アシスタント体験を実現するには、開発者はWhisperのような自動音声認識モデルで音声を書き起こし、そのテキストをテキストモデルに渡して推論や推論を行い、モデルの出力をテキスト読み上げ機能で再生する必要があり、感情、強調、アクセントが失われ、遅延が顕著になることがよくありました。

Chat Completions API の使用では、開発者は 1 回の API 呼び出しでプロセス全体を処理できますが、人間の会話よりは遅くなります。

Realtime APIで遅延のないオーディオ出入力を実現

Realtime API は、オーディオ入力と出力を直接ストリーミングすることでこれを改善し、より自然な会話体験を実現します。また、ChatGPT の高度な音声モードと同様に、中断を自動的に処理することもできます。

開発者は、アプリケーションに高速な音声合成エクスペリエンスを組み込むことができるようになりました。本日よりすべての有料開発者がアプリで低遅延のマルチモーダルエクスペリエンスを構築できるようになります。

下記のポストに添付された動画は、ChatGPTにPC画面上でシンガポールでイチゴを買う店を探してもらっている様子をデモンストレーションしています。音声で色々な注文を出す毎にChatGPTは音声で返答しながら地図上でその店を示してくれます。左には音声チャットのログが流れ、右にはChatGPTが示す地図が彼女の説明に応じて表示される様が写されています。

The new Realtime API from OpenAI is incredible...

— Ty (@FieroTy) October 1, 2024

Watch it order 400 strawberries by actually CALLING the store with twillio. All with voice. 🍓🎤 pic.twitter.com/J2BBoL9yFv

OpenAIの新しいリアルタイム API は素晴らしいです... Twillio で実際に店舗に電話して 400 個のイチゴを注文する様子をご覧ください。すべて音声で行われます。

下記のポストに添付された動画はサンフランシスコについて質問していて、途中からカナダに対する質問にかわりますが、その都度ChatGPTは答えながらその答えに該当する地図を表示していく様子が写っています。

OpenAIのrealtime APIを用いた公式デベロッパーのデモ👀

— ホーダチ | AI✖️Cloud✖️Dev | 外資×ひとり法人 (@hokazuya) October 1, 2024

このスピードが本当なら、ストレスなく会話ができるので、またフェーズが一つ進む

pic.twitter.com/6QxTcApn6K

OpenAIのrealtime APIを用いた公式デベロッパーのデモ

このスピードが本当なら、ストレスなく会話ができるので、またフェーズが一つ進む

Realtime APIのパブリックベータ版

ChatGPTの高度な音声モードと同様に、Realtime APIは6つのプリセット音声を使用して自然な音声対音声の会話をサポートします。

チャット補完APIにオーディオ入力と出力を導入

Realtime API の低レイテンシの利点を必要としないユースケースをサポートします。このアップデートにより、開発者は任意のテキストまたはオーディオ入力をGPT-4oに渡し、モデルにテキスト、オーディオ、またはその両方を選択して応答させることができます。

Chat Completions API のオーディオが利用可能に

言語アプリや教育ソフトウェアからカスタマー サポート エクスペリエンスまで、開発者は音声エクスペリエンスを活用したサービスを提供することができるようになります。

Realtime API と、近々 Chat Completions API のオーディオが利用可能になることで、開発者はこれらのエクスペリエンスを強化するために複数のモデルを組み合わせる必要がなくなりました。代わりに、1 回の API 呼び出しで自然な会話エクスペリエンスを構築できます。

価格とリリース時期

Chat Completions API のオーディオは、新しいモデルとして今後数週間以内にリリースされる予定です。gpt-4o-audio-previewかgpt-4o-audio-previewを使用すると、開発者はGPT-4o にテキストまたはオーディオを入力し、テキスト、オーディオまたはその両方で応答を実現する事ができます。

Realtime API は、テキスト トークンとオーディオ トークンの両方を使用します。テキスト入力トークンの価格は 100 万トークンあたり5ドル、出力トークン 100 万トークンあたり 20 ドルです。オーディオ入力の価格は 100 万トークンあたり100ドル、出力の価格は100万トークンあたり 200ドルです。

これは、オーディオ入力 1 分あたり約 0.06 ドル、オーディオ出力 1 分あたり約 0.24ドルに相当します。チャット完了API のオーディオも同じ価格になります。

安全性とプライバシー

Realtime API は、自動監視やフラグ付きモデルの入力と出力の人間によるレビューなど、複数の安全保護レイヤーを使用して API 不正使用のリスクを軽減します。Realtime API は、ChatGPT の高度な音声モードを動かす GPT-4o と同じバージョン上に構築されており、 GPT-4o システム カードに詳述されているPreparedness Frameworkに従った評価を含め、自動評価と人間による評価の両方を使用して慎重に評価しました。Realtime API は、高度な音声モード用に構築したのと同じオーディオ安全インフラストラクチャも活用しており、危害の可能性の低減に役立っています。

OpenAIのサービスからの出力をスパム、誤解を招く、または他者に危害を加える目的で再利用または配布することは、OpenAIの利用ポリシーに違反します。OpenAIでは、潜在的な不正使用を積極的に監視しています。OpenAIのポリシーでは、文脈から明らかな場合を除き、開発者が AI とやり取りしていることをユーザーに対して明確に伝えることも義務付けています。

リリース前に、外部のレッドチーム ネットワークで Realtime API をテストしたところ、Realtime API によって、既存の緩和策でカバーされていない高リスクのギャップは発生しないことがわかりました。すべての API サービスと同様に、Realtime API は当社のエンタープライズ プライバシーコミットメントの対象となります。OpenAIが明示的な許可なしに、このサービスで使用される入力または出力でモデルをトレーニングすることはありません。

今後のリリース予定

一般提供に向けて、OpenAIは Realtime API を改善するためのフィードバックを積極的に収集しており、導入を予定している機能には次のようなものがあります。

より多くのモダリティ:まず、Realtime API は音声をサポートし、時間の経過とともにビジョンやビデオなどの追加のモダリティを追加する予定です。

レート制限の引き上げ: 現在、API のレート制限は Tier 5 開発者の場合約 100 同時セッションに制限されており、Tier 1 ~ 4 の場合は制限が低くなっています。今後、より大規模な展開をサポートするために、これらの制限を徐々に引き上げていく予定です。

公式 SDK サポート: Realtime API のサポートを OpenAI Python および Node.js SDK に統合します。

プロンプトキャッシュ:プロンプトキャッシュのサポートを追加します(新しいウィンドウで開きます)以前の会話ターンを割引価格で再処理できます。

拡張モデル サポート: Realtime API は、そのモデルの今後のバージョンで GPT-4o mini もサポートします。

ファインチューニングAPI:ビジョン

開発者は画像やテキストを使ってGPT-4oを微調整し、視覚機能を向上させることができるようになりました。

開発者はモデルをカスタマイズして、画像理解機能を強化することができるようになり、視覚検索機能の強化、自律走行車やスマート シティのオブジェクト検出の改善、医療画像分析の精度向上などのアプリケーションが可能になります。

ビジョンの仕組み

ビジョンの微調整はテキストの微調整と同様のプロセスに従っています。開発者は適切な形式に従って画像データセットを準備できます。そして、そのデータセットをOpenAIのプラットフォームにアップロードする事により、わずか 100 枚の画像で視覚タスクのGPT-4oのパフォーマンスを向上させ、大量のテキストや画像データでさらに高いパフォーマンスを実現する事ができます。

{

"messages": [

{ "role": "system", "content": "You are an assistant that identifies uncommon cheeses." },

{ "role": "user", "content": "What is this cheese?" },

{ "role": "user", "content": [

{

"type": "image_url",

"image_url": {

"url": "https://upload.wikimedia.org/wikipedia/commons/3/36/Danbo_Cheese.jpg"

}

}

]

},

{ "role": "assistant", "content": "Danbo" }

]

}

Grab:画像検出技術を向上させて道路の理解を強化

食事配達やライドシェアを提供する大手企業Grabは、ドライバーが収集したストリートレベルの画像をマッピングデータに変換し、それをGrabMapsというサービスで活用しています。

GrabMapsは、Grabの東南アジア全域の運営を支えるマッピングサービスです。Grabはわずか100件の例を使用したビジョン・ファインチューニングにより、GPT-4oに交通標識の正確な位置特定や車線区分のカウントを学習させ、マッピングデータを精緻化しました。その結果、車線数の精度が20%向上し、速度制限標識の位置特定が13%改善されました。これにより、以前は手作業で行っていたマッピング業務の自動化が大幅に進展しました。

Automat:業務プロセスを自動化するデスクトップボットの成功率を向上

企業向け自動化会社であるAutomatは、書類を処理し、UIベースの操作を行うデスクトップおよびウェブエージェントを開発し、業務プロセスの自動化を実現しています。

Automatは、ビジョン・ファインチューニングとスクリーンショットのデータセットを使用して、自然言語で記述された内容に基づき、画面上のUI要素を特定するようにGPT-4oを訓練しました。その結果、RPAエージェントの成功率が16.60%から61.67%に向上し、ベースモデルのGPT-4oに比べて272%の性能向上を達成しました。さらに、構造化されていない保険書類の200枚の画像で訓練したところ、情報抽出タスクでのF1スコアが7%向上しました。

Coframe:デジタルコンテンツ作成の質を向上

Coframeは、企業がウェブサイトやUIのバリエーションを継続的に作成・テストし、ビジネスメトリクスを最適化するためのAI成長エンジニアリングアシスタントを開発しています。

この作業の重要な部分は、ウェブサイト全体に基づいて、自動的に新しいブランドセクションを生成することです。Coframeは、ウェブサイトの既存コードや画像に基づいて、次のセクションのコード生成をGPT-4oに任せました。画像やコードを使ってGPT-4oをファインチューニングした結果、視覚的なスタイルの一貫性やレイアウトの正確さがベースのGPT-4oモデルと比較して26%向上しました。

安全性とプライバシー

OpenAIは、ファインチューニングされたモデルに対して自動安全評価を継続的に実施し、アプリケーションが使用ポリシーに従って適切に利用されているかを監視しています。すべてのAPIサービスと同様に、ビジョンファインチューニングも企業向けプライバシーに関するコミットメントに準拠しています。ファインチューニングされたモデルは完全にお客様の管理下にあり、ビジネスデータの所有権も全てお客様に帰属します。明示的な許可がない限り、OpenAIはこのサービスで使用された入力や出力をもとにモデルをトレーニングすることはありません。

ビジョンファインチューニング機能:価格

OpenAIは、ビジョンファインチューニング機能を有料利用プランのすべての開発者向けに提供しています。この機能は、最新のGPT-4oモデルスナップショット「gpt-4o-2024-08-06」でサポートされています。開発者は、Chatエンドポイントと同じ形式を使用して、既存のファインチューニング用の画像トレーニングデータを拡張することが可能です。

2024年10月31日まで、GPT-4oを画像でファインチューニングするための1日あたり100万トークンのトレーニングを無料で提供します。2024年10月31日以降、GPT-4oのファインチューニングトレーニングには100万トークンあたり25ドル、推論には入力トークン100万あたり3.75ドル、出力トークン100万あたり15ドルの料金がかかります。画像入力は画像サイズに基づいてトークン化され、テキスト入力と同じトークン単価で価格設定されます。詳細はAPIの価格ページをご確認ください。

始めるには、ファインチューニングダッシュボードにアクセスし、「作成」をクリックし、ベースモデルのドロップダウンから「gpt-4o-2024-08-06」を選択してください。GPT-4oを画像でファインチューニングする方法については、ドキュメントをご参照ください。

注釈: GPT-4oベースモデルとは「gpt-4o-2024-08-06」を指します。

プロンプトキャッシング:入力トークンの50%割引と高速処理

多くの開発者は、コードベースを編集するときや、チャットボットとの長時間の複数ターンの会話をするときなど、AI アプリケーションを構築するときに、複数の API 呼び出しで同じコンテキストを繰り返し使用します。本日、Prompt Caching を導入し、開発者がコストとレイテンシを削減できるようにします。最近使用した入力トークンを再利用することで、開発者は 50% の割引とプロンプト処理時間の短縮を実現できます。

プロンプトキャッシングの可用性と価格

本日より、GPT-4o、GPT-4o mini、o1-preview、o1-mini の最新バージョン、およびそれらのモデルの微調整バージョンにプロンプト キャッシュが自動的に適用されます。キャッシュされたプロンプトは、キャッシュされていないプロンプトに比べて割引価格で提供されます。

キャッシュ使用状況の監視

サポートされているモデルへの API 呼び出しでは、1,024 トークンを超えるプロンプトに対して、自動的にプロンプト キャッシュのメリットが得られます。API は、以前に計算されたプロンプトの最長プレフィックスをキャッシュします。これは、1,024 トークンから始まり、128 トークンずつ増加します。共通のプレフィックスを持つプロンプトを再利用すると、API 統合に変更を加えることなく、プロンプト キャッシュの割引が自動的に適用されます。

プロンプト キャッシュを使用するリクエストでは、API 応答のcached_tokens'' フィールド内に '' 値が含まれます。

usage: {

total_tokens: 2306,

prompt_tokens: 2006,

completion_tokens: 300,

prompt_tokens_details: {

cached_tokens: 1920,

audio_tokens: 0,

},

completion_tokens_details: {

reasoning_tokens: 0,

audio_tokens: 0,

}

}キャッシュは通常、5 ~ 10 分間操作が行われないとクリアされ、最後に使用されてから 1 時間以内に削除されます。すべての API サービスと同様に、Prompt Caching は当社のエンタープライズ プライバシーコミットメントの対象となります。Prompt キャッシュは組織間で共有されません。

Prompt Caching は、開発者がパフォーマンス、コスト、レイテンシのバランスを取りながら、本番環境でアプリケーションを拡張するためのさまざまなツールの 1 つです。詳細については、Prompt Caching のドキュメントをご覧ください。

APIを使ったモデル蒸留

OpenAIはプラットフォーム内で蒸留パイプライン全体を直接管理するための統合ワークフローを開発者に提供する新しいモデル蒸留サービスを導入します。

これまで、蒸留は複数のステップから成るエラーが発生しやすいプロセスであり、データセットの生成からモデルの微調整、パフォーマンス向上の測定まで、開発者は切断されたツール間で複数の操作を手動で調整する必要がありました。蒸留は本質的に反復的であるため、開発者は各ステップを繰り返し実行する必要があり、多大な労力と複雑さが加わっていました。

大規模なフロンティアモデルの出力を使用して、コスト効率の高いモデルを微調整する事ができるようになります。すべて OpenAI プラットフォーム上で実行できます。

新しいモデル蒸留サービスでできる事

これにより、開発者は o1-preview や GPT-4o などの最先端のモデルの出力を簡単に使用して、GPT-4o mini などのよりコスト効率の高いモデルを微調整し、パフォーマンスを向上させることができます。

モデル蒸留では、より高性能なモデルの出力を使用して、より小規模でコスト効率の高いモデルを微調整し、特定のタスクで高度なモデルのパフォーマンスに匹敵するパフォーマンスをはるかに低いコストで実現します。

新しいモデル蒸留スイート詳細

新しいモデル蒸留スイートには以下が含まれます。

保存された完了:開発者は、GPT-4oやo1-previewなどのモデルによって生成された入力と出力のペアをAPI経由で自動的にキャプチャして保存することで、蒸留用のデータセットを簡単に生成できるようになりました。Stored Completionsを使用すると、実稼働データを使用してデータセットを簡単に構築し、モデルを評価および微調整できます。開発者はこの統合ガイドを確認できます。(新しいウィンドウで開きます)補完を保存する方法を学ぶ。

評価(ベータ版): 開発者は、プラットフォーム上でカスタム評価を作成して実行し、特定のタスクにおけるモデルのパフォーマンスを測定できるようになりました。評価スクリプトを手動で作成してさまざまなログツールを統合する代わりに、Evals はモデルのパフォーマンスを測定する統合された方法を提供します。評価を設定するには、保存された完了のデータを使用するか、既存のデータセットをアップロードすることができます。また、Evals は微調整とは独立して使用して、ユースケースのモデルのパフォーマンスを定量的に評価することもできます。

微調整: Stored Completions と Evals は、既存の微調整機能と完全に統合されています。つまり、開発者は Stored Completions で作成されたデータセットを微調整ジョブで使用し、Evals を使用して微調整されたモデルの評価を実行できます。これらはすべて当社のプラットフォーム内で実行できます。

モデル蒸留の使い方

まず評価を作成します。この例では GPT-4o mini となる、抽出するモデルのパフォーマンスを測定します。この評価は、抽出したモデルのパフォーマンスを継続的にテストするために使用され、デプロイするかどうかを決定するのに役立ちます。

次に、ストアド コンプリーションを使用して、GPT-4o mini を微調整するタスクの GPT-4o の出力を使用した実際の例の蒸留データセットを作成します。これを行うには、Chat Completions API で「store:true」フラグを設定すると、遅延の影響を受けずにこれらの入力と出力のペアが自動的に保存されます。保存されたこれらの補完を確認、フィルタリング、タグ付けして、微調整や評価のための高品質のデータセットを作成できます。

response = client.chat.completions.create(

model="gpt-4o",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "what's the capital of the USA?"

}

]

}

],

store=True,

metadata={"username": "user123", "user_id": "123", "session_id": "123"}最後に、このデータセットを使用して GPT-4o mini を微調整します。保存された補完は、微調整されたモデルを作成するときにトレーニング ファイルとして使用できます。モデルが微調整されたら、評価に戻って、微調整された GPT-4o mini モデルが GPT-4o と比較してパフォーマンス基準を満たしているかどうかをテストできます。

微調整は反復的なプロセスです。最初の結果が満足のいくものでない場合は、データセットを改良したり、トレーニング パラメータを調整したり、モデルのパフォーマンスが低い具体的な例をキャプチャしたりする必要があるかもしれません。目標は、精製モデルを段階的に改善して、実稼働環境での使用に十分なパフォーマンスが得られるようにすることです。

リリース時期と価格

Model Distillation は現在すべての開発者に提供されており、GPT-4o や o1-preview を含むすべてのモデルの蒸留に使用できます。開発者が蒸留を始められるように、10 月 31 日まで、GPT-4o mini で 1 日あたり 200 万の無料トレーニング トークン、GPT-4o で 1 日あたり 100 万の無料トレーニング トークンも提供しています。この制限を超えると、蒸留モデルのトレーニングと実行にかかるコストは、API 料金ページで確認できる標準の微調整料金と同じです。

Stored Completionsは無料でご利用いただけます。ベータ版で利用可能な評価は、使用されたトークンに基づいて標準モデル価格で課金されます。開発者は、年末まで、オプトインすると評価を無料で実行できます(週あたり最大7回)。(新しいウィンドウで開きます)OpenAI と評価結果を共有します。共有された評価結果は、将来のモデルの改善と評価に役立てられます。

詳細については、モデル蒸留のドキュメントをご覧ください。

なお、デブ・デーの様子は下記のポストが順を追って写真添付で投稿しています。

OpenAI dev day live tweeting

— Nick Dobos (@NickADobos) October 1, 2024

Let’s see what they cooked! pic.twitter.com/lzBMKuy3ct

なお、下記のポストが紹介する「@O1Visa」は、「Aliens of Extraordinary Ability(特別な才能を持つ外国人)」を紹介するアカウントですが、アメリカのO1ビザとは「Aliens of Extraordinary Ability(特別な才能を持つ外国人)」に与えられるビザの事をいいます。彼は、OpenAIのデブ・デーでOpenAIのモデルo1という名前は、このビザの名前から来ているとサム・アルトマンから聞いて大喜びしている様子が写っています。日本人にもこのようなジーニアスな移民になれるGen-Zが育つといいですね。

Just confirmed: @sama named O1 after the @O1Visa https://t.co/KasKyta3rZ pic.twitter.com/BgMqMZdexy

— Sigil Wen (@0xSigil) October 2, 2024

この記事が気に入ったらサポートをしてみませんか?