個人でバーチャル空間にてイベントやコラボ配信を開催する

こちらでVR研究者のふぁるこさんが「バーチャル空間でイベントを開催するには」というとても重要な記事を出されています。

私はもう少し小さい、いわゆる「コラボ」と言われる規模の配信やイベントをどのように行なっているのか紹介します。

前置き

私が行なっている配信はいわゆる「学術系VTuber配信」と呼ばれるものですが、知識を分かりやすく説明するものではありません。

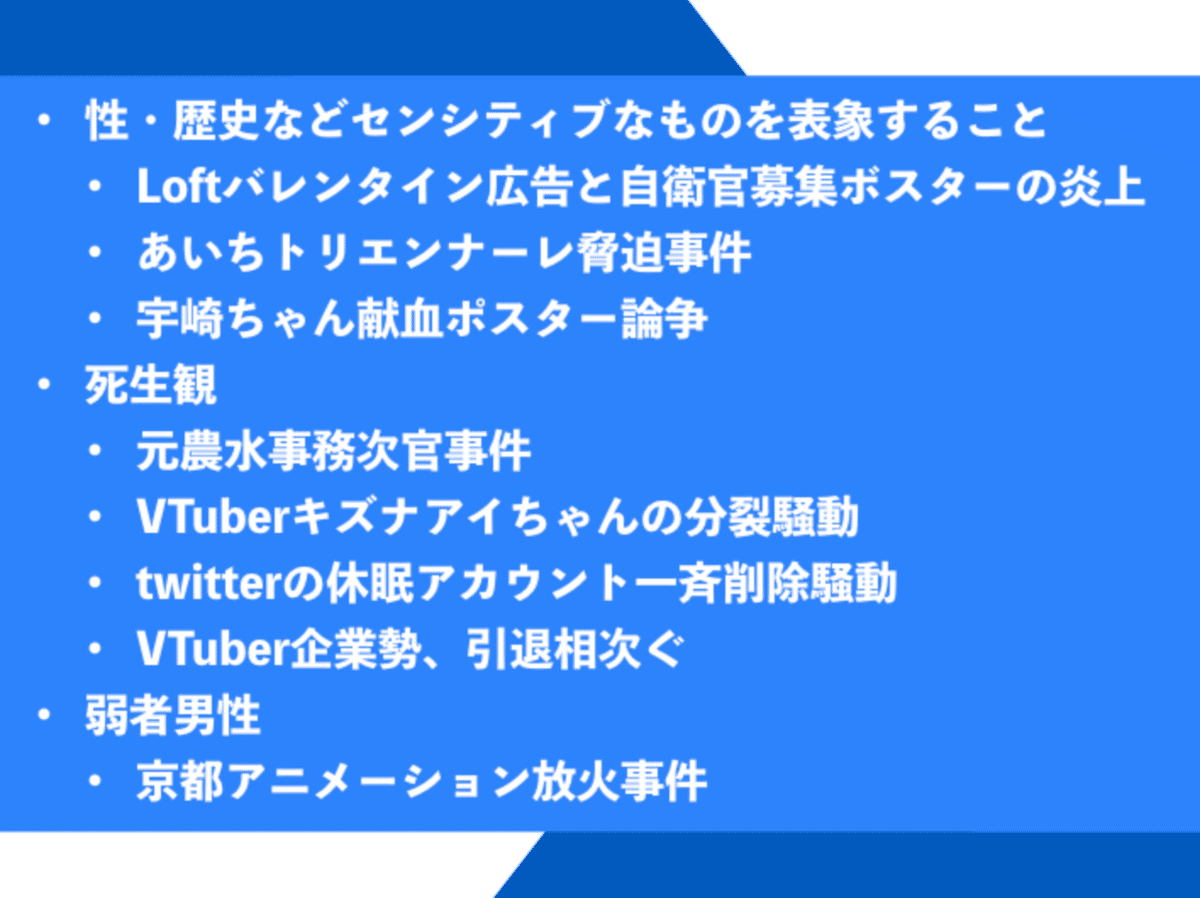

明確な法律や倫理観が存在しない特定のテーマについて、ゲストさん(VTuberに限らない)たちが「こういう考え方があるんじゃないか」「こんな視点があるのではないか」と意見を出し合います。

テーマについて明確な「答え」を出すのではなく、「考えるのは、答えを出すのはあなた自身。配信ではあなたが主役です」。

「視点」「考え方」をあぶり出すことで、視聴者さん含めた皆さんの「考えるためのヒント」になったら嬉しいと考えています。

例えば、現にアバターに関して問題を抱えている方々がいます。その方々が状況を分析して考えるヒントのひとつになったら。問題のない方でも「もし自分がその立場になったらどうするか」を考えるヒントになったらと。

前置きが長くなりましたが、上記の理由から様々な専門家の皆さまをお呼びしています。

1.テーマを決める

1-1.ニュースを読む

私の専門が「身体・テクノロジー・社会の関係性を探る」なので、これに関する(可能な限り)大手新聞社のニュースの中から気になるものをピックアップします。ニュースをTwitterやDiscordのコミュニティで知ることも多いですが、その後大手新聞社のニュースを見に行きます。

ニュースから気になるワードを見つけ、検索。そして出てきたページの中から気になるキーワードを見つけてまた検索…を繰り返すと、ひとつのニュースに対して何が関わっているのかを知ることができます。事実・事象や考え方、視点などですね。

キーワードのセレクションは完全な直感です。とはいえ適当な直感ではなく、今まで読んできた本・教えて頂いた知識・経験などからできています。

この方法は、学部生だった私に1年間ジャーナリズムの基礎を叩き込んで下さった、あるジャーナリストさんに教えて頂いたものです。

例えばこの「AI美空ひばり」のニュース。

「歌声も容姿も本人のコピー」「感動の再会か、故人に対する侮辱か」「人格の再現性」「AIで甦らせることで起きる問題」「AI技術が暴走した場合、誰が責任を持つのか」「復元された存在に依存」…などなど。

AI美空ひばりの場合は「AI技術」「機械学習」もキーワードなので、これ+気になるキーワードで検索する場合もあります。

1-2.関連情報を洗い出し、ゲストさんに聞きたいことを決める

1-1.では、キーワードと関連記事を書き出して、ひとつのニュースに対してどんな考え方や視点があるのかを見つけました。

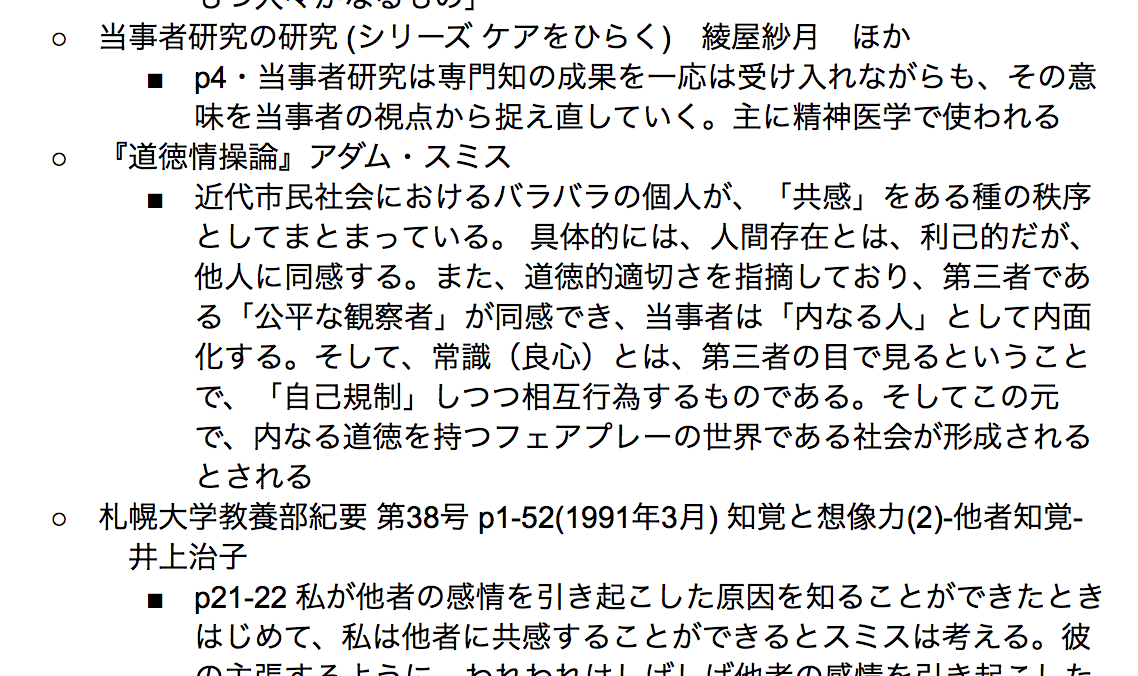

次はその考え方や視点が具体的にどのようなものか、論文や本を読んで探っていきます。このときに同時に学術的な裏付け・根拠も取っていきます。

ウチの配信は「学術系」と名乗っている以上、特に学術知識に関する正確性には注意を払う必要があります。例え説明する量が増えたとしても、簡略化した結果間違って捉えられるのだけは避けたい。

だいたいひとつの配信について、本は10冊以上、論文は30件以上に目を通します。私のある先生は「ひとつのトピックについて100冊以上は参考にすべき」とおっしゃっていますが、私は53冊が限界でした…しかも新規で読み直したのではなく、過去の読書メモを参照してやっとこの数でした。

こちらのために今回借りた本。美少女と表象について主に復習 https://t.co/D5NMgTXSIq pic.twitter.com/wFZoW4gMx3

— よーへん🌒xR人文V研究者 (@361Yohen) October 22, 2019

キーワード・記事・学術情報・Web上の記事をザーッとGoogleドキュメントに箇条書きを使って、関連するもの同士をまとめていきます。その上で自分の見解を書き出します。

またこの時点でそれぞれの専門家である友人たちに一度見せて、意見を頂くこともあります。すべて私ひとりの手で行なっているので、視点の硬直化を防ぐためでもあります。

関連するもの同士をまとめることで全体像が見えてくるので、この時点で配信で何を扱いたいかがだいたい決まってきます。AI美空ひばりのときは「アバターと生命倫理を扱おう。キャラクターやアバターには"いのち"があるのか、あるとするなら/ないとするならその根拠は?アバターの死生観とは?」が出てきました。

(諸事情で配信にできてないのですが)

2.ゲストさんにラブレターを書いて依頼する

扱いたい内容が決まったら、内容に関連する研究を行なっていたり、見解を持っている研究者さんを探します。大学や企業に所属していない、いわゆる在野の研究者さんや大学院生さんも含みます。

お願いする前にその方のTwitter・論文・本を拝見して、どのようなお考えを持っている方なのか理解します。その上でウチが考えている問いと合致しそうな方にラブレターを書きます。

ラブレターは私が個人的にすごいと感じた見解や選択、その方の独自性がいかにウチの配信で参考になるかを真摯に書いたものです。謝礼の金額(いかんせん個人V…)や提案した配信時期のスケジュールが折り合わずにポシャることもありますが、多くの方が真摯に受け止めてお返事を返して下さいます。

3.ゲストさんと内容を相談する

ウチの配信では「視点・考え方出し合い回」「レクチャー回」の2つの種類があります。視点・考え方出し合い回では、テーマに沿って出演者さん(だいたい4,5人)がそれぞれの見解を出し合います。この見解には「明確な答え」はありません。あくまで出演者さん自身と視聴者さんそれぞれが考えるための「サンプル」です。

レクチャー回は研究者さんに90分レクチャーして頂きます。あらかじめ私がまとめた資料をゲストさんにお渡しし、視点・考え方出し合い回で出た内容も参考にして、学術的な根拠もふまえた上でレクチャーして頂いています。

ゲストさんが何に興味関心があるのか・私たちが何に興味関心があるのかをふまえた上で、相談して内容を決めていきます。

4.進行表とカンペをつくる

4-1.司会がしゃべる内容と進行を書き出す

いわゆる「シナリオ」「脚本」です。1.で出たリサーチ結果やゲストさんの考え方・視点を参考に作っていきます。

ガチガチに決めてはいませんが、司会である私や相方にゃんがしゃべる内容は明確にセリフとして書いています。あとはCMや音楽を入れるタイミングなども記載しています。

これは毎回私が配信をワンオペで行なっており、考えながらしゃべるのにものすごく負荷がかかるためです。友人たちからはオーバーワークといつも言われますが、システム上仕方ないですね。

4-2.KeynoteのPNG書き出しでバーチャルキャスト用のカンペを用意

出演者さんにチェックを入れて頂いたら、進行表のデータをMacのKeynoteにコピペして、VRソーシャルサービスの「バーチャルキャスト」で使うカンペを作ります。KeynoteにコピーしたカンペはPNGデータで書き出して、Googleドライブに保存します。

5.スライドをつくる

配信のバックで表示するスライドを作ります。

レクチャー回ではゲストさんから頂いたスライドをPNGファイルにしてGoogleドライブに保存、バーチャルキャストで読み出します。今のところ、最大30枚まで読み込んでいます。

視点・考え方出し合い回では進行表をもとに私がスライドを作成します。

6.会場作り

配信で使用する会場(3Dモデル)を作成します。最近は時間がないので、「The Seed Online」で公開されているものや公式の背景モデルデータを使用させて頂いています。

場合によっては私のアバターの衣装もモデリング・テクスチャ作成を行います。

帰ったら美波レン(@ren_vliver)ちゃんの配信でも使ってもらったこちらのステージをclusterステージ化してみようと思います pic.twitter.com/J5k4yb02UG

— よーへん🌒xR人文V研究者 (@361Yohen) July 5, 2019

7.広報バナーをつくる

日程・ゲストさん・内容も決まった。進行表も準備して後は本番を待つだけ…次に行うのは「告知」です。

私がよく請け負っていたアート系の物理イベントの場合は最低3ヶ月前から、1ヶ月前からは怒涛の広報をしますが、VTuber配信ではだいたい1週間前に最初のツイートをして、当日まで定期的にRTをします。

その際に告知バナーを作成します。これは司会の相方にゃんとの時間が取れるときはVR空間で撮影しますが、多くはUnityでポーズを取って合成します。最後にPhotoshopとIllustratorで仕上げて完成です。

あとは刺さるコピーを考えてツイートするだけ。

8.本番、地獄のワンオペ

参考文献のリサーチ・ゲストさんとのやり取りを経て、本番です。

ウチの配信ではVR環境を持たないゲストさんもご出演頂いているため、下記の方法を取っています。

・VR環境の方

アバター:バーチャルキャスト、音声:Discord、またはSkype

・VR環境ではない方

アバター:ご本人のご希望を聞いた上で私が作ったボクセルアバター、もしくは2Dアイコンパネル。ご本人がしゃべっているときに私が専用の吹き出しアニメーションを再生する

音声:Discord、またはSkype

「バーチャル美少女に姿が変わることで動き方が変わり、視線が変わることで心の持ちようが変わる」

— よーへん🌒xR人文V研究者 (@361Yohen) October 27, 2019

アバターを心理学から考える配信のアーカイブができました! フルはこちらから→https://t.co/9qPL1WeDWT pic.twitter.com/Pi4pQS5xUK

音のレベルを確認するリサーサルを本番1時間前に行います。なのでゲストさんの集合時間はだいたい配信1時間前で、私はリハ2時間前から準備を行います。

主に音声・スライド・カンペ・ゲストさん用アニメーション自作VCI・カメラコントロール自作VCIがきちんと動作するかを確認します。

最近は新しいシステムを使用していないので、リハ1時間前でも十分間に合うようになりましたが、新しいシステムを導入したときは必ず当日にもチェックを行うことを推奨します。生は何が起こるか分からない…

ちなみにワンオペ卓はこのような感じになっています。

上に写っている●はカメラコントロール用の自作VCI、下はVR環境でないゲストさんがしゃべったときに再生させるアニメーションのコントロールVCIです(私が分かればいいのでUIは適当)。

スライドをコントロールするレーザーポインタ・カンペ・コメントを確認する画面は写真撮影用のカメラに写らないので見えていませんが、かなり大変なことになっています(VRでの配信を熟知しているVTuberさんにもビックリされました) 。これは最大6人での大人数コラボ配信がデフォルトなので、仕方ない…

ワンオペ卓はこのようになっております。ひとり6役wでもこれがバーチャルのいいところ。ひとりで責任負える

— よーへん🌒xR人文V研究者 (@361Yohen) September 7, 2019

・ゲストさんVCIアイテム管理

・カメラマルチアングル切り替え

・進行表という名前のカンペ

・コメント確認用デスクトップ

・スライド送り pic.twitter.com/dbIAW03faG

上記のツイートにも書かれていますが、本番で私が行なっている作業は下記になります。これすべてワンオペです。

要するに本来であれば裏方のオペレーターと表の司会業を同時に行なっているわけです。ワンオペコラボ配信の辛いところですね。ゲストさんには集中してできるだけいい状態でお話して頂きたいので、作業はすべて私がやるというスタンスです。

・VR環境でないゲストさんのアニメーション管理(そのゲストさんが話してるのが分かるように)

・カメラアングルの切り替え

・進行表見ながら司会をして、適切なタイミングでゲストさんに話題をふる

・YouTubeコメント確認(これはゲストさんと分担できるのでまだ楽ですが、コメントによってはゲストさんに話をふることもあるので、私もきちんとチェックする)

・スライド送り

・ゲストさんの状況確認(話す方が誰かに偏っていないか)

・音声と映像チェック随時

・OBSでのBGMや動画再生

書き出してみたら地獄ですね。8つの作業を同時に行なっています…

昨年AI系のシンポジウムに生身でゲストとして登壇させて頂いたのですが、配信とは違って言葉がスルスル出てきて、自分がこれほどしゃべれるとは思っていませんでした。

かといって司会は配信のスタンスや流れを決める存在でもあるので、どなたかに完全にお任せするのは難しい。責任も負わせることになってしまう。オペレーションも公式の機能にない部分は自作せざるを得ないので、Unityが使えてLuaスクリプトが分かる人でないと、これもまた難しい。

今試しに使っているVRソーシャル「NeosVR」は音量に合わせてアニメーションを自動再生等もできるようなので、負担軽減のためにNeosVRに移行もありかなと考えています。

9.最後のシメ、配信日は寝られない

無事配信が終了しました。お疲れ様でした!…にはならないのが主催者の辛いところ。

YouTubeは生配信終了後2時間くらいでアーカイブが視聴可能になります。それを確認してからアーカイブデータをチャンネル設定画面から正規の方法でダウンロードして、ダイジェストを作成します。人によっては冒頭1.2分のみを書き出してツイートする方もいますが、私は各ゲストさんのハイライトを抜き出して編集しています。このときにできるだけゲストさんのダイジェスト登場数が平等になるように抜き出します。

さらに簡単な字幕を入れ、全体の音量をチェックして書き出します。

「アバターでも物理現実でも"今ここにいる自分"を大事してあげる。"こうあるべき"という"べき思考"がその人を苦しめているのではないか」

— よーへん🌒xR人文V研究者 (@361Yohen) December 22, 2019

アバターを身体論・表象文化論・心理学から考えるアーカイブができました https://t.co/cq7r07T4CE pic.twitter.com/khaT2ohKj4

配信が終わるのが23時なので、その後ご飯を食べてお風呂に入ると1時くらい。その後朝6時まで編集作業です。

配信時間が長くて2時間で、それに全部目を通して気になる箇所のタイムコードを書き出していき編集作業に入るので、どうしてもそれくらいの時間がかかってしまいます。

Premiereで書き出せたのを確認したら、翌日のお昼ごろに自動的にツイートされるようにTweetDeckで設定して、寝ます。なのでウチの配信は金曜日か土曜日の夜に行うことが多いです。

配信翌日にきちんとダイジェストがツイートされているのを確認したら、アーカイブをもとにnoteの記事を書きます。

これでようやく配信作業が終わります。

まとめ

参考文献のリサーチ・ゲストさんとのやり取り・背景モデル作成・本番・ダイジェストとまとめ。やることはたったこれだけですが、そのプロセスの数はかなり多いです。本番のタスクとモデル作成はともかく、それまでのプロセスは「いかに視聴者さんとゲストさんが一緒に"考えることができるか"」に真摯に向き合うからこそ発生してくるものです。

ウチはコラボ配信だから作業量が多く見えるだけで、他の学術系VTuber・YouTuberさんも、日々膨大な資料と向き合ってどう伝えるか真剣に考えていらっしゃると思います。

伝えるために学ぶことが、実は知識を身につけるいちばん手っ取り早い方法だったりするんですよね。

この記事が気に入ったらサポートをしてみませんか?