改めてCLIP(画像・テキストエンコーダ)を理解する

人工知能(AI)技術の進化は、私たちの生活に大きな変化をもたらしています。その中でも、画像認識は自動運転、医療診断、セキュリティなど、様々な分野で応用が期待される重要な技術です。従来の画像認識AIは、深層学習(Deep Learning)と呼ばれる技術を用いて、大量の画像データとその画像に何が写っているかを人間がラベル付けしたデータ(教師データ)を使って学習することで、画像の内容を認識する能力を獲得してきました。

しかし、この従来のアプローチには、新しいタスクに対応する度に、大量の画像データにラベル付けする作業が必要となるという大きな課題がありました。このラベル付け作業は、多大な時間とコストを要するため、画像認識AIの応用範囲を狭める要因となっていました。加えて、人間がラベル付けしたデータにはどうしてもバイアスが含まれてしまう可能性があり、そのバイアスがAIモデルにも反映されてしまうという問題も孕んでいます。

このような状況の中、OpenAIが開発した「CLIP」(Contrastive Language–Image Pre-training)は、テキストと画像の関係性を学習することで、従来の画像認識AIの課題を克服する革新的な技術として注目を集めています。 CLIPは、まるで私たち人間のように、画像とそれに対応するテキストを関連付けて学習することで、画像の内容を理解する能力を獲得し、ラベル付け作業の削減や新しいタスクへの柔軟な対応を実現します。

本記事では、このCLIPについてさらに詳細に解説し、その革新性、利点、応用例、そして今後の展望について、技術的な詳細も含めて深く掘り下げていきます。各項目では、理解を助けるための図解も用意しました。

CLIP:テキストと画像の橋渡し役

CLIPは、インターネット上に存在する膨大な量の画像とテキストデータを使って事前学習(Pre-training)するAIモデルです。具体的には、画像とその画像に関連するキャプションや説明文などのテキストをペアにして学習することで、画像の内容とテキストの意味を結びつける能力を獲得します。

例えば、犬の画像と「可愛い犬が芝生の上で遊んでいる」というテキストのペアを学習することで、CLIPは犬の画像を見たときに、「可愛い」「犬」「芝生」「遊ぶ」といった単語や概念を思い浮かべることができるようになります。このように、CLIPは画像とテキストを関連付けて学習することで、画像の内容をテキストで表現できる、いわば「多言語話者」のような能力を獲得し、画像とテキストという異なるモダリティ間の橋渡し役を果たします。

CLIPの学習方法:対照学習とVision Transformer

CLIPの学習方法は、「対照学習」(Contrastive Learning)と呼ばれる手法に基づいています。対照学習では、正解データと不正解データを対比させて学習することで、モデルの精度を向上させることができます。CLIPの場合、画像とそれに対応するテキストのペアが正解データ(positive pair)、ランダムに組み合わせた画像とテキストのペアが不正解データ(negative pair)となります。CLIPは、正解データと不正解データを区別できるように学習することで、画像とテキストの関係性を正確に理解していきます。

具体的には、CLIPは画像エンコーダーとテキストエンコーダーという2つのニューラルネットワークを使って学習を行います。

画像エンコーダー: 画像を入力として受け取り、その画像の特徴量を抽出するニューラルネットワークです。CLIPでは、Vision Transformer (ViT)と呼ばれる、近年注目を集めているニューラルネットワークアーキテクチャが採用されています。ViTは、自然言語処理で成功を収めたTransformerを画像認識に応用したもので、画像をパッチに分割し、各パッチをTransformerに入力することで、画像の特徴量を抽出します。ViTは、従来の画像認識モデルである畳み込みニューラルネットワーク (CNN) よりも高い精度を達成することができる場合があり、CLIPの高い性能に貢献しています。

テキストエンコーダー: テキストを入力として受け取り、そのテキストの意味を表すベクトルを生成するニューラルネットワークです。CLIPでは、Transformerベースの言語モデルが使用されます。

CLIPは、画像エンコーダーとテキストエンコーダーが出力するベクトルが、正解データの場合は近くなり(コサイン類似度が高くなり)、不正解データの場合は遠くなるように(コサイン類似度が低くなるように)学習します。これにより、CLIPは画像とテキストの関係性を学習し、画像とテキストの意味的な空間を構築することができます。

学習プロセスでは、ミニバッチ内の各画像に対して、対応するテキストとの類似度を最大化し、他のテキストとの類似度を最小化するように損失関数が設計されます。この損失関数は、対照損失と呼ばれ、CLIPが画像とテキストの関係性を効果的に学習することを可能にします。

ゼロショット転移

CLIPの最も革新的な点は、「ゼロショット転移」(Zero-shot Transfer)と呼ばれる能力にあります。ゼロショット転移とは、新しいタスクを学習することなく、既存の知識を使って新しいタスクをこなす能力のことです。

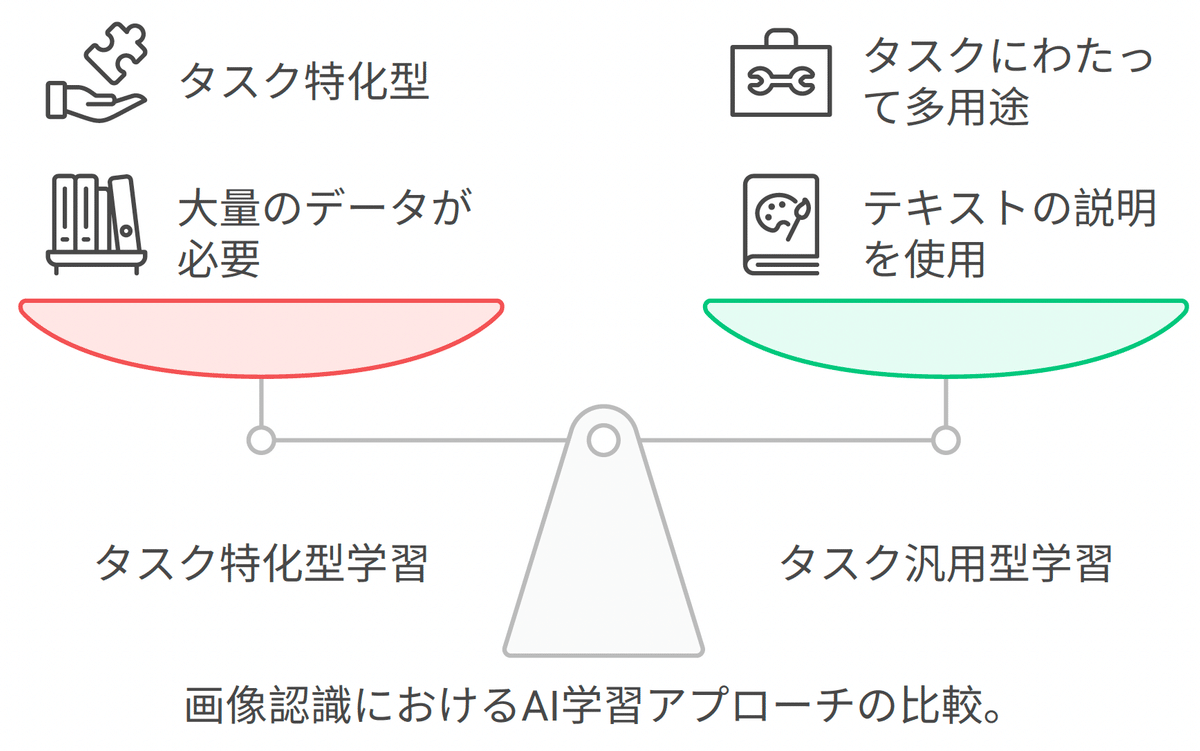

従来の画像認識AIは、例えば「猫」を認識するためには、事前に大量の猫の画像を学習する必要がありました。これは、タスク特化型学習と呼ばれるアプローチで、特定のタスクをこなす能力を特化して学習させる方法です。しかし、CLIPは「猫」というテキストを理解しているので、猫の画像を見たことがなくても、「猫」と認識することができます。これは、CLIPがタスク汎用型学習と呼ばれる、様々なタスクに共通して使える知識を学習するアプローチを採用しているためです。

CLIPは、画像の内容をテキストに変換し、そのテキストを使って新しいタスクをこなすことができます。例えば、CLIPに「猫の画像を選んで」と指示すれば、CLIPは画像の内容をテキストに変換し、「猫」という単語が含まれている画像を選ぶことができます。

ゼロショット転移は、画像認識AIの応用範囲を大きく広げる可能性を秘めています。従来の画像認識AIでは、新しいタスクに対応する度に、大量の画像データを収集し、ラベル付けする必要がありました。しかし、CLIPを使えば、新しいタスクに対応するために必要なのは、そのタスクをテキストで説明することだけです。

ゼロショット転移の仕組み

CLIPのゼロショット転移は、以下のような仕組みで実現されています。

画像の特徴量抽出: CLIPの画像エンコーダーは、入力画像の特徴量を抽出します。ViTは、画像をパッチに分割し、各パッチをTransformerに入力することで、画像全体の特徴量をベクトルとして出力します。

テキストの特徴量抽出: CLIPのテキストエンコーダーは、タスクを説明するテキスト(例:「猫の画像」)の特徴量を抽出します。Transformerベースの言語モデルは、テキストの各単語をベクトルに変換し、それらのベクトルを組み合わせることで、テキスト全体の意味を表すベクトルを出力します。

類似度計算: CLIPは、画像の特徴量とテキストの特徴量の類似度を計算します。具体的には、コサイン類似度が用いられます。コサイン類似度は、2つのベクトルの間の角度のコサイン値を表し、1に近いほど類似度が高く、-1に近いほど類似度が低いことを示します。

予測: CLIPは、類似度が最も高い画像を、タスクの答えとして出力します。例えば、複数の画像の中から「猫の画像」を選ぶタスクでは、CLIPは画像の特徴量と「猫の画像」というテキストの特徴量のコサイン類似度を計算し、最も類似度が高い画像を「猫の画像」として出力します。

このように、CLIPは画像とテキストの特徴量を比較することで、新しいタスクを学習することなく、そのタスクをこなすことができます。

CLIPの利点

CLIPは、従来の画像認識AIと比較して、以下のような多くの利点を持っています。

ラベル付け作業の削減: 大量の画像データにラベル付けする必要がないため、時間とコストを大幅に削減することができます。これは、特にデータ収集とラベル付けが困難な分野、例えば医療画像診断や希少動物の認識などにおいて大きなメリットとなります。

新しいタスクへの柔軟な対応: ゼロショット転移により、新しいタスクを学習することなく、既存の知識を使って新しいタスクをこなすことができます。これは、AIの開発サイクルを短縮し、AIの適用範囲を拡大する上で非常に重要です。例えば、新しい種類の製品を認識する必要がある場合、従来の画像認識AIでは、その製品の画像データを収集し、ラベル付けする必要がありましたが、CLIPを使えば、「新しい製品の画像」というテキストを入力するだけで、その製品を認識することができます。

高い精度: 従来の画像認識AIに匹敵する、あるいはそれ以上の精度を達成することができます。これは、CLIPがインターネット上の膨大なデータを使って学習されているため、様々な種類の画像やテキストに対応できる汎用的な知識を獲得しているためです。

多様なタスクへの適用: 画像分類、物体検出、画像生成など、様々な画像認識タスクに適用することができます。これは、CLIPが画像とテキストの関係性を汎用的に学習しているためです。例えば、CLIPは画像から物体を検出するだけでなく、その物体が何であるかをテキストで説明することもできます。

バイアスの軽減: 従来の画像認識AIでは、人間がラベル付けしたデータにバイアスが含まれている可能性があり、そのバイアスがAIモデルにも反映されてしまうという問題がありました。しかし、CLIPはインターネット上の多様なデータを使って学習されているため、特定のバイアスに偏ることなく、より公平な判断を行うことができます。

CLIPの応用例

CLIPは、その革新的な能力により、様々な分野での応用が期待されています。

画像検索: テキストで画像を検索することができます。例えば、「ビーチで遊んでいる犬」と入力すれば、CLIPはビーチで遊んでいる犬の画像を検索することができます。これは、従来のキーワード検索よりも、より直感的な画像検索を可能にします。また、CLIPは画像の内容を理解しているため、「幸せそうな犬」や「元気な犬」といった、より抽象的な検索にも対応することができます。

画像分類: 画像を自動的に分類することができます。例えば、大量の商品画像をCLIPに与えれば、CLIPはそれらの画像をカテゴリ別に分類することができます。これは、ECサイトなどにおける商品管理の自動化に役立ちます。また、CLIPは画像の内容を理解しているため、「夏の服装」や「フォーマルな服装」といった、より抽象的なカテゴリにも対応することができます。

物体検出: 画像から特定の物体を検出することができます。例えば、監視カメラの映像からCLIPを使って人物を検出することができます。これは、セキュリティシステムの高度化に貢献します。また、CLIPは画像の内容を理解しているため、「不審な行動をしている人物」や「危険な物を持っている人物」といった、より複雑な状況にも対応することができます。

画像生成: テキストから画像を生成することができます。例えば、「夕焼け空を飛ぶドラゴン」と入力すれば、CLIPはそのような画像を生成することができます。これは、エンターテイメントやアートの分野で新たな表現の可能性を生み出すでしょう。また、CLIPは画像の内容を理解しているため、「リアルなドラゴン」や「ファンタジー風のドラゴン」といった、より詳細な指示にも対応することができます。

医療診断: CLIPを使って、レントゲン画像やCT画像から病気を診断することができます。CLIPは、画像中の異常を見つけ出すだけでなく、その異常がどのような病気であるかをテキストで説明することもできます。これは、医師の診断を支援し、医療の質向上に貢献するでしょう。

自動運転: CLIPを使って、周囲の状況を認識し、安全な運転を支援することができます。CLIPは、画像から歩行者や自転車、信号などを検出し、自動運転車が適切な判断を下せるように情報を提供することができます。また、CLIPは画像の内容を理解しているため、「道路工事中」や「渋滞している」といった、より複雑な状況にも対応することができます。

ロボット工学: CLIPは、ロボットが周囲の環境を理解し、適切な行動をとるために利用することができます。例えば、ロボットに「テーブルの上にあるコップを取ってきて」と指示すれば、CLIPは画像からコップを認識し、ロボットがコップをつかむための情報を提供することができます。また、CLIPは画像の内容を理解しているため、「壊れやすいコップ」や「熱いコップ」といった、より詳細な情報にも対応することができます。

CLIPの課題

CLIPは革新的な技術ですが、まだいくつかの課題も残されています。

抽象的な概念の理解: CLIPは具体的な物体を認識することは得意ですが、抽象的な概念を理解することは苦手です。例えば、「幸せ」や「悲しみ」といった感情を表現した画像を正しく認識することは難しい場合があります。これは、抽象的な概念は具体的な物体のように明確な特徴を持っていないためです。この課題を解決するために、CLIPに人間の知識を組み込んだり、より多くの抽象的な概念を含むデータを使って学習させたりする研究が進められています。

バイアス: 学習データに偏りがあると、CLIPもその偏りを反映した結果を出力してしまう可能性があります。例えば、学習データに白人男性の画像が多ければ、CLIPは白人男性を認識しやすくなる可能性があります。これは、AI倫理の観点からも重要な課題です。この課題を解決するために、より多様なデータを学習させたり、バイアスを検出・除去する技術を開発したりする研究が進められています。

説明可能性: CLIPが出力した結果がなぜそうなるのかを説明することは難しい場合があります。これは、CLIPが深層学習と呼ばれる複雑な技術を使っているためです。AIの説明可能性は、AIの信頼性を向上させる上で重要な課題です。この課題を解決するために、CLIPの内部構造を分析したり、CLIPの判断根拠を可視化する技術を開発したりする研究が進められています。

計算コスト: CLIPは、膨大なデータを使って学習されているため、学習や推論に多くの計算資源を必要とします。これは、CLIPの利用を制限する要因となる可能性があります。この課題を解決するために、CLIPのモデルを軽量化したり、推論を高速化する研究が進められています。

細粒度認識: CLIPは、画像を大まかに分類することは得意ですが、似たような画像を細かく区別することは苦手です。例えば、CLIPは犬と猫を区別することはできますが、様々な種類の犬を区別することは難しい場合があります。これは、CLIPが画像の大まかな特徴を学習することに重点を置いているためです。この課題を解決するために、CLIPに細粒度認識のための学習データを追加したり、CLIPのアーキテクチャを改良したりする研究が進められています。

敵対的サンプルへの脆弱性: CLIPは、人間には認識できないようなわずかなノイズを加えることで、誤った認識をしてしまう可能性があります。このようなノイズを加えた画像は、「敵対的サンプル」と呼ばれます。これは、セキュリティの観点からも重要な課題です。この課題を解決するために、敵対的サンプルに対する耐性を持つCLIPを開発する研究が進められています。

まとめ

CLIPは、テキストと画像の関係性を学習することで、従来の画像認識AIの課題を克服する革新的な技術です。ゼロショット転移により、新しいタスクに柔軟に対応することができ、画像検索、画像分類、物体検出、画像生成など、様々な分野での応用が期待されています。

CLIPは、AIが人間の言葉を理解し、世界を認識する能力を大きく前進させる技術と言えるでしょう。CLIPの進化は、私たちの生活をより豊かに、より便利にする可能性を秘めています。今後のCLIPの研究開発によって、これらの課題が克服され、CLIPがさらに進化していくことが期待されます。

専門用語解説

ゼロショット転移: 事前に学習していないタスクを、既存の知識を使ってこなす能力。

対照学習: 正解データと不正解データを対比させて学習する手法。CLIPでは、画像とテキストのペアが正解データ、ランダムに組み合わせた画像とテキストのペアが不正解データとなります。

Vision Transformer: 画像認識にTransformerと呼ばれる自然言語処理でよく使われるモデルを適用したもの。CLIPはVision Transformerを使って画像の特徴量を抽出しています。

線形プローブ: 学習済みモデルの特徴量を使って、新しいタスクを学習する手法。CLIPの汎用性を評価するために使われました。

深層学習: 多層構造のニューラルネットワークを用いた機械学習の手法。

バイアス: データの偏りのこと。

説明可能性: AIが出力した結果がなぜそうなるのかを説明できること。

事前学習: 大規模なデータセットを使って、モデルに汎用的な知識を学習させること。

タスク特化型学習: 特定のタスクをこなす能力を特化して学習させること。

タスク汎用型学習: 様々なタスクに共通して使える知識を学習すること。

画像エンコーダー: 画像を入力として受け取り、その画像の特徴量を抽出するニューラルネットワーク。

テキストエンコーダー: テキストを入力として受け取り、そのテキストの意味を表すベクトルを生成するニューラルネットワーク。

コサイン類似度: 2つのベクトルの間の角度のコサイン値を表す指標。1に近いほど類似度が高く、-1に近いほど類似度が低い。

対照損失: 対照学習で用いられる損失関数。正解データの類似度を最大化し、不正解データの類似度を最小化するように設計される。

細粒度認識: 似たようなものを細かく区別する能力。

敵対的サンプル: 人間には認識できないようなわずかなノイズを加えることで、AIモデルを誤動作させるように設計されたデータ。

参考文献

CLIP: Connecting Text and Images (OpenAI)

Learning Transferable Visual Models From Natural Language Supervision (arXiv)

この記事が気に入ったらサポートをしてみませんか?