分かりやすくプロンプトテクニックを紐解く試み【Least to Most Prompting】

本日もプロンプトテクニックを学んでいきます。

例によって参考にさせていただいたサイトをご紹介。

いつも通り定義から確認していきます。

Least to Most prompting (LtM) takes CoT prompting a step further by first breaking a problem into sub problems then solving each one. It is a technique inspired by real-world educational strategies for children.

「Least to Most prompting」とは、

「1つの問題をAI自身にいくつかの小問題として分割させ、それらに回答させることで精度を向上させる」技術です。

現実世界の子どもの教育方針からインスピレーションを受けたそうなんですが、いまいちピンとこないですね…。

さっそく例を見ていきましょう。

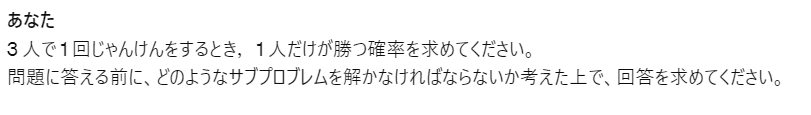

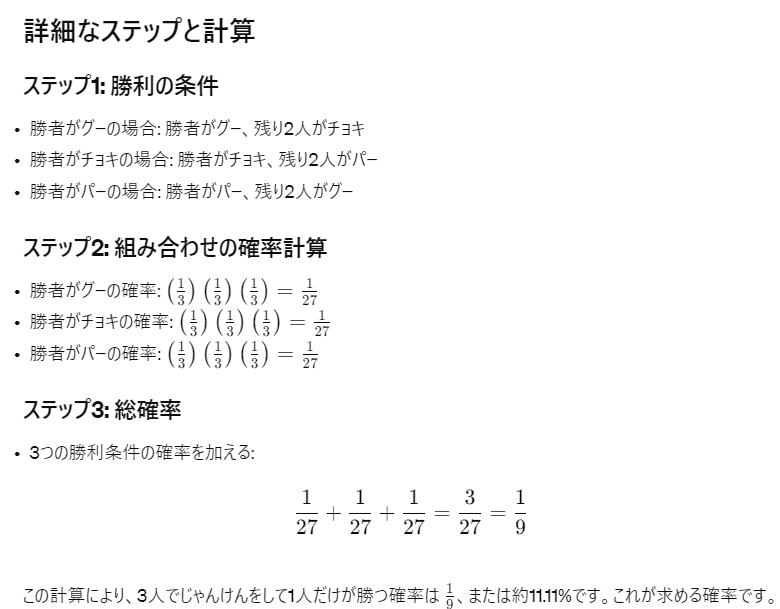

上記は3人でじゃんけんをして、1人が勝つ確率を出してもらうプロンプトです。AI自身に問題を分割して考えさせ、同じルートをもう一度辿らせます。

段階的に考えて回答させるという点では、「Chain of Thought」と似ています。実際、類似していることは原著でも指摘されています。

しかしながら、以下のように記述されております。

Chain of Thought performs significantly better than standard prompting. This is because it now allows the model to consider extracting the last letter of each word on its own, reducing the complexity down to the operation of grouping letters it has previously collected. However, this starts to break down at larger sizes.

特に見ていただきたいのは、最後の一文。

要は「大きな問題には対処できない」ということです。

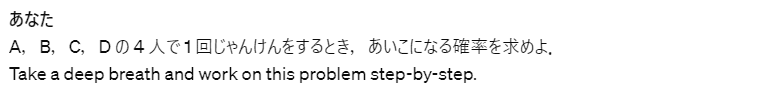

例えば、以下のプロンプトを見てください。

4人でじゃんけんした場合にあいこになる確率を求める場合です。

簡易的にCoTさせることができる例の一文を加えて回答させてみます。

(回答が長いので最後だけ出力させます。)

実際の回答は13/27ですが、間違えてしまっています。

では、今回の「Least to Most」でやってみましょう。

こちらも長いので結果だけ貼ります。

見事正解です。回答の道筋も参考書の回答例のごとく完璧でした。

これは「Let's think step by step」よりも使えるのでは…?

1つ弱点を挙げるとすれば、出力文が長いのでトークン泥棒になっちゃうくらいですね。

この記事が気に入ったらサポートをしてみませんか?