Dify v0.9.1-fix1 ; 新モデルとプロバイダーの追加など

はじめに

Difyの新バージョンが、10月11日に公開されています。v0.9.2ではなく、v0.9.1-fix1とのことです。v0.9.0で強化されているRAG関連のモデルとプロバイダーなどが強化されているようです。

前回は、そのRAG関連としてJina ReaderやSiliconFlow経由でBAA/bgeのエンベディングモデルやリランカーなどを紹介とともに、ナレッジ生成で使ってみました。

今回は、エンベディングモデルを提供しているVoyager AIとNomicなどについて、その概要や特徴をメモしておこうと思います。

背景

生成AI関連の分野は、進歩がとても速く、新しいジャンルのプロバイダーやモデルが次々と登場します。

LLM関連だと今のところは、OpenAI、Google、Anthropic(claude)そしてMeta(Llama)などがやはり強い印象ですが、MS、Amazon、nvidiaなどもその動向が気になります。新しいベンダーも次々とでています。

これらの流れのキーワードの一つがマルチモーダル化でしょうか。これに沿って、DIfyでは、TTSやSTTなどの音声関連や、画像関連のツールが増えてきています。

これらに加え、最近RAG関連のモデルなども色々でてきているようです。

Difyでは、バージョンを経る毎に、それらも含めた新しいプロバイダーとそのモデルが増えてきています。

モデルプロバイダーの数は、v0.9.1-fix1で、51となっています。多いです。

既に把握しきれません。しかし、今後さらに増えるとともに、消えていくのもでてくるでしょう。

視点を変えれば、これらのモデルを、まずはさっくりと試用する環境としても、Difyは便利な存在となっていくような気もします。

v0.9.1-fix1について

githubのリンク先を示します。

以下は、このリンク先の内容の抜粋です。

v0.9.1-fix1 の新機能は? ✨

🛠️ 修正と改善

チャットAPIで会話/セッション履歴が正しく読み込まれない問題を解決しました。

🚀 モデル

Voyageコレクションから不足しているモデルを追加しました

整理しやすいようにGeminiモデルを分類しました

OpenRouterにqwen2.5-72bとモデルllama3.2を導入。

以上の3項目です。

これらのキーワードの背景には、v0.9.0でのモデルとプロバイダーの追加があります。

再掲します。

v0.9.0

🧠 モデル(説明のため番号をつけます)

Voyage AI : 新しいモデルプロバイダーが追加されました

Llama3.2 : FireworksとGroqプロバイダーが利用可能になり、パフォーマンスと多様性が向上しました

InternLM 2.5-20bとQwen 2.5-coder-7bを導入しました

Jamba:私たちの能力を拡張するもう一つの新しいモデル

新しいNomic埋め込みモデルプロバイダーが導入されました

OpenRouterのo1シリーズモデルのサポート

DeepSeek-v2.5 がSiliconFlow のモデルプロバイダーとして追加されました

Geminiのストリームが利用可能になりました

Vertex AI Gemini 1.5 002と実験モデルがサポートされるようになりました

注記: 上記モデル等について

上記で、注目されるのは、1VoyageAIと、5.Nomicです。

いずれも、RAG関連で、embeddingやrerankerのモデルプロバイダーです。

特に、VoyageAIのモデルが、今回のfix1で追加されています。

それ以外についてですが、3のInternLM2.5-20bというのは、internlm/internlm2_5-20b-chatのことだと思います。これは、SiliconFlowで追加されています。

4のJambaというモデルは、AI21 Labsからリリースされていますが、同社はAWSと提携していますので、AWS Bedrock's modelsとして追加されているのではないかと推察されます。

2,6,7,8,9は、各プロバイダーのモデルとしてぞれぞれ追加されています。SiliconFlowについては、前回示しましたので、それ以外について一部を後で示します。

ということで、今回のFix1に関連に関連した各プロバイダーの状況について、以下画像でメモします。

各プロバイダーのモデルについて

各プロバイダーの、v0.9.1-fix1での、モデルの状況をクリップして示します。ともかく、毎回、いつのまにかモデルが増えている印象ですので、このようなメモも意味があるかもしれません。

ちょっと順番が異なりますが、まず、Gemini(google)関連です。

Gemini

現在のモデルレイアウトの順番は、以下のように整理されました。内容は、v0.9.1とかわらないようです。それぞれのLatestと002が最新版です。

Open Router

同社について、私は、今回はじめてセットアップしました。このプロバイダーの扱うモデルの数が、かなり多いのに驚きました。画面を2つに分けて表示します。

1つ目は01-previewをはじめ、有名どころが並んでいます。

2つ目に今回の追加モデルが入っています。

このリストにははいっていませんが、xAI(ツイッター)のxAI: Grok 2 mini やxAI: Grok 2なども扱っているようです。今後、追加されるかもしれません。

このように、異なるプロバイダーが同じモデルを扱っている状況だと、プライスが気になります。

また、最近のにゃんたさんのYoutube動画によると、同じモデルでもプロバイダーで性能が異なるかも、とのことです。未確認ですが。

Groq

特徴という観点では、このGroqが、実行速度の速さという点で有名です。

Llama系を使うのであれば、当面、ここがベストかもしれません。

Nomic

Difyでは今のところエンベッティングモデルが2つ使えるようです。

下記のようなFAQがありました。

FAQ:

Q: Nomic Embedは無料で利用できますか? A: はい、Nomic Embedの利用には無料のアカウントが必要ですが、最大1百万トークンまで無料で利用できます。

Q: Nomic Embedは他の埋め込みモデルよりも優れていますか? A: はい、Nomic Embedはパフォーマンスが優れており、オープンAIのモデルよりも優れた結果を示しています。

Q: Nomic Embedはエンタープライズ環境で利用できますか? A: はい、Nomic Atlas Enterpriseを使用することで、Nomic Embedをエンタープライズ環境で利用することができます。

今後のモデルの追加や展開に期待です。

Voyage AI

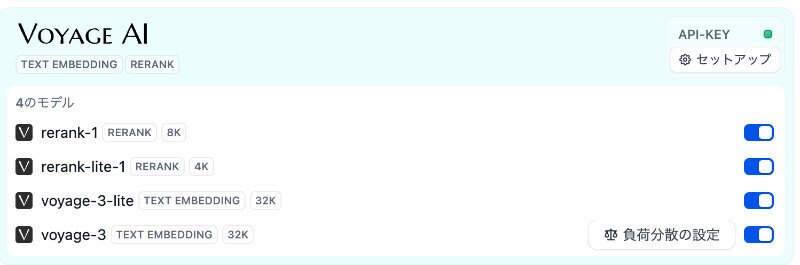

今回の最後は、VoyageAIです。まず、Difyで使えるモデルですが、v0.9.1

では、こうでした。

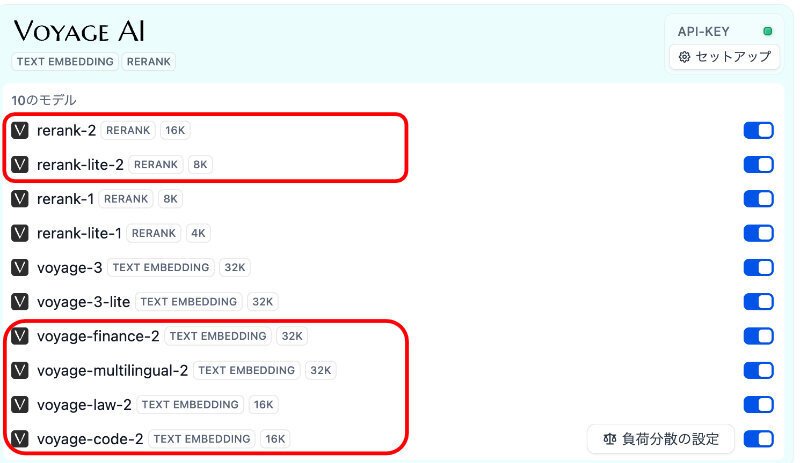

fix1では、次のように増えました。

名称からの推察ですが、リランクモデルの最新版が導入されています。

従って、同社のモデルのみでナレッジが作れます。

また、Finance, Law, Codeといった特定分野に特化しているモデルがあるようです。なお、multilingual-2は、3の旧モデル、(つまり3はマルチリンガルと思われます)、ですが、その性能には、定評があるようです。

あのclaudeのAnthropicが、ここを推奨しています。

**Anthropicで埋め込みを取得する方法**

Anthropic は独自の埋め込みモデルを提供していません。上記のすべての考慮事項を網羅した幅広いオプションと機能を備えた埋め込みプロバイダーの 1 つが[**Voyage AI**](https://www.voyageai.com/?ref=anthropic)です。

Voyage AI は[**最先端の**](https://blog.voyageai.com/2023/10/29/voyage-embeddings/?ref=anthropic)埋め込みモデルを作成し、金融やヘルスケアなどの特定の業界分野向けにカスタマイズされたモデルや、個々の顧客向けにカスタマイズした微調整されたモデルを提供しています。

このガイドの残りの部分は Voyage AI に関するものですが、さまざまな埋め込みベンダーを評価して、特定のユースケースに最適なものを見つけることをお勧めします。

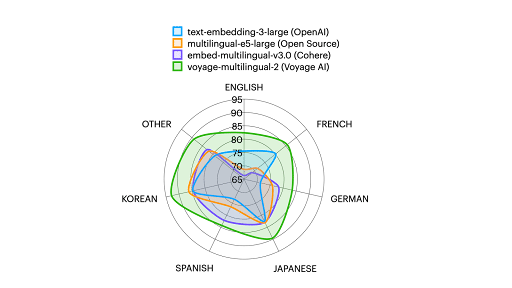

また、Voyage-multilingual-2と他社の有名なエンベッティングモデルとの比較例として次があります。

Voyage AIの多言語埋め込みモデルであるVoyage Multilingual 2は、多言語検索とRAGに最適化されています。フランス語、ドイツ語、スペイン語、韓国語、日本語など27の言語をサポートし、OpenAI(text-embedding-3-large)、多言語E5(infloat/multilingual-e5-large)、Cohere(embed-multilingual-v3.0)を上回っています。これは、検索品質を評価するために最も広く使用されている指標であるNDC@10に基づく検索精度で、2番目に優れたモデルを5.6%上回っています。検索と機械学習では、わずかな利益でも大きな進歩があります。企業が生成AIユースケースの実稼働化に向けて動く中、この精度向上は幻覚症状のさらなる低減につながるでしょう。

同じ引用先に、上記引用内容を示す次のグラフが提示されています。

最新モデルのVoyage-3は、かなり期待できそうです。

ただし、使用にあたっては、無料枠が設定されていますが、支払い方法を入力しないと性能が落ちるように設定されているとのことです。

請求ページにまだお支払い方法を追加していないため、レート制限は 3 RPM と 10K TPM に引き下げられます。請求ページにお支払い方法を追加して、標準のレート制限を解除してください。詳細については、レート制限に関するドキュメントをご覧ください。Voyage シリーズ 3 モデルの場合、最初の 2 億トークンは引き続き無料です。無料トークンの数については、ドキュメントをご覧ください。

今回は、以上です。

まとめ

Dify の最新版であるv0.9.1-fix1の新しいモデルとプロバイダーについてモデルのリストと特記事項等をメモしました。

なお、このラインとは別に、v.0.10.0-beta2というのがリリースされています。

v.0.9.xでは、特にRAG関連の機能が強化されているようです。

それに伴い、RAGに関連するモデルやそれを供給するプロバイダーも新規に複数提供されています。

現時点では、特に、VoyageAIとBAA/bgeのモデルが注目されます。

両社の製品は、これまで標準だった、OpenAIやCohereのモデルよりもより高性能と評価されているようです。

また、Difyで使えるモデルの数は少ないですが、Nomicなども今後期待できそうです。

従来のLLMに加え、これらembedding や rerank用のモデル、またcoderなどの機能の特化したモデルもでてきています。

それに加え、Difyでは、マルチモーダルツール対応として、TTSやSTT、画像関連も増えています。

特にこの分野では、新しいプロバイダーが従来のモデルを凌駕するモデルをだしてくるのが目立ちます。注意が必要です。

既に、オリジナルのモデルを持ついわば1次のプロバイダーと、複数の他社モデルを扱う2次のプロバイダーが存在します。

2次のプロバイダーについては、プライス(ユーザーにとってはコスト)と性能(信頼度、速度等)の視点からの比較が、今後必要と思われます。