nijijourneyで元画像を生成してStable Diffusionで仕上げる画像生成AI横断的な工程

これまで私は1つの画像生成AIを使って極力テキストのみ(t2i)で仕上げることがほとんどで、ある意味そこにこだわっている部分もありました。が、さすがに生成を始めて2年近く経過したこともあって、最近は生成するイメージに応じて複数の生成AIを横断してレタッチしながら1枚の画像を作ることも取り入れています。

— 宇城 一|UKI Hajime (@uki_hajime) August 12, 2024

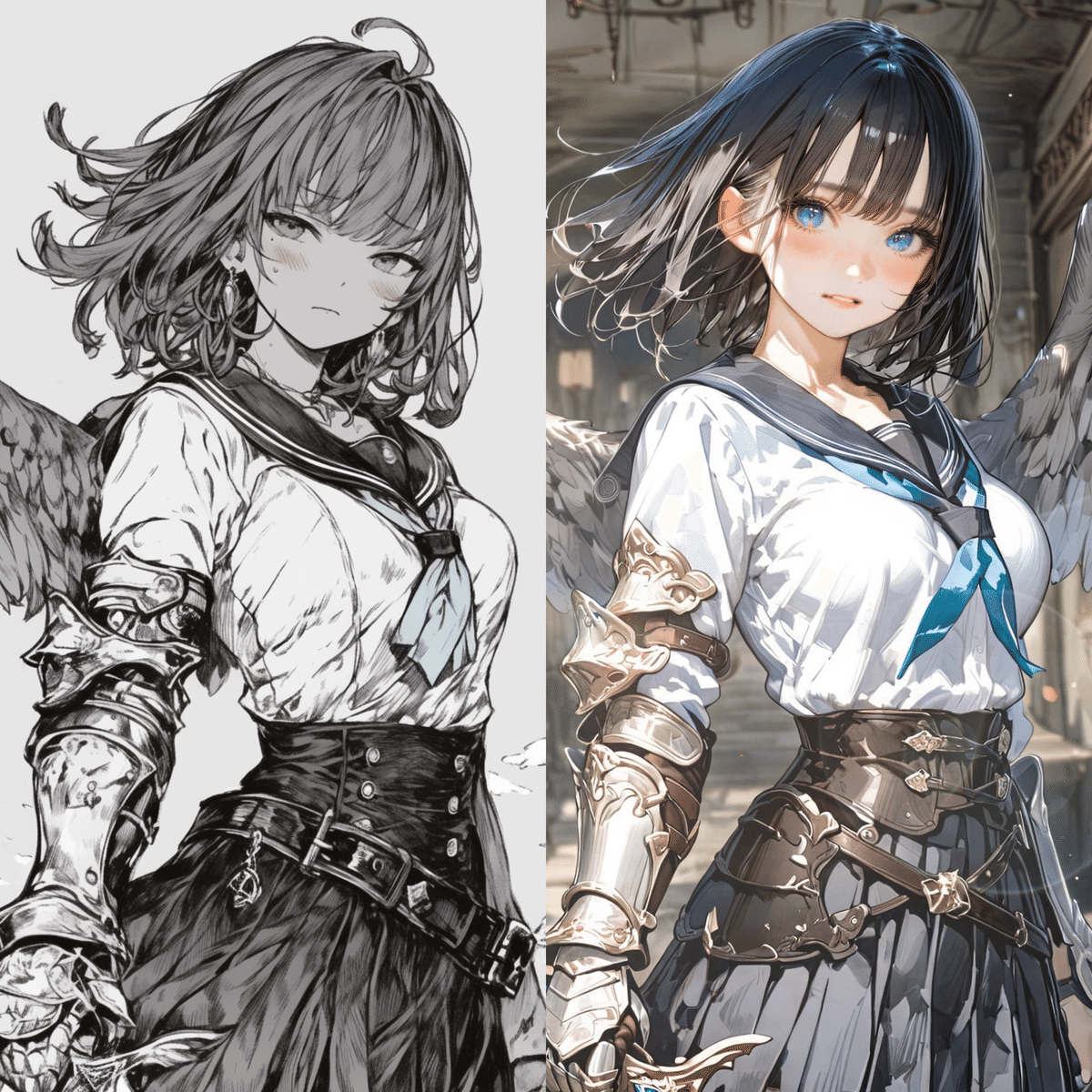

今回は上の「初陣」という画像を作るまでのざっくり工程紹介です。

niji・journeyでベースの画を作成

まずnijijourneyを使って、元となる(下絵のような位置づけの)画像を生成します。今回のタイトルは「初陣」なので、ファンタジー風の鎧に真っ白なセーラー服を加えることで初々しさを出してみようと思い、

セーラー服

剣と鎧

翼

あたりをモチーフに持ってきました。

何回かプロンプトを調整して、イメージに合いそうなものとして出てきたのが上の画像になります。

片翼の画像を両翼に修正

もっとも、この画像は羽が片翼になっているので、向かって左の翼の一部をコピーして右にペーストして両翼に修正しました。(片翼が混ざってくるのはAIで有翼人種を生成する場合のあるあるかもしれませんね)

あとでi2iで調整するので、ペーストする際は「だいたいこんな感じ」程度の大雑把さで問題ありません。

※この作業、私はProcreateを使いました

Stable Diffusion XLで成形と着色

nijijourneyで生成した画像をStable Diffusion XLに読み込んで、i2iで成形と着色を行います。

今回は元画像にほとんど直したい箇所がなかったので、見た内容でプロンプトを入れてのかなり素直なi2iになっています。

NovelAIのディレクターツールで背景削除

nijijourneyで生成した元の画に描かれていた背景は、今回は使わないので削除します。背景削除はいろいろなツールで可能ですが、生成AIを横断的に使って画像を作る過程なので、今回は切り抜きもNovelAI Diffusionのディレクターツールにお願いしました。(スマホのデフォルトの機能でも簡単に背景を削除できる時代かもですね)

背景画像をDALL·E 3で生成

背景もあらためてnijijourneyで生成するつもりでしたが、こちらも画像生成AIをできるだけ横断して使うためにDALLE3で生成してみました。

背景画像と重ね合わせてi2iで馴染ませる

生成した背景画像は人物と比較して少しボケて見えるように(被写界深度が浅くなるように)、Photoshopでぼかし(ガウス)を数パーセント入れます。

ぼかしを入れた背景画像と人物の女の子を重ね合わせて1枚の画像にして(この工程も、先述のProcreateで行いました)、再度Stable Diffusion XLに画像を取り込んでi2iで両者を馴染ませます。

画像の方向を調整

ここまで「初陣」というタイトルの下「魔物の住むダンジョンに初めて挑む剣士」といったイメージで生成していたのですが、むしろダンジョンそのものよりも自分の部屋とかギルドのような場所で、これから始めてダンジョンに挑む雰囲気のほうが「初陣」っぽいかな?

と、ここで考え直してwindowやsunlightなどのプロンプトを加えて背景がダンジョンではなく石造りの部屋っぽくなるように変更しました。(途中で方向転換するのは大抵出来が悪くなるので、極力やらないに越したことはありませんが)

1つ前の画像と比較すると、顔や首に当たっているのが横からの明るい光に変わっていることがわかるかと思います。

Fireflyで生成した光の画像を重ね合わせ

次はPhotoshopのFireflyを使って陽の光が横から差し込む画像を生成して、レイヤーを「スクリーン」で重ね合わせて部屋の明るさを足します。

前の工程では背景と人物があまり大きく変わらないように浅めのi2iで馴染ませているので、背景と人物の両方に影響する環境光の画像を重ね合わせることで、全体をより馴染ませる(不自然さを下げる)効果も狙っています。

また最終調整として頭の形を少し整え、表情も険しすぎると熟練冒険者のような雰囲気も出てしまうかなと思ったので少し柔らかな表情をプロンプトで足して、初陣への期待と緊張感が多少出るようにStable Diffusionのinpaintで修正しました。

元の画像との比較

以上で画像生成AIを横断しながら、イメージしていたものに近い画像を生成することができました。

nijijourneyで生成した直後はかなりシンプルでしたが、だいぶ雰囲気のあるそれっぽい画像に仕上がったのではないでしょうか。

この記事が気に入ったらサポートをしてみませんか?