comfyUI使ってAnimagineXLv3で遊んだお話(あと自分のSDXLworkflow配布)

myPCは💩みたいなスペックなのでSDXL自体避けていたのですが、TL見るとAnimagineXLv3ばっか上がってくるのでちょっと触りたくなった次第。

でもAUTOMATIC1111じゃ動かすの厳しいしな🤔ってことでcomfyUIだったら軽いし10VRAM民でも動くよ!って教えてもらったので、存在は知っていたけど避けていたcomfyUIもついでにやってみることにしました。

comfyUIの導入

導入方法

以下URL入って『Direct link to download』をクリックしてDL。

解凍して『run_nvidia_gpu.bat』を起動したら普通に動いたのでこれといって難しいことは一つもなかったです。

AUTOMATIC1111をローカルPCで動かしている人なら多分大丈夫なはず。

PythonのVerとか気をつけてれば多分いいんじゃないかな?と思うけど、聞かれても答えれないよ🥺

ざっくりとした使い方

comfyUIはPCとかTVの配線みたいに繋げて使うと思えばよいです。

各パーツ(nodeと言います)を配置して、線でつなげていく感じのイメージで良いです。

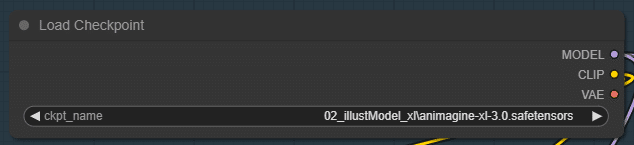

上記みたいなnodeを複数繋げていくだけで使えるのですが、これが理解しにくいと言われる所以かな?🤔と思います。

nodeの右側(上記画像だとmodel/clip/vae)が別のnodeに渡して上げる『出力』側と認識してればよいです。

上記nodeにはないけど左側にも◯があるnodeがあり、その場合は別のnodeから受け取る『入力』側と思ってもらうのが一番理解しやすいです。

さて、最低限必要なnodeってなんだろうと言われると以下になります。

Load Checkpoint ( Add Node > loaders > Load Checkpoint )

Load VAE ( Add Node > loaders > Load VAE )

Clip Text Encode * 2 ( Add Node > conditioning> Clip Text Encode )

EmptyImage or Empty Latent Image ( Add Node > image > EmptyImage ) or ( Add Node > latent > Empty Latent Image )

KSampler ( Add Node > sampling > KSampler )

VAE Decode ( Add Node > latent > VAE Decode )

Save Image ( Add Node > image > Save Image )

上記のnodeを繋げてやれば、とりあえず生成自体はできます。

ここからUpscaleするためのnode郡を用意して……ってやればいいんですが、Upscale方法は多種多様だったりします。

AUTOMATIC1111の場合だと『hires.fix』にチェック入れて設定ちょっといじるかt2iしたものをi2iにもっていってtileやったり、controlnetを通して……って感じだと思います。

もちろんcomfyUIでも出来るのですが、それをするためのnodeを用意する必要があるのが難点です。

でも、AUTOMATIC1111では段階に分けてやる必要作業がワンポチでできるのがcomfyUIの利点だと思います。

まずは生成→Upscaleを1回通す→出力→2回目のUpscaleではsamplerやUpscalerを変える(R-ESGAN→swinIR)→出力

みたいなフローもワンポチでできます。

もちろん細かい設定も1回目と2回目、それ以降も設定すれば変えれるので難しいけど理解すればより柔軟な生成環境を自分で構築することができるんですよね。

それで実際にt2i+Upscaleのnodeを組んでみたのが以下になります。

Load Modelというグループが、モデルデータやVAE、アップスケール時に使用するUpscalerをまとめたもの。

PromptはわかりやすくClip*2のみ。

Settingが画像サイズやseed、CFGやsamplerなどの設定をする所。

Upscaleが拡張機能使ってますが、アップスケール設定の箇所ですね。

最後にSend Webp Image to Eagleという拡張機能でwebp保存+Eagleに登録という感じのworkflowです。

上記では『ComfyUI-send-Eagle(slim)』と『UltimateSDUpscale』という拡張機能をつかってます。

最低限

ComfyUI Manager

pythongosssss/ComfyUI-Custom-Scripts

入れたあと、好きなプラグイン入れていけばいいとおもいます。

入れた拡張ブラグイン

以下は自分が入れたプラグインの一覧です。

でも1割も使ってないです🥺っていうか使い方自体分かってないんだよね。

ComfyUI Manager

ComfyUI Impact Pack

ComfyUI Inspire Pack

ComfyUI's ControlNet Auxiliary Preprocessors

ComfyUI Frame Interpolation

Advanced CLIP Text Encode

Tiled sampling for ComfyUI

Efficiency Nodes for ComfyUI Version 2.0+

WAS Node Suite

simple wildcard for ComfyUI

ComfyUI-Saveaswebp

pythongosssss/ComfyUI-Custom-Scripts

UltimateSDUpscale

SDXL Prompt Styler

SDXL Prompt Styler (customized version by wolfden)

DynamicPrompts Custom Nodes

JPS Custom Nodes for ComfyUI

ComfyUI-send-Eagle(slim)

ControlNet-LLLite-ComfyUI

ComfyUI Neural network latent upscale custom node

select_folder_path_easy

まずは『ComfyUI Manager』から導入すると良いです。

これを入れることで、Managerメニュー → Install Custom Nodes からプラグインを入れることができます。

あとオートコンプリートも導入されるので楽です。

モデルデータとVAEのダウンロード

civitaiかHuggingfaceでダウンロードすれば良いと思います。

以下は自分が使ったモデルとVAEです。

AnimagineXLv3で遊んでみた例

初めてのSDXLとcomfyUIはワクワクしたよね🤗PCスペックがちょっと低い(AI生成界隈では)人も使えるので、よかったらみんなもチャレンジしてみてね!

オマケ

おまけは自分のSDXL環境(workflow)の配布。

comfyUIはworkflowをsvg画像として保存して、ドラッグ&ドロップするだけで読み込んだりできるんだよね🤗

ってことで需要ほぼないと思うけど、自分のSDXL環境配布しますね。

よろしければサポートしていただけないでしょうか。 サポートいただきましたら、より私が活発に動き、いただいた支援はAI生成の活動費になります🥰