2010年代に登場したニューラルネットワークを活用した自然言語モデルTransformerについて

こんにちは!こーたろー@データ分析の診療所 院長です。

今回は、2010年代から活用されているTransfomerモデルについて考えて行きます!

前の記事で、大規模言語モデル(LLM)の歴史についても書いていますので、そちらもご覧ください。

Twitter: https://twitter.com/DsfKotaro

1. はじめに

近年、人工知能(AI)の発展により、自然言語処理(NLP)の分野でも大きな進歩が見られます。その中でも、ニューラルネットワークを活用したモデルが注目を集めています。本記事では、2010年代に登場したニューラルネットワークを活用した自然言語モデル「Transformer」について詳しく解説します。

2. ニューラルネットワークの概要

2.1 人工ニューラルネットワーク

人工ニューラルネットワークは、人間の脳の神経細胞(ニューロン)を模倣した概念です。ニューロンは、複数の入力信号を受け取り、一定の閾値を超えると出力信号を発生させます。この動作を基に、人工ニューラルネットワークでは、入力データに対して重みを掛け合わせ、バイアスを加えた結果が活性化関数により変換され、出力となります。

2.2 ニューラルネットワークの種類

深層学習は、ニューラルネットワークが多層になったもので、隠れ層が多いほど「深い」と言います。深層学習は、複雑な問題を解く能力があり、画像認識や自然言語処理など、多くの分野で利用されています。

3. Transformerの概要

3.1 Transformerの構造

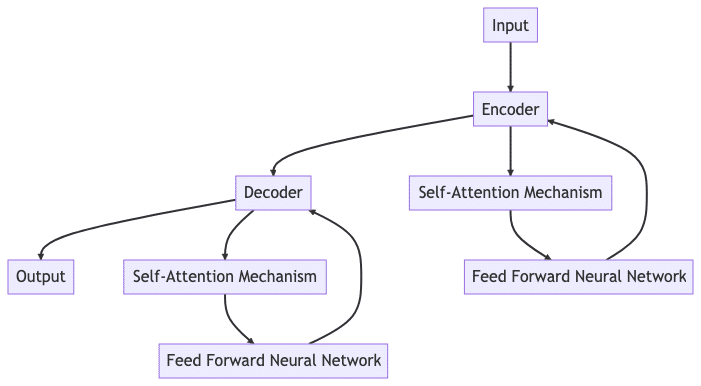

Transformerのエンコーダは、入力データを内部表現に変換します。エンコーダは、自己注意機構とフィードフォワードニューラルネットワークから構成され、これらの層を複数スタックした構造を持ちます。

デコーダは、エンコーダからの出力と自己の過去の出力を用いて、次の出力を生成します。デコーダもエンコーダと同様に、自己注意機構とフィードフォワードニューラルネットワークから構成されています。

Transformerの構造を示す図は以下の通りです。

3.2 自己注意機構(Self-Attention Layer)

自己注意機構は、入力データの各部分が他の部分とどの程度関連しているかを計算します。これにより、Transformerは文脈に基づいた理解を可能にします。自己注意機構は、エンコーダとデコーダの両方に存在します。

3.3 フィードフォワードニューラルネットワーク

フィードフォワードニューラルネットワークは、一連の全結合層から構成され、非線形性をモデルに導入します。これにより、Transformerは複雑なパターンを学習することができます。フィードフォワードニューラルネットワークも、エンコーダとデコーダの両方に存在します。

3.4 エンコーダとデコーダのスタック

Transformerのエンコーダとデコーダは、それぞれ複数の同一の層をスタックした構造を持ちます。これにより、Transformerは深層学習を行い、より複雑な特徴を抽出することができます。

4. Transformerの応用

4.1 自然言語処理

自然言語処理(NLP)は、Transformerの最も一般的な応用分野の一つです。Transformerは、機械翻訳、文章生成、文章要約、感情分析など、多くのNLPタスクで使用されています。

4.2 音声認識

Transformerは、音声認識の分野でも利用されています。音声データをテキストデータに変換するこのタスクは、Transformerの能力を最大限に活用しています。

4.3 画像認識

最近では、Transformerは画像認識のタスクにも適用されています。画像の各ピクセルをトークンとして扱い、画像全体のコンテキストを理解することが可能です。

4.4 時系列データ分析

時系列データ分析では、Transformerは各時点のデータが他の時点のデータとどのように関連しているかを理解するのに役立ちます。これは、株価予測や天候予測などのタスクで有用です。

4.5 バイオインフォマティクス

バイオインフォマティクスでは、Transformerは遺伝子配列やタンパク質配列の解析に使用されます。これらの配列は、自然言語の文と同じように、特定のパターンや構造を持っています。

5. まとめ

本記事では、ニューラルネットワークとその一種であるTransformerについて解説しました。Transformerは自然言語処理の分野で広く利用され、その性能は多くのタスクで評価されています。今後もTransformerの研究と応用は進んでいくことでしょう。

よくある質問

Q1. Transformerはどのようなタスクに使用できますか?

A1. Transformerは、自然言語処理、音声認識、画像認識、時系列データ分析、バイオインフォマティクスなど、多岐にわたるタスクに使用できます。

Q2. Transformerの主な特徴は何ですか?

A2. Transformerの主な特徴は、自己注意機構とフィードフォワードニューラルネットワークを用いたエンコーダとデコーダの構造です。これにより、Transformerは文脈に基づいた理解を可能にします。

Q3. 自己注意機構とは何ですか?

A3. 自己注意機構は、入力データの各部分が他の部分とどの程度関連しているかを計算します。これにより、Transformerは文脈に基づいた理解を可能にします。

Q4. フィードフォワードニューラルネットワークとは何ですか?

A4. フィードフォワードニューラルネットワークは、一連の全結合層から構成され、非線形性をモデルに導入します。これにより、Transformerは複雑なパターンを学習することができます。

Q5. Transformerはどのようにして深層学習を行いますか?

A5. Transformerのエンコーダとデコーダは、それぞれ複数の同一の層をスタックした構造を持ちます。これにより、Transformerは深層学習を行い、より複雑な特徴を抽出することができます。

参考文献

この記事が気に入ったらサポートをしてみませんか?