実際に動画を生成してみた

動画生成の実力はいかがなものなのか。やはり実際に手を動かしてみないと実感できませんので、トライしてみました。生成の手順はこちらを参考に。

忠実にやってみる

実は1週間ほど前からトライしようとしていましたが、早速つまずいていました。理由は「コンテからつくってみよう」と考えたからです。「せっかくならクスッと笑えたり面白い映像をつくりたい」とハードルを上げてしまい、そこで挫折していました。笑

なので今回はmikimiki 先生のプロンプトと同じものでトライ。

まずはMidjourneyで画像生成

どんな人物がどんなことをしていたらいいか?などと考えだすと、また挫折しそうだったので、完全に同じプロンプトに。

/imagine T-pose of teenager of female from 2050, symmetrical, full body, spread arms, front view, historic action movie character, futuristic

だいたい同じようなものができました。

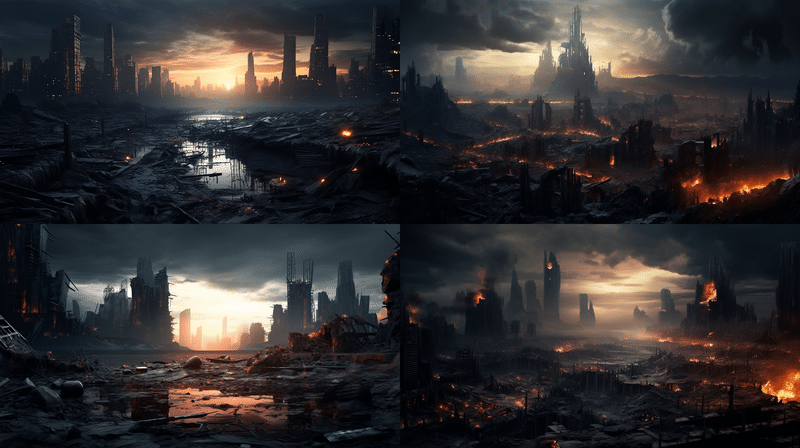

アップの女性を生成したら、続いて背景を生成。人物と背景を一緒に生成しようとすると、修正の際に相互に影響が出てしまうので、別々に生成した方が良いとのこと。

人物と背景を、これもまたMidjourneyを使って合成。Photoshopでマスクを切って合成することは今後なくなっていくのですね・・

Gen-2で動画化

この画像をそのままGen-2で動画化します。「動画化」って言葉がまだ不思議な感じもしますが、そのうち当たり前のように使うことになるんでしょうね。Gen-2では、最初は4秒しか生成されないので、8秒にまで延長しました。

Eleven Labsでセリフを生成

Eleven Labsでセリフをつくります。ここはめんどくさかったので自分で適当につくりました。笑 DeepLで翻訳して入力。あっという間に生成してくれます。

Wav2Lipでリップを合成

こちらはちょっと戸惑いました。まずUIが今までと違って親切じゃない。笑

何が起きてるのか分からず、2、3回は繰り返しました。その上、mikimiki 先生のYoutubeから3ヶ月経ち、仕様が変更に。動画を一旦Youtubeに上げ、そのリンクからWav2Lipへアップロードする方法で仕上げました。

ひとまず完成

基本的には mikimiki 先生の作られたものと同じようなものができたと思います。

色々と試行錯誤した結果、難易度としては

Midjourney ★★★

Gen-2 ★

Eleven Labs ★

Wav2Lip ★★★★

といったところでしょうか。私はMidjourneyをある程度使っていましたので、比較的スムーズでしたが、Midjourneyを触ったことがない方はもう少しハードルが高いかもしれません。

実際に手を動かしてみて

UIの変化のスピード

一番実感したのが「UIの変化」でした。3ヶ月で各生成サイトのUIやサービスがどんどん変わっていくので、過去のマニュアル動画を見ながらやっても、思い通りに進められませんでした。「自分でもやってみたい」と思う方はなるべく早く始めるか、なるべく新しい情報を元にトライすることをお勧めします。

クオリティの進化

CreativeEdgeさんのnoteやRunway TVなんかを見ると、度肝を抜かれると思います。クオリティはすでに私がつくったものの遥か先をいっています。AIを駆使する人と使えない人とでは、その差が幾何級数的に開いていくのではないかと感じました。

やっぱり企画が大事

今回はひとまず最後までやることを目標にAIで動画を作りましたが、きちんとアイデアや企画がないと当然 ”ただのリアルな映像” になってしまいます。

ずいぶん前の話ですが、Twitterが登場した時「Twitterとコラボする」という企画を出してきた方がいました。これは企画というより手法であって、AIも同じで「AIを使うからこそできる」アイデアや企画があってこそ、それが活きてきますよね。

まぁそれもAIに頼めば出してる未来がすぐにやってくるでしょうが・・

この記事が気に入ったらサポートをしてみませんか?