脱「プロンプト芸」 長いプロンプトは不要ではないのか?

長いプロンプトは不要ではないのか?

近年、大規模言語モデル(LLM)の進歩に伴い、より長い入力コンテキストを処理する能力が向上してきました。

長いプロンプトはSNSやフォーラムなどで「プロンプト芸」として披露されることが多いですが、ChatGPT、Claude3、Geminiの公式サイトが提示しているプロンプト例文はいずれも短文である事に気がつくでしょう。

これは、長いプロンプトが必ずしも必要ではないことを示唆しているのではないでしょうか?

事実、長いプロンプトは必ずしも有益ではなく、場合によっては性能を低下させることもあります。ここでは、長いプロンプトが不要であるかどうかについて、最新の研究結果を基に考察します。

参考論文

長いプロンプトの影響

パフォーマンスの低下

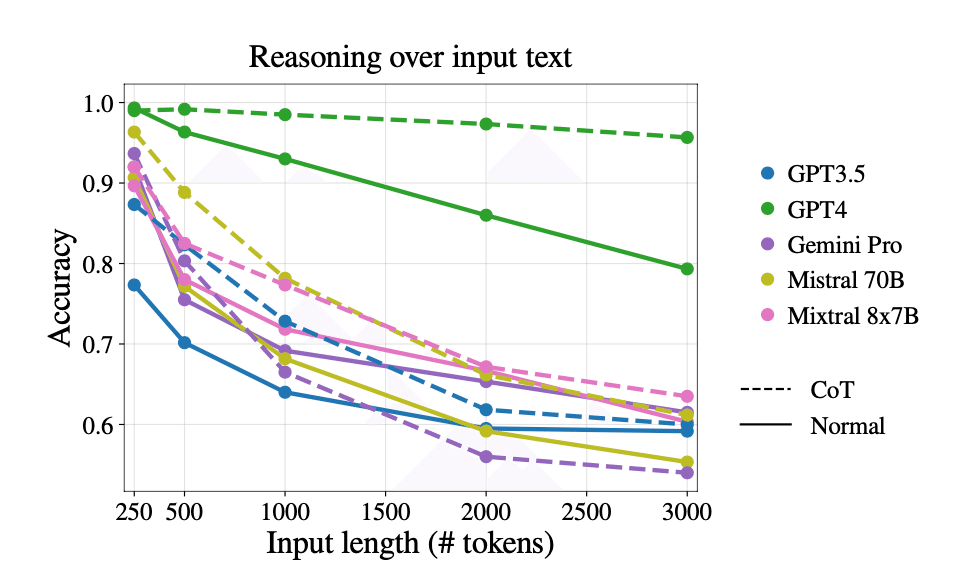

研究によれば、入力の長さが増すにつれて、LLMの推論能力が著しく低下することが確認されています。

具体的には、入力が3000トークンを超えると、モデルの推論精度が92%から68%にまで低下することが示されています。この結果は、長いプロンプトが必ずしもモデルの性能向上につながらないことを示唆しています。

関連情報の配置とパフォーマンス

さらに、入力コンテキスト内の関連情報の位置もモデルの性能に影響を与えることが確認されています。

具体的には、関連情報がコンテキストの始めまたは終わりにある場合、モデルの性能は高く、中間に配置されると性能が低下する「U字型」のパフォーマンス曲線が観察されています。この傾向は、長い入力が必ずしも効果的に利用されていないことを示しています。

チェイン・オブ・ソート(CoT)プロンプトの効果

CoTプロンプトの効果の変化

CoTプロンプト技術は、短い入力においては性能を向上させることが示されていますが、長い入力に対しては効果が限定的であることが明らかになっています。多くのモデルで、入力が長くなるとCoTプロンプトの効果が減少し、推論精度が低下することが報告されています。

チェイン・オブ・ソート(CoT)プロンプトとは?

チェイン・オブ・ソート(Chain of Thought, CoT)プロンプトとは、モデルに対して「これを順を追って考えましょう」というような指示を与え、各ステップでの考え方を詳細に説明させることで、最終的な答えを導くプロセスです。これにより、モデルはより論理的かつ体系的に問題を解決することが期待されます。

実務における影響

また、実体験としてChatGPT GPTsのネット検索機能をオンにすると、プロンプトに従いにくくなることを感じている人もいます。これは、ネット検索用のシステムプロンプトが長く、モデルが指示に従いにくくなるためです。

これらの結果から、長いプロンプトが常に最適なアプローチであるとは限らないことが示唆されます。以下の点を考慮することが重要です:

良いプロンプトとは

タスクの複雑性と入力の関連性:

タスクの複雑性に応じて、必要な情報をコンパクトにまとめることが求められます。無駄な情報を排除し、関連情報に集中することが効果的です。

プロンプト設計の工夫:

長い入力を効果的に扱うためには、関連情報の配置やプロンプトの構造を工夫することが必要です。例えば、重要な情報をプロンプトの初めや終わりに配置することで、モデルのパフォーマンスを向上させることができます。

モデルの特性を理解する:

各モデルの特性やバイアスを理解し、それに応じたプロンプト設計を行うことが重要です。モデルの学習データやアーキテクチャに基づいて、最適な入力形式を選択することが求められます。

結論

長いプロンプトは必ずしも効果的ではなく、場合によってはモデルの性能を低下させることがあります。プロンプトの長さに関する適切なバランスを見つけることが、LLMを効果的に活用する鍵となります。従って、無闇にプロンプトを長くするのではなく、タスクに応じた最適なプロンプト設計を心がけることが重要です。