AIアライメント/AIセーフティの4つの問題領域

「AIアライメント」や「AIセーフティ」に関する会話で、まず最初に必ず躓くのが、これらの言葉の意味だ。「AI Alignment」「AI Safety」と聞いて何をイメージするかには、人によってものすごくばらつきがある。相手の頭に、どのような範囲の問題が浮かんでいるか、それを探るところから会話を始めなくてはいけない。

実際、これらの言葉は何を意味しているのだろうか。これらの用語・用例の出自にさかのぼっても、あまり役に立たないかもしれない。というのも、種々の思惑、ポジション取りのために、これらの言葉の意味はその都度変わってきたからだ(そのあたりの事情の一端は、Center for AI Safety所長のDan Hendrycksさんが先日のWebinarで話してくれている)。

そこで本投稿では、言葉の歴史をいったん脇に置き、今現在の議論に集中したい。そのうえで、「AIアライメント/AIセーフティ」が指す意味を四つくらいに区分すると議論がしやすくなるのではないか、という提案をしたい。

なお、本投稿は「AIアライメント/AIセーフティ」についてある程度なじみのある方を想定している。AIと社会の問題全般については、別の角度から記事を書いているのでそちらを見ていただきたい。

AIアライメントの意味は「広く」も「狭く」もとれる

まず、AIアライメントという言葉が、広くも狭くもとれることを見ておきたい。たとえば、イギリス政府が諮問し、Yoshua Bengio氏が座長を務めた委員会の中間レポートでは以下のように定義されている。

Alignment: The process of ensuring an AI system's goals and behaviours are in line with its developer’s values and intentions.

ここでは、AI開発者の意図とAIシステムの振るまいのアライメントが問題にされている。たぶんこれはAIアライメントの最も狭い意味の定義だろう。もう少し広い定義としては以下のようなものがある。

AI alignment: The project of building intelligent autonomous systems that robustly act in our collective interests.

ここでは、AIの開発者だけでなく、AIを使う人々の集合的な利害とのアライメントが問題にされている。おそらくこちらのほうが、一般的な用法に近いと思われる。

ただ、上記のような開発者やユーザーとAIモデル・AIシステムとのアライメント問題をひっくるめて一つのカテゴリーにしてみよう。さらに、「ユーザーに危害(harm)が及ぶことを防ぐ」「AIが悪用されるのを防ぐ」という問題設定を含めて、「開発者や人々の意図・価値観に沿うAIの振る舞いの実現、危険な挙動・悪用の防止」を、「AIアライメント・セーフティ(a)」としてみよう。このカテゴリーの中には、「信頼されるAI(trustworty AI)」等の名の下で行われている広範な研究や、LLMのアライメントのために行われているfine tuning、あるいは人間の集合的な選好を知るためのinverse reinforcement learningなどの研究トピックが含まれてくるだろう。

人間同士のアライメント問題とAI

広い意味でのアライメント問題を考え始めると、かなりの確率で出てくる発言に、「では誰の価値観にアラインすればよいのか?」「人間同士もアラインしていないじゃないか?」というものがある。これはそのとおりで、AIアライメントを真剣に考え始めると、人間同士がどのように異なる意見を集約し、合意形成し、社会を営んでいるのかが問題になる。そしてこの合意形成プロセスのなかに、AIが入っていく状況をどう考えるか、よりよい集団的意思決定のためにどうAIを使うのかという考察が始まる。

これはもはや「AIアライメント」や「AIセーフティ」の問題には見えないかもしれない(実際、AI Alignmentという言葉でこうした問題をカバーすることへ批判も最近聞かれる)。しかし、社会全体にとってのアライメントやセーフティとしてみれば、スコープには収まりうるとは思う。実際にAI Alignment/safetyのコミュニティは、人間とAIの混ざり合った複雑系を相手にし、それをいかに技術的・社会的(sociotechnical)な方法を使ってよりよく制御・設計していくか、という視点に移ってきているように見える。近年、界隈の人の多くが注目の取り組みとして挙げるCollective Intelligence Projectは、AIを社会に導入しながらよりよい集合知を生み出していくための様々先駆的な活動を手掛けている。

「今のAI」か「未来のAI」か

ここまではAIアライメント/セイフティの対象となる系の大きさ(スコープの広さ)を軸に考えてきた。もう一つの重要な軸は、今現存している技術に対する対策の話をしているのか、今はまだない、推論能力や自律性を増したAIへの準備の話をしているのかという点である。

もともと「AI alignment」という言葉は、2010年代にディープラーニングが出てくる前から、まだ見ぬAIの脅威を議論する文脈で使われていた(その歴史についてはbioshok「AIのもたらす深刻なリスクとその歴史的背景」という長文の文章にまとめている)。AGI、あるいはASI(人工超知能)と呼ばれるような、今のAIモデル・システムとは比べ物にならない能力を持つ技術が登場したときに人間はそれをコントロールできるのか、また人間の意図や選好に合うふるまいをAIに行わせることができるのか、という問題が、ディープラーニングの登場以前から議論されてきたのだ。

これは問題領域(a)の「未来のAI版」といえるだろう。実際、OpenAIが一時期力を入れていた見られるWeak to Strong generalizationなどはこの問題意識からの取り組みといえる。もちろん、(c)は(a)と完全に分けられるわけではなく、実際にそのようなAI技術が出てくるかによって(c)の取り組みや優先度は変わるだろうし、(a)に区分するのが自然な取り組みも、将来の技術に備えるという要素が多少は入るはずだ。とはいえ、明らかに、「今はない技術」を想定した、(a)とは区別される研究や議論が存在しているのは事実だと思う。

最後に、問題領域(a)が(b)に広がったように、(c)は以下の(d)に広げることができる。

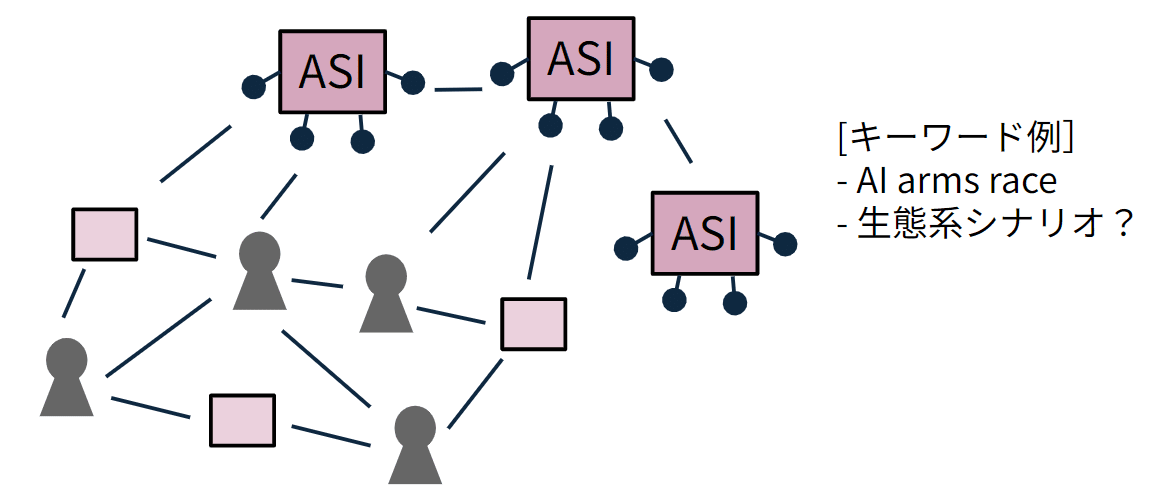

ここでは、人間とAIの混成系のなかに「ASI(超知能)」的なエージェントも入っているような状況となる。ASI的な技術がどのようなものになるのかは想像することしかできないため、多分にスペキュラティブな議論にはなるが、一部のAIアライメント/セーフティの議論がこの領域にまで及んでいるのは間違いない。

まとめ:4つの問題領域

以上、AIアライメント/セーフティの問題領域を、アライメントの「広さ」と「今の技術か/未来の技術か」の2軸で4つに分けてみた。改めて図示すれば以下のようになる。

今のところ、AIアライメント/セーフティの議論の食い違いを防ぐうえで、この4区分を意識することがベストではないかと考えている。

おまけとしての私見

なお、堅実なAIや機械学習の研究者は(a)、情報系でも社会科学よりの研究者は(b)の領域を主戦場としていると思われる。一方で、いわゆる「Less wrong系」のAIアライメントのコミュニティは、(c)から出発してよりプラクティカルな(b)の研究、あるいはよりスペキュラティブな(d)の議論をしてきたのだと思う。しかしここにきて、どちらのコミュニティも(b)の領域を重視し始めているように感じる。上記のように、(a)の問題はまじめに考えると(b)に行きつく。また(c)や(d)の「超知能」がどのようなものになるのかを占うのも、結局は人間の集団がどのようなビジョンを持ち、政策をうち、規制をかけ、投資をするかに依存する。その社会的なプロセスそのものに、今AIが入ってきている。そうした再帰的な問題領域として、今(b)の領域、言い換えると「AIと人間の混成系によるAIガバナンス」が、人類とAIの未来を占う領域として、異なる経路から注目を集めているのだと思う。

最後のところは私個人の暫定的な見立てであって、また専門家から話を聞いたりしていくなかで考えが変わっていく可能性が高い。

この記事が気に入ったらサポートをしてみませんか?