2023秋ぷよ学会まとめ4

2023秋ぷよ学会まとめ

こんにちは。ぷよ学会主催者あやさです。

これは、11/19(日)に行われた2023秋ぷよ学会について振り返るための記事です。

ぷよ学会Youtubeアーカイブ↓

学会に参加した方、ご覧になった方、見られなかった方、今ぷよ学会について知ったという方。

大歓迎ですのでぜひ質問なり意見なりコメントを置いて行っていただけると嬉しいです。(ツイートしていただいても嬉しいです。笑)

本記事では4人目たかむさんの振り返りをします。

他の発表者もまとめを作るのでぜひご覧ください☆

たかむさんのTwitter ↓

4. たかむ ぷよぷよAI関連研究の動向と学習の違いについて

ぷよぷよAIについて知る機会になれば!!

発表スライド

ぷよぷよAIもぷよぷよというゲームのAIなのでいわゆるゲームAIということになるのですが、ゲームAIは長らく「人類を倒すための最強AI」を目指して開発されてきました。ただ、最強AIを開発するというフェーズはもう終わったといってもいいと考えています。というのも、10年前に囲碁のトップ棋士をAIが倒したニュースが流れました。今貼っているこの将棋電王戦も、完全ではないですがAIの勝利となりました。こういった最強AIを目指した時代があったのですが、昨今は最強というよりも人間にとって都合のいいAI、例えばレベルが10段階あったうちレベル5の人にちょうどいいAI、レベル8の人にちょうどいいAIというものの開発が行われてきました。

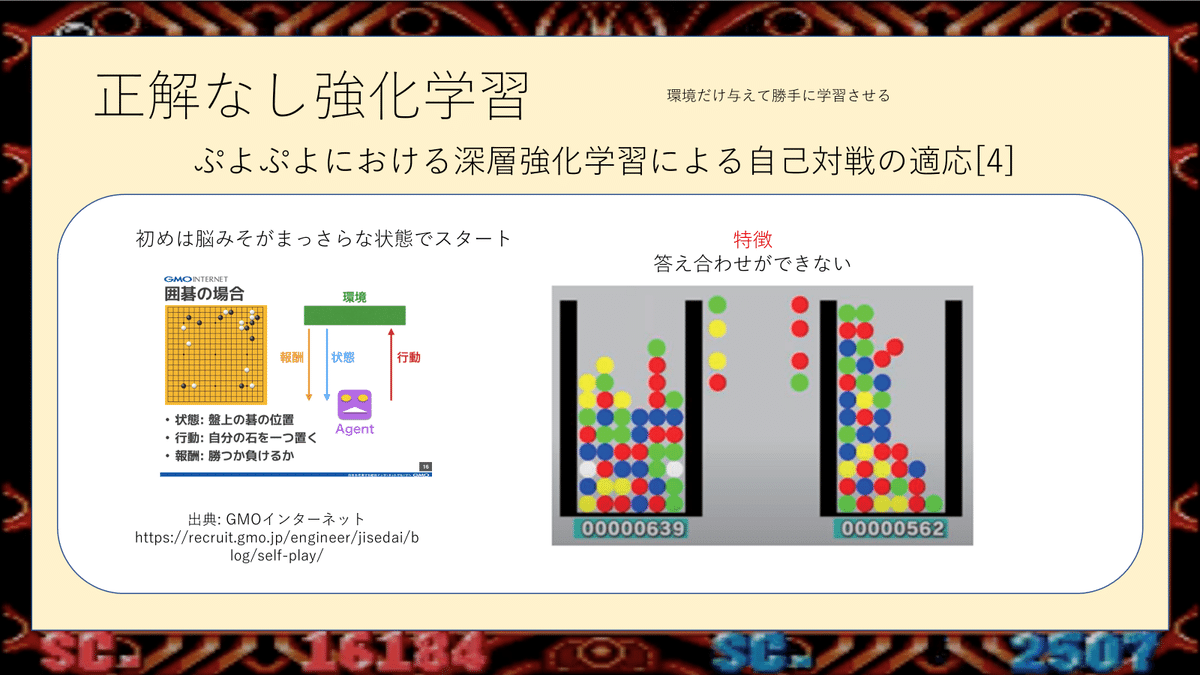

昨今は強化学習の研究が他分野でも進んでいるので、追ってぷよぷよでも研究されています。ただその中でも2種類あると考えておりまして、正解ありの強化学習と正解なしの強化学習です。こんかいはこれら3種類計4つの研究を紹介していきたいと思います。

置き方の決定と同じくらいAIでよく使われるのがゲーム木探索と呼ばれるもので、1手の置き方が22通りあるためそれを人間だと2.3手先まで読んでいるのかなと思いますが、22通りそれぞれの先に22個木が生えていくので、22のn乗、2手で484、3手見ると10000くらい、4手先まで見ると23万とか、天文学的に増えていきます。なので、現実的には2手先までかなと思います。このようなゲーム木探索はルールベースにしろ強化学習にしろAIは行っているものだと思います。

ルールベースの研究はあまりなくて、というのも「2連結がこの点数だとAIが強くなる」という職人技になるので、アカデミックなところでは研究テーマにはならないです。

右側は「mayah AIに関する研究」です。マヤAIは2世代あって、1世代目はルールベースなのですが2世代は強化学習のAIになっています。1世代のマヤAIとこぷよを100万局学習して、マヤ1世代を凌駕する性能となっています。確か出たのが10年前?かもうちょっと最近だったかもしれませんが、当時のトッププレイヤーと同じようなレベルで対戦するようなかなり強いAIになっています。こちらはフィールド6×13×4となっていますが、これは入力の方法が特殊で、動画をそのまま見ているのではなく盤面を認識してから脳みそに入力しています。盤面の4種類とネクストネクネクの情報を入力として、最終的に22個の出力になっています。22というのは先ほどお話ししたようにぷよの置き方が22通りあるので、そのうちのどれかを選択するように作られています。大体すべての強化学習で入力→脳みそ→出力の形であります。何を入力するのか、何を出力するのか、というのはすべて違うというところがAIの面白いところかと思います。

感想コメント

AI楽しみワクワク

ぷよぷよと将棋ってなかなか似ているところがありますよね

たしかに将棋AIから学ぶことも多い気がしますね。

buppa()関数がすこ。

ぷよ学会データ集めにAIを使いたいと思ったことがあるけど、インプット方法で違ってくることもあるのか…

ぶっぱ関数笑

一般的なぷよAIよりも「〇〇さんを模しているAI」の方が作りやすそうに感じますね(゜-゜)

カーバンクルに踊らされるのか

これぞおじゃまぷよ算を…?!

誰もルールを知らないぷよぷよだ

手加減してくれるAI欲しいわ

↑まじで欲しいです笑

手加減AI欲しいな~

エーックス!!

質問コメント

Q. 最後の三宅さんの研究で、「まだ6.7連鎖ですよー」ろおっしゃっていましたが、囲碁の分野だと強くなっていると。ぷよぷよと囲碁でリソースの差なのかぷよぷよの難しいところがあるのかというのは、ありますか?

→A. そうですね…。ぶちゃけ分からないというのが答えなのですが、alpha goはgoogleがもっていて、とてもパンピーには真似できないものなので、その差がないかというと、確実にあります。ただそれと同じ計算資源でやって同じくらい強くなるかというと、分からないです。

Q. 途中で「強化学習」の話が出てきたときに「手本と同じ形があると加点」というやり方があったかと思うのですが、例えば少し違う形のGTRのような、「手本とは違うけどこれも正解」のときって褒める褒めないどうするのかが疑問です。

→A. それは考えを分ける必要があると思います。「大連鎖が組めたね」の観点と「定石が組めたね」の判断があると思っていて、別々で考えたときに、連鎖は組めたけど定石はできなかったねという評価になるので、ひとまとまりで褒めるか怒るかというよりは、観点別にこちらは褒めるけどこちらは怒るよというような処理になるかと思います。

Q. ぷよぷよ全体のAIよりも○○さんを模したAIの方が作りやすいように感じましたが、そうだと思いますか?

→A. そうですね…その話をするならば、「どこまで行ったら完成なのか」を議論しなければならないと思っています。例えばmomokenさんの棋譜を見てmomokenAIを作っても、そのAIがmomokenしているのかを判断しなければいけないので、ちょっと難しい質問にはなると思います。ただ、GTRを組むプレイヤーとサブマリンを組むプレイヤーを考えると、2つのAIに分けてそれぞれを教えた方が、特徴が出るAIができると思います。

ゲームAIに限らずですが「完成した」の判断は難しいところがありますね。

Q. AIのぷよぷよは大抵下を押しっぱなしなイメージがあるのですが、下押しをやめて相手を待つ姿勢だったりが今あるのか、や今後出てくるのか、が気になりました。

→A. 僕自身今あるぷよぷよAIを全て網羅しているわけではないと思うので…あるとは思うというのが答えにはなります。トッププレイヤー相手だったらずっと下押しでいいけども、初級者や中級者に対してずっと下押しっぱだとぷよ量的にきついから調整する…というのはあまり難しくない考え方だし実装も大変ではないという観点では、あってもおかしくないと思います。

→Q. もしあるとしたら、なぜ表に出てこないかみたいなことは何かありますか?

→A. そもそも一般に公開されているぷよぷよAIが少ないと思うのですが、マヤとかニーナとか、実機で人間と対戦したことがあるAIが流行ったのっておよそ10年前だと思うのですが、他界隈も含めて最強を目指すのがトレンドだったので、「人に対して手加減をする」発想がなかったから、今も無いのかなと思います。

発表者の感想

【あやさより】学会からかなり時間が空いてしまったため、今回は発表者の感想をはぶかせていただきます。

あやさの感想

たかむさん、発表ありがとうございました✨️✨️

ぷよぷよAIのみならずAIのことから順に説明して頂き、分かりやすく、大変勉強になりました。

プレイして、良いor悪いを考えそれを学習していく…。ぷよぷよAIの成長は今後もかなり期待されるものかと思います(*´д`*)ドキドキ

また、プレイヤーの成長方法としても納得だなあと思って聞いていました。私自身アドバイスをよく貰っていたのですが、実際ぷよぷよをプレイしているところを見てもらって、「これは1縦がいいぞ」「これは暴発しちゃうからやめたほうがいい」「3.4横置きは正解!」のようなアドバイスを貰えることが成長に繋がっていたと感じています。

今回、専門家でなくても分かるように簡単に説明して頂きましたが、ぜひ詳しいところも聞いてみたいですね🤤今後が楽しみです!ありがとうございました✨️

見ていただいてありがとうございます。精進します!🌸 ぷよミニ大会/ぷよ学会は春夏秋冬3か月おきに開催しまとめるので応援よろしくお願い致します!!!