ディープフェイク詐欺の影響

いわゆる人工知能 AI は、著作権の問題、大きな電力使用、プライバシーへの懸念、誤った回答を返すことがあるなど、さまざまな理由で論争の的となっています。

しかし AI は間違いなく、文化からビジネス、政治に至るまで、デジタルライフ全般に浸透しつつあるといえるでしょう。

一方、ディープフェイクという形でAIの不正利用が増加しています。ディープフェイクとは、例えば有名人や政治家になりすまし、誤った情報や偽情報を流したり、消費者をだましたりするために AI が生成した動画や音声のことです。

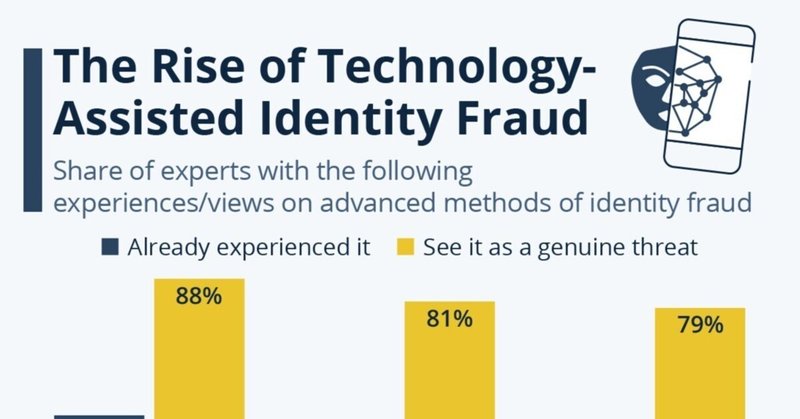

以下の表の、米国、英国、フランス、ドイツなどの国の詐欺防止に携わる専門家を対象に実施した調査によると、回答企業のかなりの割合が、高度な身元詐欺の3つの手法のいずれかに狙われています。

回答者の46%が、偽の社会保障番号と本名、住所、生年月日のような、本物と偽の ID 要素を組み合わせた合成ID詐欺のケースをすでに経験しています。

37%が、音声ディープフェイクが使用されているのを見たことがあると回答しています。政治分野で最近話題になった例としては、偽のバイデン大統領が、予備選での投票を思いとどまらせるため、有権者に個別に電話するというものがありました。

動画ディープフェイクは、今のところあまり一般的ではなく、このような詐欺行為を経験したことがあるとの回答は29%にとどまっています。生成 AI 企業は現在、OpenAI の Sora のようなツールを使って動画に注力しており、この問題は今後数カ月、数年で拡大する可能性があります。

この懸念は、調査対象となった専門家も共有しており、80~90%が同意しています。調査したRegula社は「AIが生成した偽のIDは、特別な訓練を受けていない限り、人間が検知することは困難です」としています。

個々人で自分を守ることが困難だとすれば、国家レベルでの対策が急務といえるのかもしれません。

この記事が気に入ったらサポートをしてみませんか?