LLM微調整の革新:アダプタメソッドの効率的な活用

大規模言語モデルの微調整に革新!アダプタメソッドでパフォーマンス向上とパラメータ効率を両立するアプローチ簡単に紹介します。こちらの

AIリサーチャーのSebastian Raschkaさんの記事https://magazine.sebastianraschka.com/p/finetuning-llms-with-adaptersを参考し、作成しておりますので、より詳細なこと知りたい場合ぜひこの記事を一読ください。

この記事「Finetuning LLMs Efficiently with Adapters」の主なポイントは以下の通りです:

大規模な言語モデル(LLM)は、BERT、GPT-3、GPT-4、LLaMAなど、大量のデータに基づいて訓練されたモデルを指します。これらのモデルは一般的な知識を持っていますが、特定のタスクに対しては微調整が必要です。

LLMの微調整は、特定のドメイン(例:法律や医療)に対するモデルのパフォーマンスを大幅に向上させることができます。しかし、そのプロセスは計算リソースと時間が大量に必要となります。

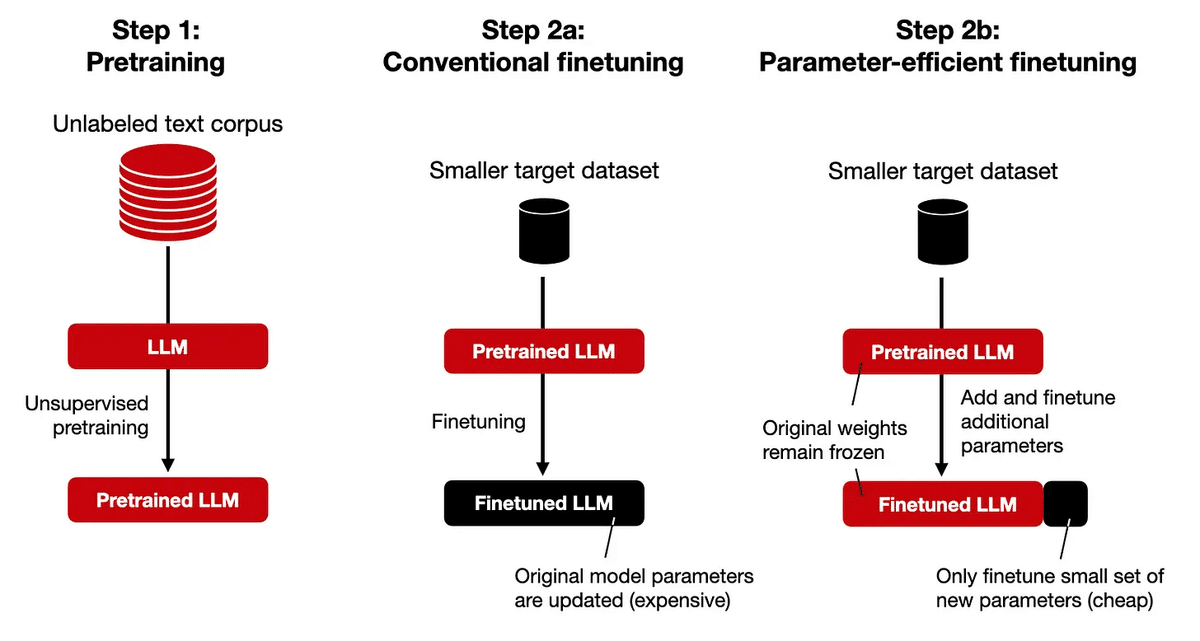

研究者たちは、パラメータ効率の良い微調整方法を開発し始めました。その一つが「アダプタ」です。

アダプタは、LLMの各トランスフォーマーブロックに調整可能なレイヤーを追加することで、モデルのパフォーマンスを向上させる方法です。

アダプタメソッドは、パラメータ効率が良いとされています。これは、新たに追加されたパラメータのみを微調整するため、全体のパラメータ数を大幅に増やすことなく、モデルのパフォーマンスを向上させることができるからです。

この記事は、大規模な言語モデルの微調整についての理解を深めるための素晴らしいリソースです。特に、パラメータ効率の良い微調整方法である「アダプタ」について詳しく説明しています。これは、特定のドメインやタスクに対するモデルのパフォーマンスを向上させるための有効な手段であり、今後のAI技術の発展に大いに寄与するでしょう。

この記事が気に入ったらサポートをしてみませんか?