いまさらKaggleに挑戦してみる

どうも、Kaggleってよく話題になってたけど、Kaggleの上位は深層学習ばかりなイメージで、食わず嫌いしてたんだよね。

初見で興味がありそうなコンペがなかったというのもだけど。

しかし、いやしかし、日頃データ分析もしてる身からすると、あわよくばオッサンからデータサイエンティストになれたらと思ってる身とすると、やっぱ避けて通れないかなと。

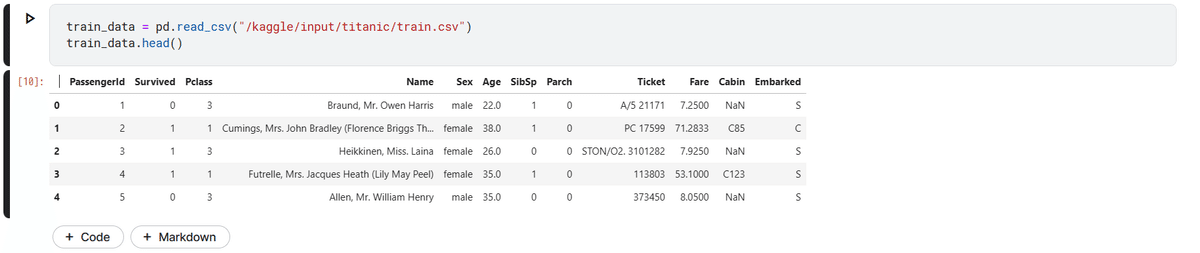

で、いきなりもあれだし、チュートリアルのタイタニックからやるかなと。

そのためのチュートリアルだし。

今日は、いくつか方針を宣言する。

方針1 説明ができるモデルを作る

チュートリアルとはいで、ただ正答率だけ求めてもなと思う。

冒頭にも書いたけど、多量のデータを食わせて深層学習というのは、やりたいことじゃないので、説明性に重きを置きたい。

線形回帰(といっても生死の2値分類になるとロジスティック回帰になるが)、サポートベクター、決定木、教科書の前半に載ってるような手法を主にしていきたい。

噂にはランダムフォレストで70%は簡単に超えるっていうけど、ランダムフォレストや勾配ブースティングはあんまり使いたくない。いわんやニューラルネットワークをや。

方針2 特徴量の作成、取捨選択は頑張る

ハイパーパラメータのチューニングより、使う特徴量の工夫。

実務だとそれだよね。

食わせる元のデータが糞だと、吐き出されるモデルも糞。

スケーリング、欠損値処理、取捨選択、新しい特徴量の定義、それらが上手くいってればfitでチューニングなしでもいい結果が得られる(はず。そうはいってももちろん、チューニングはするけど)。

とにもかくにもデビューする

今日はここまで。

読み込んだだけかよ・・・

この記事が気に入ったらサポートをしてみませんか?