GPT-4を作れって上司に明日言われたら作れますか? #WandB

こちらの記事で、Weights & Bias社(以下、WandB社)日本語LLMのランキングを扱わせて頂いたのだけど、そちらのイベント「Fully Connected Tokyo 2023」に参加してきた。

アジェンダを見るとどれも興味深いけど夕方の16:30以降が一番面白いはず…そして最後のセッションSAI秋葉さんの記事を書きたい!

と思いまして、現地レポートしてきました

GPT-4を作れって上司に明日言われたら作れますか?

️「GPT-4を作れって上司に明日言われたら作れますか?」というKagglerらしい軽快な喋りで始まった秋葉氏のセッション

シニアリサーチサイエンティスト

GPT-4はこれらの延長線上にあるの?

商用利用可能

🎉お知らせ🎉

— Stability AI 日本公式 (@StabilityAI_JP) October 10, 2023

Stability AIが日本語指示応答言語モデルの商用利用可能バージョン「Japanese StableLM Instruct Alpha 7B v2」を公開しました!

以前のバージョンと性能は変わらず、新規事業やビジネスの場でご利用いただけます。

詳細はこちら👉https://t.co/eaTSivSxBv pic.twitter.com/NS87ImU0Xs

GPT-4を作れと言われたらどう答えるか?LLMの作り方

LLMをゼロからトレーニングするためのベストプラクティス PDF配布中

https://wandb.ai/site/llm-whitepaper-japan

「LLMファインチューニングとプロンプトエンジニアリングのベストプラクティス」

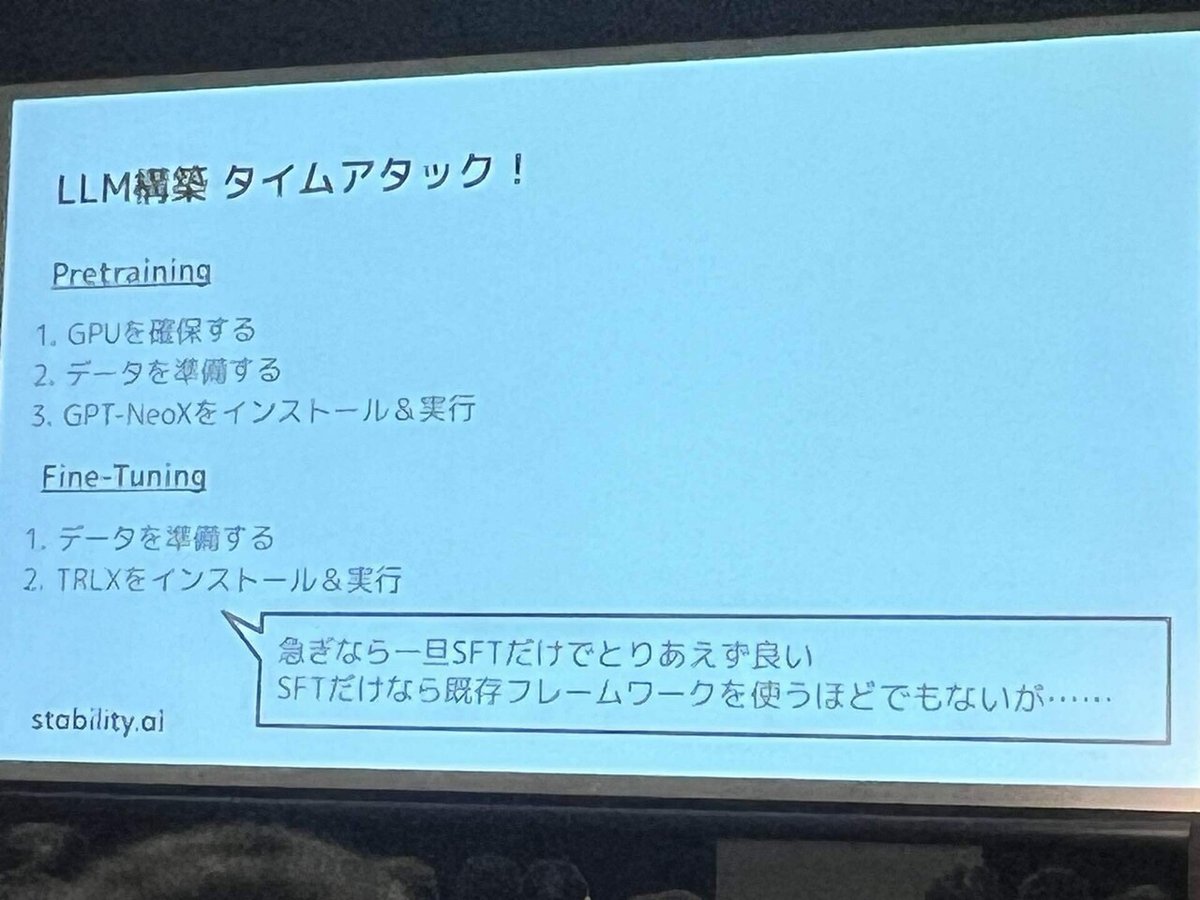

LLMの作り方 LLM構築タイムアタック!

1 Pretraining

大量のデータを学習、大きな計算資源しよう

→これがあれば勝ち確。

2 Fine-Tuning

指示を聞く、対話を可能にする

スライドが要所要所でちょけてて笑う #あきばやべぇ #wandb pic.twitter.com/LTMs8brfxa

— 城戸 (Legalscape) (@p_km) October 11, 2023

モデル構築

Transformer, データセットはRedPajama

GPT-NeoXをインストール&実行

フレームワーク、学習設定はなるべく動きそうなものを使おう

ファインチューニングのデータ準備 Alpaca,Anthropic など

TRLXをインストール&実行 SFTだけでもいい

完成。ほとんどコードを書かずに作れる

より優れたLLMを作るには

エンドロールから人員構成を算出

本日開催されました、W&Bカンファレンス、FullyConnected 2023 にてStability AI から秋葉がお話しさせていただきました。

— Stability AI 日本公式 (@StabilityAI_JP) October 11, 2023

たくさんの開発者の皆様がメモや写真を撮りながら真剣に耳を傾けてくださり、とても感激しています。

Stability AI はこれからも日本の開発者の皆様と共に頑張ります! pic.twitter.com/w6MzaR3Bcd

W&B Fully Connected、ありがとうございました!私からは「LLM、作るだけなら意外と簡単だけど、その上でどういう勘所があって、我々はW&Bを活用しながらちゃんと着実に取り組んでいるよ」という趣旨の話をさせて頂きました。一応スライドも公開しましたのでご笑覧下さい〜。 https://t.co/WST89C0Bt5

— Takuya Akiba (@iwiwi) October 11, 2023

個人的感想

そのほかのセッションもとっても良かった

時間あったらまとめたい

WandBのイベント良かった!

— Dr.(Shirai)Hakase (@o_ob) October 11, 2023

忙しいけど来て良かった#wandb pic.twitter.com/kE5q9bsyE2

知見を長々喋る感じでなくて、時間もきっちりで圧縮されていた感。

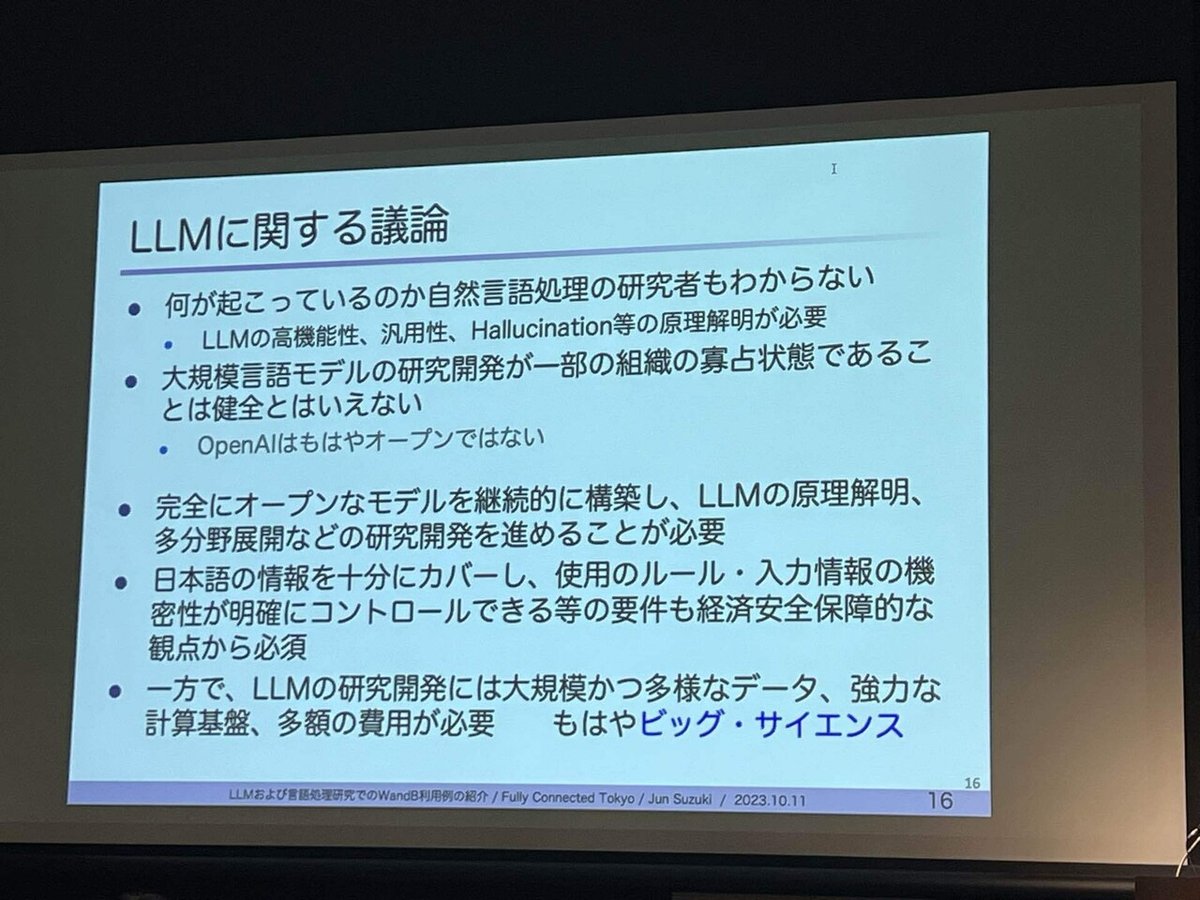

秋葉さんのセッションは、LLM構築を身近なものに感じさせるし、一方ではそんな簡単じゃないけどWandBのような環境でスッと作る事が大事だし、一方ではブラックボックス化しやすいOpenAIの中身を分析して上回るアプローチや、より効率的だったり軽かったりするモデルが日本の日本語の環境では求められていくのだなという印象を受けた。

テクニカルにはRLHF関係の扱いとか…

RLHFは無くても良いよって伏線は来月Stability AIが回収してくれるように聞こえた#wandb

— Shogo.A (@ShogoAkiyama1) October 11, 2023

WandBさんにも直接会えて、どんなユーザーが日本にいるのかとか、エンタープライズユーザだけでなく大学関係とかは無料だし(今回の東北大/NIIのLLM研究会の話もエキサイティングだった)、インターンも募集中。

日本の研究者が集まるオープンな組織「LLM 勉強会」がインターンシッププログラムを開始しています。https://t.co/FI2uTnjhjR#AI求人

— AICU Inc. (@AICUai) October 11, 2023

LLM構築はWandBのMLOpsの一角でしかない。

そして完全に不可能という技術ではないと勇気づけられた。今後もウォッチしていかねば。

この記事が気に入ったらサポートをしてみませんか?