GoogleIO 2023まとめ(視聴メモ)

こちらを視聴しながらメモしてみました。

※英語力が乏しい人によるメモレベルですので、正確な情報は記載してある動画時間あたりをご視聴してみてください。

It’s go time! 🎉 #GoogleIO is here — follow along for all our news and updates. https://t.co/GpRXHUVKxc

— Google (@Google) May 10, 2023

本日は15プロダクトについて発表がある模様です

主にAIを使って以下のサポートをしていく

知識や学習体験の向上

クリエイティビティ、生産性の向上

イノベーション促進

ビルド・デプロイ周りの支援

Gmail(05:21~)

Smart Reply: 返信する際にメール下部にあるコマンドで返信文の簡易生成ができる

Smart Compose: 返信内容を考える際に、テキスト補完もされる

Help me write: メール内容の生成可能。テイストもいくつかのタイプで変えられる

Google Map(06:59~)

Google Photos(09:09~)

PaLM2(13:25~)

Google DeepMind / Gemini(17:00~)

大量にあるデータからそのデータを見つけるためのアプローチを検討している。それがWatermarkingとmetadataと言っている気がする。

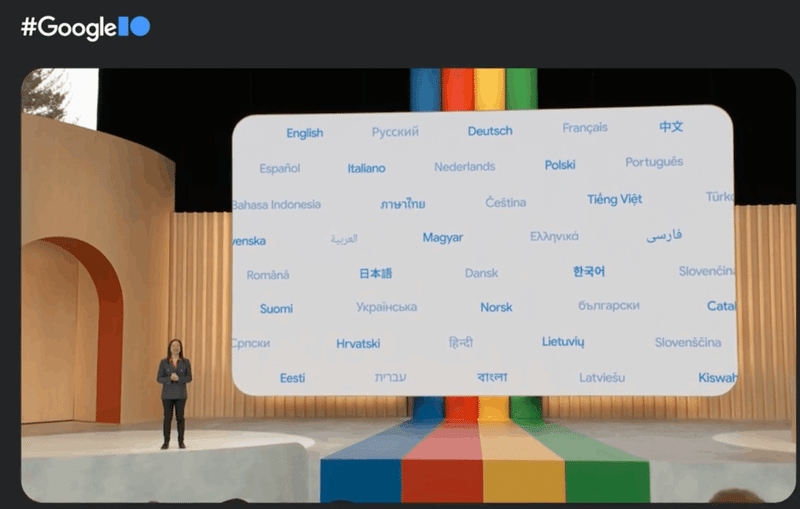

Bard(19:20~)

PaLM2の上で動いているBardは、数学的な計算力やReasoning能力も上がっている。

Google Workspace(30:57〜)

ここからは各プロダクトの中でどのようにAIを活用していけるのかという話。

Google Docs(32:00~)

Google Sheets(33:00~)

(直訳:料金付きドッグウォーキングビジネスのための顧客とペットの名簿)

Google Slides(34:00~)

Duet AI for Workspace(35:30~)

マイクロソフトのCopilotのGoogle版みたいな印象

またいくつかの質問も提示される。

ここでは(おそらくSheets内容に記載されている)既に考えているメインディッシュについて提案されている

Labs(41:30~)

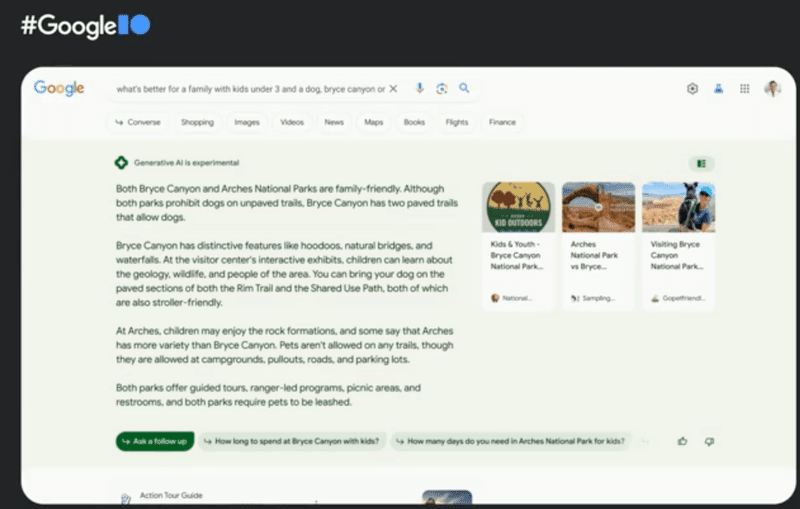

Search(42:40~)

エビデンスとなる情報元へのアクセス性が高まる感じ。良いかも

普段は判断軸みたいなところを検索してから、購入みたいなステップを分ける必要があったけど、一括で色々と情報が得られるという点で良さそうかも

対話形式で色々と聞くことができる

googleは検索クエリの前提情報を理解した上で結果を示してくれる。

52:45あたりで新しい検索体験が感じられるビデオが流れているので、チェックしてみてください!

ツイートも流れていたので紹介

Google kinda crushed it on the AI unveiling 👌 pic.twitter.com/cKGxvdrZ01

— Ridd 🏛 (@ridd_design) May 10, 2023

Google Cloud(55:55~)

Vertex AI(56:50~)

Duet AI for Google Cloud(1:02:55~)

A3 Virtual Machines(1:04:40~)

話の流れ的には、サービスインを想定したときより早いチャットレスポンスを実現を提供するためのインフラを想定しているのかな。

以下からWaiting ListへJOIN!

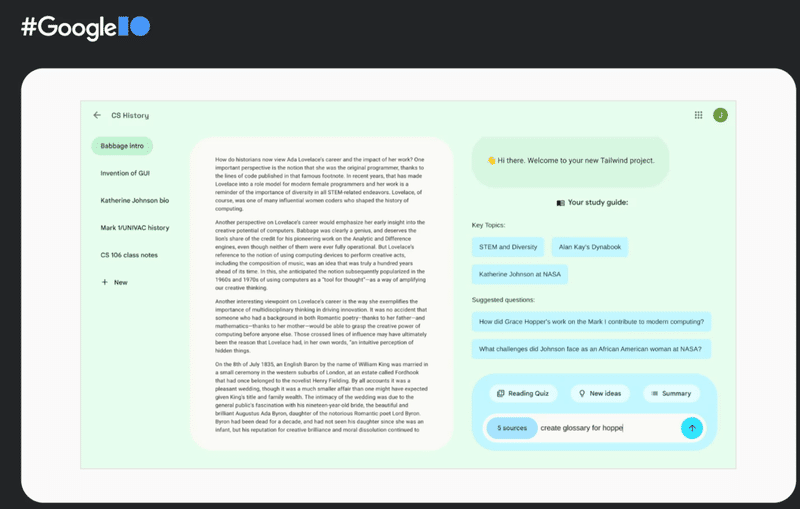

Project Tailwind(1:07:15~)

AlphaFold (1:12:25~)

Evaluating information(1:14:40~)

Universal Translator(1:16:55~)

Automated adversarial testing(1:19:00~)

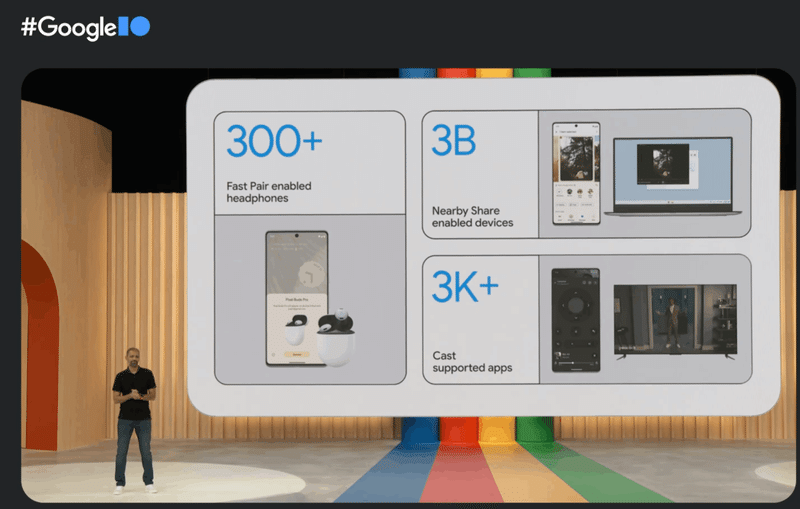

Android(1:21:30~)

Messages(1:30:00~)

Wallpapers(1:31:15~)

パーソナライズなところをよりリッチにしている感じっぽい

今年の秋に来る予定。

Pixel(1:37:10~)

Tablet(1:44:20~)

スマートホームアプリへのアクセスが容易になったらしい

Google Pixel Fold(1:53:30~)

これいいね!

実際に見てみると使い勝手良さそうだな〜

この記事が気に入ったらサポートをしてみませんか?