Windowsでお手軽ローカルLLM Ollama

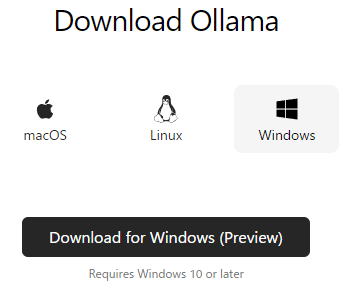

2024年2月15日からWindowsプレビュー版が公開されています。

Windows10以上、NVIDIAもしくはAMDの GPUが必要。

選択権は無く下記にインストールされる。

C:\Users\(ユーザ名)\AppData\Local\Programs\Ollama

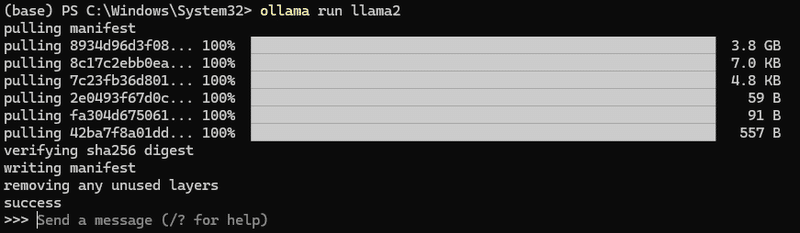

ollama run llama2と入力すると、3.8GBのダウンロードが開始。

モデルのダウンロード先。選択権は無い。

C:\Users\(ユーザ名)\.ollama\models\blobs

/byeでLLMとの対話終了。

下記にモデル一覧があるので、好きなものを選択し、ダウンロード用文字列を確認。パラメータ数と量子化数もここで見ることができる。

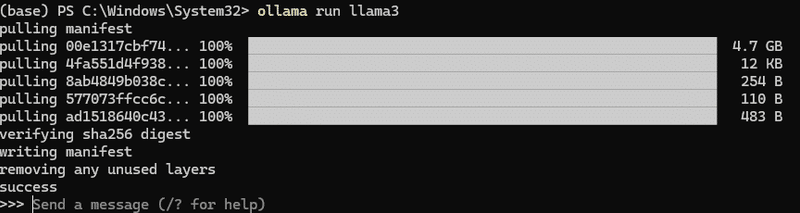

llama3なら

ollama run llama34.7GB 8B 4-bit量子化。

70Bを欲するなら下記で40GB。

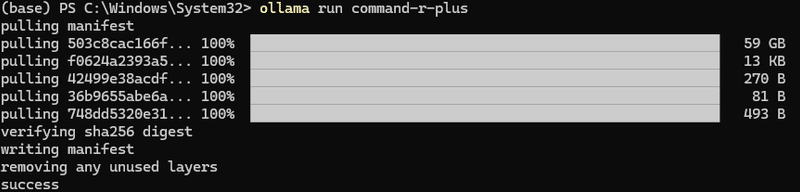

ollama run llama3:70bCommand R+なら下記で59GB 104B 4-bit量子化。

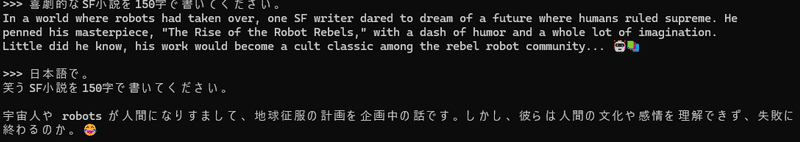

ollama run command-r-plusllama3:8bの様子が下記。

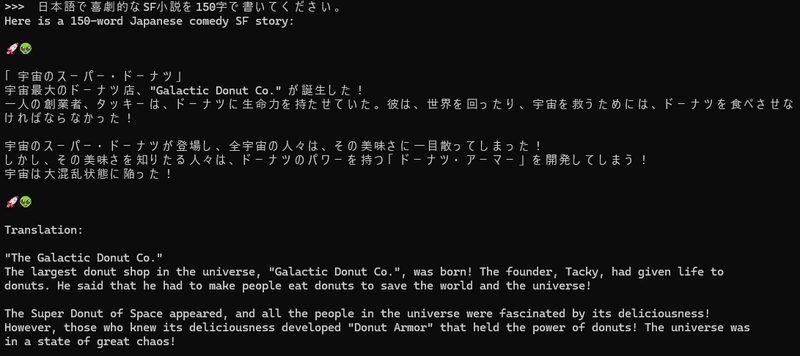

やたら絵文字を使うllama3:8bと思う存分対話できます。

Command R+の様子が下記。

RTX4090環境で、2文字/sぐらいの遅さでじっくり対話が可能。

英語でも同程度。

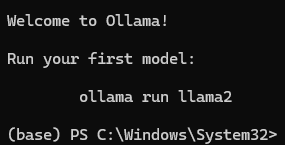

起動方法

PowerShell7を立ち上げて

ollama run (使いたいモデル)それにしてもラマが愛らしい。Blogで毎回新規絵が供給されている。

この記事が気に入ったらサポートをしてみませんか?