AIの話とワタツミ獣神化の話とControlNet1.1を触る話

AIの話

こんにちは、プロゲーマーです。

備忘録として色々書いておきます。あと、よく思うことを書いておきます。

最近、AIすごいっすよねぇ〜!って、ここ数年ずっと言ってる気がしますけど、やっとなんか手の届くところまでやってきたなー・・って感じです。

15年くらい前に 「iPhoneすごいよね〜、楽しみだね〜」って言ってた頃と似てる気がする。とても楽しいです。

ChatGPTやら、NotionAIやらの文字ベースのものから、声を自動生成するやつから、写真みたいなイラストを出すやつから もう人間って一体どうなっちゃうんだろうっていう感じがします。

でも、新しいAIに手をつけまくったりしていると、ちょっと慣れてきた頃には他のすごいエンジンがでたりするので、どれもこれもさわるのは現実的じゃないなーって思ってます。GPTモデルのAPIさわるだけで日が暮れますから、そんなにあれもこれもさわってられないです

AIとの付き合い方

人生を料理とするなら、AIって調味料とか調理器具であるべきで そのまま食べるべきものじゃないと思ってるんですよね。 正しい調味料の配合の仕方や、自分なりの配合みたいなのだったり、誰も知らない秘密の調味料を見つけたり、とんでもない使い方をして味を整えたり。

どこまでいっても料理を楽しみながら作れるのは人なんだよって思うんです。

「AIに仕事を奪われる〜!」なんて言う人もたくさんいますが、調味料や自動調理器が増えてもコックさんはなくならないんじゃないのかな〜、なんて思っています。どこまでいっても、AIは何かを補完するツールだと思うんです。

いろんなAIがすごい!とか色々新しい技術が世に出る中で、AIってGUI化されるのに時間がかかったり、GUIでは全ての機能が使えなかったりすることってよくあると思います。

※GUIとは、グラフィカルユーザーインターフェースの略。ボタンとかフォームとかがあるやつ。UIがあるやつだと思ってもらって大体OK。対義語は、CUI。(Character User Interface 文字によるユーザーインターフェース。黒い画面に文字がいっぱいある難しそうなやつ想像してもらればOK)

これは、ノーコードツールと言われるモノと、プログラミングの関係に近いのかも知れません。

※ノーコードツールとは、プログラミングが出来なくても●●がつくれるよ!みたいなツール。プログラミングができると「そんなん要らんくね」ってなりがち。

wordpressがなんとなくさわれてもjs,phpが全くさわれなかったら、自由度なんてのはお察しレベルなのに似てるのかなー。(wordpressがノーコードツールだとは思ってないのでそこだけあしからず)

まぁ結論からいうと、AIチャットくんとかAIイラストくんみたいなのって、あれでAIを使った気になっちゃうのって、「すっごくもったいねえよなあ・・」って思うわけです。

GUI化されたものすらすっ飛ばして 「LINEっていう慣れたUIで使えるよ!」ってのがウリなんだろうけど、、 そもそも1日に●回以上やりとりできないとか、セッションが複数持てないとか・・ あれ?これ大丈夫・・?ガチの劣化版じゃねってなっちゃう。

それをさわって「これが最新のAIか〜!」って思う人が増えるのがすごい嫌。ただ、AIに慣れてないユーザーや技術的なスキルがないユーザーでも、AIを簡単に体験できる・・ってのはとても素敵だと思うけど、思うのだけど!!

ChatGPTのサイトのユーザ登録ができないような人に、簡易AI使わせてどうするんだって思ってしまう。人の可能性が拡張しない可能性があがりそうなのがすごくイヤ。

例えば、ChatGPTのセッションーーーースレッドみたいなやつ。

あれってそれぞれ独立していて、過去のセッションと情報を共有しないのがウリだと思うんだけど、それの使い分けができないシングルセッションな時点で、いくらLINEで使えてもなーって思ってしまうわけです。(使ったことないから使えたらごめんなさいだけど)

いずれ進化していって、LINE上で全ての機能が使えるようになったらすごくいいんだろうね。今の状態でLINEで使えるChatGPTなら一旦僕はスルーです。おそらく優れてる点が、LINEで使えること だけだから。

話はちょっと変わって

さて、先日友人らと「ChatGPTていうほど使ってる?」っていう話で酒を飲みました

僕は「めちゃくちゃ使ってる ないと死ぬ」と答えました。

友人は「いまいち全然どうつかうべきかわかんない」っつってたんですけど、使い方が悪いっていうか・・・何聞けばいいかわかんないんだろうなーて思いました。

なんかGoogle検索で答えが出るようなことをChatGPTに聞いて、AIというやつを評価する人ってすごい多いなぁと思うんです。3歳児に何歳ですか?って聞くかの如く。

こんな感じ。

きんちゃく???!?あんみつ!? みたいな。

こういうことがおきて、「あぁAIって使い物にならないねぇーー」っていう判断をする人が多すぎるとでもいいますか。

なんというんでしょうか・・・愛知県の名物なんて、そんなものはGoogleに聞くべきです。

言い換えると、既に答えがある情報をAIから取り出そうとする ってのは、Googleにやらせておくべきなんです。ウェブ全体を検索して、適切な情報を見つけるように設計されているので当然なんですよね。

一方でAIは、情報を生成して特定の問いに対して最良の答えを出すように設計されてるーーとでもいえばいいのかな。

答えを出すという意味では全く同じなんだけど、その答えへのアプローチが全然違うんですよね。

プログラミングをAIにさせたら、一発で出来なかった!AIはまだまだクズ! みたいな記事をちょいと前に見かけましたが、指示の仕方が悪いんじゃないのかなって思っちゃうわけです。

AIに出力された情報をググりなおして、人の手によって書かれたまともな記事を見て、その記事の信頼性をAIと吟味しながら、手順をすすめるーーとかだったら大体できると思うんだけどな。

それすらも自動化される未来って相当先ですよ。

Googleの検索結果ですら、間違った情報や古い情報が未だにたくさん載ってるのに、それらの正誤判断なんてAIができるようには、しばらくならないんじゃないかなって思います。答えが1つじゃないものの方が世の中は多いですし、そこの判断は人がすべきですし。

「HANAHANA30のリプレイ外しをしながら、チェリーを4枚で取る方法は?」なんてAIにもGoogleにも答えられませんし、こゆきマッチの最善化もAIにはできません。

人が機械的にどれだけやっても、機械にはまだ出来ないんです。(というか誰もAIにそんな事させてない)

えーっと、何の話がしたいのか忘れましたが、AIとは上手に付き合っていきたいと思うわけです。どこまでいってもオモチャだと思って、色々やるのが健康的な気がします。

ワタツミ獣神化の話

さて、こいつつよいですね〜。ものすごく強い。なんでこんなキャラいなかったんだろうって思う。作った人天才。

SD関連でググってきた人には申し訳ないけどモンストの話しています。

あとあまりに強いので、ちょっとこの娘をStable Diffusion(以下SD:簡単にいうとお絵かきAI)の拡張機能であるContorolNet1.1(以下CN11)を勉強したいので色々さわってみることにしました。(?)

機能があまりに多すぎて、上手に使えるどころか、理解できる気がしないので敢えてググらずにミスしたりしながら、身体で覚えていくことにして、そんでもってその過程を備忘録として記事にしていくことにします。

ちなみに環境は

M2 Mac(2023early) OS 13.3

メモリ:96GB

Stable Diffusion web UI (Automatic1111)

python 3.10.6 | 3.10.11 の併用

ですー。

SD、macの情報が少ないので、インストールにもちょっとだけ苦労しました。ーーかといってなんでもかんでもGoogleColabでやるのも好きではないのでローカルで構築しました。GoogleColabに何個同じSDインストールされてるんだろうって思うとグーグル泣いてるよ。

もしmacに諸々インストールしたいけど困ってるーって人いたらLINEください、たぶん問題なくできます。大体躓く原因はpythonのバージョン問題だと思っていて、pythonとpipのバージョン合わせて色々インストールすればだいたいいけます。

現在、macで困ってることはA1111でLoRaファイルの作成が出来ないこと(GPU都合かな?)くらいです。やりたいことが増えるともっと増えていくんだろうけど、難しいことはあとで考えることにします。

一旦その手のことがしたいときは、Hypernetworkと拾ってきたLoRaファイルと 今からさわるCN1.1でどうにかしようて思っています。

ControlNet1.1 (CN1.1.173)を触る (下準備)

新機能がいっぱいあるらしい。モデルは全部インストール済です。

新機能どころか、CN自体をさわって2時間しか経っていないのですが、明らかに理解の範疇のキャパを超えたので身体に覚えさせていくわけです。

で、せっかくだからnoteに書いてまとめておけば忘れにくくなるだろうーと思って書いてます。

使用モデルはこれらを使います。

MODEL(CheckPoint)は、Pastemix-better-varに固定していろいろ試していこうと思う。Hypernetworkはいろいろ作ったけど一旦Noneでやります。

ControlNet1.1 (CN1.1.173)を触る (知識の下準備)

プリプロセッサ と CN1.1のモデルと その組み合わせに応じて発生する必要な入力プロンプト(画像の場合がほとんど)からいろいろつくってくれるわけだ。

プリプロセッサは、言葉の通り、本処理前に行うモノで、モデルは最終出力結果に使うモノ。プリプロセッサがめちゃくちゃ多い。

プリプロセッサとそれぞれ対応したモデルを使わないとたぶん変なことになると思う。

たくさん失敗して根本からワタツミと学んでいきたい。

CN1.1をとりあえずさわっていく

:プロンプトは空っぽにする。

:ネガティブプロンプトには EasyNegativeの拡張がはいっております

:右側に入力画像(下処理をしてある場合はその処理済の画像が入ります、左側に出力画像がでてきます)

とりあえず適当に触ってみる。

【1】下処理なし ⇒ control_v11p_sd15s2_lineart_anime [3825e83e]

ーーーーまぁそうなるよね、轟絶キャラみたいなのが産まれた。

下処理を特にせずにLINEART化するなんてことはできない。なので、それに応じた下処理(プリプロセッサ)を選択する必要があるんだと思う。

ただ、LINEARTにも5種類くらいあるっぽいので色々ためしていきましょう。ここらでシード(ランダムの種)を固定しておきます。これで比較しやすいような画像が生成される、はずです。

ーーですので、下処理をしてからぶちこみましょう。

lineart_animeで下処理をして、lineart_animeで出力します。

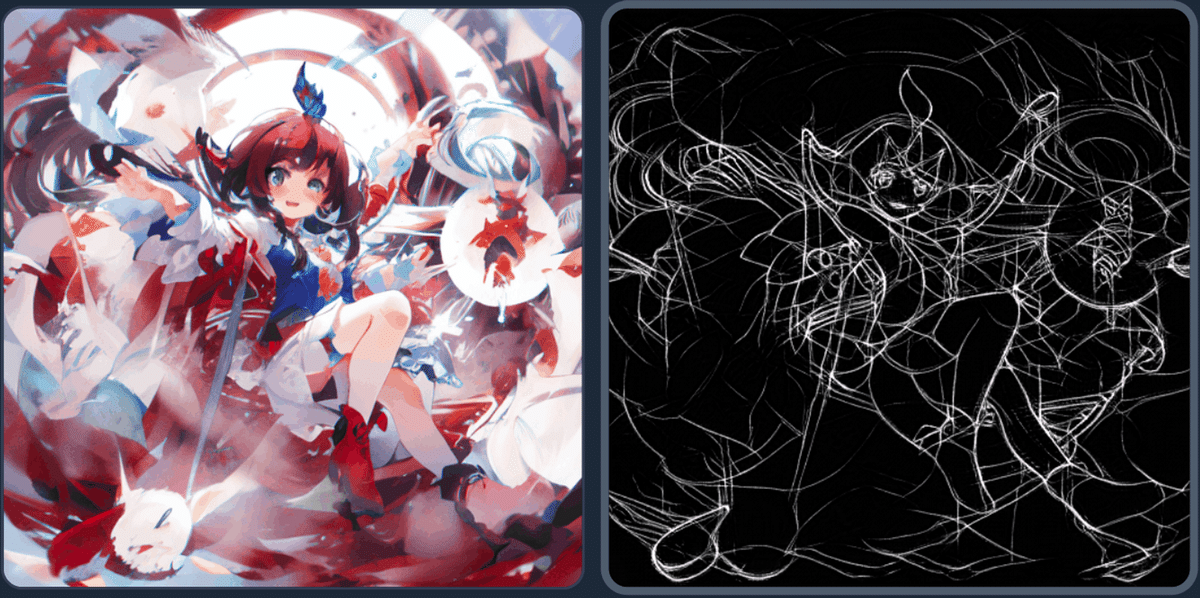

【2】 lineart_anime ⇒ control_v11p_sd15s2_lineart_anime [3825e83e]

プリプロセッサにもモデルにもLINEART_ANIME とLINEART があるので比較してみよう。

出力をlineart_animeではなく、lineartに変更してみます。

【3】lineart_anime ⇒ control_v11p_sd15_lineart [43d4be0d]

前処理は同じだけどこんなに変わるんだ。こいつのいうanimeの定義ってなんなんだろう。色がセーフカラー(?)で表現されていて、かつ、線が太いーみたいな感じでしょうか。

前処理もいろいろと種類があるので試してみましょう

denoiseというのがあるので、それで前処理をしてからぶちこみます。

【4】lineart_anime_denoise ⇒ control_v11p_sd15_lineart [43d4be0d]

おそらく、ノイズ減らしただけだと思うけど、どういう影響が出るんだろう・・・・・。

出力結果については個人の好みによるだろうから、いったんかわいいなーと思います。前処理がめちゃくちゃしっかりしててすごい。1枚絵からこれが0.2秒で作れるのすごい。

次は、前処理をlineart_coarse(ガツガツの意)させてからぶちこんでみる。

【5】lineart_coarse ⇒ control_v11p_sd15_lineart [43d4be0d]

最終的な出力の結果は同じlineartなのであまり変わらないけど、これから出力ができることがすごい。

次はrealisticな線画にできる前処理をしてみる。

【6】lineart_realistic ⇒ control_v11p_sd15_lineart [43d4be0d]

これを手軽に前処理ができるのがすごい。ボタンひとつですよ、Photoshopでもちょっと大変ですよ。

これは realistic(現実的)ってことらしい。写真とかに本来使うのかな?

出力結果は、なんか光源がしっかりしてるようにみえます。

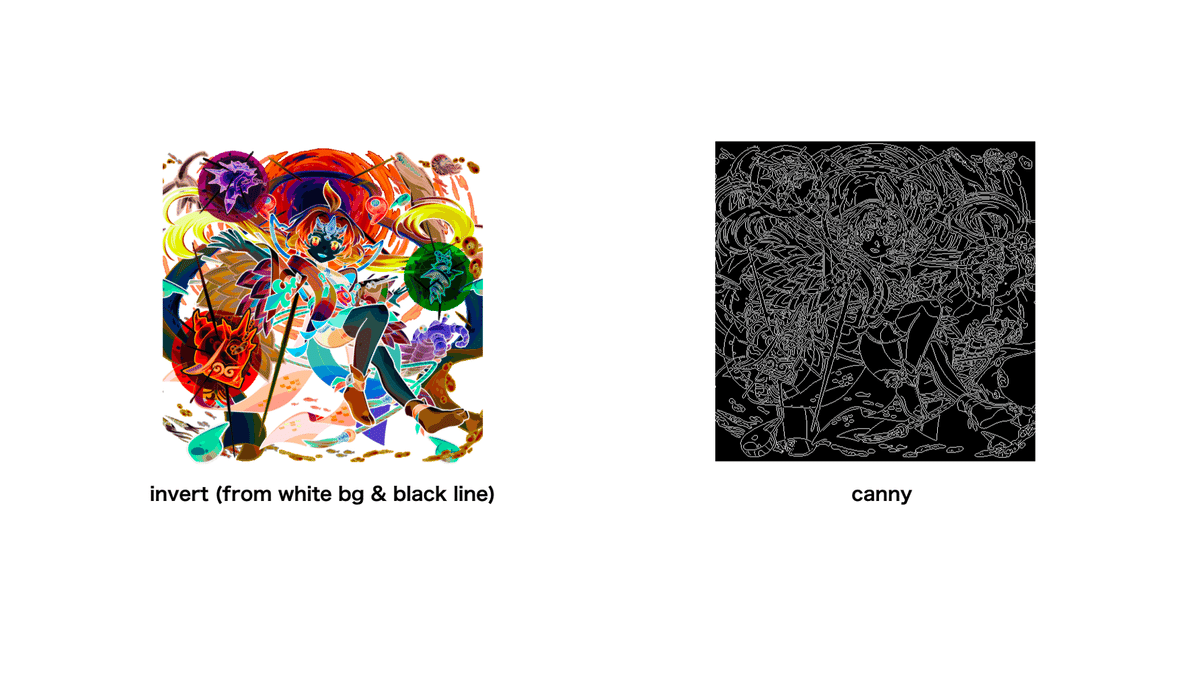

【7】lineart_standard (from white bg & black line) ⇒ control_v11p_sd15_lineart [43d4be0d]

これは使い方が違うかも知れないけど、白黒反転用かな?

なんか、このアルビノ化した感じの前処理を使って、出力をさっきのlineart_animeにしてみよう。

【8】 lineart_standard (from white bg & black line) ⇒ control_v11p_sd15s2_lineart_anime [3825e83e]

アルビノ化はたまたまだなー。ただしく処理をしてから使わないと背景が黒くなりますよ、と。

前処理(プリプロセッサ)の数がとても多いので、先にプリプロセッサを大まかに全部使ってみよう。

イメージがつかめるかもしれない。

大まかにプリプロセッサを全部試す。

前処理のことはなんか色々わかったーーー気がする。

読み込む被写体に対して、適切な処理をしたいときにそれに合わせて適切な前処理をしようってことだよね、たぶん。当たり前だけど。

あと面白そうなのがいくつかあって

入力プロンプトの方式が変わるタイプのモデルがいくつかある、ちょっといろいろ試していきたい。

なかでもip2pはどう考えても面白いので、実写写真とか上手に使ってやってみたいなー。

とりあえず、引き続きワタツミをもうちょっと色々やってみましょう

まず、属性変えたいんすよね。火にしたい。

あと種族を亜人気味にしたい。神様っぽさを取り除きましょう。

あとは、モンストっぽさをきちんと反映させたいのでモンストっぽくする調味料を混ぜる。(フチドリをそれっぽくするのと装備的なものの配色を整える。)

ちょっとだけPhotoshopで手直し。色をモンストぽくした。

顔が崩れてたり、色の数を制限してもうちょっとモンストっぽくしようとすると、レイヤーごとにわかれてないから大変そうなのでこのへんでやめ。キリがない。この遊び、沼すぎる。

もうちょっと装飾とか作り込みたい気もするけど、そもそも意味やコンセプトがないから、ある程度はしょうがないんだけど。一旦なんとなく理解できた気がする。CN1.1。イラスト以外にも実写系にもチャレンジしてみたいなーと思った。

すげえよなあ

今日さわってみたことって、たぶん基本のキなんだけど

今はまだ難しくてもこういったAIがそこそこ上手に誰でもつかえるようになると、世界中の人が絵がかけるようになるのとほぼ同じと思ってしまいます。

なんというか、僕らは絵描きさんじゃないので、思い描いているものを100%再現できるわけではないだろうけど、70%でも十分ですよね、絵が1から創作できない身からすれば、元々0%なんだし。

だからなんていうか、そういう、絵描き力70%になれる可能性をつぶしちゃう気がしていて、冒頭に書いた LINEで簡単にAI! 系のサービスがあまり好きじゃないんですよね。人とAIの出会いのキッカケにはなるかもしれないけど、進化の可能性があまりに運営会社ベースになってしまうというか・・・。

そもそも

「コーラを飲むピカチュウ」 ⇒ 出力 ⇒ 「わーすごい!!」

みたいなのってgoogle画像検索でいいんですよ。

でてこないけど。

情弱ビジネスとまでは言わないけど、なんていうか可能性の蓋を閉じてるのがなんか気になるなー。テクノロジーってもっと面白くワクワクっするようなものであるべきだと思うんだよ。

もっとみんな前のめりにダメ元で、興味本位で普通のAI(LINEで動くやつは普通のAIじゃないよただのサービスだよ)をさわってみたらいいのにな〜って思ってます。

全く興味なかった人が「キララさんでもさわれるなら、俺にも出来るかも!楽しそう!」って思ってくれたらうれしいです

あと!

今はもちろん1枚絵を出力したんだけど、最終的に1枚絵を出力したものを、パーツごとにレイヤーにわけることができる世界になったらすごいことになるなぁ・・・!って改めておもいました。

なんか下手したら今年中にそういうフェーズに入る気がしてしまう。

誰でもパソコンさえあれば無料出来るのめちゃくちゃ楽しいな。

今さわっていた画像系AIを活かすような仕事は俺は特には無いんだけど、なんか上手に使って、生活に彩りをつけていきたいものです。

すごいスピードで進化していくのをさわっていれば感じられるので、とても楽しいー。趣味AIみたいになってるな。なんか触ってみたいから触ってるだけの初学者なんですけど、同じような趣味のフォロワーさんいたら仲良くしてください、よろしくおねがいします。

この記事が気に入ったらサポートをしてみませんか?