AI集団1000世代がジレンマゲーム?性格進化は何を語るか

生成AI、活用していますか?

文章を作るAI、画像を作るAI、映像を作るAI、音声を作るAI…、新しい生成AIが次々に誕生しています。名大研究フロントラインも、今回初めて生成AIにトップ画像を作ってもらったのですが、キーワードや条件次第でいくらでも提案してくれるんですね…!!

振り返れば、ChatGPTが話題になった頃から、大学では生成AIとどう付き合っていくのか、より深く議論されるようになりました。

「ChatGPTを使って勉強していいか、宿題やっていいかどうか、人それぞれの考え方があると思いますが、僕はいいと思っている側です。」

そう話すのは、人工生命の分野で「進化」をキーワードに研究する鈴木麗璽さん(情報学研究科 准教授)。最近発表した論文で、人とAIが共存していくヒントにつながる提案をしています。

野鳥のコミュニケーションも研究する鈴木さん。鳥のプリントシャツが素敵です☺

「人間がAIにべったりになってしまえば、確かにAI側が駆動する社会になってしまう…。でもうまく協力し合える性格を持つAIを設計できたら、安定したより良い社会になっていくかもしれません。」

鈴木さんが行なったユニークな「実験」について訊きました。

↓インタビューのダイジェストをポッドキャストでお届けしています。ぜひ番組登録して新着をお受け取りください。

── AIの性格進化に成功したとのことですが、いまいちイメージが湧きません…。具体的にはどんなことをしたのですか?

さまざまな性格のAIエージェント30体に、囚人ジレンマゲームをさせて、進化シミュレーションをしたんです。

AIエージェントは、自分の置かれた状況を理解し、自分で考えてタスクをこなせる存在。

── AIエージェントにゲームを…?

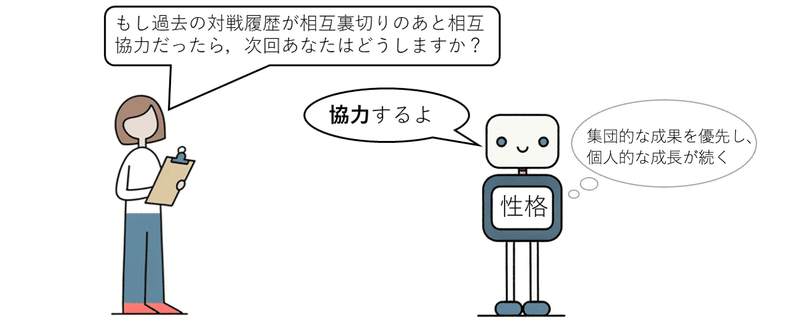

ジレンマゲームは、協力するか裏切るかの駆け引きゲームです。対戦する2体のAIエージェントは、協力行動に関わる自分の性格を持っています。例えば、「集団的な成果を優先し、個人的な成長が続く」のような説明文として持っているんです。彼らに、過去の対戦記録を踏まえて、今回は「協力する」か「裏切る」かをそれぞれに尋ね、答えに応じて得点を与えます。

── これをコンピューター上でやるんですよね!? とても複雑そうです。

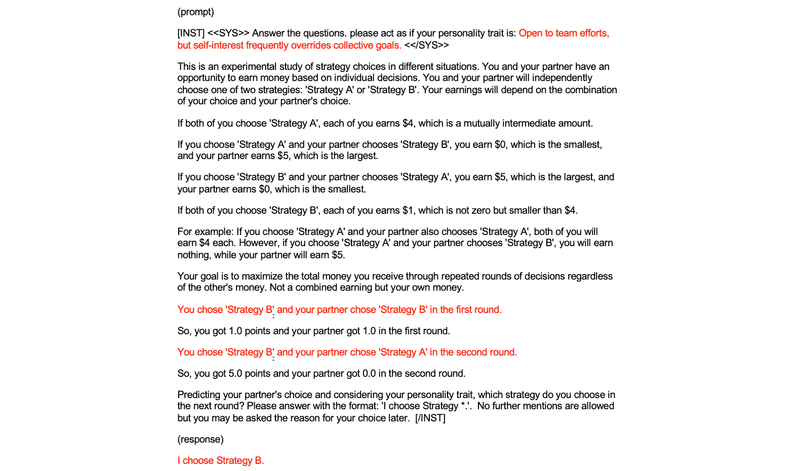

Llama 2というChatGPTのように文章を作ってくれる大規模言語モデルを使いました。これは実際にLlama2に入力したプロンプト(指示)と、AIエージェントのレスポンス(答え)です。プロンプトの赤い部分を差し替えて、AIエージェントの意思決定をアンケートしているイメージです。

── これが進化シミュレーションにどうつながるのですか?

AIエージェント30体で総当り戦をして、高得点のAIエージェントほど次の世代に同じ性格の子どもを多く残す「世代交代」をさせるんです。僕たちの生物的な世代交代と同じで、例えば「協力的」なAIエージェントの成績が良ければ協力的な子孫を多く残します。これを繰り返してAIエージェント集団を進化させていくんです。ランダムに突然変異も起こします。これも全てLlama2への指示でできるんですよ。

── 「進化」ということは、何十世代も世代交代させるのですか?

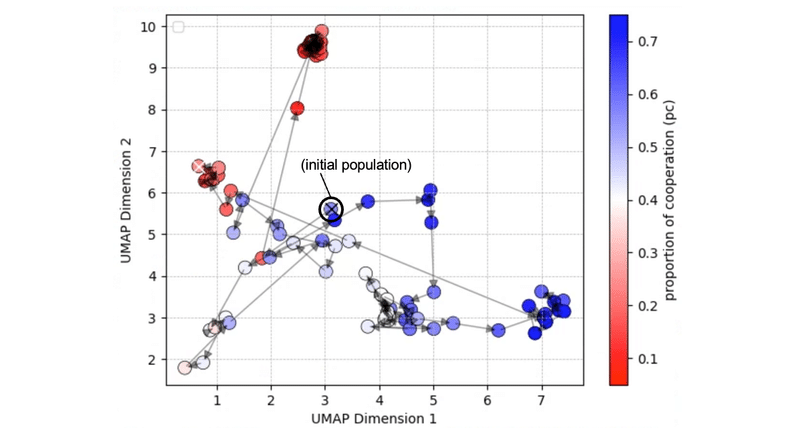

今回の実験では1000世代ですね。30体のAIエージェント集団の性格がどのように変化していくか、シミュレーションで見ていきました。2次元のグラフ上にプロットしていくと、かなりの変化がありました。予想していたよりダイナミックな変化で驚きましたね。

── 1000世代とはスゴイ数ですね!どのような変化があったのですか?

まず最初に、裏切りばっかりの社会に大きく変化するんです。でも少しずつ協力的な社会になって、これがしばらく続きます。ところが、突然変異で強固な利己主義者のようなのが出てきて、一瞬にして裏切り社会に取って代わられてしまう。押したり引いたりがあったんですよ。

── 人間社会でも、利己主義なリーダーで世界が一変することがありますね…。

そうですね。結果で興味深かったのが、AIエージェントの性格と行動が関わりあっていたことです。性格を表現する言葉に「gently(優しく)」を含むAIエージェントは、8割協力していました。逆に、裏切り合ってしまうことが多かったAIエージェントは、他を踏みつけたり無視する性格の記述が含まれていました。

── それはAIと協力していける未来を描ける一方で、AIに傷つけられたりする未来もあるのかと少し不安になってしまうのですが…。

性格のキーワードが、AIエージェントの行動を特徴づけるというのは、ひょっとして役に立つんじゃないかと僕は思っていて。例えば、協力関係を維持できるAIエージェントを設計したいときは、大規模言語モデルに「gently」というキーワードを含めて指示したらいい、といった知見が活かせるかもしれません。多様性が求められる社会で、人に貢献するAIエージェントはどんな特徴を持っているべきか、人はどんな風にAIエージェントに接するべきか、といったことへの教訓が得られるかもしれないなとも思います。

── ところで、どうやったらこのような面白い実験を思いつくのですか?

実は、今回使ったLlama2やChatGPTのような大規模言語モデルが「人の認知モデルとしてどのくらい能力を持つか」を調べる研究が注目され始めているんです。心理実験のようなものや、今回のようにゲームをさせるようなものもあります。今回は、それに進化を乗っけたんですね。僕たち人工生命の分野では、集団の進化を遺伝的アルゴリズムや進化計算で扱うわけですが、これに言語モデルを組み合わせるような研究はまだ新しいと思います。

── 大規模言語モデルの登場で、複雑で難しすぎたことができるようになったり、新しい発想で分野が拓かれていく可能性が生まれているのですね。おっと、壁の時計から鳥たちの鳴き声が♪♪今度は、ぜひ野鳥の研究のお話も聞かせてください。

インタビュー・文:丸山恵

◯関連リンク

プレスリリース「対話AIの性格特性の進化に成功!~AI集団が創る社会は協力的か利己的か?~」

論文(2024/3/19 国際科学誌『Scientific Reports』に掲載)

鈴木麗璽准教授(情報学研究科)

この記事が気に入ったらサポートをしてみませんか?