バーチャルプロダクションとは?その2全てはUnrealEngineに集約される。

前回でLED ICVFXっていうものがどんなものか雰囲気だけでも掴んでもらえたかと思います。

このInCameraVFXという技術。このシステムの基盤となっているアプリケーションがEpicGamesのUnrealEngineなのです。聞いたことある人も多いかと思いますがUNTYと並ぶ2大ゲームエンジンで同社の「フォートナイト」はもちろんのこと、「ファイナルファンタジー」「ドラゴンクエスト」「ストリートファイター」そして、なんと「電車でGO!!」みたいなものまで数限りない多くのゲームのプラットフォームになっています。

ゲームエンジンはリアルタイムレンダリングが基本です。

特に最近のゲームはフォトリアルな映画のような描写の作品が増えてきました。今まで実写のようなCGをレンダリングするのにはMAYAや3dsMAXなどのアプリケーションで膨大なマシンパワーと時間を必要としていました。

それがリアルタイムが基本のゲームエンジンを使用して緻密な描写できないものかという動きが数年前から起こり始めて、金字塔となっているのが2016にUNTYを用いて製作した「ADAM」です。これはのちに「第9地区」「チャッピー」などの監督、ニール・ブロムカンプによってEpisode2と3が作られ描写もストーリーも深みを増しています。

この当時のUNTYはショートフィルムに力を入れていましたが、今やバーチャルプロダクションとなるとUE4一色ですね。

最近、CGの名門WetaDigitalがUNITYに買収されたという発表がありました。 WetaDigitalと言えば映画「ロードオブザリング」などのCGでも有名です。UE4上で実写さながらのミーアキャットのドラマを描き出した衝撃が記憶に新しいですね。その技術がUNITY独占となれば実写の世界でも巻き返しを図ってるのは間違いないでしょう。

これが現在のゲームエンジンのリアルタイムレンダリングです。日本のゲームはフォトリアルなものは人気が出ないために、苦労してしてまで映画のような描写を求めることはなかなか無いですが、いつの間にか欧米のリアルな描写力ははるか先を行っていました。

ただし、それが人間となると、どうしてもCGだけでは描写できない壁があります。不気味の谷とか呼ばれている現象なんでしょう。

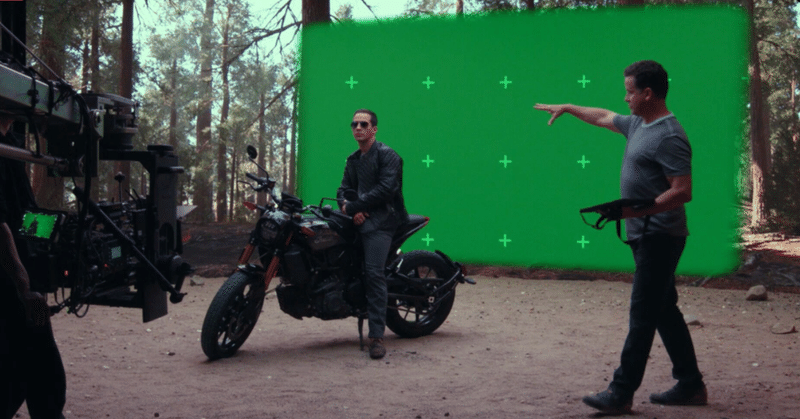

今まではグリーンバックで実写を撮影し、背景にマーカーを張ったり、カメラの3軸にセンサーを入れるなどして、カメラの動きをトレースして、それに合わせて後からCGを作成する。または、背景を事前に撮影して、それに合わせたカメラ位置と照明で人物を撮影する。といったような方法で撮影されることが殆どでした。

それがリアルタイムで実写さながらの映像が描写できるとなったらどうでしょう?

まずはグリーンバックを利用したInCameraVFXとして発展しました。UE4だけでも実現できますが、グリーンの抜きや使いやすさを考えるとZeroDensity社のRealityが性能では群を抜いています。

Realityを使って日活スタジオの4Stをグリーンバック専用スタジオとして使うバーチャルラインスタジオのデモ映像は分かりやすいですね。特に登山と渋谷のスクランブル交差点の映像は秀逸です。

しかし所詮グリーンバックになってしまうのか?と思う向きもあるでしょう。

自分も、車が自動運転になっているというのに、結局、雨が降るとワイパー動かしている、みたいな感覚で複雑な心持ちです。

そこで出てきたのが、このグリーンバックの部分をLEDディスプレイにしてしまおう!という大胆な発想です。

2019年末にディズニー+で配信されたスターウォーズスピンオフのドラマ「マンダロリアン」が世界の映像業界に衝撃を与えました。

直径23mの円周270度に高さ6m、天井までをもLEDで囲ったボリュームと呼ばれるスタジオで撮影された映像は全身メタリックのマンダロリアンをして、さながらロケのような雰囲気を醸し出していました。しかも、シーンの約50%以上をこのスタジオで撮影していると聞きます。

このマンダロリアンのケースは最上級のセッティングですが、それを最初に見せられてしまったがゆえに世界場が魅了されてしまったのでしょう。

古くはスクリーンプロセスなどグリーンバック以前からある手法なのですが、カメラの動きと同期することやLEDという発光体ゆえに照り返しまでリアルに見せられるという事で、いわゆるロケやセットなどのストレート撮影、グリーンバックなどの合成撮影に次ぐ、第三の撮影手法として注目を浴びています。

バーチャルプロダクション自体はEpicGamesのバーチャルプロダクションハブの「バーチャルプロダクション フィールドガイド」 に詳しいですね。ただ、1、2巻合わせて250pに及び、関係者のインタビューも多く、翻訳モノゆえの分かりづらさがあります。バーチャルプロダクション全般について書かれているのでLED ICVFXについては、その中の4割程度の記述になってしまいますが、このジャンルを勉強しようと思う人にとっては、まず読んでおいた方が良いでしょう。

こんな技術も時代的に複数のシステムがシンクロするように進化したおかげで実現できるようになりました。

まずは、PCのグラフィックボード(GPU)の進化とゲームエンジンなどの技術向上でリアルタイムレンダリングの品質がフォトリアルに近づいたこと。

そして、LEDの高精細化と低反射化も大きいです。「マンダロリアン」シーズン1は2.6㎜ピッチ、自分が撮影に使ったものは1.5㎜ピッチや1.9㎜ピッチ。どんどん高精細化が進んでいます。そして重要なのは低反射であること。照明を併用するLED ICVFXにとって光を受けることによって黒い部分の輝度が上がってしまうものでは使い物になりません。

最後にカメラトラッキングシステム。赤外線カメラを使ったもの、ステレオ魚眼カメラから画像認識するもの、カメラ位置のセンサーを周囲に配置された複数台のカメラで判断する方法など様々あります。

こんな複合的な要素の多いLED ICVFXですが、まずLEDから解説していきたいと思います。

続きは次回!!

この記事が気に入ったらサポートをしてみませんか?