FLUX.1のモデル紹介 [Aug 2024](更新終了)

※ Last update 8-31-2024

※ モデルが充実してきたのを見届け、更新を終了しました。

■ 概要

▼ はじめに

FP8、NF4、GGUF形式を中心に、FLUX.1モデルをピックアップして紹介しています。現状把握が目的なので、二週間足らずで更新を終了しました。LoRAは既に大量にあるので扱っていません。

FLUX.1関連の記事は、メニューよりどうぞ。

下記の記事も更新を終了しています。

■ モデルの探し方

各サービスにおいて、ログインしていないとダウンロードができない場合があります。

▼ Hugging Face

Hugging Faceは探しづらいので割愛します。Stable Diffusionの時もそうでしたが、モデルカードが空のことが多く、中身の分からないLoRAも大量にあるため、登録者名などを見て確認する候補を絞っていました。

https://huggingface.co/models?sort=modified&search=flux

▼ Civitai

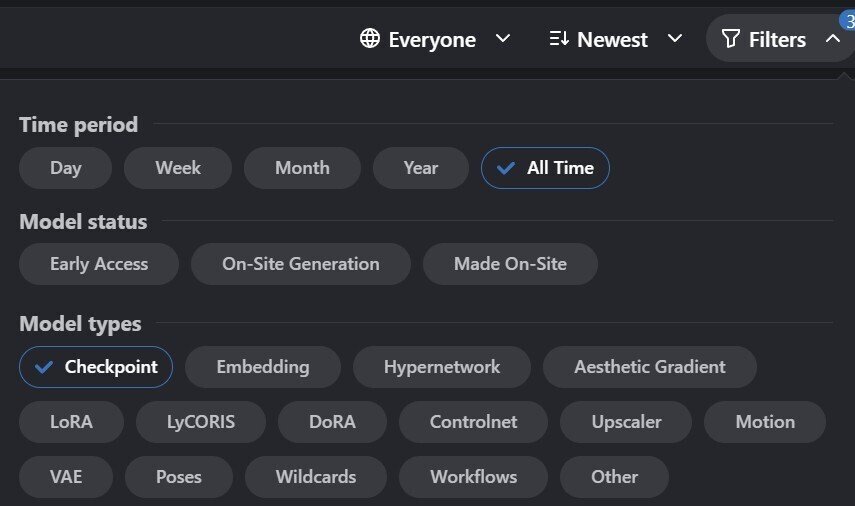

Civitaiは、モデルのページ(https://civitai.com/models)にアクセスして、右上を確認します。もし新着順に見たい場合は「Newest」に変更すると良いでしょう(二つ下の画像を参照)。

次に「Filters」を開き、下の方にある「Flux」を先に選択しておきます。選択の状態が変わるたびにリフレッシュされますが、あまり頻繁に切り替えるとエラーが発生するので、面倒でも一つずつ行うのが無難です。

モデルの場合は「Checkpoint」を選択します。選択しないと全てが表示されます。登録数は「LoRA」が圧倒的に多いので注意してください。

▼ Shakker

Shakker(https://www.shakker.ai/models)は、Civitaiほど登録数は多くありませんが、こちらにしか無いモデルもあります。アクセスするたびに絞り込みがクリアされてしまうのが、少し面倒かもしれません。

絞り込みの方法はCivitaiに似ているので難しくありません。最低でも「FLUX.1」「無料モデル」「ダウンロードを許可」を選択しておくと良いでしょう。

■ lora (for low steps generate)

▼ Hyper-SD // ByteDance

https://huggingface.co/ByteDance/Hyper-SD

Hyper-FLUX.1-dev-8steps-lora.safetensors

Hyper-FLUX.1-dev-16steps-lora.safetensors

■ trained model

▼ Fluximate // Aikimi

[NF4, GGUF(Q8) / unet]

https://civitai.com/models/674527

▼ Fluximation // Aikimi

[FP16, FP8, GGUF(Q8, Q4) / unet]

https://civitai.com/models/652994?modelVersionId=732130

▼ flux.1 dev modern anime // alfredplpl

[FP8 / unet]

https://huggingface.co/alfredplpl/flux.1-dev-modern-anime-fp8-comfyui

https://civitai.com/models/655376

▼ Modern Anime for FLUX.1 dev // alfredplpl

[FP16, GGUF(Q8, Q4) / unet]

https://huggingface.co/alfredplpl/flux.1-dev-modern-anime-full

▼ copycat-flux-test_FP8/FP16 // calculater

[FP16, FP8 / unet]

https://civitai.com/models/656083

■ merge model

▼ lyh_dalle_anime // lyh12169198

[FP8 / ckpt]

https://civitai.com/models/684646

(*) multiple styles available

▼ FLUX.1-dev-minus // blue.pen5805

[FP8, GGUF(Q8, Q4) / unet / low steps]

https://huggingface.co/bluepen5805/FLUX.1-dev-minus

▼ niji5,6 style // comer0987653734

[FP8 / unet]

https://civitai.com/models/684627

▼ Niji Style FLUX // Ai_Art_Vision

[FP8 / ckpt]

https://civitai.com/models/679033

▼ blue_pencil-flux1 // blue.pen5805

[FP16, FP8, GGUF(Q8, Q4) / ckpt, unet]

https://huggingface.co/bluepen5805/blue_pencil-flux1

▼ Nepotism FUX (DEV+SCHNELL) // BobsBlazed

[FP16, FP8 / ckpt, unet]

https://civitai.com/models/618792?modelVersionId=698731

(*) DiT = Diffusion Transformer (SD3 and FLUX.1 incorporates DiT)

▼ Flux-Fusion-DS-merge-gguf-nf4-fp4-fp8-fp16 // calculater

[FP16, FP8, FP4, NF4, GGUF(Q8, Q5, Q4) / ckpt, unet / low steps]

https://huggingface.co/Anibaaal/Flux-Fusion-DS-merge-gguf-nf4-fp4-fp8-fp16

https://civitai.com/models/630820

(*) AIO mean checkpoints

▼ Moxie Flux1 DS // moxie1776

[FP8 / ckpt / low steps]

https://civitai.com/models/629880

▼ Flux1_fp8_e4mefn_unets, flux1-nf4-weights // Silver Fritiofsson

[FP8 / unet]

https://huggingface.co/silveroxides/Flux1_fp8_e4mefn_unets

[NF4 / ckpt]

https://huggingface.co/silveroxides/flux1-nf4-weights

(*) bitte model works low steps

(*) except bnb model not work

■ base model (checkpoints, unet)

(*) Schnell model works low steps

▼ flux1-dev-bnb-nf4 // lllyasviel

[NF4 / ckpt]

https://huggingface.co/lllyasviel/flux1-dev-bnb-nf4

flux1-dev-bnb-nf4.safetensors (10.7GB)

flux1-dev-bnb-nf4-v2.safetensors (11.2GB) // recomended

▼ flux1-dev // Comfy Org

[FP8 / ckpt]

https://huggingface.co/Comfy-Org/flux1-dev

flux1-dev-fp8.safetensors (16.0GB)

▼ flux1-schnell // Comfy Org

[FP8 / ckpt]

https://huggingface.co/Comfy-Org/flux1-schnell

flux1-schnell-fp8.safetensors (16.0GB)

▼ flux1-nf4-unet // Silver Fritiofsson

[NF4 / unet]

https://huggingface.co/silveroxides/flux1-nf4-unet/tree/main

flux1-dev-nf4-unet.safetensors (5.7GB)

flux1-schnell-nf4-unet.safetensors (5.7GB)

▼ flux-fp8 // Jukka Seppänen

[FP8 / unet]

https://huggingface.co/Kijai/flux-fp8

flux1-dev-fp8-e4m3fn.safetensors (11.1GB)

flux1-dev-fp8-e5m2.safetensors (11.1GB)

flux1-schnell-fp8.safetensors (11.1GB)

▼ FLUX.1-dev-gguf // City

[F16, GGUF (Q8-Q2) / unet]

https://huggingface.co/city96/FLUX.1-dev-gguf

flux1-dev-F16.gguf (22.2GB)

flux1-dev-Q2_K.gguf (3.8GB)

flux1-dev-Q3_K_S.gguf (4.9GB)

~

flux1-schnell-Q5_1.gguf (8.4GB)

flux1-dev-Q6_K.gguf (9.2GB)

flux1-schnell-Q8_0.gguf (11.8GB)

▼ FLUX.1-schnell-gguf // City

[F16, GGUF (Q8-Q2) / unet]

https://huggingface.co/city96/FLUX.1-schnell-gguf

flux1-schnell-F16.gguf (22.1GB)

flux1-schnell-Q2_K.gguf (3.7GB)

flux1-schnell-Q3_K_S.gguf (4.9GB)

~

flux1-schnell-Q5_K_S.gguf (7.7GB)

flux1-schnell-Q6_K.gguf (9.2GB)

flux1-schnell-Q8_0.gguf (11.8GB)

■ base model (other, original)

▼ [vae]

https://huggingface.co/black-forest-labs/FLUX.1-dev

ae.safetensors (320MB)

▼ [clip]

https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main

clip_l.safetensors (235MB)

t5xxl_fp16.safetensors (9.1GB)

t5xxl_fp8_e4m3fn.safetensors (4.6GB)

▼ [FP16/unet]

https://huggingface.co/black-forest-labs/FLUX.1-dev

flux1-dev.safetensors (22.1GB)

https://huggingface.co/black-forest-labs/FLUX.1-schnell

flux1-schnell.safetensors (22.1GB)

■ おまけ

本記事に掲載した画像のプロンプトは全て同一です。表紙の画面に映っている画像は、「flux1-dev-fp8.safetensors (unet)」を用いて生成しました。

同じプロンプトを用いて、XのGrokで生成しました。

■ その他

私が書いた他の記事は、メニューよりたどってください。

noteのアカウントはメインの@Mayu_Hiraizumiに紐付けていますが、記事に関することはサブアカウントの@riddi0908までお願いします。

この記事が気に入ったらサポートをしてみませんか?