アニメーションの作り方 / Stable Diffusion

Mov2MovとControlNetを使ってアニメーションを制作する方法のメモ。

『mov2mov』は、既存の動画からAI動画を生成できる技術のこと。

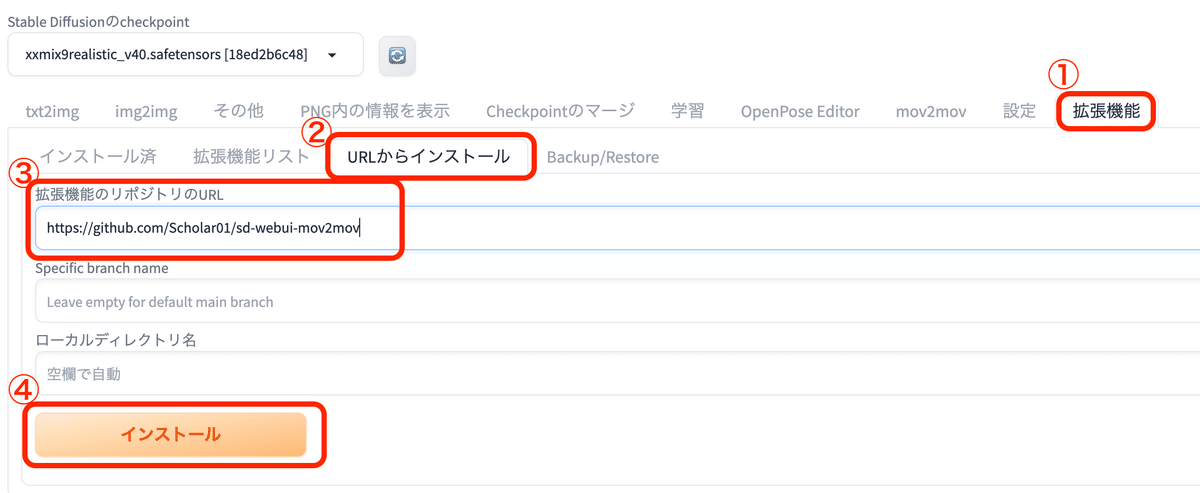

Mov2Movのインストール方法

拡張機能 → URLからインストール → 拡張機能のリポジトリのURLに、

https://github.com/Scholar01/sd-webui-mov2movを入力して、インストールボタンを押す。

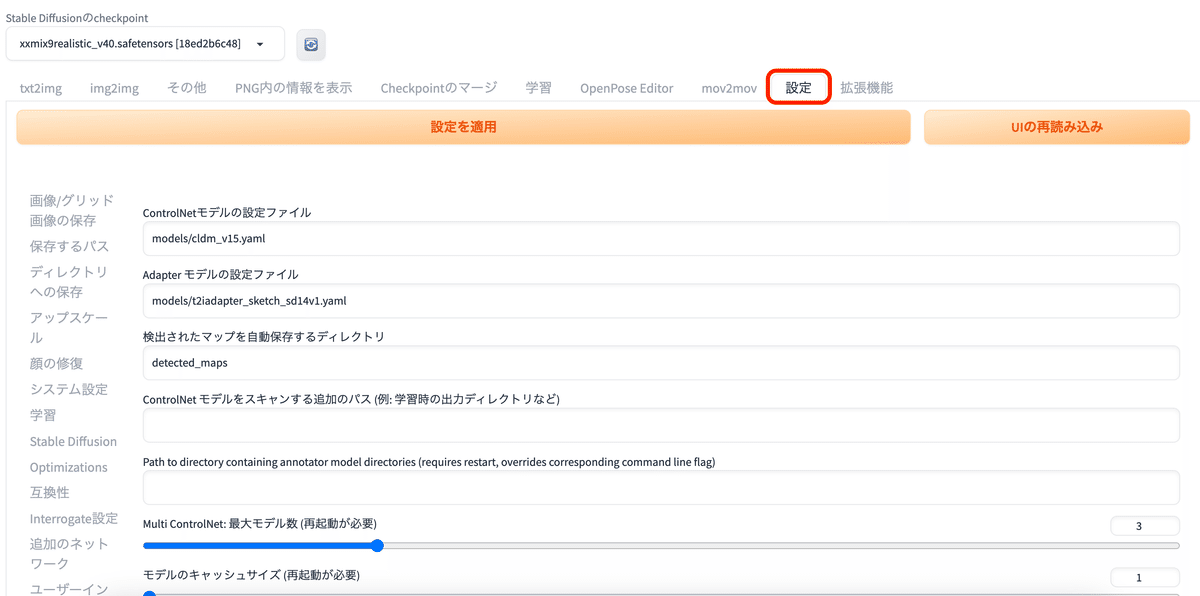

設定タブをクリック

左側メニューからControlnetをクリックし、「他のスクリプトにこの拡張機能の操作を許可する」にチェックを入れる。

「設定を適用」をクリックしてから「UIの再度読み込み」をする。

これで設定が完了。

アニメーションを作る流れ

1、動画を用意する

生成に時間がかかるため、まずは10秒程度の動画がおすすめ。

フリー素材か自分で撮影した動画を使うことを推奨。

2、mov2movで設定を行う

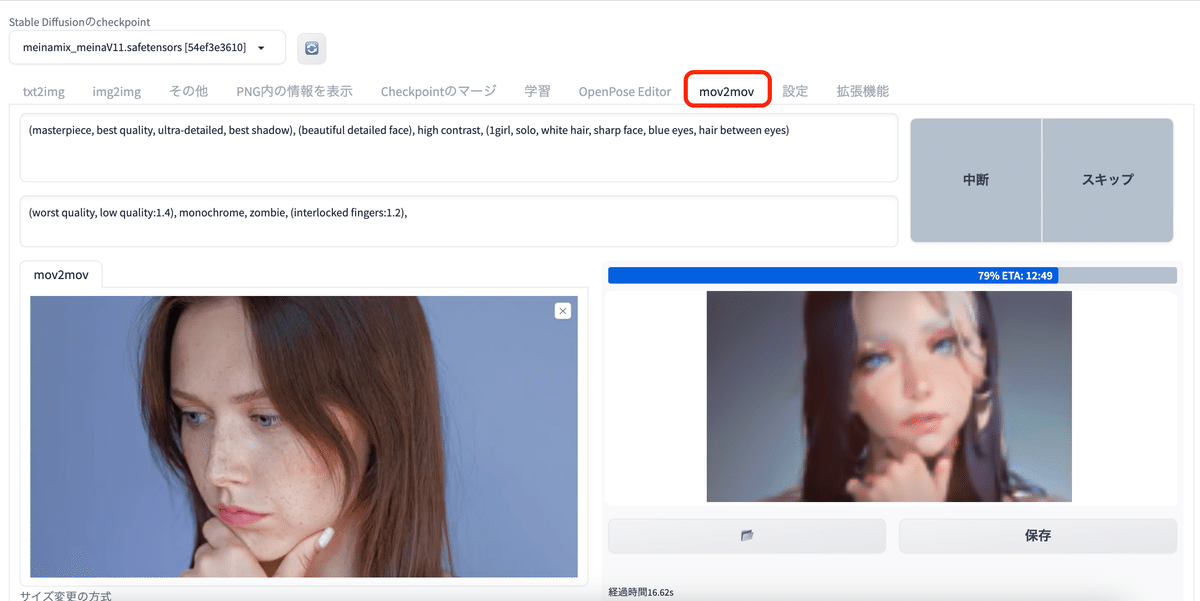

上部タブの「mov2mov」をクリック

動画をアップロードする

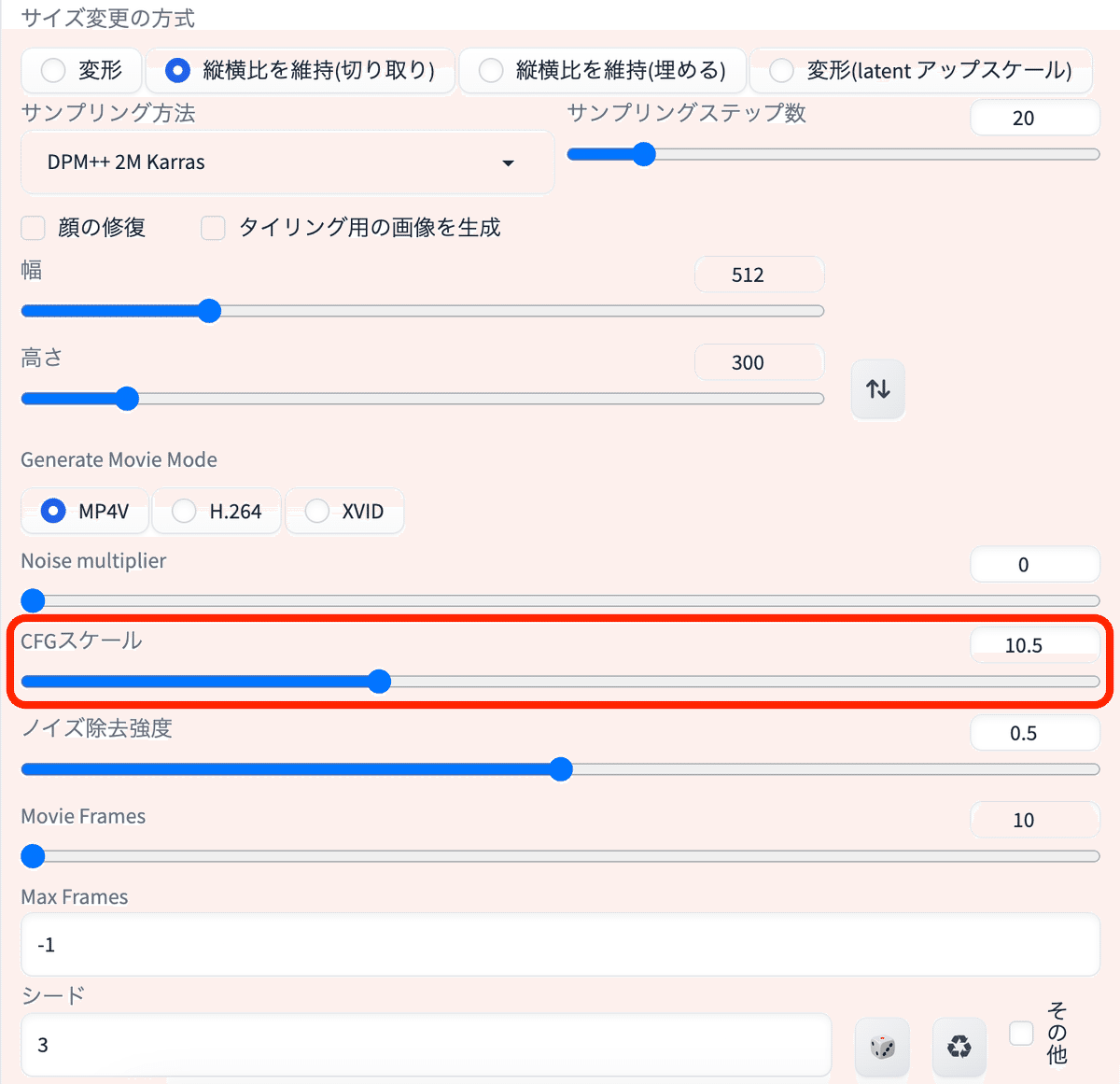

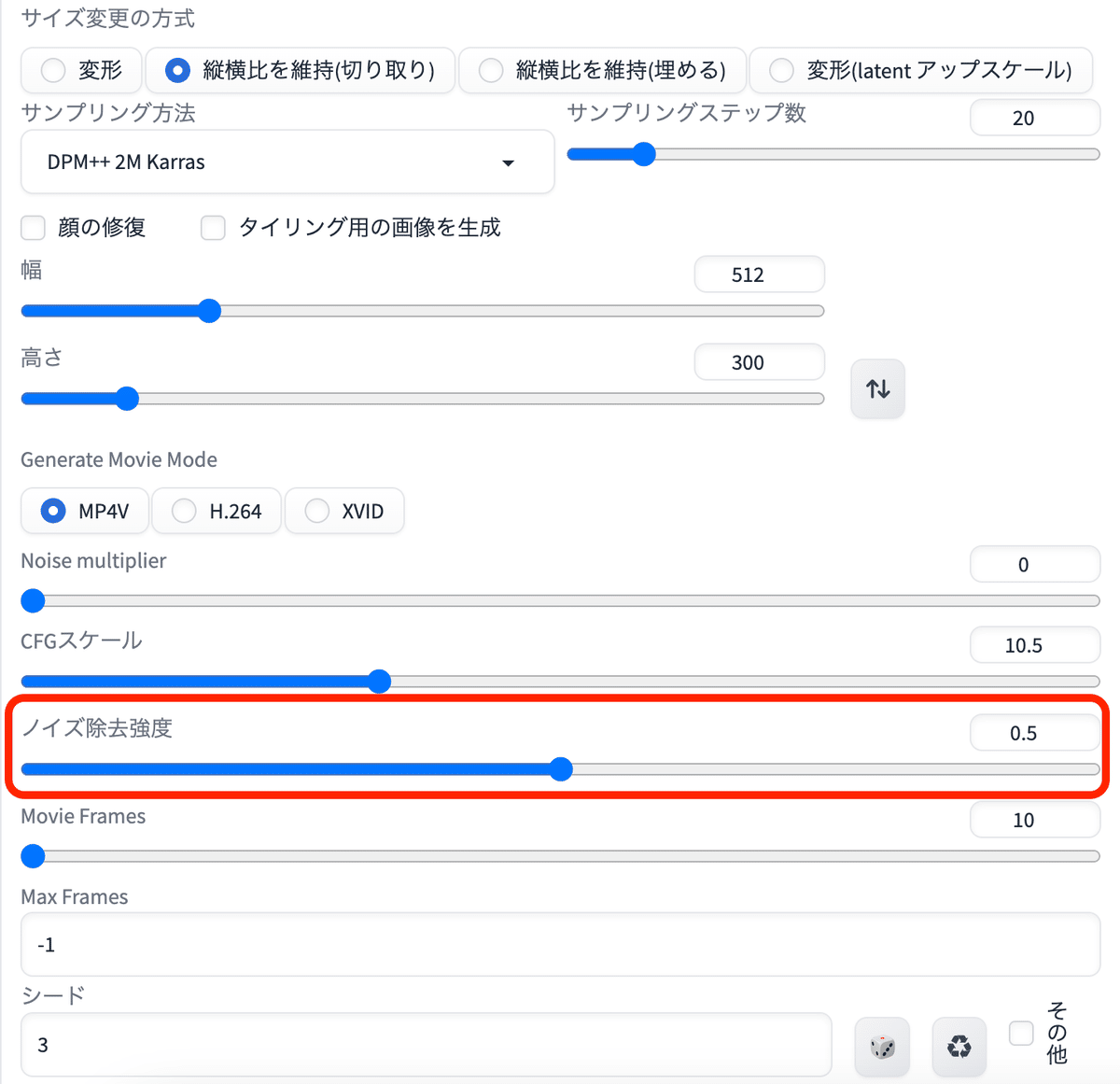

縦横比を維持(切り取り)にチェックを入れる。

「Generate Movie Mode」の形式はMP4Vが一番容量が軽くおすすめ。

サイズを調整する。サイズが大きくなるほど生成にも時間がかかってしまうので注意する。

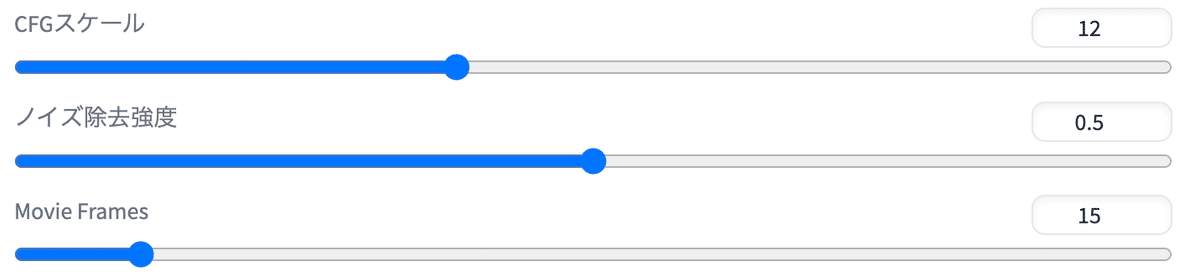

CFGスケールは10〜12あたり推奨。

CFGスケールは、イラストをどれだけプロンプト通りに従わせるかの数値。

数値が高いほど、プロンプトの指示通りのイラストが生成される。

数値が低いほど、プロントの指示を無視したイラストが生成される。

ノイズ除去強度は、数値を下げるほど元動画を忠実に再現してくれる。

元動画からあまり変化を与えたくない場合は、0.2〜0.3が綺麗に仕上がる。

人物からイラストなど変化を与える場合は0.4~0.5あたり推奨。

Movie Framesは動画のフレームレートのこと。

数値を高くするほど滑らかで綺麗な動画が生成できる。

はじめは10あたりがおすすめで、数値を高くするほど生成に時間がかかる。

3、ControlNetで設定を行う

①「ControlNet Unit0」のタブをクリック

②有効化にチェックを入れる

③SoftEdgeを選択する

プリプロセッサ:softedge_hed

モデル:control_v11p_sd15_softedge

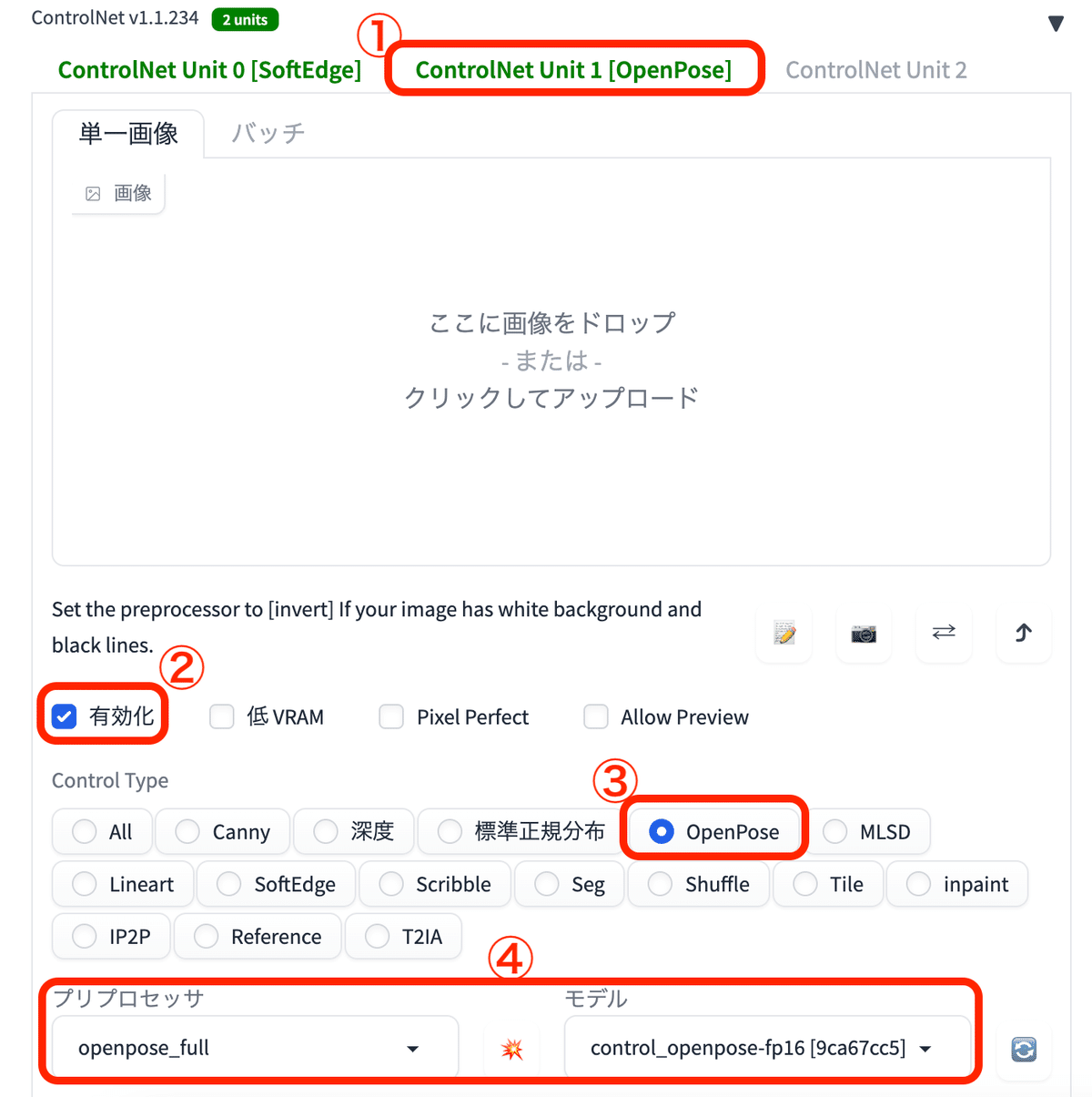

①「ControlNet Unit1」のタブをクリック

②有効化にチェックを入れる

③OpenPoseを選択する

プリプロセッサ:openpose_full

モデル:control_openpose-fp16

SoftEdgeにした理由は、他のモデルに比べて元動画をより忠実に再現してくれるため。

生成ボタンを押すと、動画の生成が開始される。

▼ 動画の保存場所

/stable-diffusion-webui/outputs/mov2mov-videos

4、生成結果

踊りの生成結果↓

設定は以下で出力している。

顔だけの生成結果↓

動画によっては顔が上手く出力できず調整が必要な場合も。↓

元動画のサイズが小さい&顔が遠いと出力の難易度が上がってしまうので、元動画は画質が鮮明な方が良い。

おまけ:Dynamic Thresholdingを使ってより綺麗に仕上げる

Stable DiffusionではCFGスケールが「7」が基準値であり、数値を上げると崩れてしまう場合がある。

そんな時にDynamic Thresholdingの拡張機能を使うと、CFGスケールの数値を上げても綺麗に仕上げてくれる。

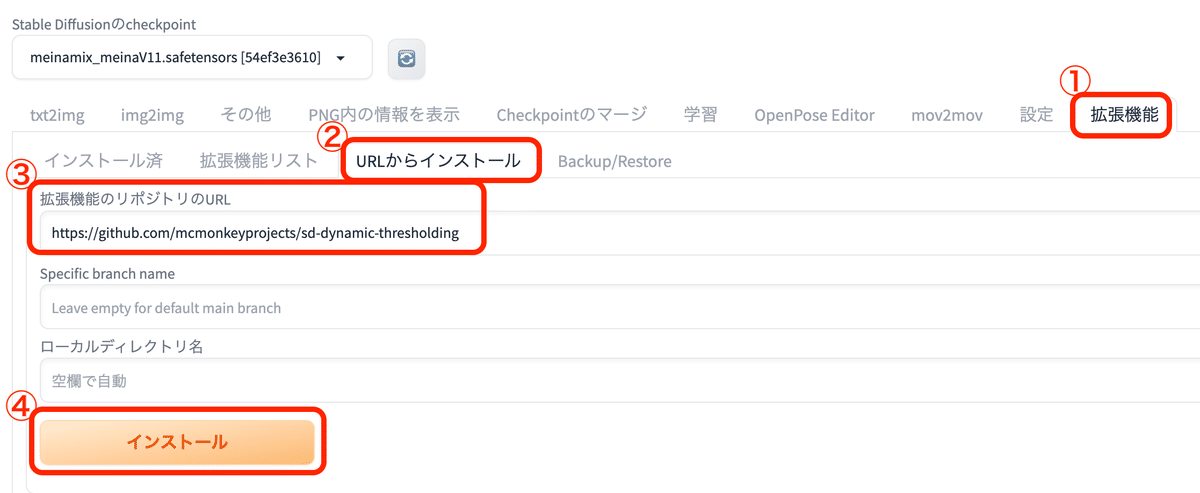

インストール方法

拡張機能 → URLからインストール → 拡張機能のリポジトリのURLに、

https://github.com/mcmonkeyprojects/sd-dynamic-thresholdingを入力したらインストールをクリック。

Enable Dynamic Thresholding (CFG Scale Fix)にチェックを入れて、

CFGスケールの数値を調整する。

これで動画を生成するとより綺麗に仕上がる。

この記事が気に入ったらサポートをしてみませんか?