【動画レポ】Bedrock Claude Night 2(JAWS-UG AI/ML支部 × 東京支部コラボ)

今回は2024年6月18日にAWS startup! loftにて開催されたClaudを擁するAnthropicさんが来日したのを受けて開催されたJAWS-UG東京支部とAI/ML支部の合同イベント「Bedrock Claude Night 2」のアーカイブ動画からレポートします。

オープニング

オープニングはシンプルに、まずJAWS-UGのコミュニティの紹介からルール、そしてAI/ML支部、東京支部についての案内が簡単にされました。

アウトプットのお願いや懇親会の案内などもサクサクと進められ、メインのAnthropicさんのキーノートに入ります。

Anthropic キーノート&デモ:Maggie Vo & Alex Albert (Anthropic)

AnthropicさんのキーノートはAnthropic技術・教育責任者のMaggie Voさんのセッションから始まりました。まずはClaude 3について画像認識とツールユースの点を中心に紹介されました。

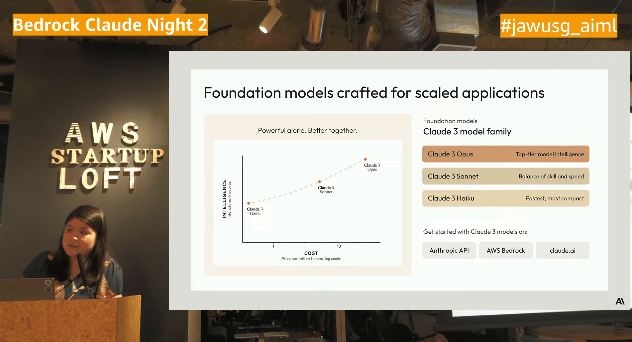

Claude 3について

Claude3のモデルファミリーは「Opus」「Sonet」「Haiku」の3つがあり、Opus:機能的に一番揃っているモデル

Sonet:中間的でバランスが取れている

Haiku:コンパクトで最も速い

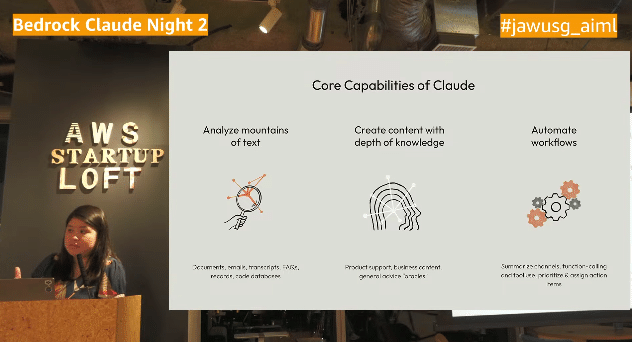

Claudeの出来ること

・分析機能:3つのモデルともにハイレベルな分析機能をもっている

・コンテンツ生成:マーケティングのコピーやビジネスコンテンツを生成

・ワークフローの自動化:ツールでE2Eのオートメーションを実現

〜ますますビジネスにおいて重要な価値を有する

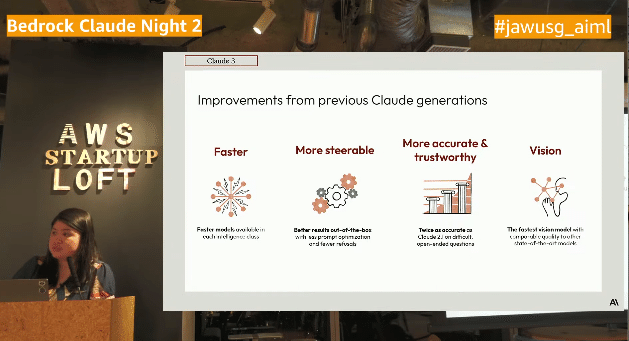

以前のモデルと比較した改善点

・スピードの向上

・少ないプロンプトで多くが可能になる

・精度・信頼性がが高い、モデルの透明性が高くハルシネーションが少ない

・全てのモデルで画像認識が出来るようになった

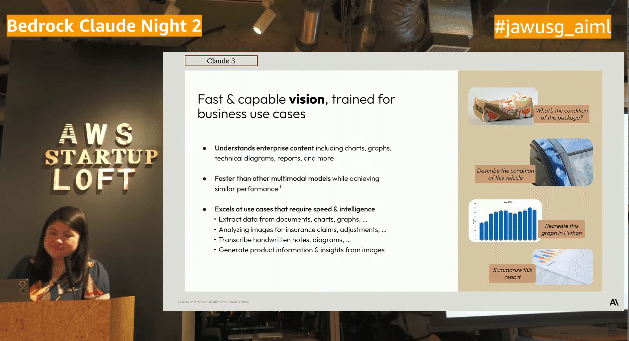

画像認識の紹介

・グラフなどのビジネスユースケース用にトレーニングされたモデル

・手書き文字も認識する。日本語に関してはAWSからフィードバック

乱暴に書かれた文字文字認識、難しい漢字などはこれからの課題

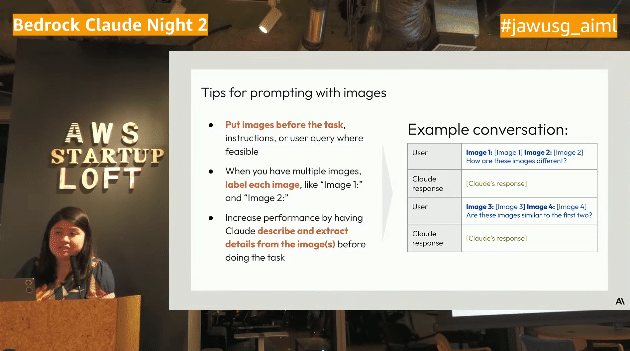

画像認識の際のTips

・まずは画像イメージを最初に置く

・ラベリングを各イメージに対して行う

・イメージに中の情報の抽出

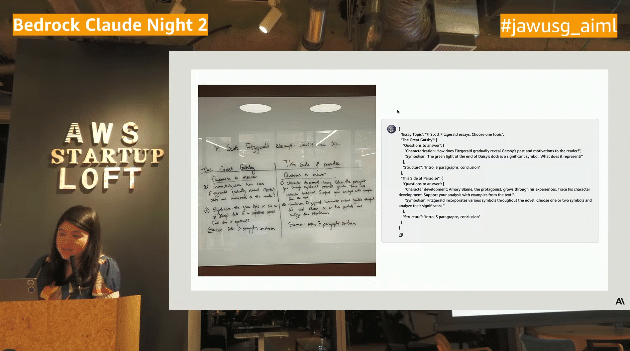

ここから読みにくいドキュメントに対しClaude 3 Haikuがいかに速く処理ができるのかを紹介する動画の紹介になりました。

実際に行った検証で光が反射して読みにくいホワイトボードからも適切に処理(JSONスキーマへの出力)され、得られた情報からさらに必要な情報を出力されるという前例のないような機能や性能が紹介されました。

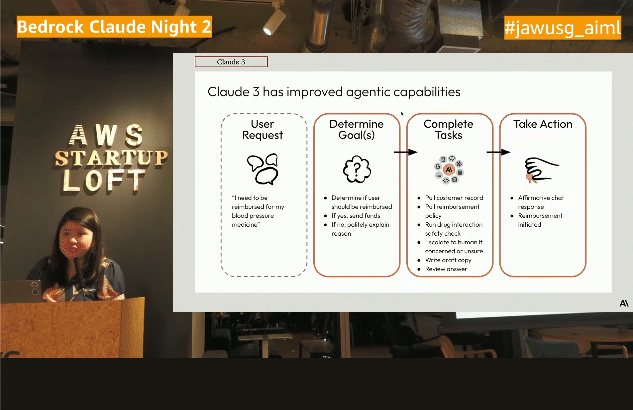

Agents + tool use

Claude 3はAgent機能を改善しています

・ユーザーリクエストが何なのか、ユーザーのゴールを特定する

・タスクを次々に完了させていく

・完了するのか、それ以外の方法で支援できるかを判断

・ConpleteTaskに様々なTool useを使うタスクの例が載っている

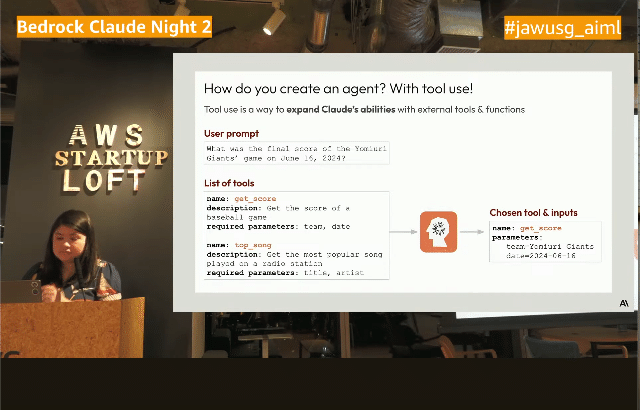

Tool use

・tool useを使えばAgentsのワークフローを作れる

・とてもシンプルなもの

プロンプトへの質問⇒toolesのリスト

・古い学習のClaudeに対して情報のアップデートが出来る

tool useを使うために何をしないといけないのか?

例)在庫をチェックする / 請求書を作成 / メールを送る

・ユーザーが実行するツールを作成できる

・Claude内の簡単なツールだけではなく適切な外部ツールも選べる

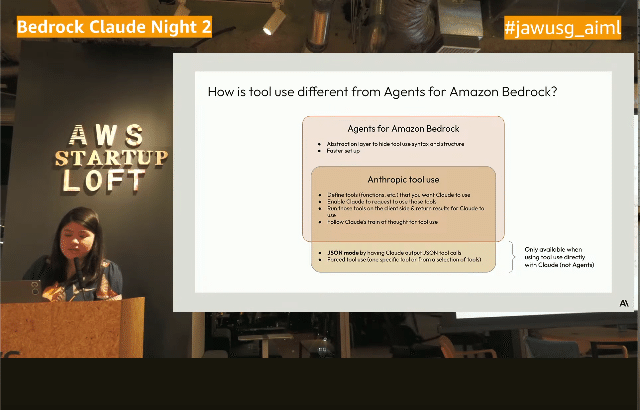

Amazon Bedrockのtoolとの違い

・すべてのJSONmodeを使用することが出来る

・絶対にtoolを使わないといけない強制モードの設定

・すべてのステップが可視化されてみることが出来る

逆にBedrockではTool useが見えないアブストラクションレイヤーがある

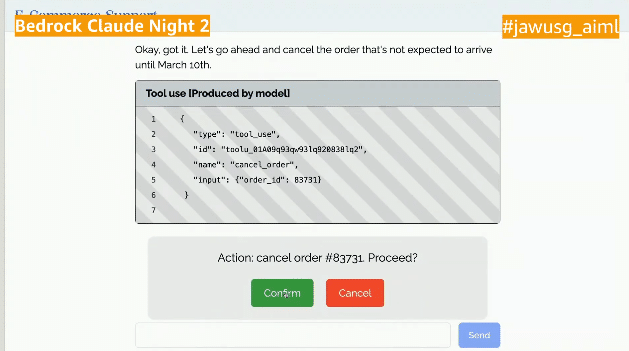

Claude 3 tool use(カスタマサポートの例)

ここからデモに入ります。ユースケースにあわせてコードの内容が作用解されます

最初のデモの内容はオンラインショッピングのカスタマーサポートの例です。お客様のIDから最近の注文の履歴を参照し確認してキャンセルするまでの例が紹介されました。

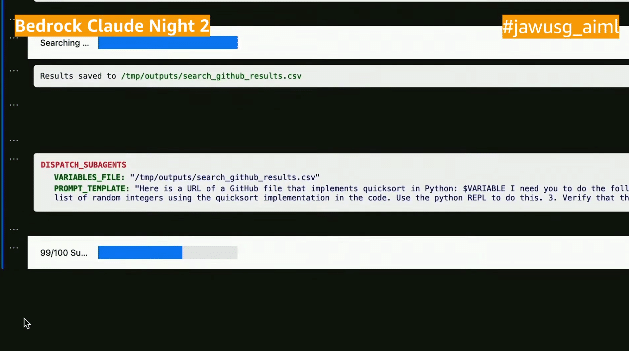

次はHaikuのオーケストレーション機能を使用して最も速い検索のアルゴリズムを見つけるプロセスの紹介です。OpusとHaikuを連携して高度なタスクを行うデモが紹介されました。複数の結果を集めて

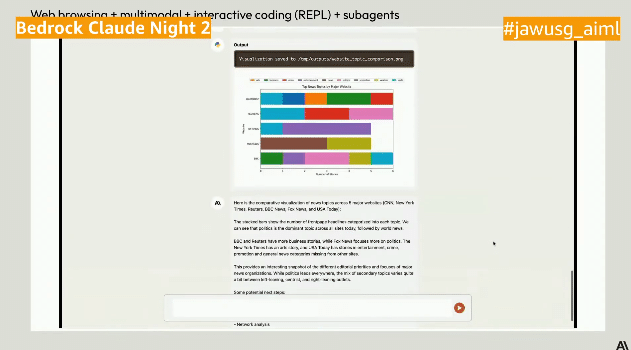

最後のデモでは画像認識でも同様のことをやってみました。ニュースサイトのスクリーンショットを取得してデータの抽出・可視化、分析コメント追加を複数のサイトに対して並列処理させました。

自分で犯した間違いを自分で理解して自分で修正するのがすごいです。

<資料です>

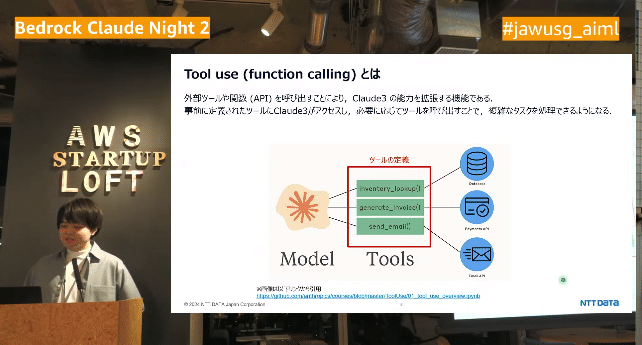

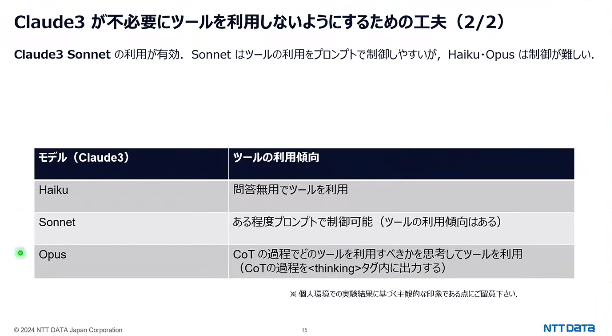

Claude3 on Bedrock(with Converse API + Tool use)でチャットアプリを作成してみた:鯨田 連也(NTT Data)さん

LTのトップバッターはNTTデータの鯨田さん。Claude3 on BedrockとConverse API 、tool useを使ってチャットアプリを作成したお話です。

従来のInvokeModel APIのときと異なりConverse APIではモデルごとに推論パラメータが異なったりせず、差分はモデルIDのみでスマートにコーディングができます。

またTool useは外部ツールやAPIを呼び出すことでCloud 3を拡張する機能でツールを呼び出すことで複雑な処理の実行ができます。

つくったものは会話中にモデルや推論パラメーターを変更可能なものですが構築の中での注意点などがいくつか詳細に紹介されました。Claude3の3つのモデルの傾向も紹介されています。

<資料です>

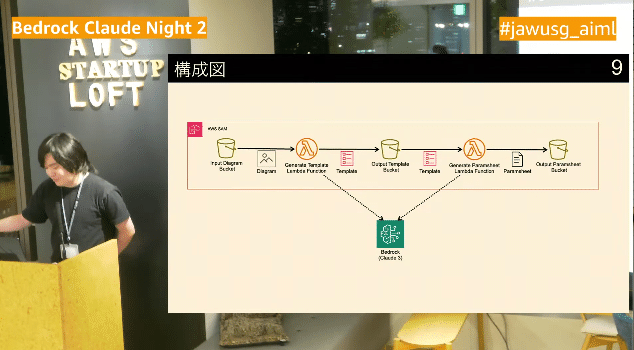

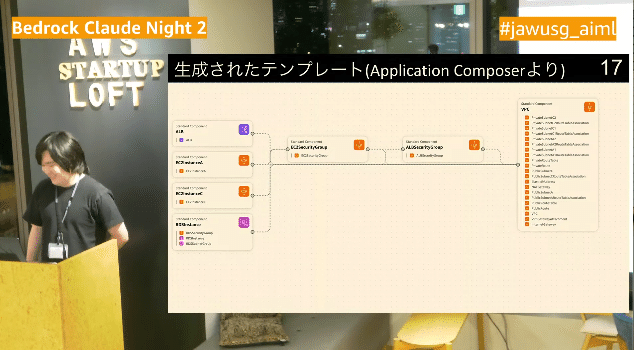

AWS構成図からCloudFormationとパラメータシートを自動生成するシステムを作ってみた:つくぼし(クラスメソッド株式会社)

次のLTはクラスメソッドのつくぼしさん。テーマはClaudeClaudeを使ってAWS構成図からCloudeformationのテンプレートとパラメーターシートを作らせてみた話です。

最大トークン数を考慮して分割したり、適切なリソースタイプをつかわせる、そしてYAMLの内容のみt¥正しく抽出する・・・・などなどの課題を解決して正しくテンプレートが作成されるようにしました。

実際に作ってみると概ね成功しましたが、テンプレートやパラメーターシートは90%以上の正確性を求めるのはかなり厳しそうで、現時点では人の代替までのレベルは厳しそうとのことでした。

<資料です>

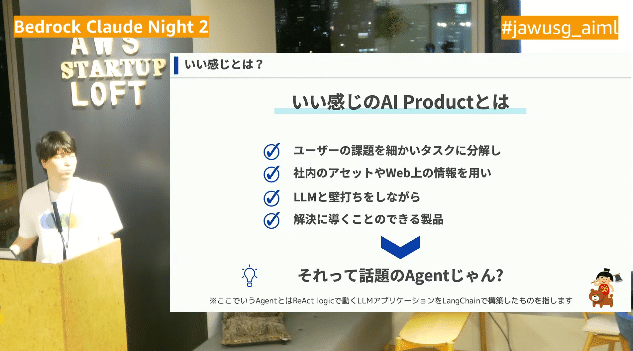

Agentは楽しいぞ:大坪 悠(KDDIアジャイル開発センター)

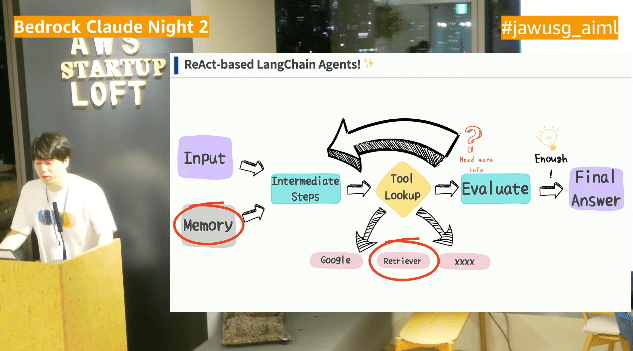

次はKDDIアジャイル開発センターの大坪さん。上司が言ってくる「いい感じのAIプロダクトを作ってよ」と言われてBedrockを使ってLangChain Agent with Retrieveを実装してみた話です。

本当にほしいAgentと考えた結果RetrieverとMemoryがあってこそと考え、構成を考えました。

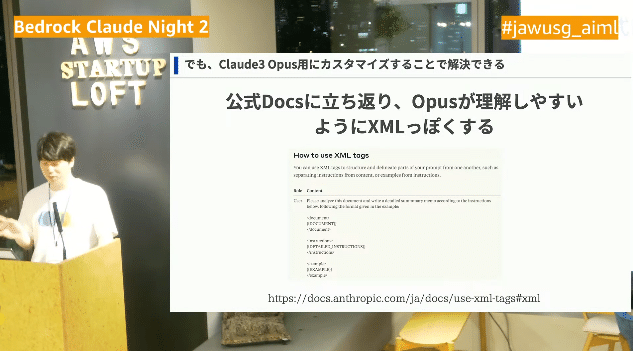

実際に作るとそれぞれ課題はあるもののLang Chainで要されているものも多く思ったよりも簡単のできたそうです。その課題とその解決について詳細に解説されました。

公式ドキュメントに立ち返ることが大事だそうです。

<資料です>

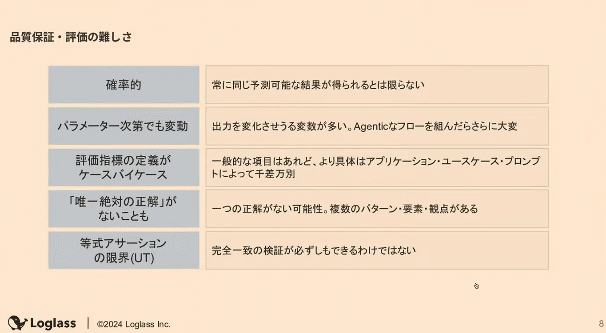

AWS BedrockでLLMOps / 評価をどう行うのか?:加賀谷 諒(株式会社ログラス)

最後のLTはログラスで生成AIのアプリエンジニアであるの加賀谷さんです。テーマはAmazon Bedrockのモデル評価機能についての紹介です。

生成AIの品質評価はなかなか難しいもので、実装前のオフライン評価でも評価は限界があり実際は稼働後実業務に即したフィードバックオンライン評価となったりなかなか標準的なものにはなりませんし、文書の自然さなどは定量的な評価軸にしづらいなどの課題があります。

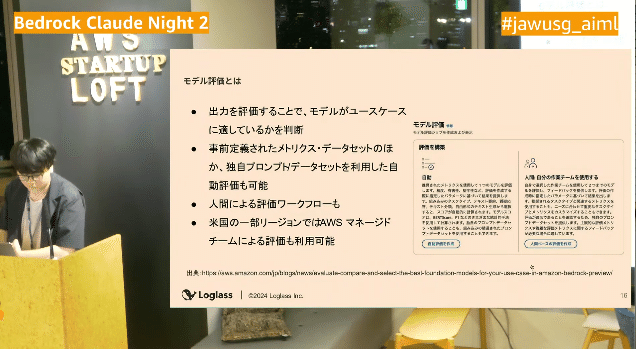

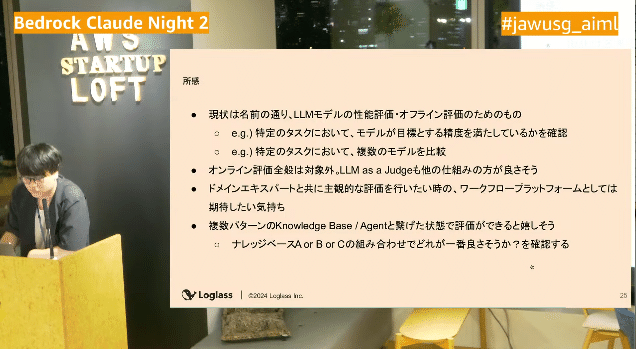

ここでAmazon Bedrockにモデル評価機能がGAされましたが、この機能を深堀りしていきます。人間によるモデル評価などもありますが自動評価も用意されています。

自動評価もありますが現状のところLLMモデルの事前評価(オフライン評価)のためのものであって実際の実務上の評価(オンライン評価)はまだ厳しそうということでした。

<資料です>

インタラクティブセッション

ここからインタラクティブセッションに入ります。会場からのAnthropicさんに対する質問コーナーとなりました。さらなるマルチモーダル化や最近のAI活用が活発な業界などの話がされました。カスタマーサポート、ソフトウケアエンジニアリング、ファイナンス、ヘルスケアなどの領域で生成AIは活発に活用されているそうです。

クロージング

ここまででイベントは終了です。最後にベストツイートということで「Amazon Bedrock 生成アプリ開発入門(AWS深堀りガイド)」が進呈されていました。

次回は大阪で7/30日の予定だそうです

<他の方々のレポートです>

<togetterです>

いいなと思ったら応援しよう!