OpenAIの新AIモデル「OpenAI o1」の概要、使い方、評価、安全性などについて詳しく解説

(公式サイトの内容を翻訳してまとめました。)

私たちは、応答する前により多くの時間をかけて考えるよう設計された新しいAIモデルシリーズを開発しました。以下は、最新のo1研究、製品、およびその他の更新に関するニュースです。

https://openai.com/o1/

1.OpenAI o1-previewの紹介

https://openai.com/index/introducing-openai-o1-preview/

困難な問題を解決するための新しい推論モデルシリーズ。9月12日から利用可能。

私たちは、応答する前により多くの時間をかけて考えるよう設計された新しいAIモデルシリーズを開発しました。このモデルは、複雑なタスクを論理的に処理し、従来のモデルよりも科学、コーディング、数学における難しい問題を解決することができます。

本日、このシリーズの最初のモデルをChatGPTおよびAPIで公開します。これはプレビュー版であり、今後定期的に更新や改善が行われる予定です。このリリースに合わせて、現在開発中の次回更新に向けた評価も提供します。

(1) 仕組み

私たちはこれらのモデルを、応答する前に問題をじっくり考えるように訓練しました。これは人間が行う思考プロセスに似ています。トレーニングを通じて、モデルは思考プロセスを洗練させ、異なる戦略を試し、誤りを認識することを学びます。

テストでは、次回モデルの更新は物理学、化学、生物学の難しいベンチマーク課題で博士課程の学生と同等の成果を出しています。また、数学とコーディングにも優れていることが判明しました。国際数学オリンピック(IMO)の予選では、GPT-4oが正解した問題は13%でしたが、推論モデルは83%の正解率を記録しました。コーディング能力もコンテストで評価され、Codeforcesの競技では89パーセンタイルに達しました。詳細は技術的な研究記事でご覧いただけます。

この初期モデルには、ウェブを検索して情報を収集したり、ファイルや画像をアップロードしたりするなど、ChatGPTの便利な機能はまだ備わっていません。多くの一般的なケースでは、GPT-4oが短期間でより優れたパフォーマンスを発揮します。

しかし、複雑な推論タスクにおいては、これは大きな進展であり、AIの能力における新たなレベルを示しています。このため、カウンターを1にリセットし、このシリーズを「OpenAI o1」と名付けます。

(2) 安全性

これらの新しいモデルの開発にあたり、推論能力を活かして安全性と整合性ガイドラインに従うための新しい安全性トレーニングアプローチを考案しました。安全ルールを文脈に応じて推論できることで、より効果的に適用できるようになります。

安全性を測る方法の一つとして、ユーザーが安全ルールを回避しようとする(いわゆる「ジェイルブレイク」)際に、モデルがどの程度安全ルールに従い続けるかをテストしています。最も難しいジェイルブレイクテストの一つでは、GPT-4oが22(0~100のスケール)だったのに対し、o1-previewモデルは84を記録しました。詳細はシステムカードや研究記事でご覧いただけます。

これらのモデルの新しい能力に合わせて、安全性の強化、内部ガバナンス、連邦政府との協力を強化しました。これには、Preparedness Framework(新しいウィンドウで開く)を使用した厳格なテストと評価、最先端のレッドチーミング、安全・セキュリティ委員会による理事会レベルの審査プロセスが含まれます。

AIの安全性へのコミットメントを進めるため、米国および英国のAI安全性研究所と正式な合意を最近締結しました。この合意に基づき、これらの研究所にこのモデルの研究版への早期アクセスを許可し、すでに運用を開始しています。この取り組みは、今後のモデルの公開前後に行われる研究、評価、テストのプロセスを確立するための重要な第一歩となりました。

(3) 対象者

これらの強化された推論能力は、科学、コーディング、数学などの分野で複雑な問題に取り組んでいる方に特に役立つかもしれません。例えば、o1は、医療研究者が細胞のシーケンシングデータに注釈を付けたり、物理学者が量子光学に必要な複雑な数学的方程式を生成したり、あらゆる分野の開発者が多段階ワークフローを構築して実行するのに利用できます。

(4) OpenAI o1-mini

o1シリーズは、複雑なコードの生成やデバッグにおいて優れた性能を発揮します。開発者向けに、より効率的なソリューションを提供するため、より高速かつ低コストな推論モデル「OpenAI o1-mini」をリリースします。o1-miniは小型モデルであり、o1-previewよりも80%低コストで、広範な知識を必要としない推論が求められるアプリケーションにおいて、非常に効果的でコストパフォーマンスに優れたモデルです。

(5) OpenAI o1の使い方

ChatGPT PlusおよびTeamのユーザーは、本日からChatGPT内でo1モデルにアクセスできるようになります。o1-previewとo1-miniのどちらも、モデル選択画面で手動で選択可能で、リリース時の制限として、o1-previewでは週30メッセージ、o1-miniでは週50メッセージの上限が設定されています。これらの制限を増やすことや、ChatGPTが自動的に適切なモデルを選択できるようにする作業も進めています。

ChatGPT EnterpriseおよびEduのユーザーは、来週から両方のモデルにアクセスできるようになります。

API使用レベル5に該当する開発者は、今日からAPIで両方のモデルを使用してプロトタイピングを開始でき、1分あたり20リクエストの制限があります。追加のテスト後にこの制限を引き上げる予定です。現在、これらのモデルのAPIは、関数呼び出し、ストリーミング、システムメッセージのサポートなどの機能を含んでいません。始めるには、APIドキュメントを確認してください。

また、o1-miniへのアクセスをすべてのChatGPT Freeユーザーにも提供する計画があります。

(6) 今後の予定

これは、ChatGPTとAPIでのこれらの推論モデルの早期プレビューです。モデルの更新に加えて、ブラウジング、ファイルや画像のアップロードなど、より多くの機能を追加して、より多くの人にとって便利にする予定です。

また、GPTシリーズのモデルに加えて、新しいOpenAI o1シリーズの開発およびリリースも継続して行っていく予定です。

2.大規模言語モデルを使った推論の学習

https://openai.com/index/learning-to-reason-with-llms/

私たちは、複雑な推論を行うために強化学習で訓練された新しい大規模言語モデル「OpenAI o1」を発表します。o1は応答する前に考え、内部で長い思考の連鎖を生成してからユーザーに応答します。

(1) 概要

OpenAI o1は、競技プログラミングの問題(Codeforces)で89パーセンタイルにランクインし、米国数学オリンピック予選(AIME)では米国トップ500の学生に相当する成績を収め、物理学、生物学、化学の問題(GPQA)のベンチマークにおいて、人間の博士課程レベルの精度を上回っています。この新しいモデルを現在のモデルのように使いやすくするための作業はまだ進行中ですが、私たちはこのモデルの初期バージョンである「OpenAI o1-preview」を、ChatGPTおよび信頼できるAPIユーザー向けに即時利用可能な形でリリースします。

私たちの大規模な強化学習アルゴリズムは、モデルが「思考の連鎖」を使って生産的に考える方法を、非常にデータ効率の良いトレーニングプロセスで教えます。強化学習(トレーニング時の計算量)や、思考にかける時間(テスト時の計算量)が増えるにつれて、o1のパフォーマンスが一貫して向上することがわかりました。このアプローチのスケーリングに関する制約は、LLMの事前学習の制約とは大きく異なっており、引き続き調査を進めています。

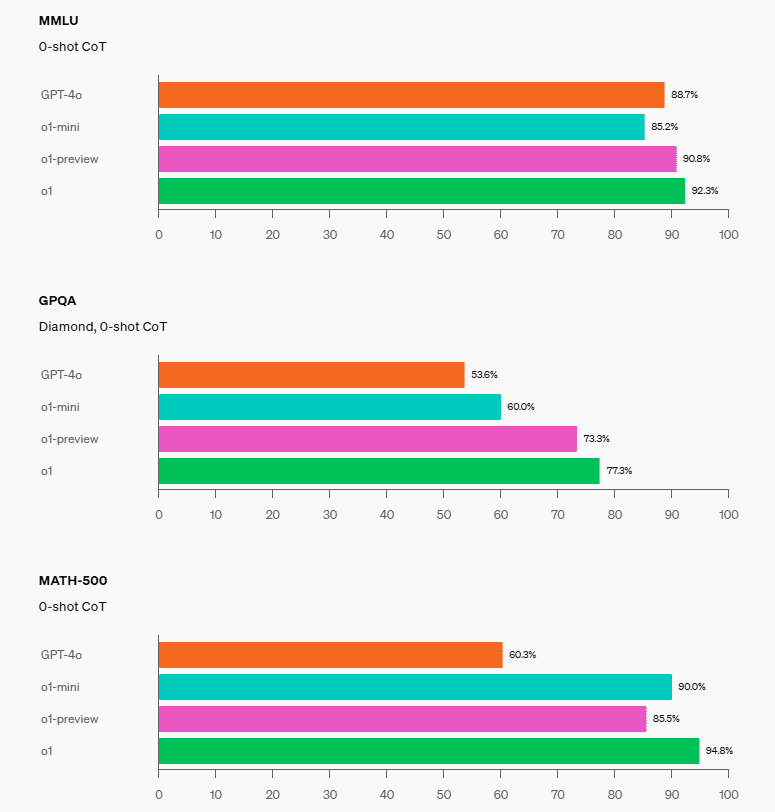

(2) 評価

GPT-4oに対する推論能力の向上を強調するために、私たちは人間の試験や機械学習ベンチマークの多様なセットでモデルをテストしました。その結果、o1はこれらの推論を多く要するタスクの大多数において、GPT-4oを大幅に上回ることが示されました。特に記載がない限り、o1は最大のテスト時の計算設定で評価されました。

多くの推論を要するベンチマークにおいて、o1は人間の専門家に匹敵するパフォーマンスを発揮しています。最近の最先端モデルは、MATHやGSM8Kで非常に優れた成績を収めており、これらのベンチマークではもはやモデル間の差異を十分に示すことができません。そこで、私たちはアメリカの最優秀な高校生を対象とした数学試験であるAIMEで数学の性能を評価しました。2024年のAIME試験では、GPT-4oは平均で12%(15問中1.8問)の正答率にとどまりましたが、o1は1問につき1サンプルで74%(15問中11.1問)の正答率を達成しました。また、64サンプルのコンセンサスでは83%(15問中12.5問)、1000サンプルを学習されたスコアリング関数で再ランク付けした場合には93%(15問中13.9問)を記録しました。このスコアは、全米トップ500の学生に相当し、米国数学オリンピックの基準を超えています。

また、o1を難易度の高い知能ベンチマークであるGPQAダイヤモンドで評価しました。これは化学、物理学、生物学における専門知識を問うものです。モデルを人間と比較するために、私たちは博士号を持つ専門家を集め、GPQAダイヤモンドの質問に回答してもらいました。その結果、o1はこれらの専門家のパフォーマンスを上回り、このベンチマークで初めて人間の専門家を超えるモデルとなりました。この結果は、o1が全ての面で博士号を持つ専門家よりも優れていることを示すものではありませんが、博士号取得者が解くべき問題の一部でモデルがより優れた解決能力を持っていることを示しています。他のいくつかの機械学習ベンチマークでも、o1は最新技術を上回りました。視覚認識機能を有効にしたo1は、MMMUで78.2%のスコアを記録し、人間の専門家と競える最初のモデルとなりました。また、57のMMLUサブカテゴリーのうち54でGPT-4oを上回りました。

(3) チェイン・オブ・ソート(思考の連鎖)

難しい質問に対して人間が長時間考えてから答えるように、o1は問題を解決しようとする際にチェイン・オブ・ソート(思考の連鎖)を用います。強化学習を通じて、o1はその思考の連鎖を磨き、使用する戦略を洗練していきます。モデルは自身のミスを認識し、修正する方法を学びます。また、難しいステップをより簡単なものに分解する方法や、現在のアプローチが機能しないときに別のアプローチを試す方法も学びます。このプロセスにより、モデルの推論能力が飛躍的に向上します。この進化を示すために、以下ではo1-previewがいくつかの難題に対して行ったチェイン・オブ・ソートを紹介します。

【暗号解読の例】

○ GPT-4oの場合

ユーザー

oyfjdnisdr rtqwainr acxz mynzbhhx -> Think step by step

上記の例を使って、次の暗号を解読してください:

oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

GPT-4o

例に基づいて、ステップごとにこれを分解していきます:

1. 例として与えられたもの:

- 入力: oyfjdnisdr rtqwainr acxz mynzbhhx

- 出力: Think step by step

言葉を調べてみると:

- 特定の文字を選択したり、変換したりするパターンがあるようです。

2. それでは、新しいフレーズをデコードしてみましょう:

- 入力: oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

ステップごとのデコードプロセス:

可能な単語の区切りを特定します。

最初のフレーズは、例と同じ構造に従うかもしれません。入力テキストは自然な区切りやパターンに基づいてグループに分けられる可能性があります。

例えば、次のように分けられるかもしれません:

oyekaijzdf

aaptcg

suaokybhai

ouow

aqht

mynznvaatzacdfoulxxz

しかし、意味のあるデコードを行うためには、変換や文字のシフトに関するさらなる情報が必要です。

この暗号で使用されるデコードルールや変換に関する追加の情報を提供していただけますか?

○ OpenAI o1-previewの場合

ユーザー

oyfjdnisdr rtqwainr acxz mynzbhhx → Think step by step

上記の例を使ってデコードしてください:

oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

OpenAI o1-preview

例で示されたパターンを使用して、与えられた暗号文をデコードします。

暗号文の例:

入力

oyfjdnisdr rtqwainr acxz mynzbhhx

デコードされた結果:

出力

Think step by step

デコード方法:

1. 暗号文の文字をペアにします。

2. 各文字をアルファベットの数値(A=1, B=2, ... Z=26)に変換します。

3. 各ペアの数値を合計します。

4. 合計を平均(2で割る)します。

5. 平均値を再び文字に変換します(1=A, 2=B, ... 26=Z)。

この方法を使って与えられた暗号文をデコードします。

入力

oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz

暗号文をペアに分けます:

1. 最初の単語: "oyekaijzdf"

ペア: oy, ek, ai, jz, df

デコードされた文字:

oy → (15+25)/2 = 20 → T

ek → (5+11)/2 = 8 → H

ai → (1+9)/2 = 5 → E

jz → (10+26)/2 = 18 → R

df → (4+6)/2 = 5 → E

デコードされた単語: THERE

2. 次の単語: "aaptcg"

ペア: aa, pt, cg

デコードされた文字:

aa → (1+1)/2 = 1 → A

pt → (16+20)/2 = 18 → R

cg → (3+7)/2 = 5 → E

デコードされた単語: ARE

(以下3から6までを省略)

最終的なデコード結果:

THERE ARE THREE R'S IN STRAWBERRY

答え:

THERE ARE THREE R'S IN STRAWBERRY

(公式サイトには、他にコーディングや数学など7つの例が掲載されています。)

(4) コーディング

私たちは、o1を初期化し、プログラミングスキルをさらに向上させるトレーニングを行ったモデルを開発しました。このモデルは、2024年の国際情報オリンピック(IOI)で213ポイントを獲得し、49パーセンタイルにランクインしました。このモデルは、2024年のIOIにおいて人間の参加者と同じ条件下で競技しました。6つの難解なアルゴリズム問題を解くために10時間が与えられ、各問題につき50回の提出が許可されました。

各問題に対して、システムは多くの候補となる提出物を生成し、テスト時の選択戦略に基づいて50件を提出しました。提出物は、IOIの公開テストケース、モデル生成のテストケース、および学習されたスコアリング関数に基づいて選択されました。ランダムに提出した場合、平均で156ポイントしか獲得できなかったことから、この戦略によって競技条件下で約60ポイントの価値があったことが示唆されます。

提出回数の制約を緩和すると、モデルのパフォーマンスが大幅に向上することがわかりました。問題ごとに10,000回の提出が許可された場合、このモデルは362.14ポイントを達成し、テスト時の選択戦略を使わなくても金メダルの基準を上回りました。

最後に、このモデルのコーディングスキルを示すため、Codeforcesが主催する競技プログラミングコンテストをシミュレーションしました。評価は競技ルールに厳密に従い、提出回数は10回に制限されました。GPT-4oは808のEloレーティングを達成し、これは人間の競技者の11パーセンタイルに相当します。この新しいモデルはGPT-4oとo1の両方を大幅に上回り、1807のEloレーティングを達成し、競技者の93%より優れたパフォーマンスを示しました。

(5) 人間の選好評価

試験や学術的なベンチマークに加えて、幅広い分野における難解でオープンエンドなプロンプトに対して、o1-previewとGPT-4oの人間の選好評価も行いました。この評価では、匿名化されたo1-previewとGPT-4oの応答が人間のトレーナーに提示され、どちらの応答が好ましいか投票されました。データ分析、コーディング、数学のように推論を多く必要とするカテゴリでは、o1-previewがGPT-4oよりも大幅に好まれました。しかし、一部の自然言語タスクではo1-previewは好まれず、すべてのユースケースに適しているわけではないことが示唆されます。

(6) 安全性

チェイン・オブ・ソート(思考の連鎖)による推論は、整合性と安全性の新たな機会を提供します。私たちは、モデルの行動に関するポリシーを推論モデルの思考の連鎖に統合することで、人間の価値観や原則を強力に教える効果的な方法であることを発見しました。モデルに安全ルールを教え、それらについて文脈に応じて推論する方法を学ばせることで、推論能力がモデルの堅牢性に直接寄与していることが確認されました。o1-previewは、重要な「ジェイルブレイク評価」や、モデルの安全な拒否境界を評価する最も難しい内部ベンチマークで、飛躍的な性能向上を達成しました。

チェイン・オブ・ソートは、安全性と整合性の大幅な進展をもたらすと考えています。その理由は、(1) モデルの思考過程を明確に観察できるようになることと、(2) モデルが安全ルールについて推論することで、未知のシナリオに対してもより堅牢に対応できるようになるからです。

改善を厳しくテストするために、私たちは「Preparedness Framework」に従い、デプロイ前に一連の安全性テストとレッドチーミングを実施しました。この評価において、チェイン・オブ・ソートによる推論が能力の向上に貢献したことが確認されました。特に注目すべきは、リワードハッキングの興味深い事例が観察された点です。詳細な評価結果は、付随するシステムカードに記載されています。

(7) チェイン・オブ・ソートを隠すことについて

私たちは、隠されたチェイン・オブ・ソート(思考の連鎖)がモデルの監視において独自の機会を提供すると考えています。信頼性があり、明瞭に解読できると仮定すれば、隠されたチェイン・オブ・ソートはモデルの「思考」を読み、その思考プロセスを理解する手段となります。例えば、将来的には、チェイン・オブ・ソートを監視して、ユーザーを操作しようとしている兆候を確認することができるかもしれません。しかし、この仕組みを機能させるためには、モデルが自分の思考をありのままに表現する自由が必要であり、ポリシーの遵守やユーザーの好みに沿わせるような訓練をチェイン・オブ・ソートに適用することはできません。また、ユーザーにチェイン・オブ・ソートが未整合の状態で直接見えるようにすることも避けたいと考えています。

そのため、ユーザー体験、競争上の優位性、チェイン・オブ・ソート監視の可能性など、複数の要因を慎重に検討した結果、生のチェイン・オブ・ソートをユーザーに表示しないことを決定しました。この決定にはデメリットがあることを認識していますが、チェイン・オブ・ソートから有益なアイデアを回答に再現するようモデルに教えることで、部分的に補おうと努力しています。o1モデルシリーズでは、モデル生成のチェイン・オブ・ソートの要約を表示します。

(8) 結論

o1は、AI推論の最先端技術を大きく進歩させました。今後も改良版をリリースしながら、継続的にこのモデルを改良していく予定です。これらの新しい推論能力は、モデルを人間の価値観や原則に沿わせる能力をさらに向上させると期待しています。o1とその後継モデルは、科学、コーディング、数学、その他関連分野におけるAIの新しいユースケースを数多く解放するでしょう。ユーザーやAPI開発者がどのようにしてo1が日常の仕事を向上させるかを発見することに、私たちは大きな期待を寄せています。

付録A

3.OpenAI o1-mini

https://openai.com/index/openai-o1-mini-advancing-cost-efficient-reasoning/

コスト効率の高い推論の推進

私たちは、コスト効率の高い推論モデルであるOpenAI o1-miniをリリースしています。o1-miniは特にSTEM分野(科学、技術、工学、数学)において優れた性能を発揮し、AIMEやCodeforcesなどの評価ベンチマークでは、OpenAI o1とほぼ同等のパフォーマンスを示します。o1-miniは、幅広い一般知識を必要としない推論を行うアプリケーションにおいて、より高速でコスト効率の良いモデルになることを期待しています。

本日、o1-miniをAPIユーザーのTier 5向けにリリースし、OpenAI o1-previewよりも80%安価で利用可能にしています。ChatGPT Plus、Team、Enterprise、およびEduのユーザーは、o1-previewの代わりにo1-miniを使用でき、より高いレート制限と低レイテンシーで利用できます(モデル速度を参照)。

(1) STEM推論に最適化

o1のような大規模言語モデルは、膨大なテキストデータセットで事前トレーニングされています。これらの高容量モデルは広範な世界知識を持つ一方で、現実のアプリケーションでは高コストであり、処理が遅くなることがあります。これに対して、o1-miniはSTEM推論に最適化された小型モデルであり、事前トレーニング段階でSTEM分野に特化しています。o1と同じ高計算能力の強化学習(RL)パイプラインでトレーニングされた結果、o1-miniは多くの有用な推論タスクで同等のパフォーマンスを達成しつつ、コスト効率が大幅に向上しています。

知性と推論を必要とするベンチマークで評価された際、o1-miniはo1-previewやo1と比較して良好なパフォーマンスを示します。しかし、非STEMの事実に基づく知識を必要とするタスクにおいては、パフォーマンスが低下することがあります(制限事項を参照)。

数学: 高校生向けのAIME数学コンペティションにおいて、o1-mini(70.0%)はo1(74.4%)に匹敵する競争力を持ち、さらに大幅にコストが安い上に、o1-preview(44.6%)を上回るパフォーマンスを発揮しています。o1-miniのスコア(15問中約11問正解)は、米国の高校生の上位約500人に位置します。

コーディング: Codeforcesの競技プログラミングサイトでは、o1-miniは1650のEloレーティングを達成し、これもo1(1673)に匹敵し、o1-preview(1258)を上回っています。このEloスコアは、Codeforcesプラットフォームで競うプログラマーの上位約86パーセンタイルに位置します。o1-miniは、HumanEvalコーディングベンチマークや高校レベルのサイバーセキュリティCapture the Flag(CTF)チャレンジにおいても優れたパフォーマンスを発揮しています。

STEM: 推論を必要とするいくつかの学術ベンチマーク、例えばGPQA(科学)やMATH-500では、o1-miniはGPT-4oを上回るパフォーマンスを発揮しています。しかし、o1-miniはMMLUのようなタスクではGPT-4oに及ばず、GPQAにおいても幅広い世界知識が不足しているため、o1-previewに遅れを取っています。

人間の選好評価: 我々は、人間の評価者にさまざまな分野での難解でオープンエンドなプロンプトにおいて、o1-miniとGPT-4oを比較してもらい、o1-previewとGPT-4oの比較時と同じ手法を用いました。o1-previewと同様に、o1-miniは推論を重視する分野ではGPT-4oよりも好まれましたが、言語に焦点を当てた分野ではGPT-4oの方が好まれました。

(2) モデルの速度

具体例として、単語の推論問題において、GPT-4o、o1-mini、o1-previewの回答を比較しました。GPT-4oは正答を出せなかったものの、o1-miniとo1-previewはどちらも正しい答えに到達し、o1-miniはo1-previewに比べて約3~5倍の速さで解答にたどり着きました。

(3) 安全性

o1-miniは、o1-previewと同じアラインメントおよび安全性技術を使用してトレーニングされています。このモデルは、内部版のStrongREJECTデータセットにおいて、GPT-4oと比較して59%高いジェイルブレイク耐性を持っています。展開前に、o1-miniの安全性リスクを、o1-previewと同様の準備手法、外部によるレッドチームテスト、そして安全性評価を用いて慎重に評価しました。これらの評価結果の詳細は、付随するシステムカードで公開しています。

(4) 制限事項と今後の展望

o1-miniはSTEM分野の推論能力に特化しているため、日付、人物の経歴、雑学などの非STEM分野における事実知識は、GPT-4o miniのような小規模なLLMと同等です。今後のバージョンではこれらの制限を改善し、STEM以外の他のモダリティや専門分野へのモデルの拡張にも取り組んでいく予定です。

4.OpenAI o1 システムカード

https://openai.com/index/openai-o1-system-card/

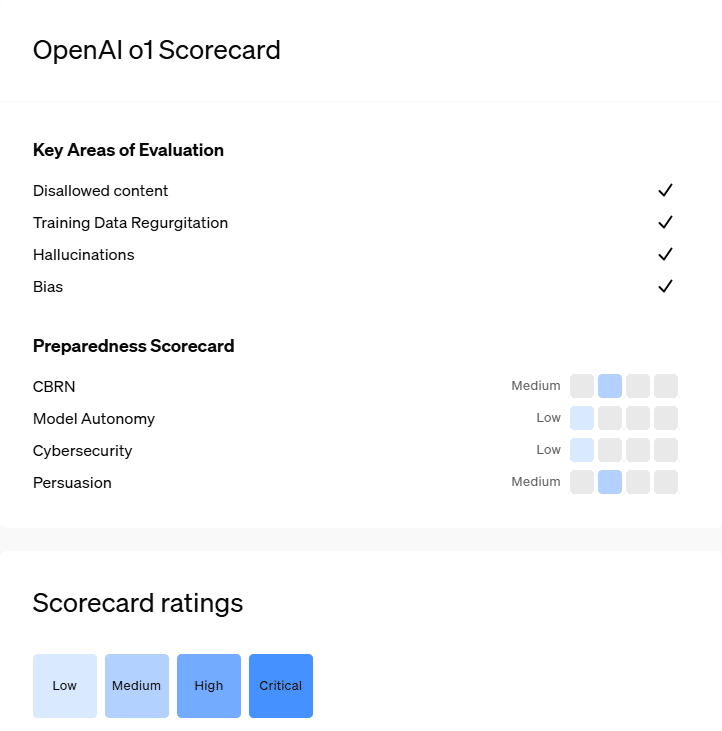

このレポートは、OpenAI o1-previewおよびo1-miniをリリースする前に実施された安全性に関する作業を概説しており、外部によるレッドチームテストや、準備フレームワークに基づいたフロンティアリスク評価を含んでいます。

緩和後のスコアが「高」以下のモデルのみがさらに開発可能です。

前回の主要なOpenAIモデルと比べて、性能が改善されているか同等の性能を持っています。

(1) 導入

私たちは、新しいモデルの潜在的なリスクを徹底的に評価し、ChatGPTやAPIに展開する前に適切な安全策を講じています。OpenAI o1の厳格な安全評価を提供するために、OpenAI o1システムカードを公開するとともに、準備フレームワークのスコアカードも併せて公開し、現在の安全課題やフロンティアリスクに対して行ってきた対策を説明しています。

過去のモデルで開発した安全評価と緩和策を基に、o1の高度な推論能力に対して追加の取り組みを行いました。公的および内部評価を用いて、禁止されたコンテンツ、人口統計に基づく公平性、幻覚傾向、危険な能力などのリスクを測定しました。これらの評価に基づき、ブロックリストや安全分類器など、モデルレベルおよびシステムレベルの両方で安全策を実施し、リスクを効果的に緩和しています。

私たちの調査結果では、o1の高度な推論能力により、安全ルールを文脈内で推論し、それをより効果的に適用できるため、有害なコンテンツの生成に対する抵抗力が高まり、安全性が向上していることが示されています。準備フレームワークに基づくと、o1は「中程度」の総合リスク評価を受け、既存のリソースで可能なことを超えるものを提供しないため、展開が安全とされています。また、サイバーセキュリティやモデルの自律性においては「低リスク」、CBRN(化学・生物・放射線・核兵器)や説得力においては「中リスク」と評価されています。

OpenAIの安全諮問グループ、安全・セキュリティ委員会、OpenAI取締役会は、o1に適用された安全およびセキュリティプロトコルと、準備評価の詳細を精査し、o1のリリースを承認しました。

o1モデルシリーズは、大規模な強化学習によってトレーニングされ、連鎖的な思考を用いた推論を行います。これらの高度な推論能力は、モデルの安全性と堅牢性を向上させるための新たな道を提供します。特に、潜在的に安全でないプロンプトに対して応答する際、文脈に沿って安全ポリシーを推論できるようになり、違法な助言の生成、ステレオタイプな応答の選択、既知のジェイルブレイクに対する耐性など、いくつかのベンチマークにおいて最先端のパフォーマンスを発揮します。回答前に連鎖的な思考を取り入れるようにモデルをトレーニングすることで、大きな利益が得られる可能性がある一方で、より高度な知性に起因するリスクが増加する可能性もあります。これらの結果は、堅牢なアラインメント手法の構築、効果の徹底的なストレステスト、および細心のリスク管理プロトコルの維持が重要であることを強調しています。このレポートでは、OpenAI o1-previewおよびOpenAI o1-miniモデルに対して行われた安全評価、外部レッドチームテスト、準備フレームワーク評価など、安全に関する作業を概説しています。

この作業の詳細については、以下のレポートをご覧ください。

Memo

OpenAI o1チームとのAMAセッションの概要

9月14日に行われたOpenAI o1チームとのAMA(Ask Me Anything)セッションの要約です。

モデル名と推論パラダイム

- OpenAI o1は、新たなAI能力のレベルを表すために名付けられ、カウンターが1にリセットされている。

- 「Preview」は、モデルの初期バージョンであることを示す。

- 「Mini」は、o1モデルの小型バージョンで、スピードに最適化されていることを意味する。

- oはOpenAIを表す。

- o1は「システム」ではなく、最終的な回答を返す前に長い推論の連鎖を生成するように訓練されたモデルである。

- o1のアイコンは、比喩的に卓越した能力を持つエイリアンを象徴している。

o1モデルのサイズと性能

- o1-miniはo1-previewよりもはるかに小型で高速であり、将来的に無料ユーザーに提供される予定。

- o1-previewはo1モデルの初期チェックポイントであり、大きさは変わらない。

- o1-miniはSTEM関連のタスクで優れているが、世界知識は限られている。

- o1-miniは、特にコード関連のタスクでo1-previewよりも優れている。

- o1の入力トークンはGPT-4oと同じトークナイザーを使って計算される。

- o1-miniはo1-previewよりも多くの思考連鎖を探索できる。

入力トークンコンテキストとモデルの能力

- o1モデルに対して、より大きな入力コンテキストがまもなく提供される予定。

- o1モデルはGPT-4oに比べて、入力のチャンク分割が少なく、長くてオープンなタスクを処理できる。

- o1は、以前のモデルとは異なり、回答を出す前に長い思考連鎖を生成できる。

- 現時点ではCoT中に推論を一時停止して追加のコンテキストを加える方法はないが、将来的なモデルでこれが検討されている。

ツール、機能、今後のアップデート

- o1-previewはまだツールを使用していないが、関数呼び出し、コードインタープリター、ブラウジングのサポートが計画されている。

- ツールサポート、構造化された出力、システムプロンプトが将来のアップデートで追加される。

- 将来的には、ユーザーが思考時間やトークン制限をコントロールできる可能性がある。

- ストリーミング機能や、API内で推論進行状況を考慮する計画が進行中。

- マルチモーダル能力がo1に組み込まれており、MMMU(多様モーダルマルチユースタスク)で最先端のパフォーマンスを目指している。

CoT(思考の連鎖)推論

- o1は推論中に隠れた思考の連鎖を生成する。

- CoTトークンをAPIユーザーやChatGPTに公開する予定はない。

- CoTトークンは要約されるが、実際の推論と一致している保証はない。

- プロンプトの指示が、モデルが問題についてどのように考えるかに影響を与える。

- 強化学習(RL)を使用してo1のCoTを改善しており、GPT-4oはプロンプトだけではそのCoTパフォーマンスに匹敵できない。

- 思考の段階は、思考プロセスを要約するため遅く見えるが、実際の回答生成は通常高速である。

APIと使用制限

- o1-miniはChatGPT Plusユーザーに対して、週50プロンプトの制限がある。

- ChatGPTではすべてのプロンプトが同じようにカウントされる。

- APIアクセスのさらなる層や、より高いレート制限が今後導入される予定。

- APIでのプロンプトキャッシングは人気のリクエストだが、まだ具体的なタイムラインはない。

価格設定、ファインチューニング、スケーリング

- o1モデルの価格設定は、1~2年ごとの価格引き下げ傾向に従うと予想される。

- バッチAPI価格は、レート制限が増加するとサポートされる予定。

- ファインチューニングは計画中だが、まだタイムラインは発表されていない。

- o1のスケーリングは、研究およびエンジニアリングの人材によってボトルネックになっている。

- 推論コンピューティングにおける新しいスケーリングパラダイムは、将来のモデル世代で大きな成果をもたらす可能性がある。

- 逆スケーリングはまだ重要ではないが、個人的な執筆プロンプトでは、o1-previewがGPT-4oと同等か、やや劣ることがある。

モデル開発と研究の洞察

- o1は強化学習を使用して推論パフォーマンスを達成した。

- モデルは創造的な思考や、詩のような横断的なタスクにおいて強力なパフォーマンスを示す。

- o1の哲学的推論や暗号解読など、一般化する能力は印象的である。

- o1は、研究者がGitHubボットを作成し、適切なコードオーナーにレビューを依頼するために使用された。

- 内部テストでは、o1が自ら難問を出題し、自分の能力を評価した。

- 広範な世界の知識が追加されており、将来のバージョンで改善される予定。

- o1-miniに対しては、最新データが今後のバージョン(2023年10月現在)で導入される計画がある。

プロンプト技術とベストプラクティス

- o1は、エッジケースや推論スタイルを提示するプロンプトスタイルから恩恵を受ける。

- o1モデルは、以前のモデルよりもプロンプト内の推論の手がかりに敏感である。

- 検索拡張生成(RAG)において、関連するコンテキストを提供することがパフォーマンスを向上させ、不適切なチャンクは推論を悪化させる可能性がある。

全体的なフィードバックと今後の改善点

- o1-previewのレート制限は初期段階のテストのため低く設定されているが、今後は増加する予定。

- レイテンシーや推論時間の改善が積極的に進められている。

特筆すべきモデルの能力

- o1は「生命とは何か」といった哲学的な質問に思考を巡らせることができる。

- 研究者たちは、o1が複雑なタスクを処理し、限られた指示から一般化できる能力に感銘を受けた。

- o1の創造的な推論能力は、自身にクイズを出して能力を評価するなど、高度な問題解決能力を示している。

Summary of what we have learned during AMA hour with the OpenAI o1 team today

— Tibor Blaho (@btibor91) September 13, 2024

Model Names and Reasoning Paradigm

- OpenAI o1 is named to represent a new level of AI capability; the counter is reset to 1

- "Preview" indicates it's an early version of the full model

- "Mini"… https://t.co/LdIsWgn1Hy