LlamaCloudとLlamaParseの紹介 | by Jerry Liu | Feb, 2024 | LlamaIndex Blog

Clip source: Introducing LlamaCloud and LlamaParse | by Jerry Liu | Feb, 2024 | LlamaIndex Blog

マルチモードの生成AIが2024年の大きな技術テーマである、と言われてますが、テキストデータを統合的に生成AIとして処理できるようにするために、もともと文字だったデータのみならず、画像から文字の抽出、PDFからの文字の抽出、そして特にPDFや画像などに含まれるグラフや表(テーブル)等のデータの読み込み、そして文字データへの変換が一番重要な要件として上がっています。特に企業におけるデータは、かなりの比重でPDFフォーマットが存在し、今までの生成AIではそれが無視されてきました。企業内の生成AIシステムを開発する上で、RAGの機能としてPDFのデータを正しくテキストデータとして読み込むことができるようにしたのが、LlamaIndex社のLlamaParse/LlamaCloudの機能で、今後大きな活用が期待されます。

まだプレビューなので機能には制限がありますが、すでにDataStax社、MongoDB社、Qdrant社、Nvidia社等では、自社のRAG機能にLlamaParse/LlamaCloudを採用しており、さらに広い範囲での採用が期待されます。

LlamaCloudとLlamaParseの紹介

LlamaIndex Blog February 20, 2024

本日、LlamaIndexは、新世代の管理型パーシング、取り込み、および検索サービスであるLlamaCloudを発表します。これは、LLMおよびRAGアプリケーションに対するプロダクションレベルのコンテキスト拡張を提供するよう設計されています。

エンタープライズAIエンジニアとしてLlamaCloudを使用することで、データの取り扱いに悩むことなく、ビジネスロジックの記述に集中し、大量の本番データを処理して直ちに応答品質を向上させることができます。LlamaCloudは、以下の主要コンポーネントで提供します。

LlamaParse: テーブルや図表などの埋め込まれたオブジェクトを含む複雑な文書のための独自のパーシング。LlamaParseは、LlamaIndexの取り込みおよび検索と直接統合され、複雑な半構造化文書上での検索を構築することができます。以前には不可能だった複雑な質問に対応可能になります。

管理型取り込みおよび検索API: RAGアプリのためのデータを簡単にロード、処理、保存し、任意の言語で対応することができるAPI。LlamaHub内のデータソース、LlamaParse、およびデータストレージ統合機能によって支えられています。

LlamaParseは、本日から公開プレビュー開始です。現在、PDFの処理が可能ですが、利用には上限があります。商用利用の際の条件については、お問い合わせください。管理型取り込みおよび検索APIは、プライベートプレビューとして利用可能です。限られたセットのエンタープライズデザインパートナーへのアクセスを提供しています。興味があれば、ご連絡ください。(新バージョンのウェブサイトもローンチしました🦙!)

RAGの性能はデータの質次第です

LLM(大規模言語モデル)の重要な役割は、あらゆる非構造化データソースを統合して知識検索、合成、抽出、および計画を自動化できることです。過去1年間で、これらのコンテキスト拡張LLMアプリケーションを支える新しいデータスタックとしてRetrieval-Augmented Generation (RAG)が出現しました。このスタックには、データのローディング、処理、埋め込み、ベクトルデータベースへのローディングが含まれ、LLMアプリ内でコンテキストを提供するための検索とプロンプティングの下流でのオーケストレーションが可能になります。

このスタックは、従来のETLスタックとは異なります。なぜなら、従来のソフトウェアとは異なり、データスタックのあらゆる決定がLLMを搭載したシステム全体の精度に直接影響を与えるからです。チャンクサイズの設定や埋め込みモデルの選択がLLMのアウトプットに大きな影響を与えるが、LLMがブラックボックスであるため、単体テストで正しい振る舞いを確認することはできません。

LlamaIndex社では、高性能で先進的なRAGを様々なユースケースで構築する方法について、ツールの提供を行なっています。月間ダウンロード数は200万を超え、Adyen、T-Systems、Jasper.ai、Weights and Biases、DataStaxなど、大企業からスタートアップまで幅広く使用されています。

しかし、本番級のRAGを構築する上で、次のような悩みが多く発生することをユーザーから聞いてます:

結果が十分に正確ではない:アプリケーションが、特定の入力タスク/クエリに対して満足のいく結果を生み出すことができませんでした。

調整すべきパラメータの数が圧倒的に多い:データのパース、取り込み、検索を通じて、どのパラメータを調整すべきかが不明確。

PDFが特に問題:複雑なPDFフォーマットのドキュメントは大量に存在します。これらをLLMが理解できるようなデータ表現方法が必要。

データの同期が課題:本番データは定期的に更新され、新しいデータを継続的に同期することに課題がある。

これらの問題をLlamaCloudで解決しようとしてるのが今回の発表です。

本番環境への道を開くデータパイプライン

LlamaCloudとLlamaParseにより、RAGアプリケーションをより迅速に本番環境に導くためのデータパイプラインが提供されます。

LlamaParse

LlamaParseは、最新型のパーサーであり、埋め込まれたテーブルやチャートを含む複雑なPDF上でRAGを実現することを特に目的として設計されています。これは、他のアプローチでは以前は不可能だった機能です。

過去数ヶ月間、私たちはこの問題可決に取り込んできました。これは、非常に広い範囲での利用が可能で、ArXivの論文から10Kの提出物、医療報告書に至るまで、様々なデータタイプに対応します。

チャンキングと検索アルゴリズムは難しい技術を要しますが、LlamaIndexは文書内テーブルとテキストを階層的に索引付けし、クエリするための再帰的検索RAG技術を提供しこの課題に取り組んでます。残る課題は、最初にテーブルとテキストをどのように適切に解析するか、という点でした。

LlamaParseは、複雑なテーブルを含むPDFをよく構造化されたマークダウン形式に解析することに非常に優れた独自のパーシングサービスを提供します。これには、オープンソースライブラリで提供されるな高度なMarkdown解析および再帰的検索アルゴリズムに直接組み込まれます。結果として、表形式のデータと非構造化データの両方に関する質問に答えることができる複雑な文書上でRAGを構築することができます。以下の結果を確認して、比較してみてください:

このサービスは公開プレビューモードで利用可能です:誰でも利用できますが、使用制限があります(1日あたり1kページ)。これはスタンドアロンサービスとして機能し、管理された取り込みおよび検索APIにも組み込まれます(下記参照)。詳細については、こちらのLlamaParseオンボーディングをご覧ください。

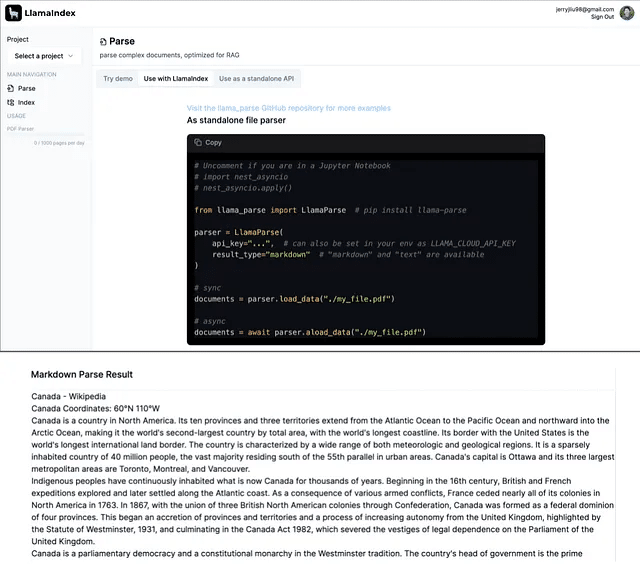

from llama_parse import LlamaParse

parser = LlamaParse(

api_key="llx-...", # can also be set in your env as LLAMA_CLOUD_API_KEY

result_type="markdown", # "markdown" and "text" are available

verbose=True

)

LlamaParseの無制限の商用利用については、私たちに連絡してください。

次のステップ

初期のユーザーからは、次に何を見たいかについて重要なフィードバックを既にいただいています。現在、私たちは主にテーブルを含むPDFをサポートしていますが、図表のサポートを強化し、さらに人気のあるドキュメントタイプ(.docx、.pptx、.html)のサポートを拡大するための開発も進めています。

管理型取り込みおよび検索

LlamaCloudのもう一つの主要な提供物は、任意のコンテキスト拡張LLMアプリケーションに対して、パフォーマンスの高いデータパイプラインを簡単に宣言できる管理型取り込みおよび検索APIです。

LLMアプリケーションにクリーンなデータを提供することで、データの取り扱いにかかる時間を減らし、コアアプリケーションロジックの記述自体に注力が可能になります。LlamaCloudは、次のような利点を提供します:

エンジニアリング時間の節約:Pythonでカスタムコネクタやパーシングロジックを書く必要がなく、APIを使用して異なるデータソースに直接接続可能。

パフォーマンス:異なるデータタイプに対して良好なアウトオブザボックスのパフォーマンスを提供し、実験、評価、改善のための直感的なパスを提供。

システムの複雑さの軽減:大量のデータソースを増分更新で扱います。

コアコンポーネントを簡単に見てみましょう!

取り込み:LlamaHubの150以上のデータソースと40以上のストレージ統合を目的地として、プロセスおよび変換/チャンク/埋め込みデータを処理するための管理型パイプラインを宣言します。同期と負荷分散を自動的に処理します。UIまたはオープンソースライブラリを通じて定義します。

検索:オープンソースライブラリとデータストレージに支えられた最先端の高度な検索にアクセスします。任意の言語から利用できる使いやすいREST APIでラップします。

プレイグラウンド:デプロイメント前の取り込み/検索戦略をテストおよび改善するためのインタラクティブUIで、ループ内での評価を提供します。

管理型取り込みおよび検索APIについて、限られたセットのエンタープライズパートナー向けにプライベートベータを公開しています。データパイプラインを集約し、実際のRAGユースケースにより多くの時間を割くことに興味がある場合は、私たちに話をしに来てください。

ローンチパートナーとコラボレーター

2月初旬にFutureproof LabsおよびDatastaxと共催したハッカソンでLlamaParseへのアクセスを開始し、LlamaParseのアプリケーションが開発されています。事例として、アクセサリー住居ユニット(ADU)計画のための建築コードの解析や、家の購入のための不動産開示情報の解析など、複雑なデータの分析例もあります。

Mendable AIの共同創設者であるEric Ciarlaは、MendableのデータスタックにLlamaParseを組み込みました。「私たちはLlamaParseを、私たちのデータ取り込み機能であるオープンソースのデータコネクタリポジトリに統合しました。統合は簡単で、私たちが試した他のどの代替品よりも強力でした。」

また、LLMおよびAIエコシステム内の次のパートナー企業もすでに導入を開始しています。

DataStax

DataStaxは、プライバシーを保護するRAGソリューションを企業に提供するために、LlamaParseを自社のRAGStackに組み込みました。「先週、私たちの顧客であるImpromptが、LlamaIndexによって強化されたRAGStackを活用して、「Chat-to-Everything」プラットフォームを先駆けて立ち上げ、企業向けのプライバシー強化機能を提供してます。」とDataStaxのCTO兼エグゼクティブバイスプレジデントであるDavor Bonaciは述べています。「効率的なソリューションを提供するためにLlamaIndexと提携できることに期待しています。LlamaIndexをRAGStackに組み込むことで、RAG実装の複雑さを簡素化し、長期的なサポートと互換性保証を提供する包括的な生成AI機能をエンタープライズ開発者に提供しています。」

MongoDB

「MongoDBとLlamaIndexとのパートナーシップにより、データをMongoDB Atlas Vectorデータベースに取り込み、LlamaParseおよびLlamaCloudを介してAtlasからインデックスを取得することが可能になり、RAGシステムやその他のAIアプリケーションの開発を可能にします。」とMongoDBのグローバルリード、AIエコシステムのGreg Maxsonは述べています。「これで、開発者はデータ取り込みに関連する複雑さを抽象化し、RAGパイプラインの実装を簡素化し、大規模言語モデルアプリケーションをよりコスト効率良く開発できるようになり、結果として生成AIアプリの開発を加速し、アプリをより迅速に市場に投入できます。」

Qdrant

QdrantのCEOであるAndré Zayarniは、「Qdrantチームは、最適なデータ前処理、ベクトル化、および取り込みの力をQdrantと組み合わせて、強力なフルスタックRAGソリューションを提供するためにLlamaIndexと提携することに興奮しています。」と述べています。

NVIDIA

NVIDIAとのコラボレーションも実現してます。NVIDIAのAIエンタープライズソフトウェアプラットフォームとLlamaIndexを統合に両社は協業してます。「LlamaCloudは、独自のデータを大規模言語モデルの力にリンクするコネクタを使用して、企業が開発から本番環境への生成AIアプリケーションの導入を支援します。」と、NVIDIAのエンタープライズおよびエッジコンピューティング担当副社長であるJustin Boitanoは述べています。「LlamaCloudとNVIDIA AIエンタープライズを組み合わせることで、データ処理、埋め込みの作成、インデックス作成、モデル推論を含むLLMパイプライン全体を加速し、クラウド、データセンター、エッジまでの加速コンピューティングを横断して加速できます。」

FAQ

LlamaCloudはベクトルデータベースと競合しますか?

いいえ。LlamaCloudは主にデータのパースと取り込みに焦点を当てており、これは任意のベクトルストレージプロバイダに補完的なレイヤーです。検索レイヤーは、既存のストレージシステムの上にオーケストレーションを行います。LlamaIndexのオープンソースは、最も人気のある40以上のベクトルデータベースと統合されており、私たちは以下のことを行うために努力しています:

既存のデザインパートナーのストレージプロバイダーとLlamaCloudを統合する

より「セルフサービス」方式でLlamaCloudを利用可能にする

この記事が気に入ったらサポートをしてみませんか?