OpenAI社のSuperAlignmentプロジェクトについて

OpenAIのCEO、Sam Altman氏がOpenAI社のボードから解雇されてから戻るまで、映画でもおそらく考えつきにくいドラマが展開されてきましたが、その解雇の動きの中心人物とされている、Ilya Sutskever氏がOpenAI社内で、SuperAllignmentチーム、という組織を立ち上げました。

このSuperAlignmentチーム、というのは、近い将来(今世紀内、と書かれてます)に危惧される、AIシステムが人間の知能を超えた場合のコントロールをどのようにすべきか、という事を研究する専門組織です。

読むと、ほとんどSFの映画のシナリオのような内容ですが、OpenAIの最近数ヶ月内に起きた事象の背景に、この危惧に対する意見の違いが要因になっている、ということを考えると、あながち酔狂の末の作り話、と片付けられないような気もしてきます。

Responsible AIとかAI Ethicsとか、色々なキーワードが登場してますが、AIの技術が便利極まりない反面、それが悪用される、またはAI自身が悪意を持った判断を促すような働きをしてしまわないようにするための道徳なブレーキをかける必要性、というのは現実的な課題として考えられます。その多くは、AIを使う人間が正しい目的をもってAIを使うための制限や規制を定義して実行する仕組みですが、このOpenAI社のSuper Alignmentは、AIシステム自体が人間のためにプラスになるような処理に限定できるような制御が必要だ、と謳ってます。

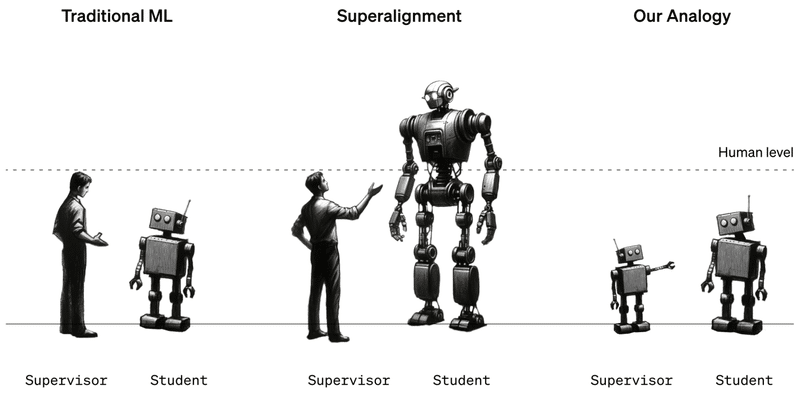

具体的には、それを人間が制御するのではなく、少し弱いAIシステムが強いAIシステムを監視して、コントロールすることだ、と書かれてます。

その弱いAIシステムは、恐らく人間がコントロールするのでは、と察しますが、

古くは、アイザック アシモフというSF作家がロボット3原則、というのを書いたのを思い出しましたが、リアルの世界ではもう少し複雑なのかなぁ、と感じました。

OpenAI社のスーパーアラインメントチームが何をしていたのかが明らかになりました。

Clip source: Now we know what OpenAI’s superalignment team has been up to | MIT Technology Review

この会社は、スーパーインテリジェンスが暴走しないようにしたいと考えています。これがその第一歩です。

2023年12月14日

ステファニー・アーネット/MITTR

OpenAIは、スーパーインテリジェンス(人間よりも賢い仮説上の未来のコンピュータ)が暴走しないようにするための発足した社内プロジェクト、スーパーアラインメントチームからの最初の報告をしてます。

同社の多くの発表とは異なり、これは大きな製品発表ではなく、控えめな研究論文を通して、より強力な大規模言語モデルをより弱いものが監督する技術コンセプトを説明し、超人的なマシンを人間が監督できる方法としてその考え方を説明してます。

OpenAIが、CEOのSam Altmanが監督委員会によって解雇された(Ilya Sutskever主任科学者による企業内クーデターとされてます)後、3日で再任された危機に見舞われてから1か月も経たないうちに、発表された内容です。。

しかし、OpenAIの業務は通常ではありません。多くの研究者は、マシンがいつか人間の知性に匹敵するか、それを超えるかどうかをまだ疑問視しています。OpenAIのチームは、マシンの最終的な優位性を当然のこととしています。「ここ数年のAIの進歩は非常に速い」と、スーパーアラインメントチームの研究者Leopold Aschenbrennerは言います。「私たちはすべてのベンチマークを圧倒しており、その進歩は止まることなく続いています。」

Aschenbrennerと同社の他の人々にとって、人間のような能力を持つモデルはすぐそこにあります。「しかし、そこで止まることはありません」と彼は言います。「私たちは超人的なモデル、私たちよりもはるかに賢いモデルを持つことになるでしょう。そして、それは根本的な新しい技術的な課題を提示します。」

7月に、SutskeverとOpenAIの科学者Jan Leikeは、これらの課題に取り組むためにスーパーアラインメントチームを設立しました。「私は自分自身の利益のためにそれを行っています」とSutskeverは9月にMITテクノロジーレビューに語りました。「誰かが構築する任意のスーパーインテリジェンスが暴走しないようにすることは明らかに重要です。」

AltmanがAI安全に対する自社のアプローチを軽率に扱ったために解雇されたという憶測の中で、Sutskeverのスーパーアラインメントチームが見出しの背後に潜んでいました。多くの人々が、それが何をしていたのかを正確に見るのを待っていました。

やるべきこととやってはいけないことの判断

このチームが解決しようとしている問題は、私たちよりも遥かに賢いとされる仮説上の将来のモデル、いわゆる超人的モデルをどのように制御または「アラインメント」するかということです。アラインメントとは、モデルが望む行動を行い、望まない行動を行わないようにすることを意味します。スーパーアラインメントは、この考えを超人的モデルに適用するものです。

既存のモデルをアラインメントするために広く使用されている技術の一つは、人間のフィードバックによる強化学習です。簡単に言うと、人間のテスターがモデルの応答を評価し、望む行動を支持し、望まない行動を非難します。このフィードバックは、モデルが人間のテスターが好む応答のみを生成するように訓練するために使用されます。この技術は、ChatGPTが魅力的である理由の大きな部分を占めています。

問題は、望ましい行動と望ましくない行動を最初に判断できる人間が必要であるということです。しかし、超人的モデルの場合、理論によると、人間のテスターが理解できない行動をする可能性があり、そのため評価することができなくなる可能性があります。(それは人間から本当の行動を隠そうとするかもしれないと、Sutskeverは私たちに話しました。)

OpenAIのスーパーアラインメント問題へのアプローチ OPENAI

研究者たちは、超人的なマシンが現時点では存在しないため、この問題を研究することが難しいと指摘しています。そこで彼らは代替案を使用しました。人間が超人的なマシンを監督する方法を調べる代わりに、5年前にOpenAIがリリースしたGPT-2が、OpenAIの最新で最も強力なモデルであるGPT-4を監督する方法について研究しました。「それができれば、人間が超人的なモデルを監督するために同様の技術を使用できるかもしれないという証拠になるかもしれません」と、スーパーアラインメントチームの別の研究者であるCollin Burnsは言います。

チームはGPT-2を取り、チェスのパズルのセットや推論、感情分析などを評価する22の一般的な自然言語処理テストなど、さまざまなタスクを実行するように訓練しました。彼らはこれらのテストとパズルに対するGPT-2の反応を使用して、GPT-4を同じタスクを実行するように訓練しました。まるで12年生が3年生によってタスクの実行方法を教えられたようなものです。問題は、GPT-4のパフォーマンスに大きな影響を与えずにこれを行うことでした。

結果は混在していました。チームは、GPT-2の最善の推測に基づいて訓練されたGPT-4と、正しい答えに基づいて訓練されたGPT-4の間のパフォーマンスの差を測定しました。彼らは、GPT-2によって訓練されたGPT-4は言語タスクでGPT-2よりも20%から70%優れていることを発見しましたが、チェスのパズルではあまりうまくいきませんでした。

チームメンバーのPavel Izmailovは、「GPT-4がその先生を超えたという事実自体が印象的です。これは本当に驚くべきで前向きな結果です」と言います。しかし、彼によると、それは自分自身でできることからはるかに及ばないとのことです。彼らは、このアプローチが有望だが、さらなる作業が必要であると結論付けています。

「それは面白いアイデアです」と、ドイツのシュツットガルト大学でアラインメントに取り組むAI研究者のThilo Hagendorffは言います。しかし、彼はGPT-2が良い教師になり得ないほど愚かかもしれないと考えています。「GPT-2は、少し複雑であったり、推論が必要なタスクに対しては、たいてい無意味な反応をする傾向があります」と彼は言います。Hagendorffは、代わりにGPT-3が使用された場合に何が起こるかを知りたいと思っています。

また、彼は、このアプローチがSutskeverが想定したシナリオ、すなわちスーパーインテリジェンスが本当の行動を隠し、アラインされているふりをするが、実際にはそうでない場合を対処していないと指摘しています。「将来の超人的なモデルは、研究者には未知の新しい能力を持つ可能性が高い」とHagendorffは言います。「これらのケースでは、アラインメントはどのように機能するのでしょうか?」

しかし、欠点を指摘することは簡単です。彼はOpenAIが推測から実験へと移行しているのを見て喜んでいます。「私はOpenAIの努力を称賛します。」

OpenAIは現在、他の人々を自分たちのプロジェクトに参加させたいと考えています。この研究のアップデートとともに、同社はスーパーアラインメントに取り組んでいる人々を支援するために使用する予定の新しい1000万ドルの資金を発表しました。大学の研究室、非営利団体、個々の研究者に最大200万ドルの助成金、大学院生には15万ドルの1年間のフェローシップを提供します。「これについては賞賛します。」とAschenbrennerは言います。「新しい研究者が多くのことを貢献できると本当に思っています。」

この記事が気に入ったらサポートをしてみませんか?