【徹底解説】 Claude 3 Haikuで検索しながら超長文を書かせる方法(無料)

こんにちは!

しまゆずです。

今日は、Claude3を用いたパワフルAIリサーチを実践してみたので、皆さんにその方法をシェアします。

最近話題の生成AIツール、Claude3。

皆さんは触っていますか?

特に最上位モデルのOpusに関しては、トークン長や、日本語らしい日本語の出力などでSNSでも話題になり、注目されているツールと言っても過言ではないでしょう。

そんな中で、Claude3 Haikuというモデルが公開されました。

こちらは、軽量タイプで非常に出力速度も速いモデルになっています。

今回はそのClaude3 Haikuをもちいて、特定のトピックに関する長文作成かつWebからリサーチした情報をもとに記事を作成する方法を紹介します!

その名も「AIリサーチアシスタント」!

このアシスタントは、Anthropic社のClaude 3モデルとSERP APIを組み合わせることで、与えられたトピックについて徹底的に調べ上げ、さらにそれをリサーチのプロセスをサブトピックに分解し、各サブトピックごとに個別のレポートを生成した後、それらを最終的な総合レポートにまとめるんです。

基本的には、英語のレポート(もちろん日本語でも出力可能ですが、検索は英語の方が情報量は多いです)ですので、出来上がったレポートは日本語にClaude3で翻訳した結果がこちら。

1撃で17000文字。すごくないですか?

というわけで、そのやり方について解説していきます。

用意するもの

今回用意するのは3つ。

Google colaboratory

Claude API

SERP API

初めての方はちょっと難解に見えますが、ひとつずつ解説していきます。

1. Google Colab.

Google Colab とは、ブラウザから Python というプログラム言語を実行できるサービスです。基本無料で使えること、PCのスペックが少々難があってもGPUが起動できる優れたサービスです。

Googleアカウントさえあれば、使えますので上記リンクを参考にしてみて下しあ。ちなみに有料版は月額1072円で利用可能です。

2. Claude API

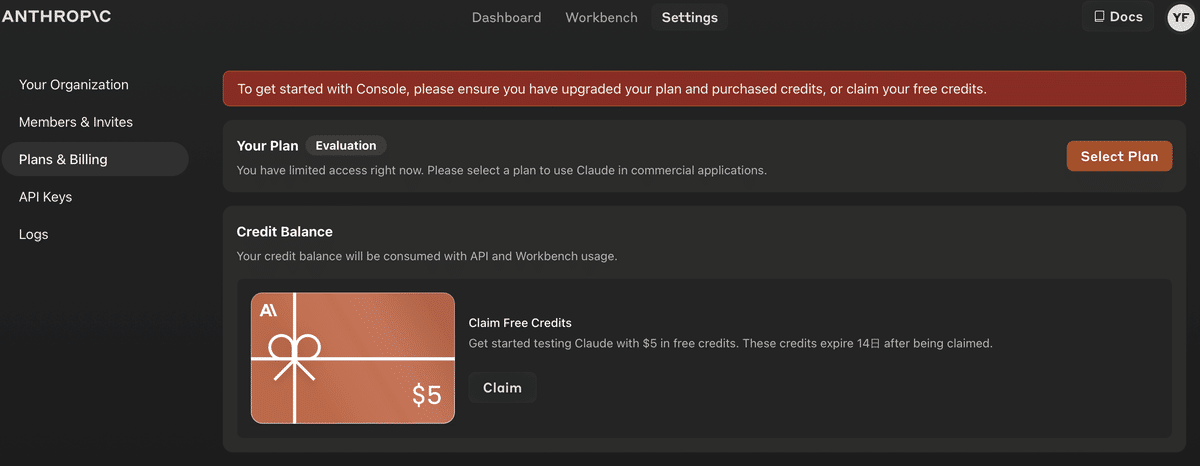

こちらは開発者向けのClaudeですが、無料で5$のクレジット分が貰えます。

やり方は、以下です。

Get API KeysのCreate Keyをクリック

Closeを押すと2度と記録できないので、必ずコピーしてから閉じてください

また、API Keyは絶対に他人に教えない事!

Claimをクリックしましょう。

注意:Claimしてから14日間で失効しますので使う直前にClaimしましょう。

3. SERP API

馴染みの薄いAPIですが、

SERP API(Search Engine Results Page API)は、検索エンジンの結果ページをプログラムで取得するためのインターフェースです。

このAPIを使用することで、GoogleやBingなどの検索エンジンからの検索結果を自動的に収集し、分析や監視、データ収集などの目的で使用できます。

特にSEO(検索エンジン最適化)分析、市場調査、コンテンツマーケティング、競合分析などに役立ちます。 by ChatGPT

そうなんです。今回の長文作成に、検索エンジンからの情報が入った上で作成できるので、ハルシネーションも起きにくく、より正確な情報が得られる可能性があるというのが大きなメリットです。

今回は上記のSerpAPIを提供するサイトを利用します。こちらも100回まで無料で使えますので今回の作成には十分足りる量です(が、私は何度もエラーを繰り返して消費したため課金する羽目に・・・泣)

GoogleアカウントなどでSign upすると以下の様な画面になります。

さあ、これで準備完了です。

このAIリサーチャーの特徴

・与えられたトピックについて、調査すべきサブトピックの詳細なチェックリストを生成

・各サブトピックについて、複数回の検索と分析を実施

・サブトピックごとに個別のレポートを作成

・「上司」ペルソナからのフィードバックを取り入れ、不足情報を特定してレポートを改善

・サブトピックのレポートを総合的な最終レポートにまとめる

いわゆるチェーンプロンプトと呼ばれるプロセスを分解して次に渡す方法ですが、これをプログラミングで行なっているもの、と理解してみて下さい。

使い方はここまでの設定ができていれば超カンタンです。Google Colabでノートブックを開いて、APIキーを入力したら、あとはトピックを入れるだけ!研究と生成が完了すると、最終レポートが「comprehensive_report.txt」として保存されます。

まず、下記のリンクを立ち上げてください。

GPUを選択したあと、右側の接続を押します(RAM, ディスクと書いてあるところ)。

AnthropicとSERPのAPIをそれぞれ、YOUR KEY HERE を消して、代入し、左側の▶️を押します。

さらにその下のブロックの▶️を押すと、

すると、ぶぅわわーっと書き出して、comprehensive_reportという名前のファイルが出来上がります。

で、出来上がったファイルをClaude3に投げて、日本語訳にしてもらえば完成!

一連の流れの動画はこちらです。

さらに、AIモデルやトークン数、温度値などのパラメータを調整することで、AI研究アシスタントの動作をカスタマイズすることもできる優れもの。

もちろん、生成されたレポートの品質と正確性はClaude3 AIの性能とSERP APIの検索結果に依存するため、完璧とは言えないかもしれません。複雑なトピックだと実行にかなり時間がかかることもあります。

カスタマイズリサーチャー

さて。ここからは、Tipsです。

私も1回目で感動したのですが、実はその後エラーを繰り返しました。

その理由は、

Rate limitというClaude側のAPI制限に引っかかり、せっかく途中まで作成したのに途中エラーで止まり、最後のテキストファイル作成まで辿りつかなかったのです。

これには困りました。課金を増やせば使用可能な上限も上がるのですが、この記事のためには・・・キツイ(笑)

という事で、カスタマイズすることにしました。

文字数はこちら。

レポートの量は落ちるものの、十分だと判断しました。

変更点は

検索ラウンドの回数を3回から1回に減らす。これにより、APIリクエストの数が減ります。

レポート分析と追加検索のラウンドの回数を3回から1回に減らす。これにより、APIリクエストの数がさらに減ります。

サブトピックの最大数を5から3に減らします。これにより、生成されるサブトピックレポートの数が減ります。

max token を減らす。これにより、1回のAPIリクエストで使用されるトークン数が減ります。

ということで、本家をモディファイしたものがこちら。

閲覧のみになっているので、必ずドライブにコピーして保存を選んで、コピーファイルから利用してください。

ただ、出来上がったファイルを見たら、かなりのVolume。

これだけでブログ記事になるのでは!?以下はその日本語訳された記事全文です。

というわけで、生成AIの力を借りてリサーチを自動化する「AIリサーチアシスタント」、ぜひ試してみてください!きっとリサーチの効率が上がること間違いなしですよ〜。

という事で、本家のGitHubはこちら。

https://github.com/mshumer/ai-researcher?tab=readme-ov-file

これをオープンソースで公開している方もすごいです。

Mattさんという方です。ぜひ、興味のある方はツイートをのぞいてみてください。

最後まで読んで頂きありがとうございました!

感想、いいねやフォローをお願いします。

記事は全て無料公開していますが、投げ銭もお待ちしています笑!!

また、NewsPicksでも定期執筆していますので、こちらもフォローをしていただけると、嬉しいです。私以外にも生成AIを使いこなしているメンバーで記事を作成しています。

この記事が気に入ったらサポートをしてみませんか?