noteのビュー数などを自動取得できるようにしてみたけど、ルール上ダメなようですね。。

noteを毎日投稿していて、

日々のビュー数ってデータ残らないのかな、とか、

ダッシュボードの数値を毎日自動で取得してくれないかな、

とか思って過ごしていました。

今月はPythonの学習を始めたので、

試しに作ってみました。

結論としてはダメなようです。

これは需要がありそうだから、

有料記事にしてみるかなーとか思っていたのですが、

そもそもダメなようですね。

ガーン。。

こちらのページがわかりやすかったです。

webスクレイピングなどでwebサイトをクローリングする際に行わなければならないことの一つに「robots.txt」の記載内容の確認が挙げられます。

ここではnote.comのrobots.txtについて実際にどの様に記載されているのか読み解きながら、その内容を確認していきたいと思います。

(中略)

「ログインした状態でないと見れない個人用のページ」や「運営管理用と思われるページ」が拒否設定となっているみたいです。

成果物はこんな感じです。

いちおう作ったものの成果物を載せておきます。

1.noteのダッシュボード「全期間」の記事を1件別に取得。

イメージはこんな感じです。

2.毎日定期に実行

毎日定時に動きます。

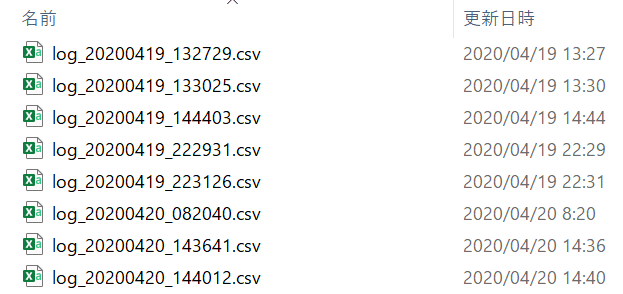

保存されるcsv名にはcsvを出力した日付と時間(秒単位)を指定しています。

イメージはこんな感じです。

処理を実行したpythonファイルと同じ階層に保存されます。

主にPythonのseleniumというツールを使いました。

つらつらと書いたものの、だめなものはだめですね。

Python便利だなぁって感じでした。

コードが動くと嬉しいですね。

今回は残念でしたが、課題がたくさん見つかったので、

少しずつ学んでいこうと思います。

この記事が気に入ったらサポートをしてみませんか?