ようやくGPT-4Vが使えるようになった・・!個人的には95点くらいの性能(ChatGPT部, 大城)

おはようございます、ChatGPT部、部長の大城です。例のChatGPTの画像解析昨日のGPT-4V、うちのChatGPTプラスアカウントにも届いてました・・!先行リリース開始6日くらい、当初のデモがあった2023/3/14くらいから半年以上待ってたのでめっちゃ嬉しいです。

過去にも7月にGoogle Bardと通常盤Bing Chatで画像処理の性能を検証しましたが、その時は45点〜65点くらいの印象でしたが今回30分くらいGPT-4Vを触ったところでは感想としては文句なしの95点くらいの性能でしたので、簡単にまとめます。

( 待っていた分、だいぶ贔屓目に見ているところもあるかもですが・・笑 )

( 日本語に弱いのと、カウント能力にまだ改善の余地があるので-5点です )

ご参考:届く前の記事

ちなみに、先週まではGPT-4Vがなかったので、調査ベースにてこちらをまとめてました。

前回までの実験はこちら

画像を与えて「これは何?」を中心とした質問です。同じ問題を今回も解いてもらおうと思います。

使い方:画像アップロードボタンを押して聞くだけ

こんな感じで画像のアイコンがでてましたのでこちらをクリック or 画像ファイルをドラッグ&ドロップして質問します。なお、Advanced Data Analyticsにも同じアイコンが出ていたので、多分コーディングとセットでの解析も行ける気がしています(未検証)。一報でBingの検索機能やプラグインとの同時利用はできない感じでした(アップロードのアイコンが無い)

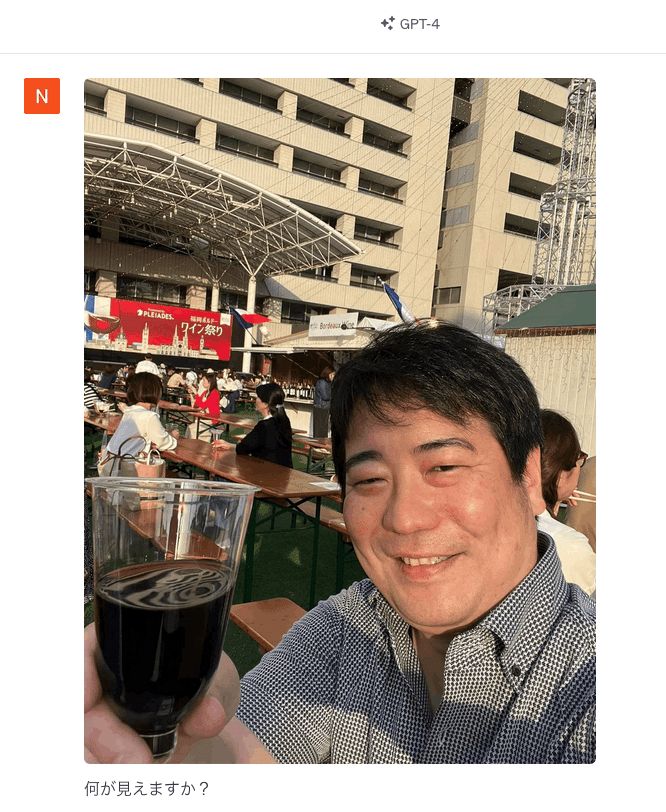

①人物画像 -> 行ける。80点くらい、ただ日本語は認識せず

いつものこのおっさん(私)の画像です。正しく認識してくれていましたが、「日本語がおそらく読めていない」節がありましたので、80点としています。この辺りはGoogleのVision APIの方が優秀かもですが、それ以外の描写はほぼ完璧です。

ここまでは順調ですね。ただ、「ワイン」と言う字が読めていません。

Google Vision AIの場合

ちなみに、Google Vision AIを使うと日本語の認識もしていましたので、技術的にはこの辺を組み合わせると色々できそうだなと言う気もしています。

( GPT-4Vも遅かれ早かれ日本語認識性能も上がるのでは、と予想してます )

OCRベースだと思いますが、「福岡 ボルドー」や「ワイン 祭り」まで読めれば場所やイベントも推定、できますからね。

ハルシネーションに注意

ちなみにGPT-4V、ここまで試してかなり順調でしたが、「軽井沢のように見える」と急に嘘をつき始めましたので、やはり油断は大敵ですね。

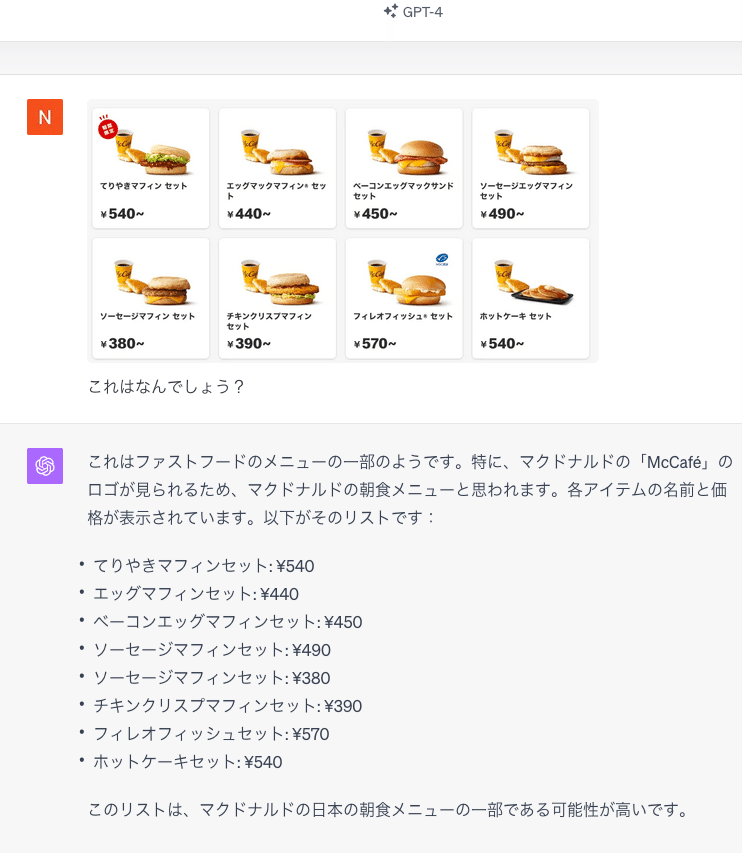

②いつものハンバーガー屋のスクレイピング、120点

続いていつもの問題。

これ、普段ならスクレイピングして100点!と言う感じなんですが、「MacCafeの文字が見えるから朝食メニューでは?」と言う推察まで入れてくれてますね・・ということで120点な回答。

ちなみにこちらは「画像としてメニューをスクショして渡している」状態なので、HTMLを解析する、とかはできない状態です。Webサイトのスクレイピングは普通は裏側のHTMLを読むので、これはちゃんと文字認識をしてくれている感じですね。

ちなみに前回Bardでやったときは15点くらい(全然ダメ)、Bingは70点くらい(金額が一部違って減点)を前回所感としてはつけていました。

③アスキーアート解析 -> 80点 (ただし、ヒントあり)

続いてはアスキーアート。最初は「何これ」と言う感じでしたが、「アスキーアートです」と言うヒントを与えると見事正解ですね。

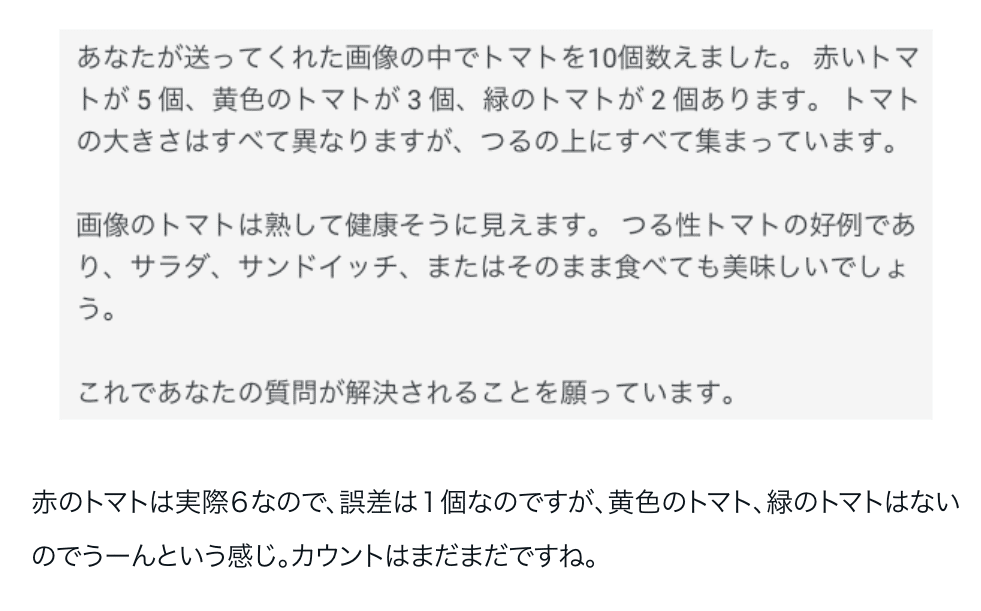

ちなみにカウンティングさせるとこんな感じですね。うーん、性能としてはもう少し。高解像度画像ならいけるかもですが、人間なら解けるタスクなので80点くらいでしょうか。

④AIが作成した自動車の渋滞画像 -> 100点

こちらも100点満点の回答。

カウントも「正確にはできない」というところですが、概算40台くらい、というのはほぼ一致ですね。大体35台前後かと。

⑤トマト画像 -> 120点

いやー、これもすごい。トマトの認識に留まらず「支柱が見える」「背面がコンクリート」というところから「家庭菜園」「バルコニー」と推測してますね。この推論能力はやはりChatGPTならでは、ではないでしょうか。

カウンティングも6個で完璧ですね。ちなみにBard、Bingで昔検証した際はカウンティングはここまで正確ではありませんでした。

カウンティングの性能比較(vs. google bard, MS bing chat)

以前、google Bardで実験した例

以前、MS Bing Chatで実験した例

やはりGPT-4Vが頭一つ二つ、抜けている気がしますね。

所感と今後の展望:いよいよAIに「目」がやってきた

いやー、すごい。日本語の解析機能などは一部弱いところがありますが、推論能力とセットにするとほぼほぼ合格点ではないでしょうか。性能向上はもはや時間の問題かなと思います。

今後しばらくはこのGPT-4Vを触ってみたり、勉強会をしてみたりしようと思います。画像解析機能が出たら試したいこと、昔少しブレストしてましたのでこの辺とかですかね(5/7記事)。

日本語は多分まだ厳しいのでは、と予想。これも後で再実験(7/25記事)。

あと個人的にはこの辺りのMSさんの調査レポートとかも気になってるんですよね。先人に学ぼう。

1/ マイクロソフトの研究者が「GPT-4V」で色々な入力を試した論文

— 門脇 敦司/ Atsushi (@at_sushi_) October 3, 2023

「どのような画像を読み取れるのか」「どの分野に応用できるか」など。図表が多くわかりやすいです。

かなり長い(166ページ)ですが、目次と要約を載せます。気になった部分だけでも(続く→) pic.twitter.com/OUru1FBsa9

GPT-4V、今後の性能によっては我々の業務・日常生活を大きく変えるポテンシャルはあると思っています。交通量調査とかマーケティングとかエレベータの監視業務とか。今はまだAPIは出ていませんが、おそらく時間の問題でしょうし、ひとまずは「どのレベルまでなら使えうるか」の情報を集めたいと思います。

ということで、みなさんもどうぞ良いChatGPT & GPT-4Vライフを・・!!

この記事が気に入ったらサポートをしてみませんか?